Альт Сервер Виртуализации 9.2

Руководство пользователя

Редакция июль, 2021

Аннотация

Добро пожаловать в документацию дистрибутива Альт Сервер Виртуализации. Данное руководство предназначено как для начинающих, так и для опытных пользователей. Руководство описывает подготовку системы для установки, процесс установки дистрибутива, а также процедуру настройки и использования системы.

Названия компаний и продуктов, встречающихся в руководстве, могут являться торговыми знаками соответствующих компаний.

Данное руководство соответствует текущему состоянию сведений, но какие-либо окончательные правки могли не попасть в него. В случае обнаружения ошибок и неточностей в руководство вносятся изменения.

Часть II. Установка дистрибутива

В этой части рассматривается процесс установки дистрибутива.

Глава 4. Подготовка установочного диска

Наиболее частый способ установки операционной системы на компьютер представляет собой установку с установочного DVD-диска. В этой главе описываются различные способы записи дистрибутива на DVD-диск.

Установочные образы являются гибридными, что позволяет производить установку, записав такой образ на USB Flash. О записи установочного образа на USB Flash также рассказано в этой главе.

4.1. Запись ISO-образа дистрибутива на DVD

4.1.1. Запись образа диска под операционной системой MS Windows

Файл ISO-образа диска — это файл специального формата, подготовленный для записи на диск. Для записи ISO-образа под операционной системой MS Windows используйте специальные программы:

SCDWriter,

Nero BurningROM и другие. Рекомендуем для записи использовать новые диски от известных производителей, таких как: Verbatim, TDK. Записанный на плохой диск образ может вызвать неразрешимые проблемы при установке.

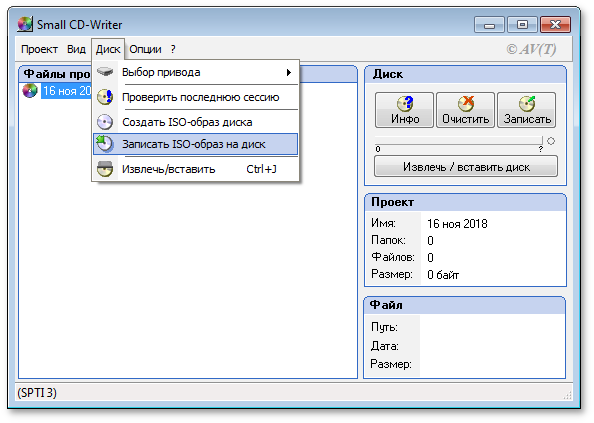

4.1.1.1. Запись образа диска с помощью Small CD-Writer

Весь процесс записи установочного диска при помощи

Small CD-Writer состоит из следующих шагов:

скачать образ дистрибутива;

распаковать файлы программы из архива в любой каталог;

вставить чистый диск в привод;

войти в распакованный каталог и запустить программу SCDWriter.exe;

открыть пункт меню → и, в появившемся окне, указать путь к образу диска;

нажать кнопку Записать.

4.1.1.2. Запись образа диска с помощью Nero BurningROM

Процесс записи установочного диска при помощи

Nero BurningROM состоит из следующих шагов:

скачать образ дистрибутива;

запустить программу и выбрать в списке устройств необходимый для записи CD/DVD дисковод;

нажать кнопку Открыть проект в главном окне. В появившемся окне выбрать необходимый ISO-образ для записи и нажать кнопку Открыть;

в окне Запись проекта (Записать образ) настроить необходимые параметры;

записать ISO-образа на диск, щёлкнув по кнопке Запись (Burn).

4.1.2. Запись образа диска под операционной системой Linux

Для записи ISO-образов можно использовать множество утилит и программ с графическим или текстовым интерфейсом. Наиболее удобно использовать программы K3b или Brasero, которые поставляются в комплекте любого дистрибутива операционной системы Linux.

4.1.2.1. Запись образа диска с помощью K3b

Весь процесс записи установочного диска при помощи

K3b состоит из следующих шагов:

если программа k3b отсутствует, необходимо установить её в систему, используя стандартные для вашего дистрибутива инструменты установки программ;

запустить программу k3b. При правильных настройках программа сообщит об отсутствии проблем с системой и предложит перейти к записи на диск;

в меню главного окна выбрать пункт ;

в появившемся окне Записать образ DVD (Burn DVD image) нажать на кнопку Выбор файла для записи. Откроется диалог, в котором необходимо выбрать ISO-образ для записи и после выбора нажать кнопку ОК;

программа k3b покажет информацию о ISO-файле и начнёт вычислять контрольную сумму. Эта операция может занять несколько минут. Полученную контрольную сумму можно сравнить с MD5SUM суммой на странице дистрибутива;

если контрольные суммы не совпадают, значит, для записи был выбран не тот файл или скачанный ISO-образ был испорчен во время передачи данных по сети;

если контрольные суммы совпадают, вставить диск для записи в дисковод. Дождаться активации кнопки Начать (Start);

нажать на кнопку Начать (Start).

4.2. Запись установочного образа на USB Flash

Запись образа дистрибутива на flash-диск приведёт к изменению таблицы разделов на носителе, таким образом, если flash-диск выполнил функцию загрузочного\установочного устройства и требуется вернуть ему функцию переносного накопителя данных, то необходимо удалить все имеющиеся разделы на flash-диске и создать нужное их количество заново.

Для восстановления совместимости flash-диска с операционными системами семейства Windows может понадобиться также пересоздание таблицы разделов (например, при помощи parted). Нужно удалить таблицу GPT и создать таблицу типа msdos. Кроме того, должен быть только один раздел с FAT или NTFS.

Для создания загрузочного flash-диска понадобится файл ISO-образа установочного диска с дистрибутивом. ISO-образы установочных дисков являются гибридными (Hybrid ISO/IMG), что позволяет записать их на flash-накопитель.

4.2.1. В операционной системе Windows

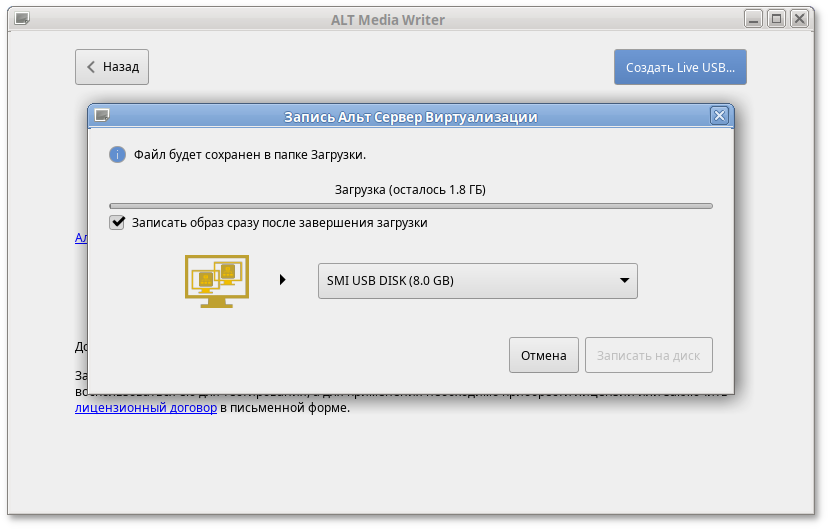

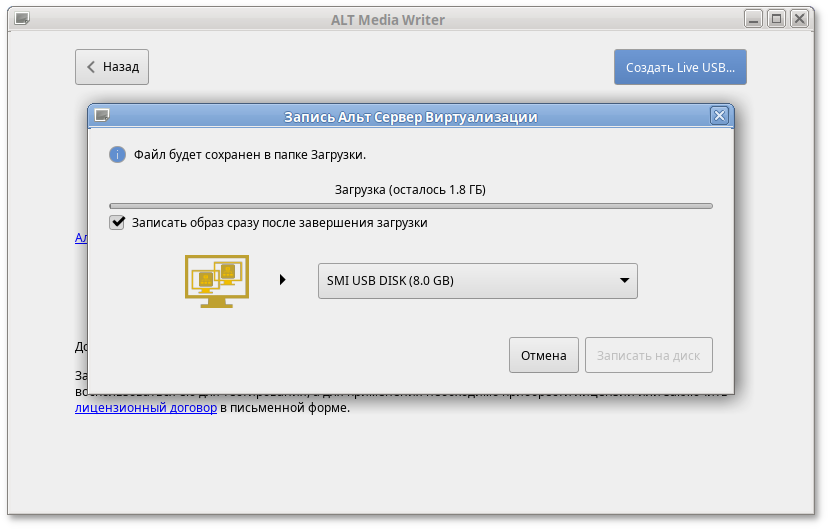

ALT Media Writer — это инструмент, который помогает записывать образы ALT на портативные накопители, такие как flash-диски. Он может автоматически загружать образы из интернета и записывать их. Для записи образа на flash-диск необходимо:

скачать и установить

ALT Media Writer;

вставить flash-диск в USB-разъем;

запустить ALT Media Writer;

выбрать дистрибутив и нажать кнопку

Создать Live USB…:

начнётся загрузка образа из интернета;

выбрать устройство (flash-диск);

после окончания загрузки нажать кнопку Записать на диск (если был отмечен пункт Записать образ после загрузки, запись образа начнётся автоматически).

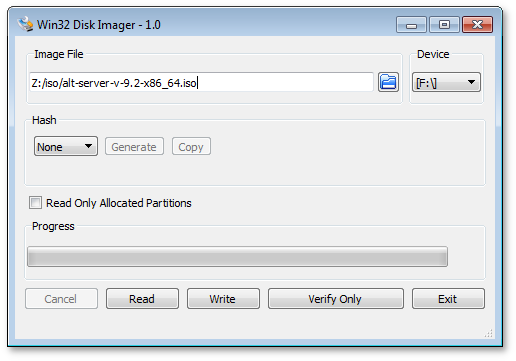

Инструкция для записи образа в программе

Win32 Disk Imager:

скачать образ дистрибутива;

вставить flash-диск в USB-разъем (размер flash-диска должен быть не меньше размера скачанного образа диска);

запустить Win32 Disk Imager;

в появившимся окне выбрать ISO-образ дистрибутива, выбрать устройство (flash-диск):

нажать кнопку Write для записи образа на flash-диск.

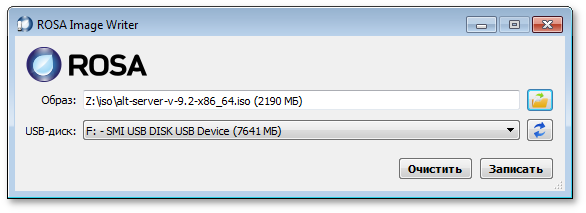

Инструкция для записи образа в программе

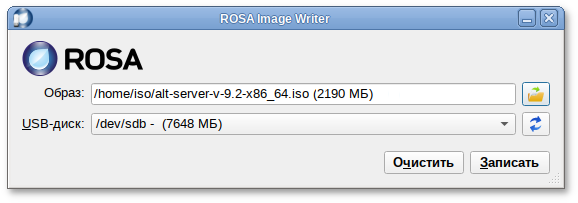

ROSA Image Writer:

распаковать файлы программы из архива в любой каталог;

скачать образ дистрибутива;

вставить flash-диск в USB-разъем (размер flash-диска должен быть не меньше размера скачанного образа диска);

запустить файл .exe;

в появившимся окне выбрать ISO-образ дистрибутива, выбрать устройство (flash-диск):

нажать кнопку Записать для записи образа на flash-диск.

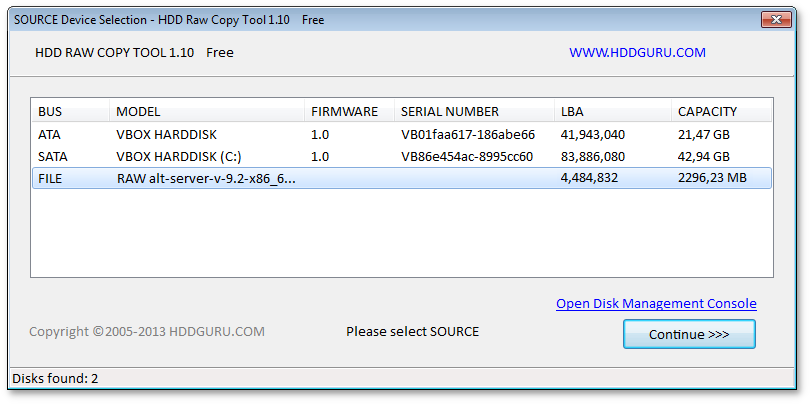

Для записи образа на flash-диск подойдёт и утилита

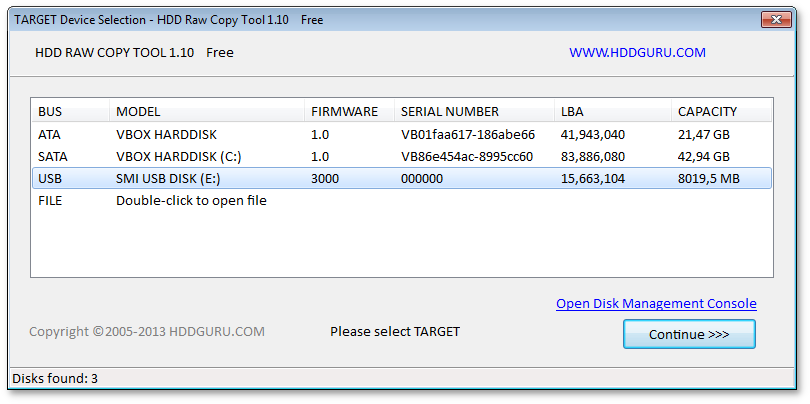

HDD Raw Copy Tool. На первом шаге нужно выбрать файл с образом диска:

На втором шаге нужно выбрать flash-диск, на который будет записан образ:

Будьте внимательны при указании имени usb-устройства — запись образа по ошибке на свой жёсткий диск приведёт к почти гарантированной потере данных на нём!

После проверки правильности выбранных параметров и нажатия кнопки Continue можно приступать к записи, нажав кнопку START. По успешному завершению записи окно с индикацией процесса записи закроется, после чего можно закрыть и окно самой программы.

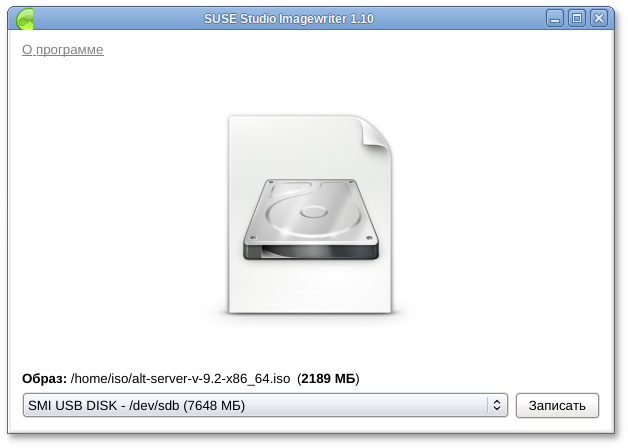

4.2.2. В операционной системе Linux

Для записи образа на flash-диск можно воспользоваться любой из трёх программ с графическим интерфейсом:

Для записи установочного образа можно воспользоваться утилитой командной строки dd:

dd oflag=direct if=<файл-образа.iso> of=/dev/sdX bs=1M status=progress

sync

где <файл-образа.iso> — образ диска ISO, а

/dev/sdX — устройство, соответствующее flash-диску.

Для удобства показа прогресса записи можно установить пакет pv и использовать команду:

pv <файл-образа.iso> | dd oflag=direct of=/dev/sdX bs=1M;sync

где <файл-образа.iso> — образ диска ISO, а

/dev/sdX — устройство, соответствующее flash-диску.

Просмотреть список доступных устройств можно командой lsblk или (если такой команды нет): blkid.

Например, так можно определить имя flash-диска:

$ lsblk | grep disk

sda 8:0 0 931,5G 0 disk

sdb 8:16 0 931,5G 0 disk

sdc 8:32 1 7,4G 0 disk

flash-диск имеет имя устройства sdc.

Затем записать:

# dd oflag=direct if=/iso/alt-server-v-9.2-x86_64.iso of=/dev/sdc bs=1M status=progress; sync

или, например, так:

# pv /iso/alt-server-v-9.2-x86_64.iso | dd oflag=direct of=/dev/sdc bs=1M;sync

dd: warning: partial read (524288 bytes); suggest iflag=fullblock

3GiB 0:10:28 [4,61MiB/s] [===================================> ] 72% ETA 0:04:07

Будьте внимательны при указании имени usb-устройства — запись образа по ошибке на свой жёсткий диск приведёт к почти гарантированной потере данных на нём!

Не добавляйте номер раздела, образ пишется на flash-диск с самого начала!

Не извлекайте flash-диск, пока образ не запишется до конца! Определить финал процесса можно по прекращению моргания индикатора flash-диска либо посредством виджета "Безопасное извлечение съемных устройств". В консоли можно подать команду

eject /dev/sdX

и дождаться ее успешного завершения.

4.2.3. В операционной системе OS X

В операционной системе OS X для создания загрузочного flash-диска можно использовать команду:

sudo dd if=alt-server-v-9.2-x86_64.iso of=/dev/diskX bs=1M

sync

где alt-server-v-9.2-x86_64.iso — образ диска ISO, а /dev/diskX — flash-диск.

Просмотреть список доступных устройств можно командой:

diskutil list

Будьте внимательны при указании имени usb-устройства — запись образа по ошибке на свой жёсткий диск приведёт к почти гарантированной потере данных на нём!

4.2.4. Проверка целостности записанного образа

Внимание! Если речь идёт о записи на flash-диск образа LiveCD, проверка должна быть выполнена сразу же после записи на USB Flash, без запуска с него. Причина в том, что остаток flash-диска, при первом запуске LiveCD, форматируется, как r/w раздел, при этом меняется и таблица разделов.

Для проверки целостности записанного образа необходимо выполнить следующие шаги:

определить длину образа в байтах:

$ du -b alt-server-v-9.2-x86_64.iso | cut -f1

2296233984

посчитать контрольную сумму образа (или просмотреть контрольную сумму образа из файла MD5SUM на сервере FTP):

$ md5sum alt-server-v-9.2-x86_64.iso

56e7330ee5a4bf3a4238a8f118c3b834 alt-server-v-9.2-x86_64.iso

подсчитать контрольную сумму записанного образа на DVD или USB Flash (выполняется под правами пользователя root):

# head -c 2296233984 /dev/sdd | md5sum

56e7330ee5a4bf3a4238a8f118c3b834

где размер после -c — вывод в п.1, а /dev/sdd — устройство DVD или USB Flash, на которое производилась запись.

Глава 5. Сохранение данных и меры предосторожности

Если необходимо установить ОС Альт Сервер Виртуализации и при этом сохранить уже установленную на компьютере операционную систему (например, другую версию GNU/Linux или Microsoft Windows), то нужно обязательно позаботиться о подготовке компьютера к установке второй системы и о сохранении ценных для вас данных.

Если у вас нет загрузочного диска для уже установленной системы, создайте его. В случае прерванной установки ОС Альт Сервер Виртуализации или неправильной настройки загрузчика, вы можете потерять возможность загрузиться в вашу предыдущую ОС.

Если на диске, выбранном для установки ОС Альт Сервер Виртуализации, не осталось свободного раздела, то программа установки должна будет изменить размер существующего раздела. От этой операции могут пострадать ваши данные, поэтому предварительно надо сделать следующие действия.

Выполнить проверку раздела, который вы собираетесь уменьшать. Для этого воспользуйтесь соответствующим программным обеспечением (далее — ПО), входящим в состав уже установленной ОС. Программа установки Альт Сервер Виртуализации может обнаружить некоторые очевидные ошибки при изменении размера раздела, но специализированное ПО предустановленной ОС справится с этой задачей лучше.

Выполнить дефрагментацию уменьшаемого раздела в целях повышения уровня безопасности данных. Это действие не является обязательным, но мы настоятельно рекомендуем его произвести: изменение размера раздела пройдёт легче и быстрее.

Полной гарантией от проблем, связанных с потерей данных, является резервное копирование!

Глава 6. Начало установки: загрузка системы

6.1. Способы первоначальной загрузки

Для загрузки компьютера с целью установки системы необходимо воспользоваться носителем, содержащим начальный загрузчик.

Простейший способ запустить программу установки — загрузить компьютер с помощью загрузочного носителя, находящегося на установочном DVD с дистрибутивом (при условии, что система поддерживает загрузку с устройства для чтения DVD).

Также программу установки можно запустить с другого загрузочного носителя. Например, в качестве загрузочного носителя может использоваться загрузочный USB flash-накопитель.

Для того чтобы начать установку ОС Альт Сервер Виртуализации, достаточно загрузиться с носителя, на котором записан дистрибутив.

Предварительно следует включить в BIOS опцию загрузки с оптического привода или с USB-устройства.

В большинстве случаев указание способа входа в BIOS отображается на вашем мониторе непосредственно после включения компьютера. Способ входа в меню BIOS и информация о расположении настроек определяется производителем используемого оборудования. За информацией можно обратиться к документации на ваше оборудование.

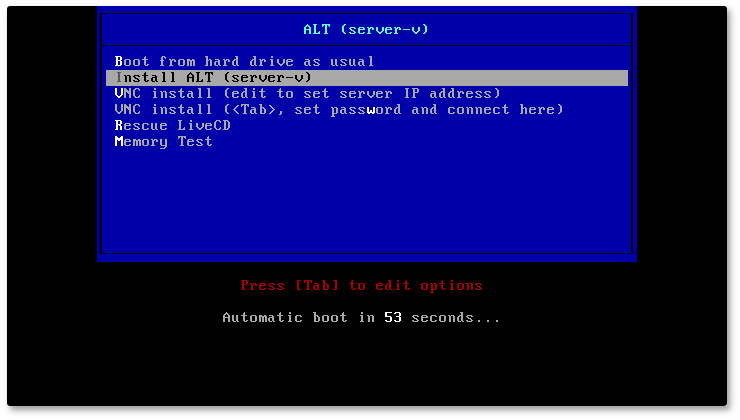

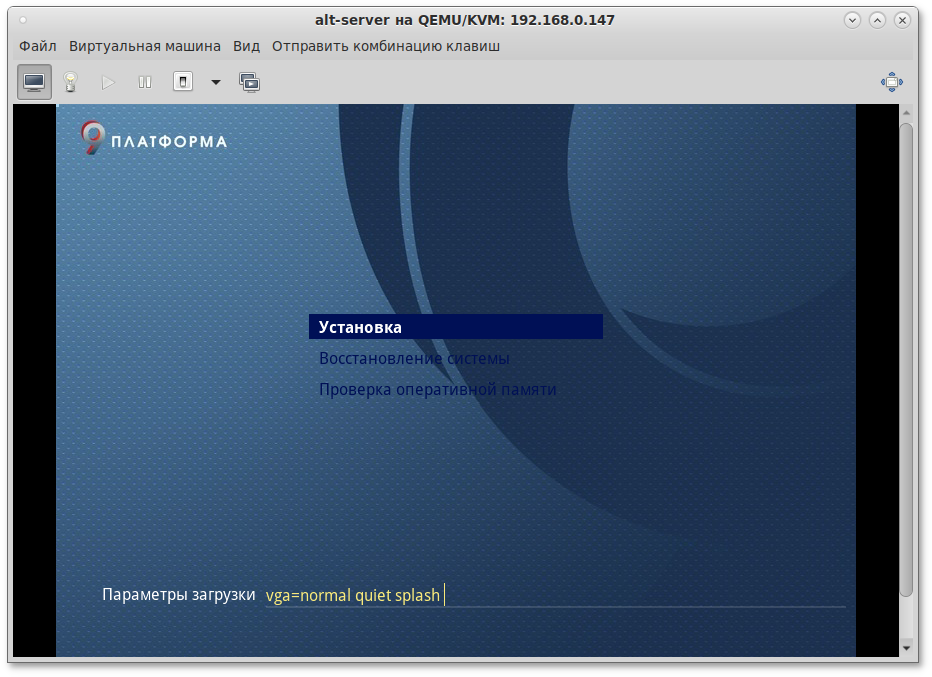

Загрузка с установочного диска или специально подготовленного USB-flash-накопителя начинается с меню, в котором перечислено несколько вариантов загрузки. Кроме установки системы с установочного диска, в данном меню доступны несколько вариантов сетевой установки.

— запуск уже установленной на жестком диске операционной системы;

— установка операционной системы;

— установка по VNC с соединением с устанавливаемой машины на сервер VNC с заданным IP-адресом. Параметры установки по VNC передаются как параметры ядра. Нажатие клавиши Tab позволяет задать IP-адрес компьютера, с которого будет происходить управление (для приёма подключения на сервере VNC следует запустить, например, vncviewer --listen);

) — установка по VNC с соединением в сторону устанавливаемой машины. Параметры установки по VNC передаются как параметры ядра. Нажатие клавиши Tab позволяет задать пароль (по умолчанию — VNCPWD);

— восстановление уже установленной, но так или иначе поврежденной ОС Linux путем запуска небольшого образа ОС в оперативной памяти. Восстановление системы потребует некоторой квалификации. Этот пункт также может быть использован для сбора информации об оборудовании компьютера, которую можно отправить разработчикам, если ОС Альт Сервер Виртуализации устанавливается и работает неправильно. Загрузка восстановительного режима заканчивается приглашением командной строки:

[root@localhost /]#

— проверка целостности оперативной памяти. Процесс диагностики заключается в проведении нескольких этапов тестирования каждого отдельного модуля ОЗУ (данный процесс будет выполняться бесконечно, пока его не остановят, необходимо дождаться окончания хотя бы одного цикла проверки).

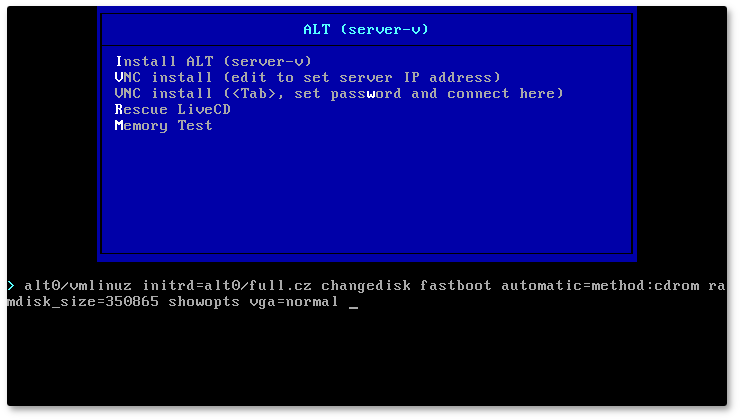

Мышь на этом этапе установки не поддерживается. Для выбора опций установки и различных вариантов необходимо использовать клавиатуру.

Нажатие клавиши

Tab позволяет вручную задать параметры, передаваемые ядру. Например,

nomodeset — не использовать modeset-драйверы для видеокарты;

vga=normal — отключить графический экран загрузки установщика;

xdriver=vesa — явно использовать видеодрайвер vesa. Данным параметром можно явно указать нужный вариант драйвера;

acpi=off noapic — отключение ACPI (управление питанием), если система не поддерживает ACPI полностью.

Чтобы начать процесс установки, нужно клавишами перемещения курсора вверх и вниз, выбрать пункт меню , и нажать Enter. Начальный этап установки не требует вмешательства пользователя: происходит автоматическое определение оборудования и запуск компонентов программы установки.

В начальном загрузчике установлено небольшое время ожидания: если в этот момент не предпринимать никаких действий, то будет загружена та система, которая уже установлена на жестком диске. Если вы пропустили нужный момент, перезагрузите компьютер и вовремя выберите пункт .

Глава 7. Последовательность установки

До того, как будет произведена установка базовой системы на жёсткий диск, программа установки работает с образом системы, загруженным в оперативную память компьютера.

Если инициализация оборудования завершилась успешно, будет запущен графический интерфейс программы-установщика. Процесс установки разделён на шаги. Каждый шаг посвящён настройке или установке определённого свойства системы. Шаги нужно проходить последовательно. Переход к следующему шагу происходит по нажатию кнопки Далее. При помощи кнопки Назад, при необходимости, можно вернуться к уже пройденному шагу и изменить настройки. Однако возможность перехода к предыдущему шагу ограничена теми шагами, в которых нет зависимости от данных, введённых ранее.

Если по каким-то причинам возникла необходимость прекратить установку, необходимо нажать кнопку <Reset> на корпусе системного блока компьютера.

Совершенно безопасно выполнить отмену установки только до шага «

Подготовка диска», поскольку до этого момента не производится никаких изменений на жёстком диске. Если прервать установку между шагами «

Подготовка диска» и «

Установка загрузчика», существует вероятность, что после этого с жёсткого диска не сможет загрузиться ни одна из установленных систем (если такие имеются).

Технические сведения о ходе установки можно посмотреть, нажав Ctrl+Alt+F1, вернуться к программе установки — Ctrl+Alt+F7. По нажатию Ctrl+Alt+F2 откроется отладочная виртуальная консоль.

Каждый шаг сопровождается краткой справкой, которую можно вызвать, щёлкнув кнопку Справка или нажав клавишу F1.

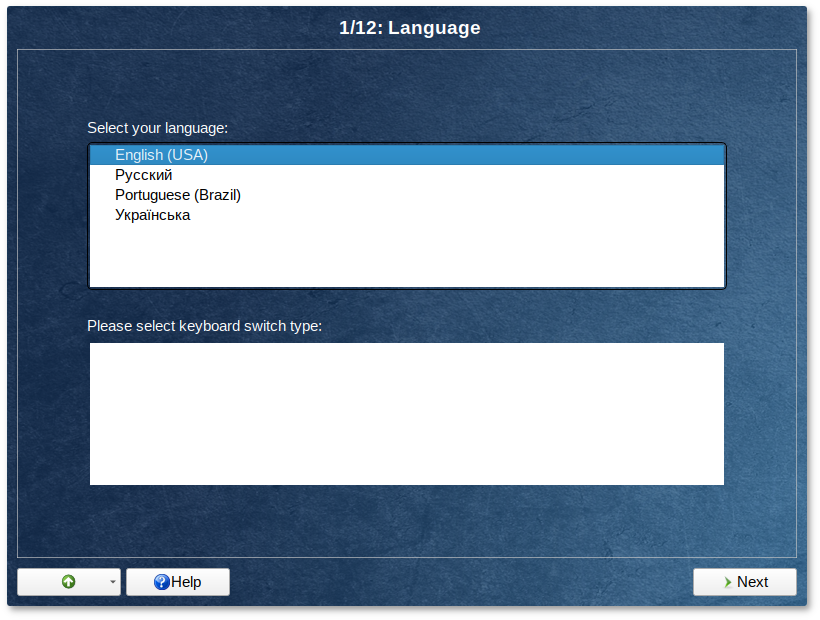

Язык установщика по умолчанию — английский, иной надо выбирать вручную на первом шаге установки.

Во время установки системы выполняются следующие шаги:

По умолчанию используется английский язык:

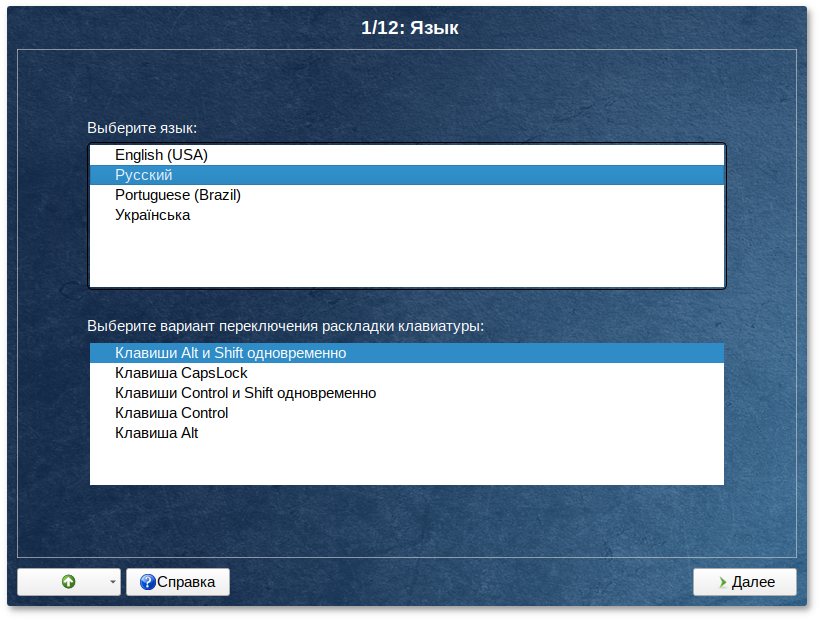

Установка Альт Сервер Виртуализации начинается с выбора основного языка — языка интерфейса программы установки и устанавливаемой системы. На этом этапе можно выбрать русский язык:

На этом же этапе выбирается вариант переключения раскладки клавиатуры. Раскладка клавиатуры — это привязка букв, цифр и специальных символов к клавишам на клавиатуре. Помимо ввода символов на основном языке, в любой системе Linux необходимо иметь возможность вводить латинские символы (имена команд, файлов и т.п.). Для этого обычно используется стандартная английская раскладка клавиатуры. Переключение между раскладками осуществляется при помощи специально зарезервированных для этого клавиш. Для русского языка доступны следующие варианты переключения раскладки:

Если выбранный основной язык имеет всего одну раскладку (например, при выборе английского языка в качестве основного), эта единственная раскладка будет принята автоматически.

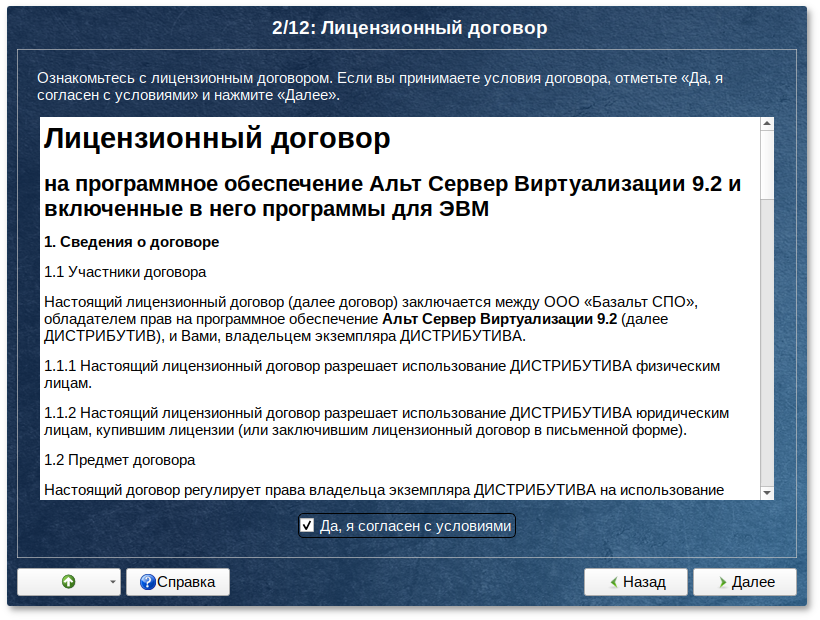

Глава 9. Лицензионный договор

Перед продолжением установки следует внимательно прочитать условия лицензии. В лицензии говорится о ваших правах. В частности, за вами закрепляются права на:

эксплуатацию программ на любом количестве компьютеров и в любых целях;

распространение программ (сопровождая их копией авторского договора);

получение исходных текстов программ.

Если вы приобрели дистрибутив, то данное лицензионное соглашение прилагается в печатном виде к вашей копии дистрибутива. Лицензия относится ко всему дистрибутиву Альт Сервер Виртуализации. Если вы согласны с условиями лицензии, отметьте пункт Да, я согласен с условиями и нажмите кнопку Далее.

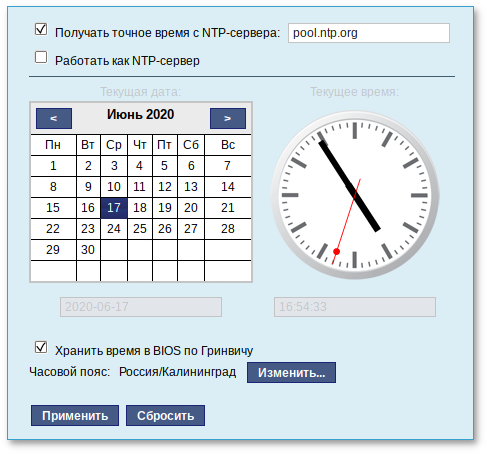

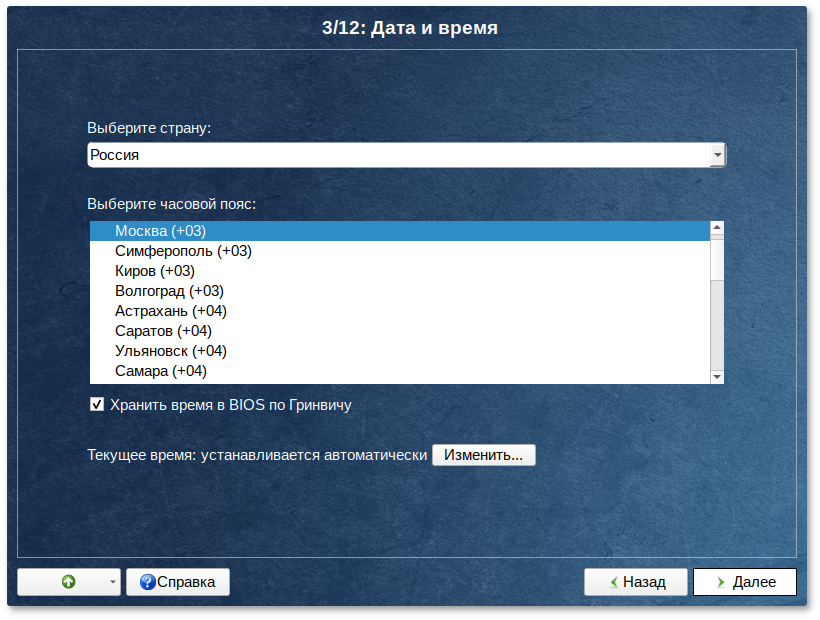

На данном этапе выполняется выбор страны и города, по которым будет определен часовой пояс и установлены системные часы.

Для корректной установки даты и времени достаточно правильно указать часовой пояс и выставить желаемые значения для даты и времени.

На этом шаге следует выбрать часовой пояс, по которому нужно установить часы. Для этого в соответствующих списках выберите страну, а затем регион. Поиск по списку можно ускорить, набирая на клавиатуре первые буквы искомого слова.

Пункт Хранить время в BIOS по Гринвичу выставляет настройки даты и времени в соответствии с часовыми поясами, установленными по Гринвичу, и добавляет к местному времени часовую поправку для выбранного региона.

После выбора часового пояса будут предложены системные дата и время по умолчанию.

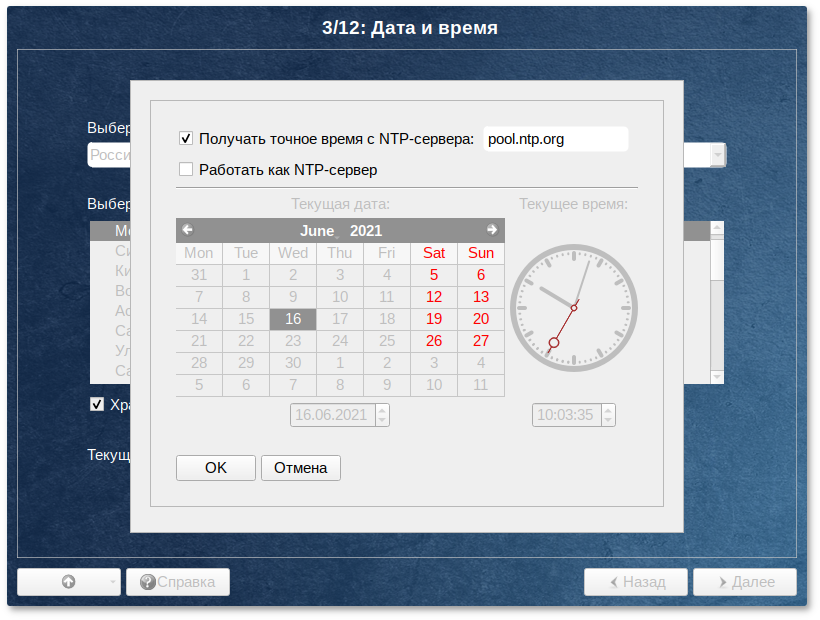

Для ручной установки текущих даты и времени нужно нажать кнопку Изменить…. Откроется окно ручной настройки системных параметров даты и времени.

Для синхронизации системных часов с удалённым сервером времени (NTP) по локальной сети или по сети Интернет нужно отметить пункт Получать точное время с NTP-сервера и указать предпочитаемый NTP-сервер. В большинстве случаев можно указать сервер pool.ntp.org.

Если выбрана опция Получать точное время с NTP-сервера, то компьютер может и сам быть сервером точного времени. Например, использоваться как сервер точного времени машинами локальной сети. Для активации этой возможности необходимо отметить пункт Работать как NTP-сервер.

Для сохранения настроек и продолжения установки системы в окне ручной установки даты и времени необходимо нажать кнопку ОК и затем в окне Дата и время нажать кнопку Далее.

В случае если ОС Альт Сервер Виртуализации устанавливается как вторая ОС, необходимо снять отметку с пункта Хранить время в BIOS по Гринвичу, иначе время в уже установленной ОС может отображаться некорректно.

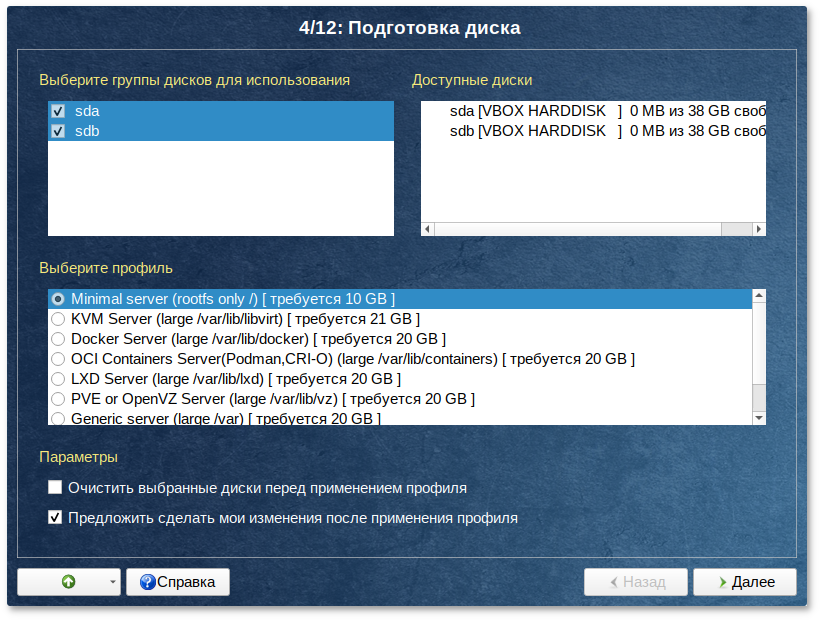

Глава 11. Подготовка диска

На этом этапе подготавливается площадка для установки Альт Сервер Виртуализации, в первую очередь — выделяется свободное место на диске.

Переход к этому шагу может занять некоторое время. Время ожидания зависит от производительности компьютера, объёма жёсткого диска, количества разделов на нём и других параметров.

11.1. Выбор профиля разбиения диска

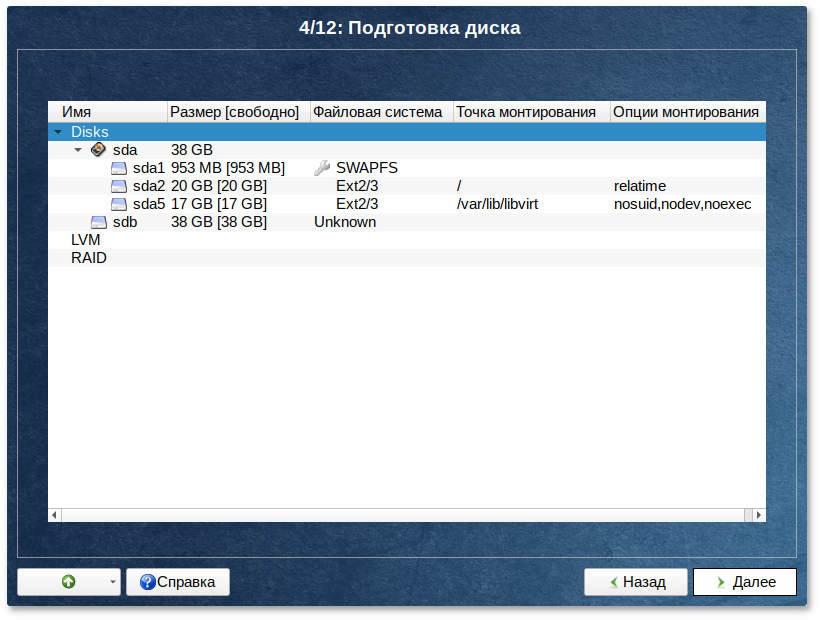

После завершения первичной конфигурации загрузочного носителя откроется окно Подготовка диска. В списке разделов перечислены уже существующие на жёстких дисках разделы (в том числе здесь могут оказаться съёмные flash-диски, подключённые к компьютеру в момент установки).

В списке

Выберите профиль перечислены доступные профили разбиения диска. Профиль — это шаблон распределения места на диске для установки ОС. Можно выбрать один из профилей:

Minimal server — единственная файловая система ext4 под корень (swap и раздел под efi автоматически);

KVM Server — большой раздел под /var/lib/libvirt;

Docker Server — большой раздел под /var/lib/docker;

OCI Containers Server (Podman,CRI-O) — большой раздел под /var/lib/containers;

LXD Server — большой раздел под /var/lib/lxd;

PVE or OpenVZ Server — большой раздел под /var/lib/vz;

Generic Server — большой раздел под /var.

Вручную.

Все профили, кроме последнего предполагают автоматическое разбиение диска.

11.2. Автоматический профиль разбиения диска

Выбор автоматического профиля разбиения диска влияет на предлагаемый по умолчанию профиль устанавливаемого программного обеспечения.

Например, при выборе пункта KVM Server — при разбиении диска будут выделены отдельные разделы для подкачки и для корневой файловой системы. Оставшееся место будет отведено под раздел /var/lib/libvirt. Если результат вас по каким-то причинам не устраивает, прямо сейчас можно его отредактировать.

От возможности редактировать результат разбиения можно отказаться, сняв выделение с пункта Предложить сделать мои изменения после применения профиля. В этом случае никакой информации о распределении дискового пространства на экране отображаться не будет. После осуществления физических изменений на жестком диске начнется установка базовой системы. Этот вариант подойдет для установки на чистый диск.

Рядом с названием каждого профиля указан минимальный объём свободного места на диске, требуемый для установки в соответствии с данным профилем. Если при применении одного из профилей автоматического разбиения диска доступного места на диске окажется недостаточно, то на монитор будет выведено сообщение об ошибке: Невозможно создать все разделы, недостаточно места на диске. В этом случае можно воспользоваться методом ручной разметки: профиль Вручную или установить отметку на пункте Очистить все диски перед применением профиля.

При отмеченном пункте Очистить все диски перед применением профиля будут удалены все данные со всех дисков (включая внешние USB-носители) без возможности восстановления. Рекомендуется использовать эту возможность при полной уверенности в том, что диски не содержат никаких ценных данных.

11.3. Ручной профиль разбиения диска

При необходимости освободить часть дискового пространства следует воспользоваться профилем разбиения Вручную. В этом случае можно удалить некоторые из существующих разделов или содержащиеся в них файловые системы. После этого можно создать необходимые разделы самостоятельно или вернуться к шагу выбора профиля и применить автоматический профиль. Выбор этой возможности требует знаний об устройстве диска и технологиях его разметки.

По нажатию кнопки Далее будет произведена запись новой таблицы разделов на диск и форматирование разделов. Только что созданные на диске программой установки разделы пока не содержат данных и поэтому форматируются без предупреждения. Уже существовавшие, но изменённые разделы, которые будут отформатированы, помечаются специальным значком в колонке Файловая система слева от названия. При уверенности в том, что подготовка диска завершена, подтвердите переход к следующему шагу нажатием кнопки Далее.

Не следует форматировать разделы с теми данными, которые вы хотите сохранить, например, со старыми пользовательскими данными (/home) или с другими операционными системами. С другой стороны, отформатировать можно любой раздел, который вы хотите «очистить» (удалить все данные).

Не уменьшайте NTFS-раздел с установленной Microsoft Windows Vista/Windows 7 средствами программы установки. В противном случае вы не сможете загрузить Microsoft Windows Vista/Windows 7 после установки Альт Сервер Виртуализации. Для выделения места под установку Альт Сервер Виртуализации воспользуйтесь средствами, предоставляемыми самой Microsoft Windows Vista/Windows 7: Управление дисками → Сжать.

11.4. Дополнительные возможности разбиения диска

Ручной профиль разбиения диска позволяет установить ОС на программный RAID-массив, разместить разделы в томах LVM и использовать шифрование на разделах. Данные возможности требуют от пользователя понимания принципов функционирования указанных технологий.

11.4.1. Создание программного RAID-массива

Избыточный массив независимых дисков RAID (redundant array of independent disks) — технология виртуализации данных, которая объединяет несколько НЖМД в логический элемент для избыточности и повышения производительности.

Для создания программного RAID-массива потребуется минимум два жёстких диска.

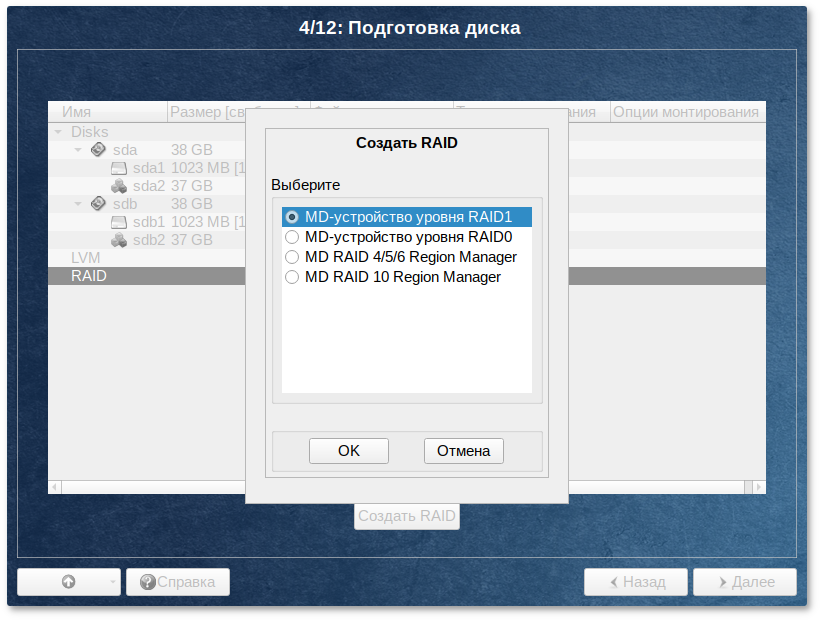

Программа установки поддерживает создание программных RAID-массивов следующих типов:

RAID 1;

RAID 0;

RAID 4/5/6;

RAID 10.

Процесс подготовки к установке на RAID условно можно разбить на следующие шаги:

создание разделов на жёстких дисках;

создание RAID-массивов на разделах жёсткого диска;

создание файловых систем на RAID-массиве.

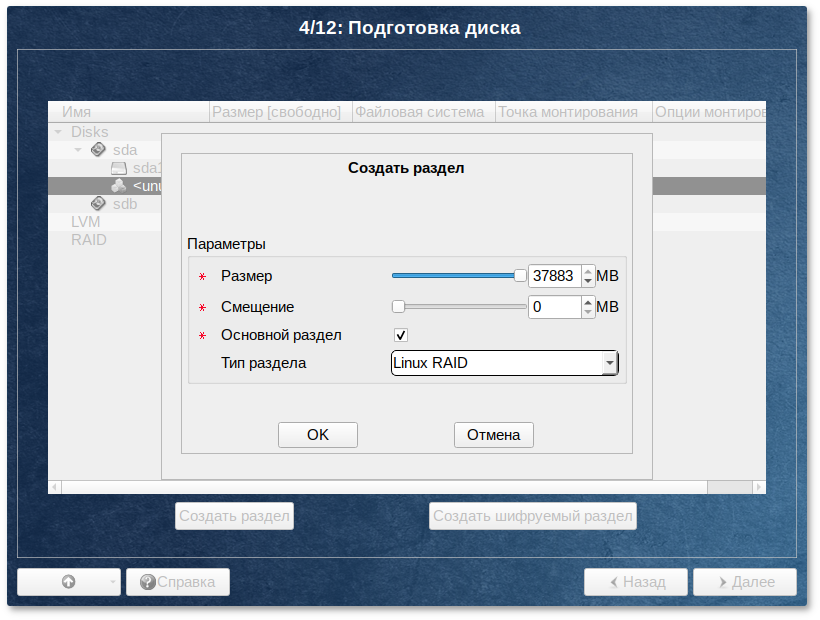

Для настройки параметров нового раздела из состава RAID-массива необходимо выбрать неразмеченный диск в окне профиля разбивки пространства Подготовить разделы вручную и нажать кнопку Создать раздел.

При создании разделов на жёстких дисках для последующего включения их в RAID-массивы следует указать Тип раздела для них равным Linux RAID.

При создании разделов следует учесть, что объём результирующего массива может зависеть от размера, включённых в него разделов жёсткого диска. Например, при создании RAID 1, результирующий размер массива будет равен размеру минимального участника.

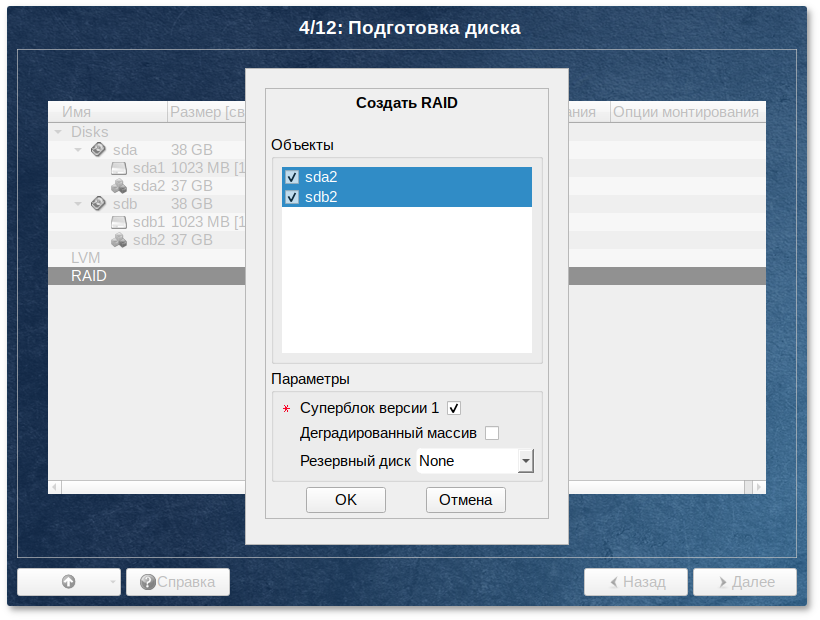

После создания разделов на дисках можно переходить к организации самих RAID-массивов. Для этого в списке следует выбрать пункт RAID, после чего нажать кнопку Создать RAID.

Далее мастер предложит выбрать тип массива и указать его участников.

После создания RAID-массивов их можно использовать как обычные разделы на жёстких дисках, то есть, на них можно создавать файловые системы или же, например, включать их в LVM-тома.

11.4.2. Создание LVM-томов

Менеджер логических дисков LVM (Logical Volume Manager) — средство гибкого управления дисковым пространством, которое позволяет создавать поверх физических разделов (либо неразбитых дисков) логические тома, которые в самой системе будут видны как обычные блочные устройства с данными (обычные разделы).

Процесс подготовки к установке на LVM условно можно разбить на следующие шаги:

Для создания группы томов LVM может потребоваться предварительно удалить таблицу разделов с жёсткого диска.

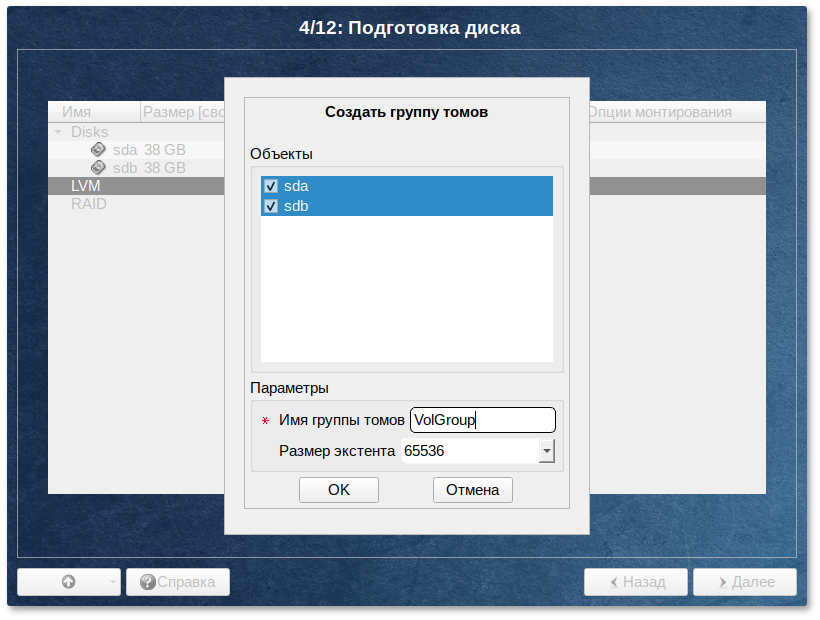

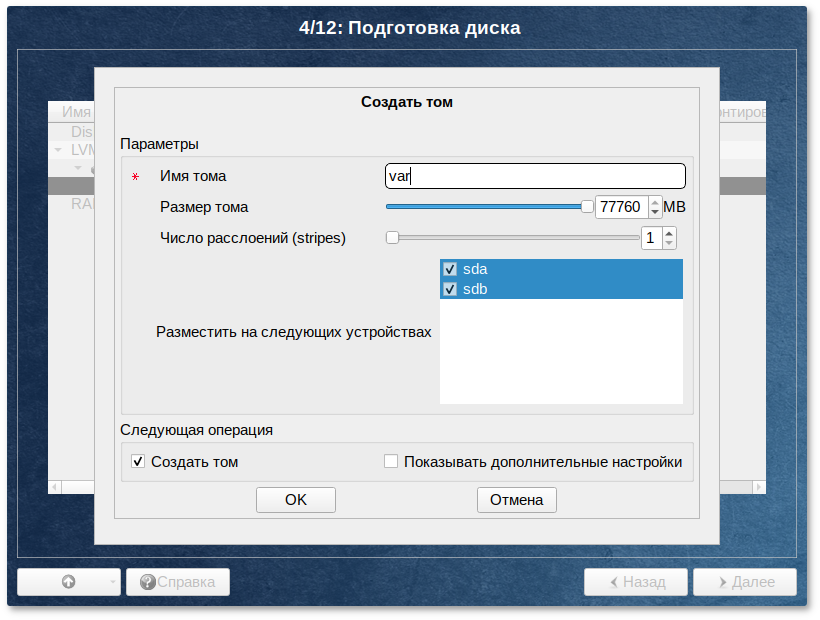

Для создания группы томов LVM в списке следует выбрать пункт LVM, после чего нажать кнопку Создать группу томов.

После создания группы томов LVM её можно использовать как обычный жёсткий диск, то есть внутри группы томов можно создавать тома (аналог раздела на физическом жёстком диске) и файловые системы внутри томов.

11.4.3. Создание шифрованных разделов

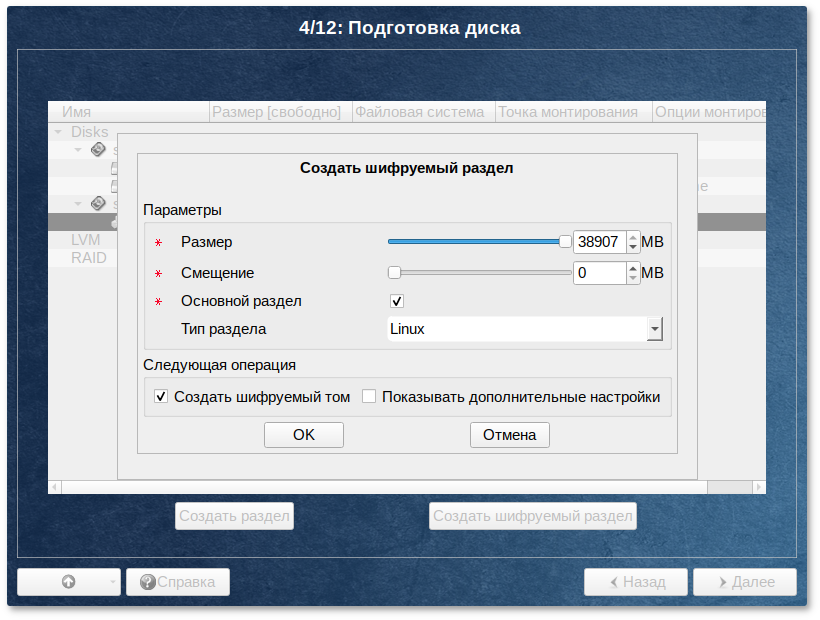

Программа установки Альт Сервер Виртуализации позволяет создавать шифрованные разделы.

Процесс создания шифрованного раздела ничем не отличается от процесса создания обычного раздела и инициируется нажатием на кнопку Создать шифруемый раздел.

После создания шифрованного раздела мастер, как и при создании обычного раздела, предложит создать на нём файловую систему и при необходимости потребует указать точку монтирования.

Установка загрузчика на шифрованный раздел не поддерживается.

Для сохранения всех внесенных настроек и продолжения установки в окне Подготовка диска нужно нажать кнопку Далее.

Глава 12. Установка системы

На данном этапе происходит распаковка ядра и установка набора программ, необходимых для работы Альт Сервер Виртуализации.

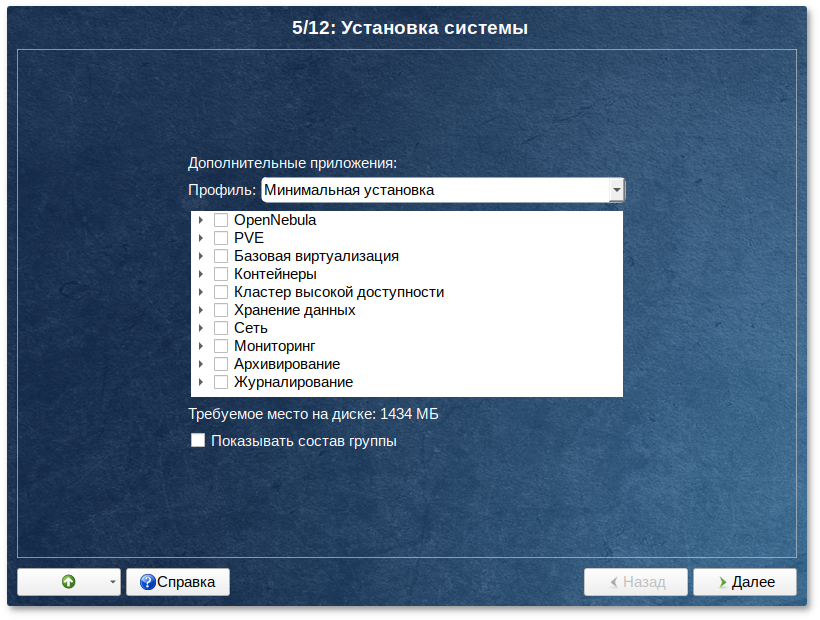

Программа установки предлагает выбрать дополнительные пакеты программ, которые будут включены в состав Альт Сервер Виртуализации и установлены вместе с ней на диск.

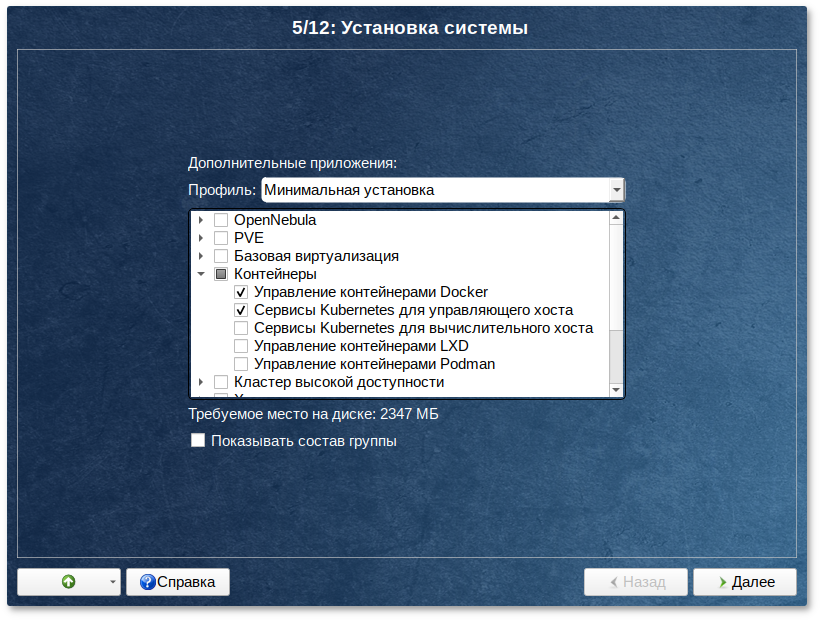

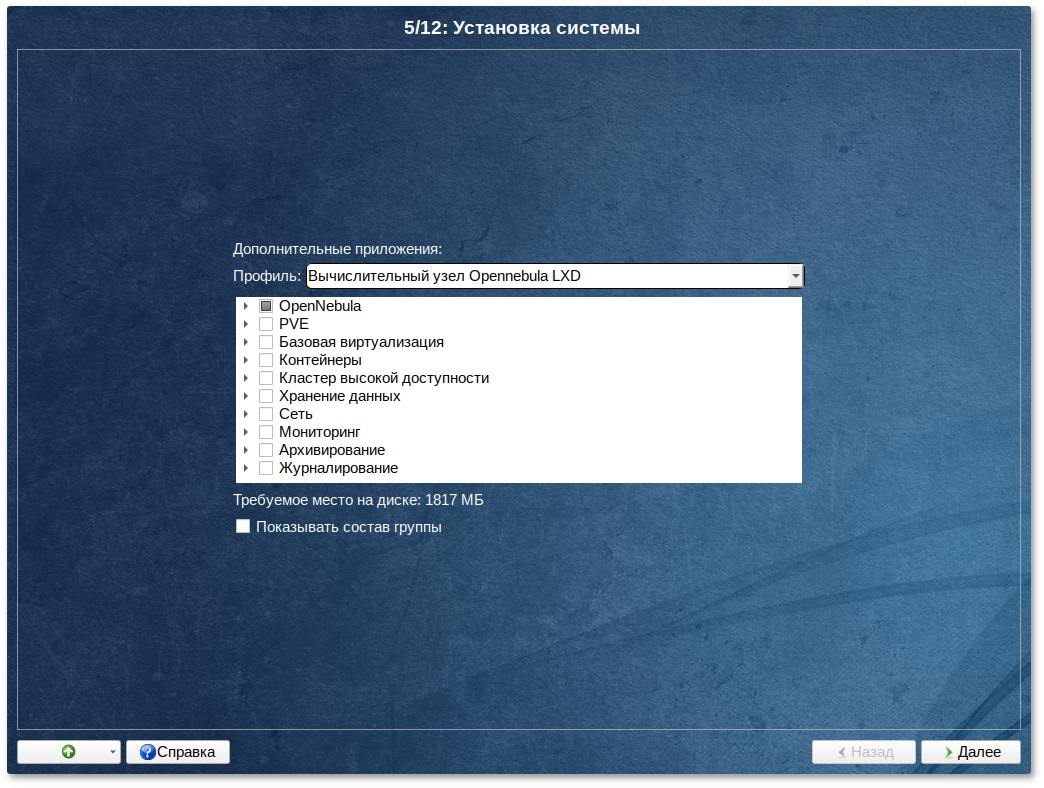

12.1. Дополнительные приложения

В дистрибутиве Альт Сервер Виртуализации доступно значительное количество программ (до нескольких тысяч), часть из них составляет саму операционную систему, а остальные — это прикладные программы и утилиты.

В Альт Сервер Виртуализации все операции установки и удаления производятся над пакетами — отдельными компонентами системы. Пакет и программа соотносятся неоднозначно: иногда одна программа состоит из нескольких пакетов, иногда один пакет включает несколько программ.

В процессе установки системы обычно не требуется детализированный выбор компонентов на уровне пакетов — это требует слишком много времени и знаний от проводящего установку. Тем более, что комплектация дистрибутива подбирается таким образом, чтобы из имеющихся программ можно было составить полноценную рабочую среду для соответствующей аудитории пользователей. Поэтому, в процессе установки системы пользователю предлагается выбрать из небольшого списка групп пакетов, объединяющих пакеты, необходимые для решения наиболее распространённых задач. Под списком групп на экране отображается информация об объёме дискового пространства, которое будет занято после установки пакетов, входящих в выбранные группы.

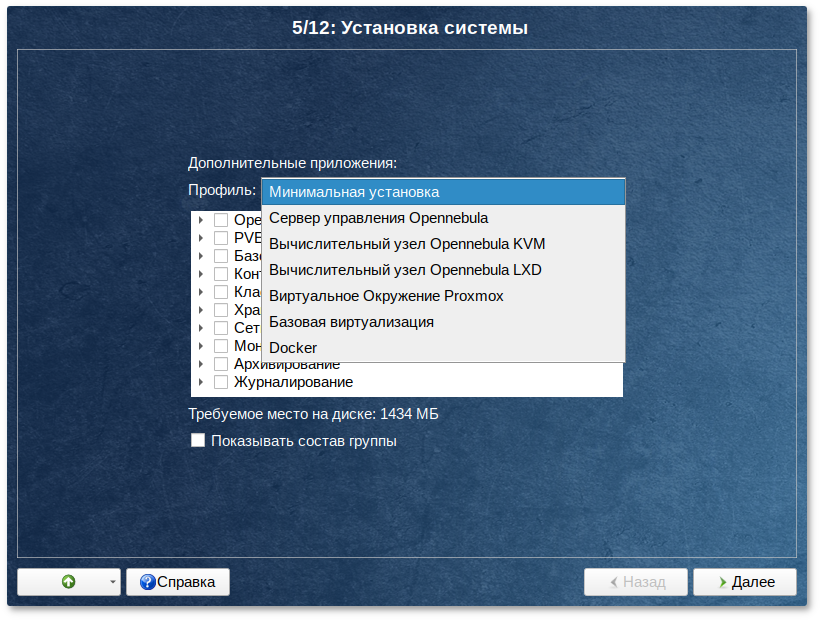

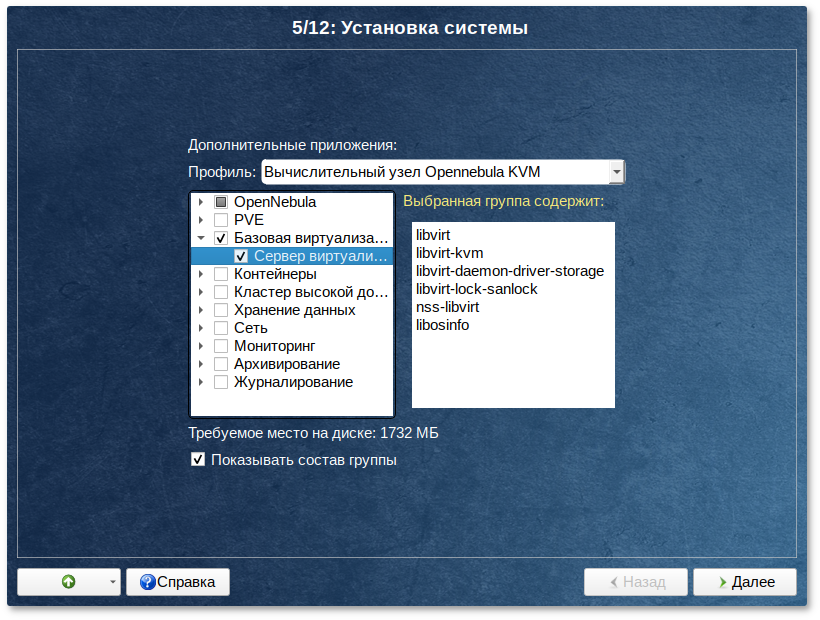

При установке сервера доступны следующие профили:

Минимальная установка — дополнительное ПО в состав устанавливаемых пакетов включаться не будет;

Сервер управления Opennebula — управляющий сервер Opennebula;

Вычислительный узел Opennebula KVM — гипервизор с виртуальными машинами;

Вычислительный узел Opennebula LXD — гипервизор LXC контейнеров;

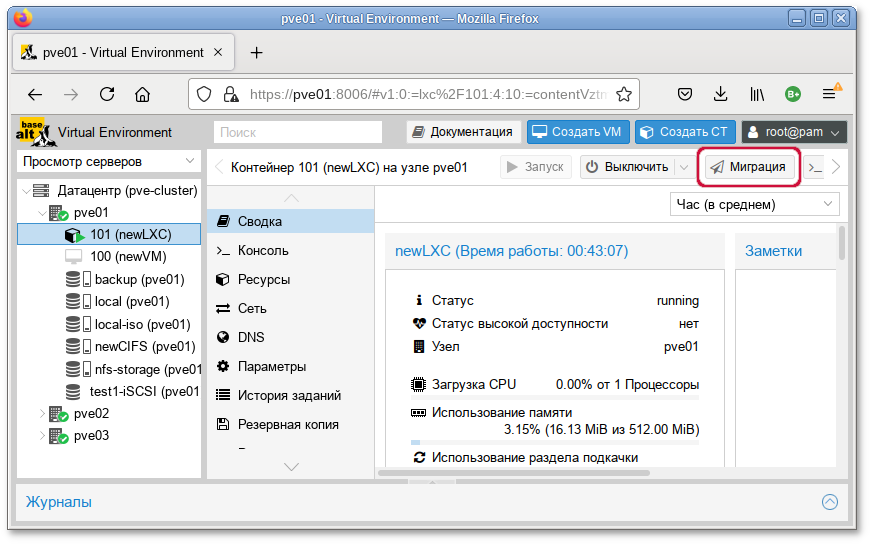

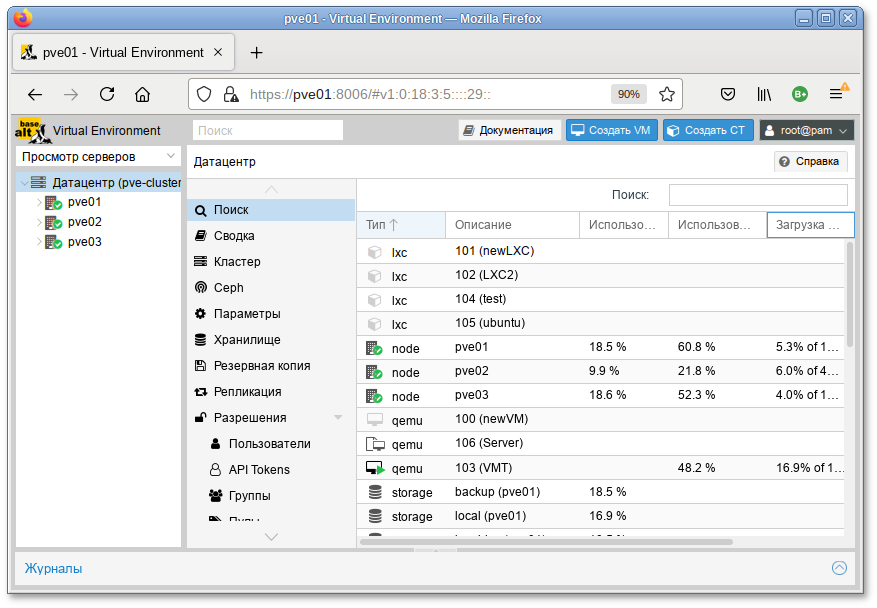

Виртуальное Окружение Proxmox — узел кластера Proxmox Virtual Enviroment. Все ноды кластера равнозначны: нет деления на сервер управления и гипервизор;

Базовая виртуализация — минимальный гипервизор, qemu + libvirtd;

Docker — сервер с предустановленным docker.

После выбора профиля можно изменить состав устанавливаемых пакетов.

Под списком групп на экране отображается информация об объёме дискового пространства, которое будет занято после установки пакетов, входящих в выбранные группы.

Опция Показать состав группы выводит список программных пакетов, входящих в состав той или иной группы пакетов.

Выбрав необходимые группы, следует нажать кнопку Далее, после чего начнётся установка пакетов.

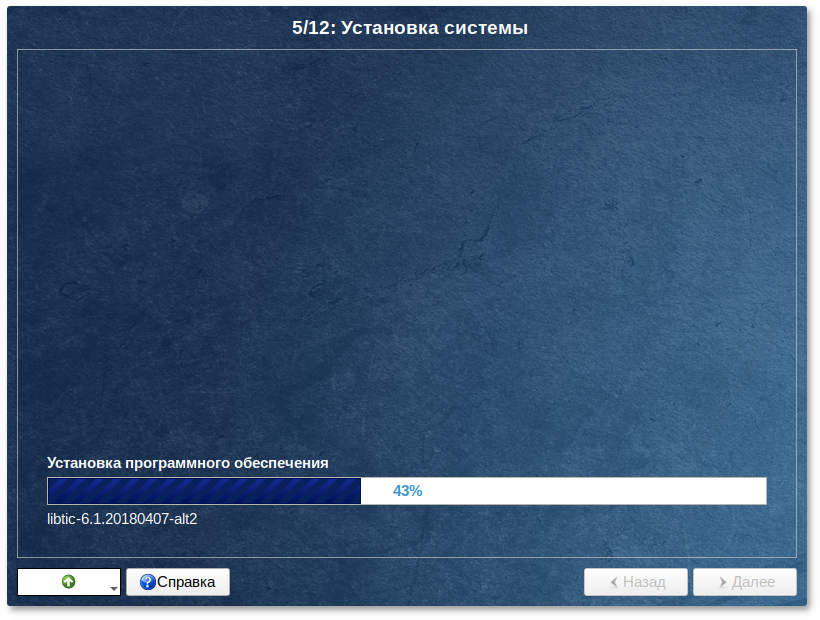

На этом этапе происходит установка набора программ, необходимых для работы системы.

Установка происходит автоматически в два этапа:

получение пакетов;

установка пакетов.

Получение пакетов осуществляется из источника, выбранного на этапе начальной загрузки. При сетевой установке время выполнения этого шага будет зависеть от скорости соединения и может быть значительно большим в сравнении с установкой с лазерного диска.

Глава 13. Сохранение настроек

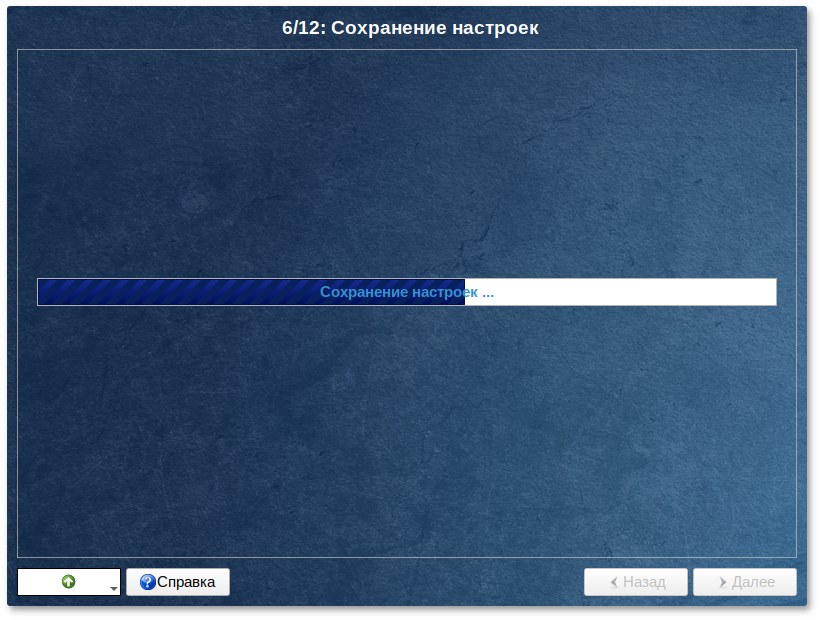

Начиная с данного этапа, программа установки работает с файлами только что установленной базовой системы. Все последующие изменения можно будет совершить после завершения установки посредством редактирования соответствующих конфигурационных файлов или при помощи модулей управления, включенных в дистрибутив.

По завершении установки базовой системы начинается шаг сохранения настроек. Он проходит автоматически и не требует вмешательства пользователя. На экране отображается индикатор выполнения.

На этом шаге производится перенос настроек, выполненных на первых шагах установки, в только что установленную базовую систему. Также производится запись информации о соответствии разделов жесткого диска смонтированным на них файловым системам (заполняется конфигурационный файл /etc/fstab).

После сохранения настроек осуществляется автоматический переход к следующему шагу.

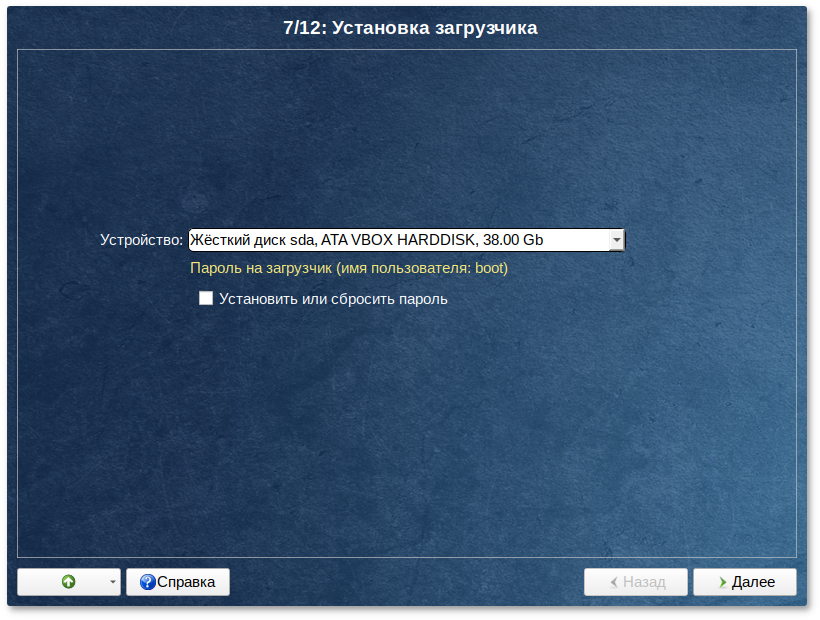

Глава 14. Установка загрузчика

Загрузчик ОС — это программа, которая позволяет загружать Альт Сервер Виртуализации и другие ОС, если они установлены на данной машине.

Программа установки автоматически определяет, в каком разделе НЖМД следует располагать загрузчик для возможности корректного запуска ОС Альт Сервер Виртуализации. Положение загрузчика, в случае необходимости, можно изменить в выпадающем списке Устройство, выбрав другой раздел.

Если же вы планируете использовать и другие ОС, уже установленные на этом компьютере, тогда имеет значение на каком жёстком диске или в каком разделе будет расположен загрузчик.

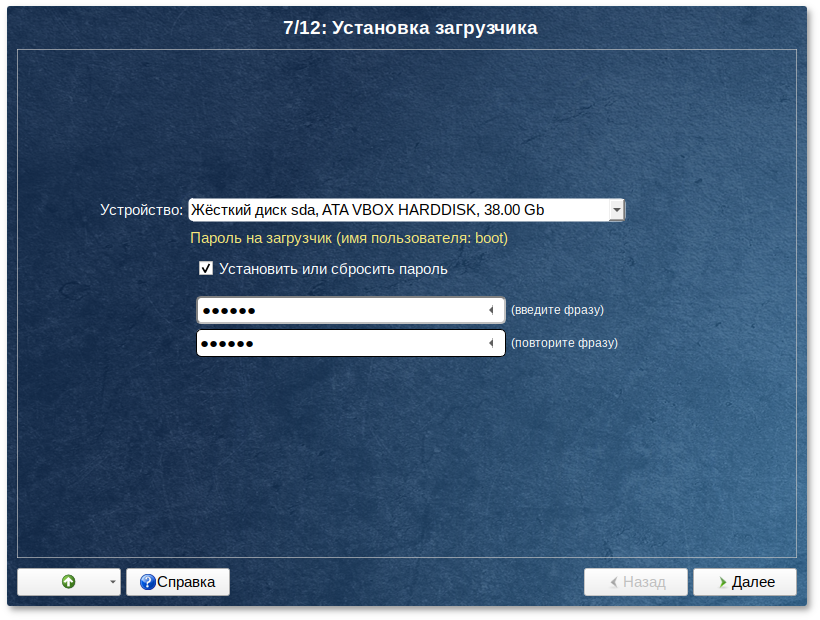

Для ограничения доступа к опциям загрузки можно установить пароль на загрузчик. Для этого необходимо отметить пункт Установить или сбросить пароль и, в появившихся полях для ввода, задать пароль.

При необходимости изменения опций загрузки при старте компьютера потребуется ввести имя пользователя «boot» и заданный на этом шаге пароль.

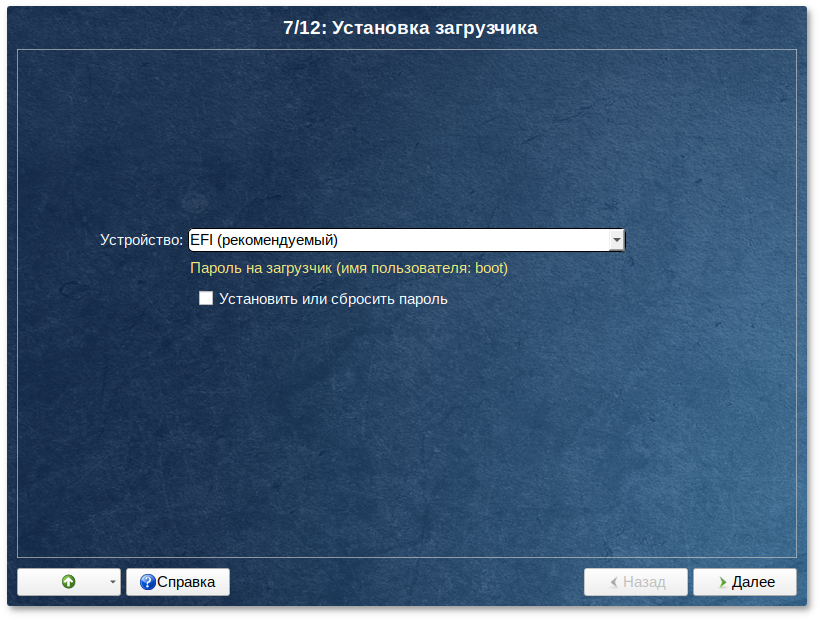

При установке на

EFI выберите в качестве устройства для установки «». Рекомендуется выбрать автоматическое разбиение на этапе разметки диска для создания необходимых разделов для загрузки с

EFI.

Для подтверждения выбора и продолжения работы программы установки необходимо нажать кнопку Далее.

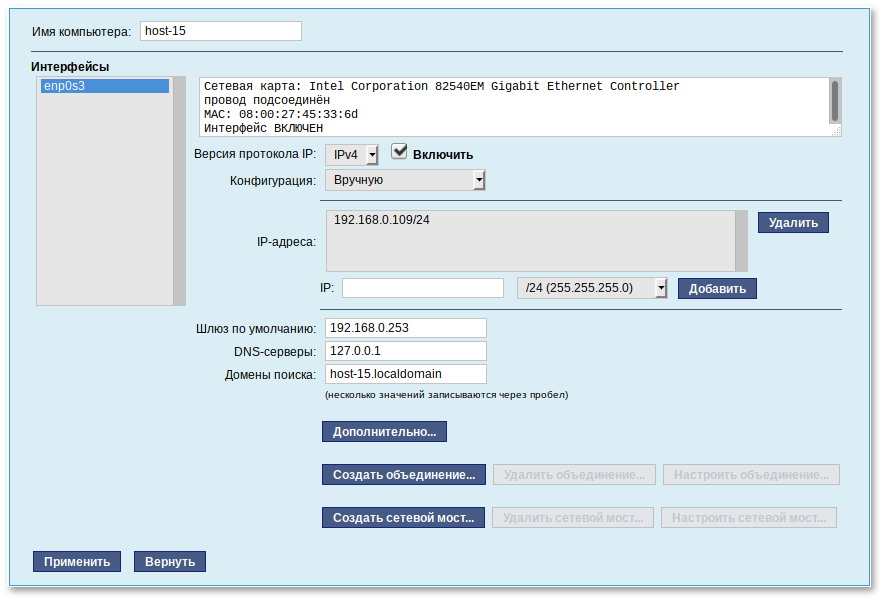

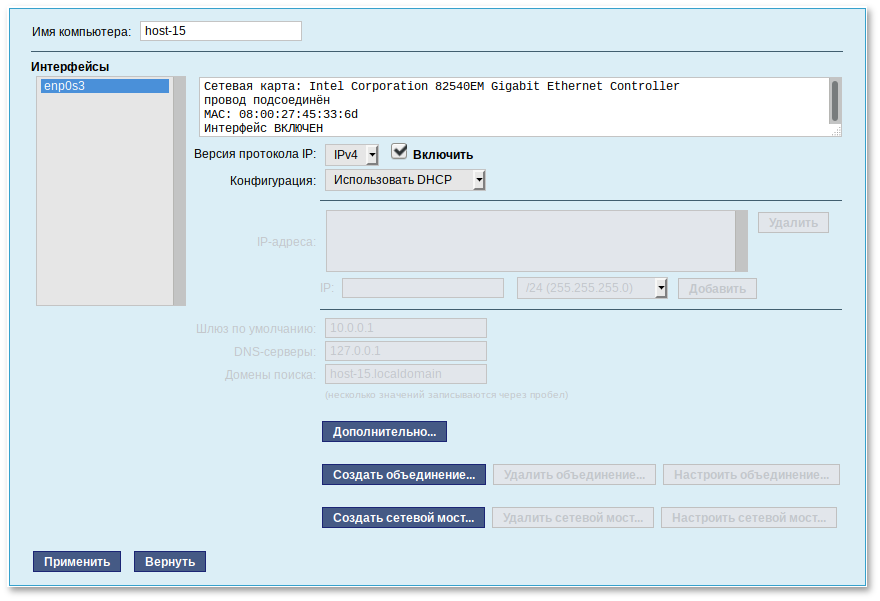

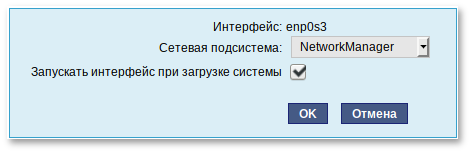

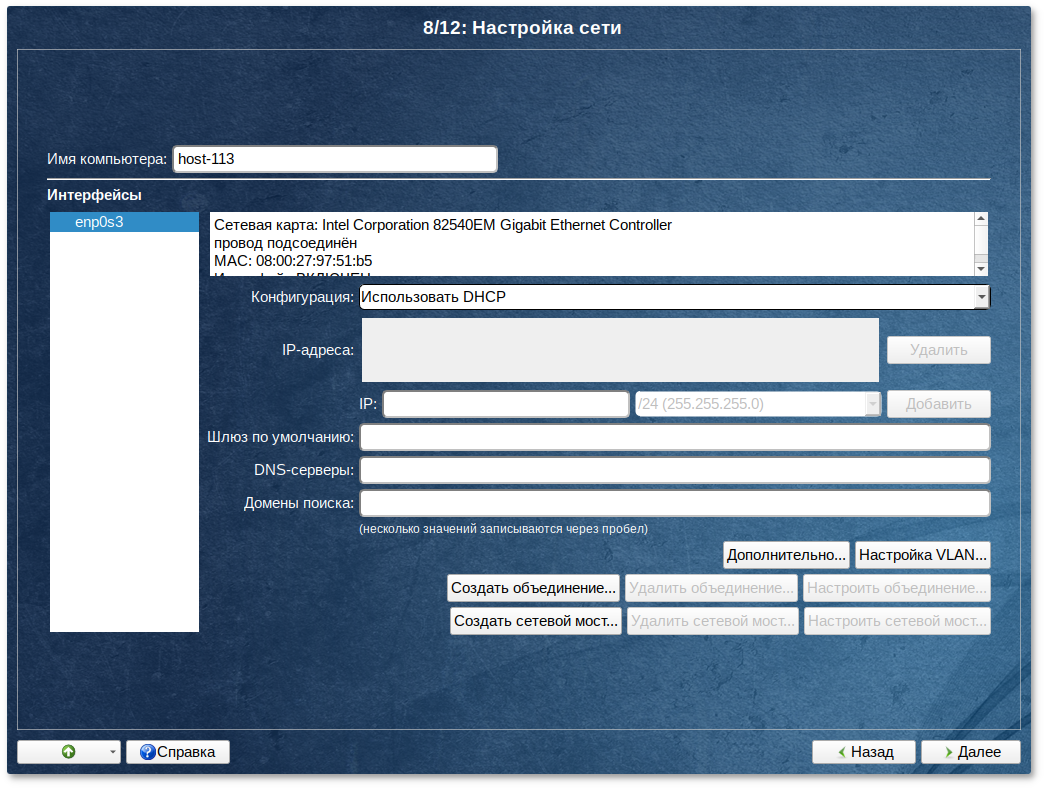

Глава 15. Настройка сети

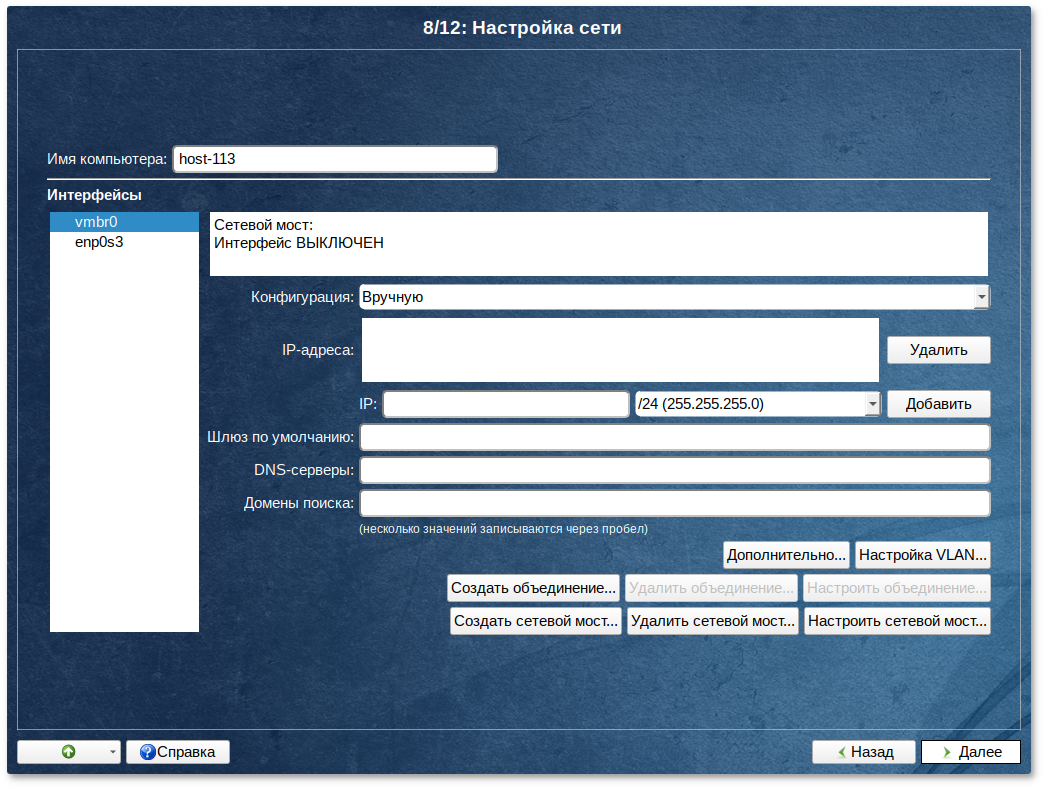

На этом этапе необходимо задать параметры работы сетевой карты и настройки сети: IP-адреса сетевых интерфейсов, DNS-сервер, шлюз и т.п. Конкретные значения будут зависеть от используемого вами сетевого окружения. Ручного введения настроек можно избежать при наличии в сети настроенного DHCP-сервера. В этом случае все необходимые сетевые настройки будут получены автоматически.

Если в сервере есть несколько сетевых карт, то одну можно использовать для управления (на неё следует назначить IP-адрес без моста), вторую использовать только для моста, в который будут подключаться виртуальные машины. Для использования CEPH, iSCSI, NFS или другого сетевого хранилища стоит использовать третью сетевую карту, желательно 10G.

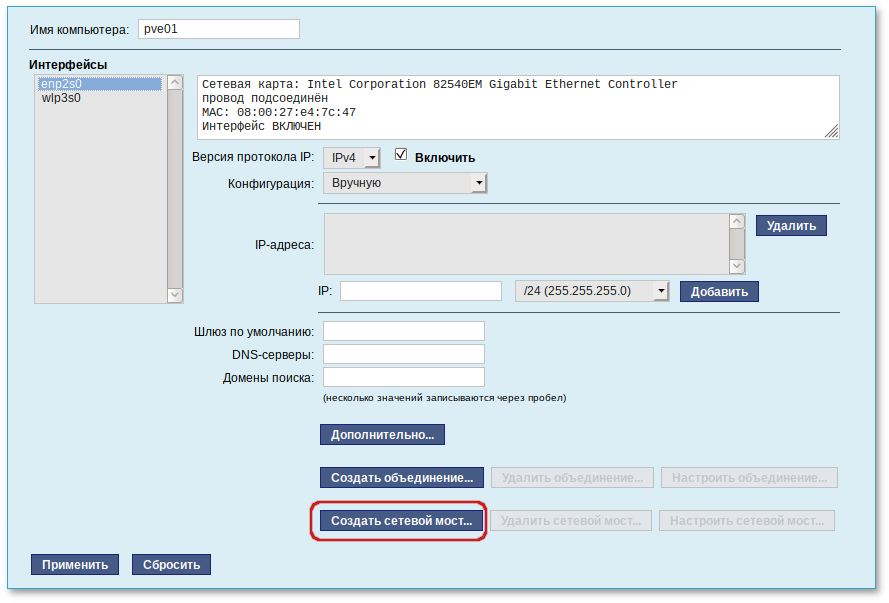

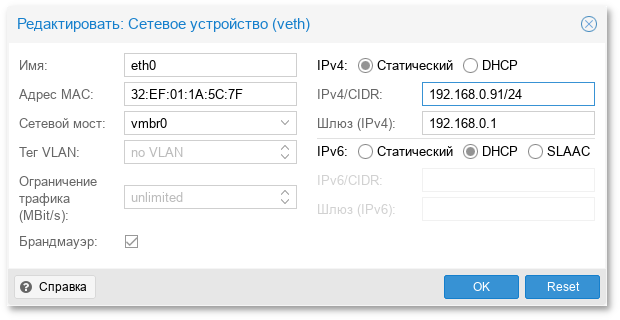

Для настройки Ethernet-моста следует нажать кнопку Настроить сетевой мост:

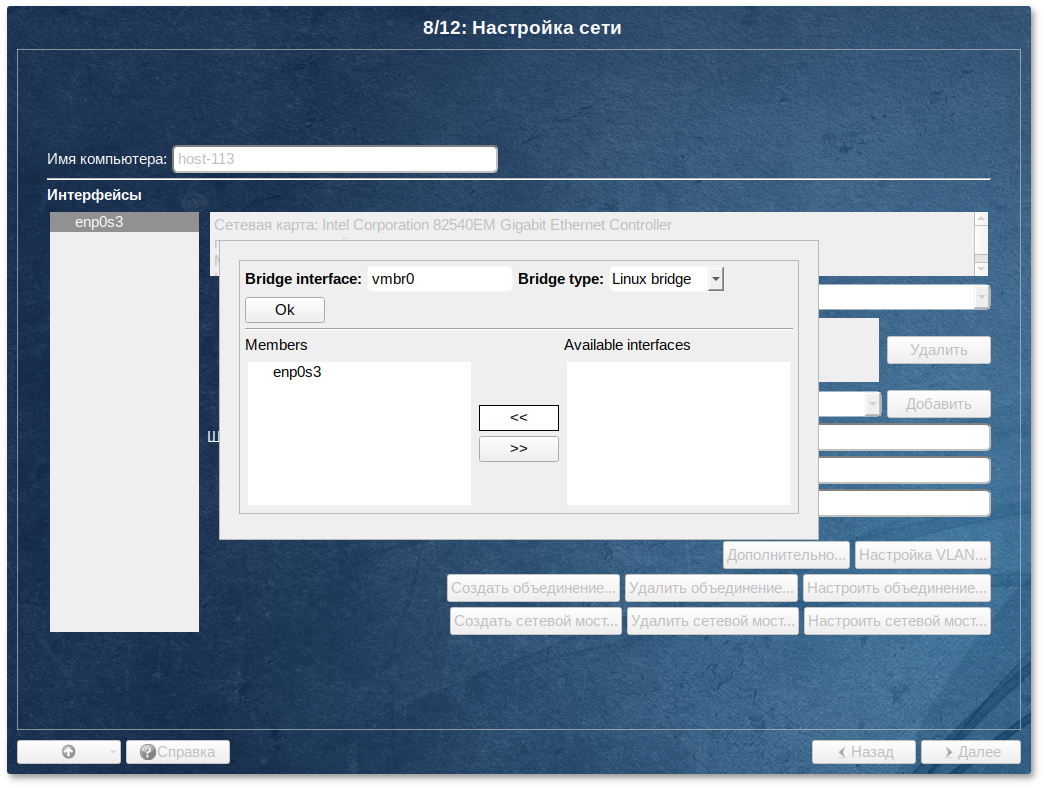

В открывшемся окне необходимо выбрать сетевой интерфейс в списке доступных интерфейсов (Available interfaces), переместить его в список Участники (Members), в выпадающем списке Тип моста (Bridge type) выбрать тип моста: Linux Bridge (по умолчанию) или Open vSwitch и нажать кнопку Ok:

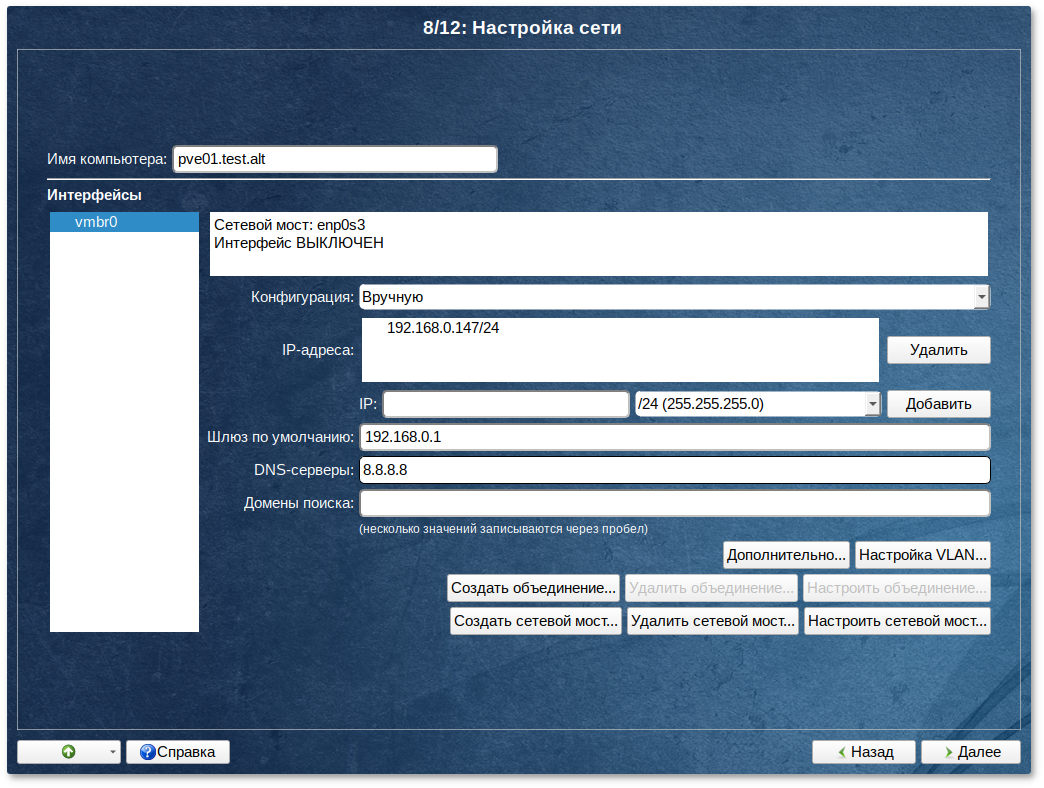

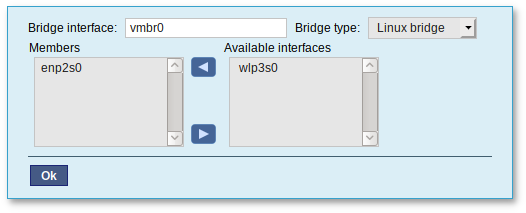

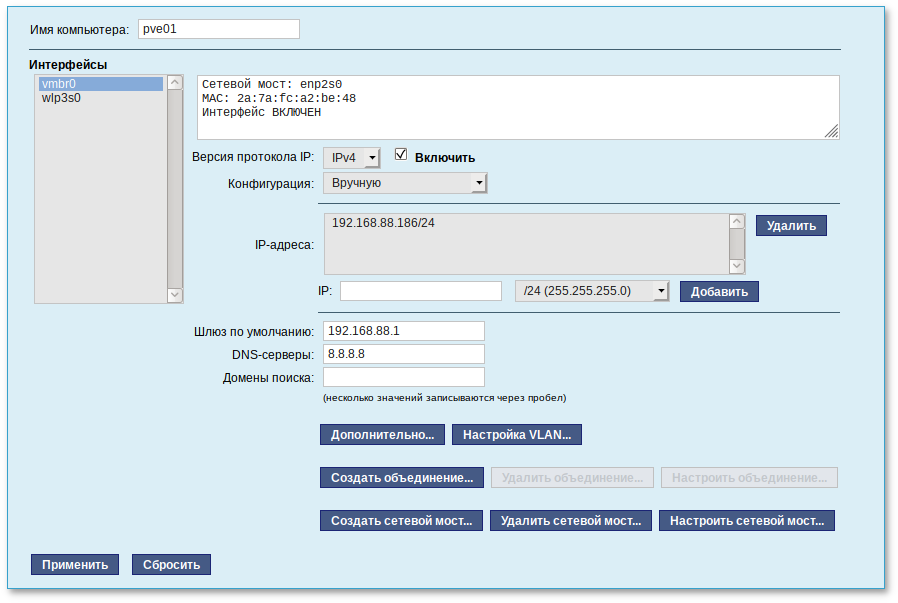

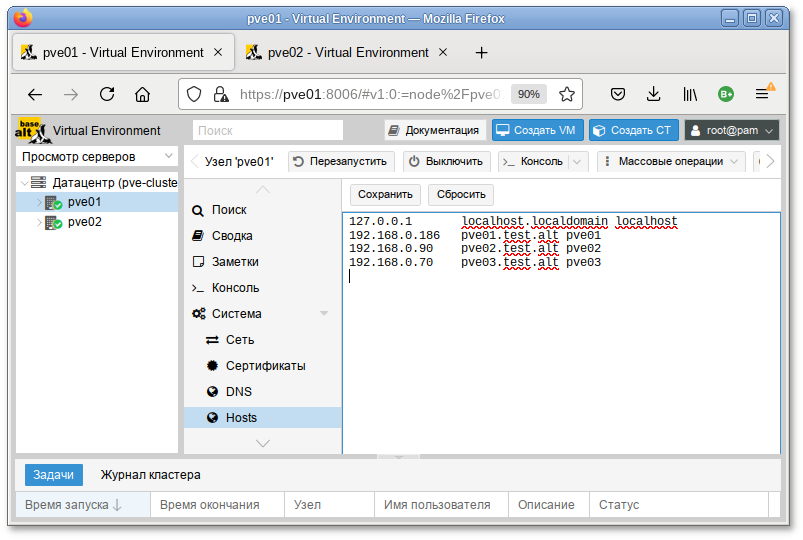

Настроить сетевой интерфейс vmbr0: ввести имя компьютера, задать IP-адрес и нажать кнопку Добавить, ввести адрес шлюза по умолчанию и DNS-сервера:

При установке PVE в поле Имя компьютера необходимо указать FQDN (полное имя с доменом).

Для сохранения настроек сети и продолжения работы программы установки необходимо нажать кнопку Далее.

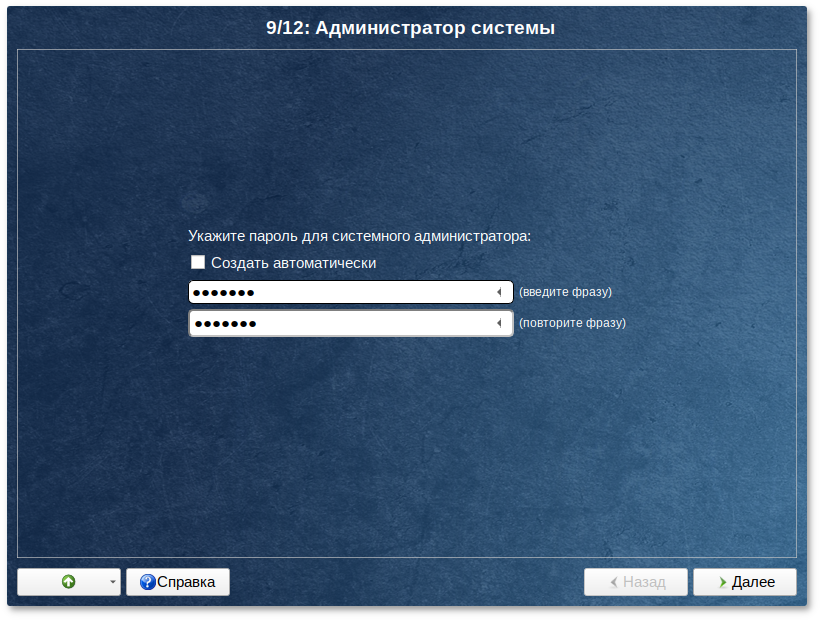

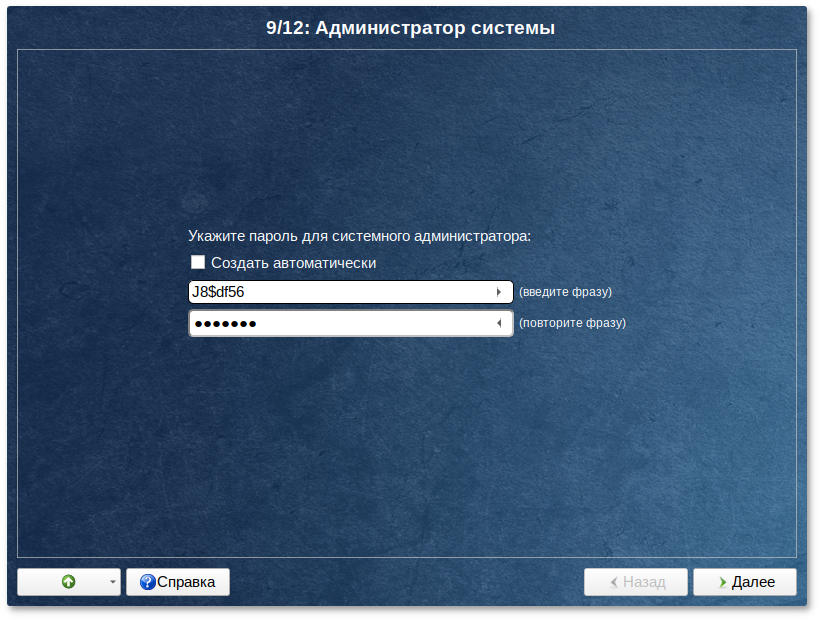

Глава 16. Администратор системы

На данном этапе загрузчик создает учетную запись администратора. В открывшемся окне необходимо ввести пароль учетной записи администратора (root). Чтобы исключить опечатки при вводе пароля, пароль учетной записи вводится дважды.

Чтобы избежать последствий неверной раскладки клавиатуры можно просмотреть пароль, который будет сохранен. Для этого нажмите на значок стрелки в поле ввода:

Для автоматической генерации пароля необходимо отметить пункт Создать автоматически. Система предложит пароль, сгенерированный автоматическим образом в соответствии с требованиями по стойкости паролей.

В любой системе Linux всегда присутствует один специальный пользователь — администратор системы, он же суперпользователь. Для него зарезервировано стандартное системное имя — root.

Администратор системы отличается от всех прочих пользователей тем, что ему позволено производить любые, в том числе самые разрушительные изменения в системе. Поэтому выбор пароля администратора системы — очень важный момент для безопасности. Любой, кто сможет ввести его правильно (узнать или подобрать), получит неограниченный доступ к системе. Даже ваши собственные неосторожные действия от имени root могут иметь катастрофические последствия для всей системы.

Стоит запомнить пароль root — его нужно будет вводить для получения права изменять настройки системы с помощью стандартных средств настройки Альт Сервер Виртуализации. Более подробную информацию о режиме суперпользователя вы можете прочитать в главе

Режим суперпользователя.

Подтверждение введенного (или сгенерированного) пароля учетной записи администратора (root) и продолжение работы программы установки выполняется нажатием кнопки Далее.

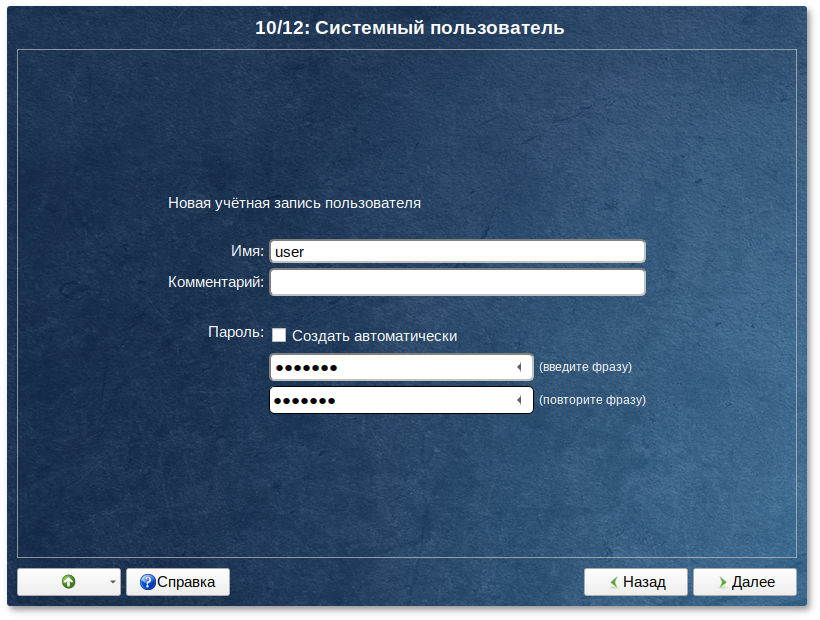

Глава 17. Системный пользователь

На данном этапе программа установки создает учетную запись системного пользователя (пользователя) Альт Сервер Виртуализации.

Помимо администратора (root) в систему необходимо добавить, по меньшей мере, одного обычного системного пользователя. Работа от имени администратора системы считается опасной, поэтому повседневную работу в Linux следует выполнять от имени ограниченного в полномочиях системного пользователя.

При добавлении системного пользователя предлагается ввести имя учётной записи пользователя. Имя учётной записи всегда представляет собой одно слово, состоящее только из строчных латинских букв (заглавные запрещены), цифр и символа подчёркивания «_» (причём цифра и символ «_» не могут стоять в начале слова).

Для того чтобы исключить опечатки, пароль пользователя вводится дважды. Пароль пользователя можно создать автоматически, по аналогии с автоматическим созданием пароля суперпользователя.

Для автоматической генерации пароля необходимо отметить пункт Создать автоматически. Система предложит пароль, сгенерированный автоматическим образом в соответствии с требованиями по стойкости паролей.

В процессе установки предлагается создать только одну учётную запись системного пользователя — от его имени можно выполнять задачи, не требующие привилегий суперпользователя. Учётные записи для всех прочих пользователей системы можно будет создать в любой момент после установки операционной системы.

Подтверждение введенного (или сгенерированного) пароля учетной записи системного пользователя и продолжение работы программы установки выполняется нажатием кнопки Далее.

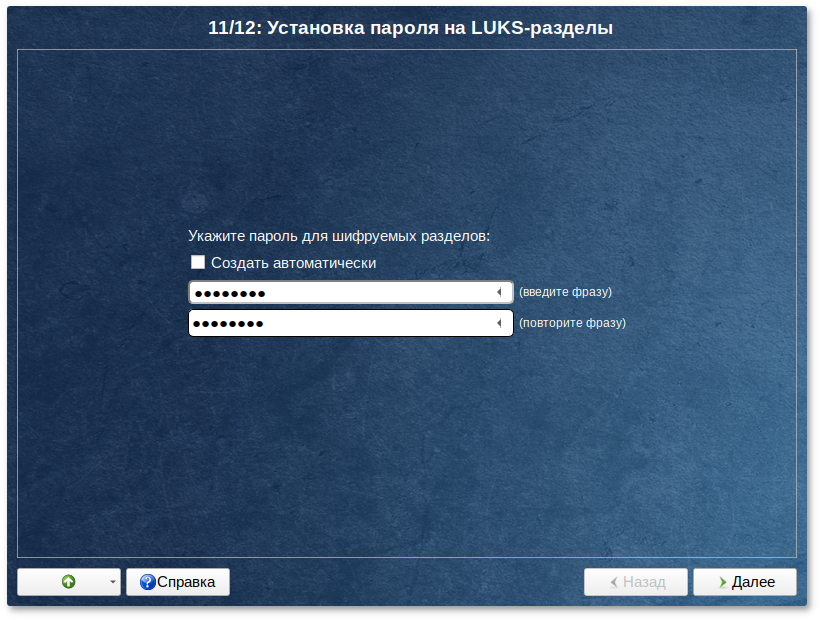

Глава 18. Установка пароля на шифрованные разделы

Если вы не создавали шифруемые разделы, то этот шаг пропускается автоматически. В этом случае сразу переходите к главе

Завершение установки.

На этом этапе требуется ввести пароль для шифруемых разделов. Этот пароль потребуется вводить для того, чтобы получать доступ к информации на данных разделах.

Например, если вы зашифровали /home, то во время загрузки системы будет необходимо ввести пароль для этого раздела, иначе вы не сможете получить доступ в систему под своим именем пользователя.

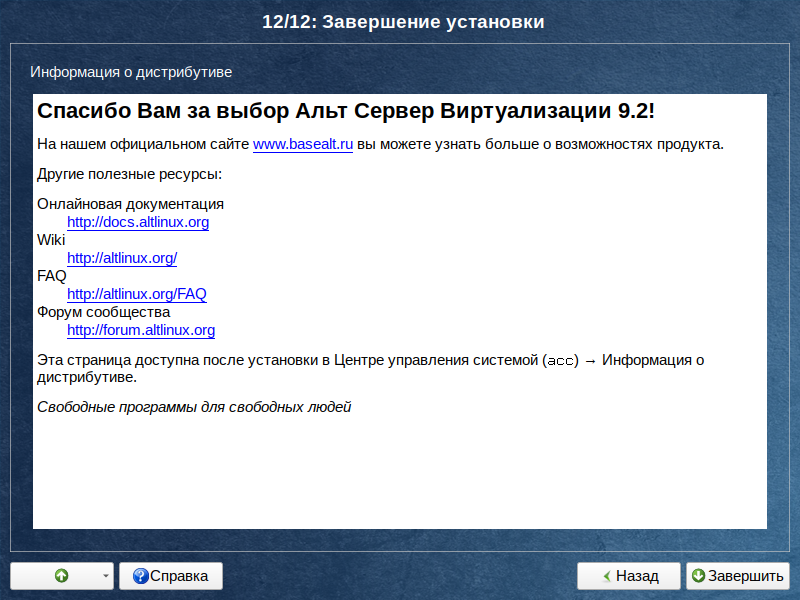

Глава 19. Завершение установки

На экране последнего шага установки отображается информация о завершении установки Альт Сервер Виртуализации.

После нажатия кнопки Завершить автоматически начнется перезагрузка системы.

Не забудьте извлечь установочный DVD (если это не происходит автоматически). Далее можно загружать установленную систему в обычном режиме.

Глава 20. Обновление системы до актуального состояния

После установки системы, её лучше сразу обновить до актуального состояния. Можно не обновлять систему и сразу приступать к работе только в том случае, если вы не планируете подключаться к сети или Интернету, не собираетесь устанавливать дополнительных программ.

Для обновления системы необходимо выполнить команды (с правами администратора):

# apt-get update

# apt-get dist-upgrade

# update-kernel

# apt-get clean

# reboot

Получить права администратора можно, выполнив в терминале команду:

$ su -

или зарегистрировавшись в системе (например, на второй консоли

Ctrl+

Alt+

F2) под именем

root. Про режим суперпользователя можно почитать в главе

Режим суперпользователя.

Часть III. Начало использования Альт Сервер Виртуализации

В этой части рассматривается загрузка установленной операционной системы и вход в среду рабочего стола.

Глава 21. Загрузка системы

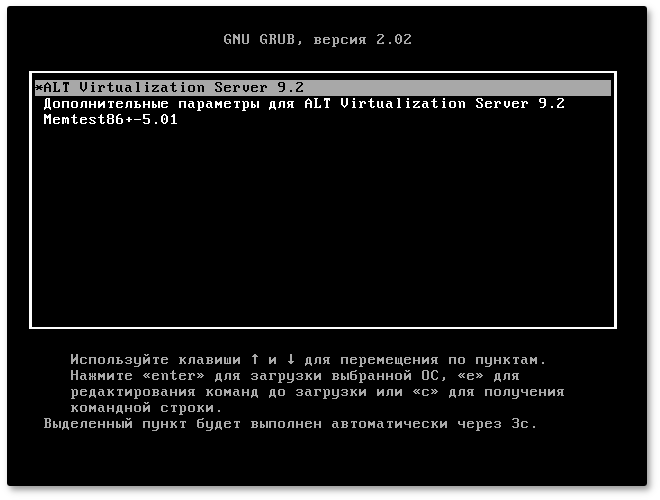

Запуск Альт Сервер Виртуализации выполняется автоматически после запуска компьютера и отработки набора программ BIOS.

На экране появляется меню, в котором перечислены возможные варианты загрузки операционной системы.

При первом старте, в условиях установки нескольких ОС на один компьютер, возможно отсутствие в загрузочном меню пункта/пунктов с другой/другими операционными системами, они будут добавлены в список при последующей перезагрузке. Все перечисленные в меню после перезагрузки варианты могут быть загружены загрузчиком Linux.

Стрелками клавиатуры Вверх и Вниз выберите нужную операционную систему. Дополнительно к основным вариантам запуска ОС из этого меню можно загрузить Linux в безопасном режиме или запустить проверку памяти.

Загрузка операционной системы по умолчанию (первая в списке) начинается автоматически после небольшого времени ожидания (обычно несколько секунд). Нажав клавишу Enter, можно начать загрузку немедленно.

Нажатием клавиши E можно вызвать редактор параметров текущего пункта загрузки. Если система настроена правильно, то редактировать их нет необходимости.

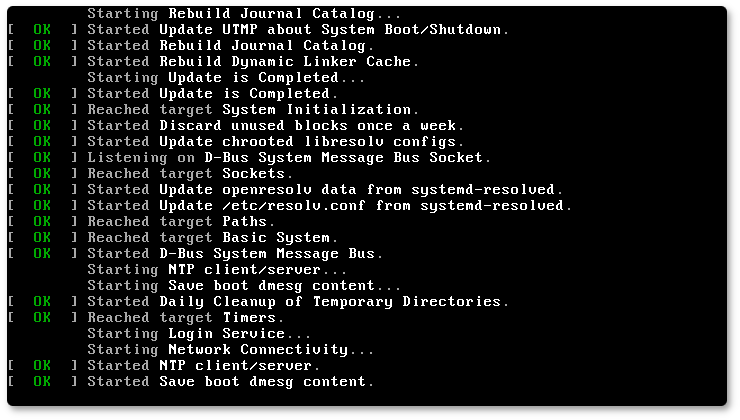

В процессе загрузки Альт Сервер Виртуализации пользователь может следить за информацией процесса загрузки, которая отображает этапы запуска различных служб и программных серверов в виде отдельных строк, на экране монитора.

При этом каждая строка начинается словом вида [XXXXXXX] (FAILED или OK), являющегося признаком нормального или ненормального завершения этапа загрузки. Слово XXXXXXX=FAILED (авария) свидетельствует о неуспешном завершении этапа загрузки, что требует вмешательства и специальных действий администратора системы.

Загрузка операционной системы может занять некоторое время, в зависимости от производительности компьютера. Основные этапы загрузки операционной системы — загрузка ядра, подключение (монтирование) файловых систем, запуск системных служб — периодически могут дополняться проверкой файловых систем на наличие ошибок. В этом случае время ожидания может быть занять больше времени, чем обычно. Подробную информацию о шагах загрузки можно получить, нажав клавишу Esc.

Глава 22. Получение доступа к зашифрованным разделам

В случае, если вы создали шифрованный раздел, вам потребуется вводить пароль при обращении к этому разделу.

Например, если был зашифрован домашний раздел /home, то для того, чтобы войти в систему под своим именем пользователя, вам потребуется ввести пароль этого раздела и затем нажать Enter.

Если не ввести пароль за отведенный промежуток времени, то загрузка системы завершится ошибкой. В этом случае вам следует перезагрузить систему, нажав для этого два раза Enter, а затем клавиши Ctrl+Alt+Delete.

Глава 23. Вход в систему

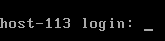

Стандартная установка Альт Сервер Виртуализации включает базовую систему, работающую в консольном режиме.

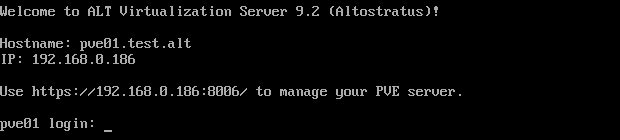

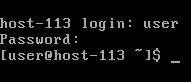

При загрузке в консольном режиме работа загрузчика Альт Сервер Виртуализации завершается запросом на ввод логина и пароля учетной записи.

После загрузки будут показаны имя и IP адрес компьютера, а также адрес доступа к панели управления (если были установлены OpenNebula или PVE):

Для дальнейшего входа в систему необходимо ввести логин и пароль учетной записи пользователя.

В случае успешного прохождения процедуры аутентификации и идентификации будет выполнен вход в систему. ОС Альт Сервер Виртуализации перейдет к штатному режиму работы и предоставит дальнейший доступ к консоли.

В процессе работы ОС Альт Сервер Виртуализации активно несколько виртуальных консолей. Каждая виртуальная консоль доступна по одновременному нажатию клавиш Ctrl, Alt и функциональной клавиши с номером этой консоли от F1 до F6.

На первых шести виртуальных консолях (от Ctrl+Alt+F1 до Ctrl+Alt+F6) пользователь может зарегистрироваться и работать в текстовом режиме. Двенадцатая виртуальная консоль (Ctrl+Alt+F12) выполняет функцию системной консоли – на нее выводятся сообщения о происходящих в системе событиях.

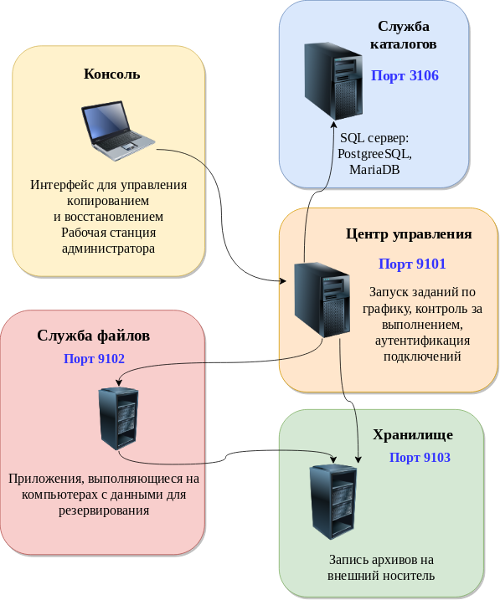

OpenNebula — это платформа облачных вычислений для управления разнородными инфраструктурами распределенных центров обработки данных. Платформа OpenNebula управляет виртуальной инфраструктурой центра обработки данных для создания частных, общедоступных и гибридных реализаций инфраструктуры как службы.

Облачная архитектура определяется 3-мя элементами: хранилищем данных, сетью и системой виртуализации.

OpenNebula состоит из следующих компонентов:

Сервер управления (Front-end) — на нём выполняются сервисы OpenNebula;

Серверы с виртуальными машинами;

Хранилище данных — содержит образы виртуальных машин;

Физическая сеть — обеспечивает связь между хранилищем данных, серверами с виртуальными машинами, поддерживает VLAN-ы для виртуальных машин, а также управление сервисами OpenNebula.

Компоненты

OpenNebula будут установлены в систему, если при установке дистрибутива выбрать профиль

Вычислительный узел Opennebula KVM,

Вычислительный узел Opennebula LXD или

Сервер управления Opennebula (см. главу

Установка системы).

Глава 24. Планирование ресурсов

Таблица 24.1. Минимальные требования к серверу управления

|

Ресурс

|

Минимальное значение

|

|

Оперативная память

|

2 ГБ

|

|

CPU

|

1 CPU (2 ядра)

|

|

Диск

|

100 ГБ

|

|

Сеть

|

2 интерфейса

|

Максимальное количество серверов (узлов виртуализации), управляемых одним сервером управления, зависит от инфраструктуры, особенно от производительности хранилища. Обычно рекомендуется не управлять более чем 500 серверами из одной точки, хотя существуют примеры с более чем 1000 серверами.

24.2. Серверы виртуализации

Серверы виртуализации — это физические машины, на которых выполняются виртуальные машины. Подсистема виртуализации — это компонент, который отвечает за связь с гипервизором, установленным на узлах, и выполнение действий, необходимых для каждого этапа жизненного цикла виртуальной машины (ВМ).

Серверы (узлы) виртуализации имеют следующие характеристики и их рекомендованные значения:

CPU — в обычных условиях каждое ядро, предоставляемое ВМ, должно быть реальным ядром физического процессора. Например, для обслуживания 40 ВМ с двумя процессорами в каждой, облако должно иметь 80 физических ядер. При этом они могут быть распределены по разным серверам: 10 серверов с восемью ядрами или 5 серверов с 16 ядрами на каждом. В случае перераспределения недостаточных ресурсов используются атрибуты CPU и VCPU: CPU определяет физические ядра, выделенные для ВМ, а VCPU — виртуальные ядра для гостевой ОС.

Память — по умолчанию, OpenNebula не предоставляет памяти для гостевых систем больше, чем есть на самом деле. Желательно рассчитывать объём памяти с запасом в 10% на гипервизор. Например, для 45 ВМ с 2 ГБ памяти на каждой, необходимо 90 ГБ физической памяти. Важным параметром является количество физических серверов: каждый сервер должен иметь 10% запас для работы гипервизора, так, 10 серверов с 10 ГБ памяти на каждом могут предоставить по 9 ГБ для виртуальных машин и смогут обслужить 45 машин из этого примера (10% от 10 ГБ = 1 ГБ на гипервизор).

OpenNebula работает с двумя видами данных в хранилище: образцами виртуальных машин и образами (дисками) самих ВМ.

В хранилище образов (Images Datastore) OpenNebula хранит все зарегистрированные образы, которые можно использовать для создания ВМ.

Системное хранилище (System Datastore) — используется для хранения дисков виртуальных машин, работающих в текущий момент. Образы дисков перемещаются, или клонируются, в хранилище образов или из него при развертывании и отключении ВМ, при подсоединении или фиксировании мгновенного состояния дисков.

Одним из основных способов управления хранилищем данных является ограничение хранилища, доступного для пользователей, путем определения квот по максимальному количеству ВМ, а также максимального объема энергозависимой памяти, который может запросить пользователь, и обеспечения достаточного пространства хранения системных данных и образов, отвечающего предельным установленным квотам. OpenNebula позволяет администратору добавлять хранилища системных данных и образов, если это необходимо.

Планирование хранилища — является критически важным аспектом, поскольку от него зависит производительность облака. Размер хранилищ сильно зависит от базовой технологии. Например, при использовании Ceph для среднего по размеру облака, необходимо взять как минимум 3 сервера в следующей конфигурации: 5 дисков по 1 ТБ, 16 ГБ памяти, 2 CPU по 4 ядра в каждом и как минимум 2 сетевые карты.

24.4. Сетевая инфраструктура

Сетевая инфраструктура должна быть спланирована так, чтобы обеспечить высокую надёжность и пропускную способность. Рекомендуется использовать 2 сетевых интерфейса на сервере управления и по 4 на каждом сервере виртуализации (публичный, внутренний, для управления и для связи с хранилищем).

Глава 25. Запуск сервера управления OpenNebula

25.1. Установка пароля для пользователя oneadmin

При установке OpenNebula система автоматически создает нового пользователя oneadmin, все дальнейшие действия по управлению OpenNebula необходимо выполнять от этого пользователя.

Файл /var/lib/one/.one/one_auth будет создан со случайно сгенерированным паролем. Необходимо поменять этот пароль перед запуском OpenNebula.

Для установки пароля для пользователя oneadmin необходимо выполнить команду:

# passwd oneadmin

Теперь зайдя под пользователем oneadmin следует заменить содержимое

/var/lib/one/.one/one_auth. Он должен содержать следующее: oneadmin:<пароль>. Например:

$ echo "oneadmin:mypassword" > ~/.one/one_auth

25.2. Настройка MySQL (MariaDB) для хранения конфигурации

По умолчанию OpenNebula работает с SQLite. Если планируется использовать OpenNebula с MySQL, следует настроить данную конфигурацию перед первым запуском OpenNebula, чтобы избежать проблем с учетными данными oneadmin и serveradmin.

Задать пароль root для mysql и настройки безопасности:

# mysql_secure_installation

Создать нового пользователя, предоставить ему привилегии в базе данных opennebula (эта база данных будет создана при первом запуске OpenNebula) и настроить уровень изоляции:

$ mysql -u root -p

Enter password:

MariaDB > GRANT ALL PRIVILEGES ON opennebula.* TO 'oneadmin' IDENTIFIED BY '<thepassword>';

Query OK, 0 rows affected (0.003 sec)

MariaDB > SET GLOBAL TRANSACTION ISOLATION LEVEL READ COMMITTED;

Query OK, 0 rows affected (0.001 sec)

MariaDB > quit

Перед запуском сервера OpenNebula в первый раз необходимо настроить параметры доступа к базе данных в конфигурационном файле

/etc/one/oned.conf:

#DB = [ BACKEND = "sqlite" ]

# Sample configuration for MySQL

DB = [ BACKEND = "mysql",

SERVER = "localhost",

PORT = 0,

USER = "oneadmin",

PASSWD = "<thepassword>",

DB_NAME = "opennebula",

CONNECTIONS = 50 ]

Для запуска OpenNebula необходимо выполнить следующие команды:

# systemctl start opennebula

# systemctl start opennebula-sunstone

25.4. Проверка установки

После запуска OpenNebula в первый раз, следует проверить, что команды могут подключаться к демону OpenNebula. Это можно сделать в командной строке или в графическом интерфейсе пользователя: Sunstone.

В командной строке

$ oneuser show

USER 0 INFORMATION

ID : 0

NAME : oneadmin

GROUP : oneadmin

PASSWORD : 3bc15c8aae3e4124dd409035f32ea2fd6835efc9

AUTH_DRIVER : core

ENABLED : Yes

USER TEMPLATE

TOKEN_PASSWORD="ec21d27e2fe4f9ed08a396cbd47b08b8e0a4ca3c"

VMS USAGE & QUOTAS

VMS USAGE & QUOTAS - RUNNING

DATASTORE USAGE & QUOTAS

NETWORK USAGE & QUOTAS

IMAGE USAGE & QUOTAS

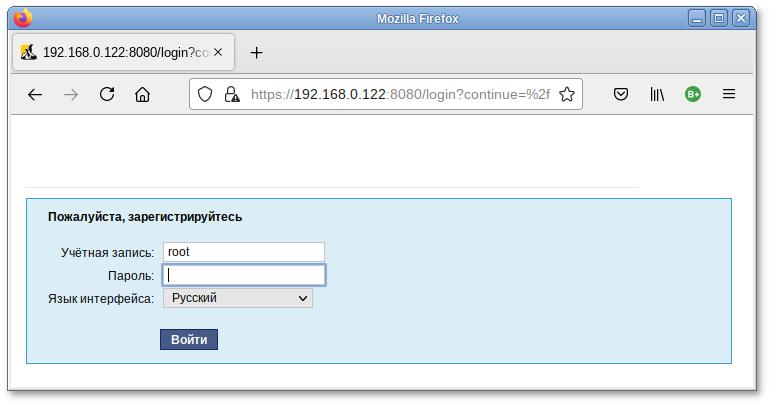

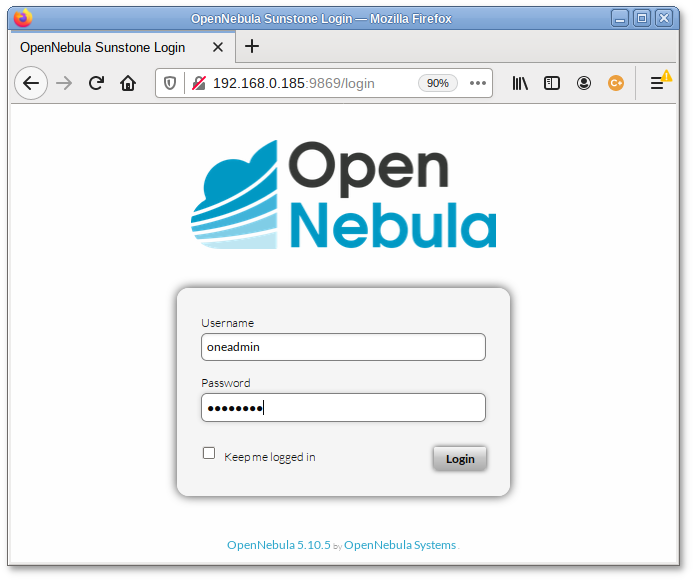

Также можно попробовать войти в веб-интерфейс Sunstone. Для этого необходимо перейти по адресу http://<внешний адрес>:9869. Если все в порядке, будет предложена страница входа.

Необходимо ввести в соответствующие поля имя пользователя (oneadmin) и пароль пользователя (тот, который находится в файле /var/lib/one/.one/one_auth):

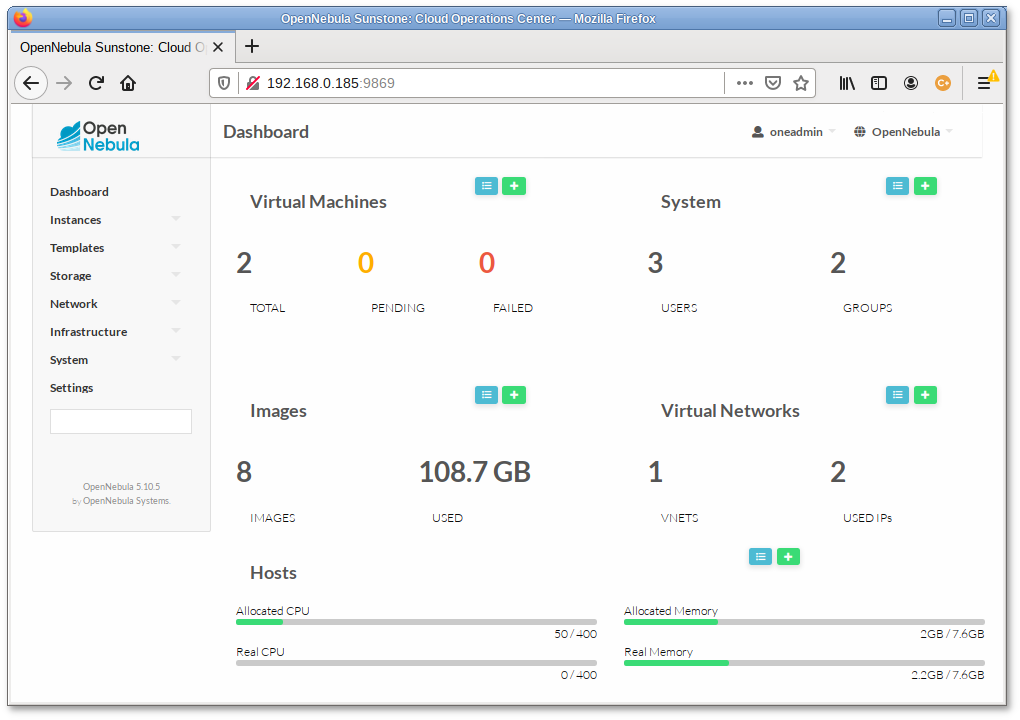

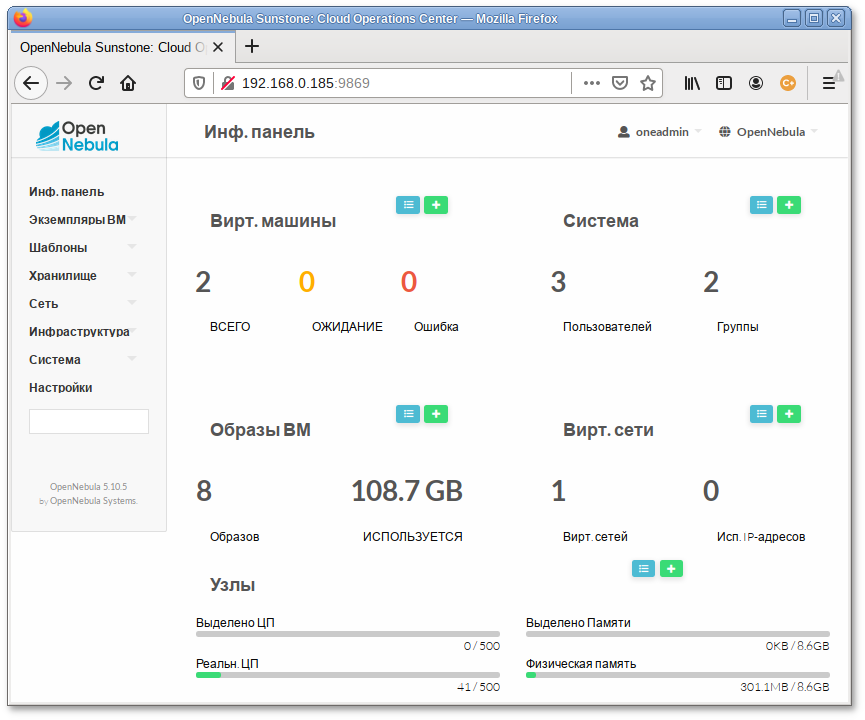

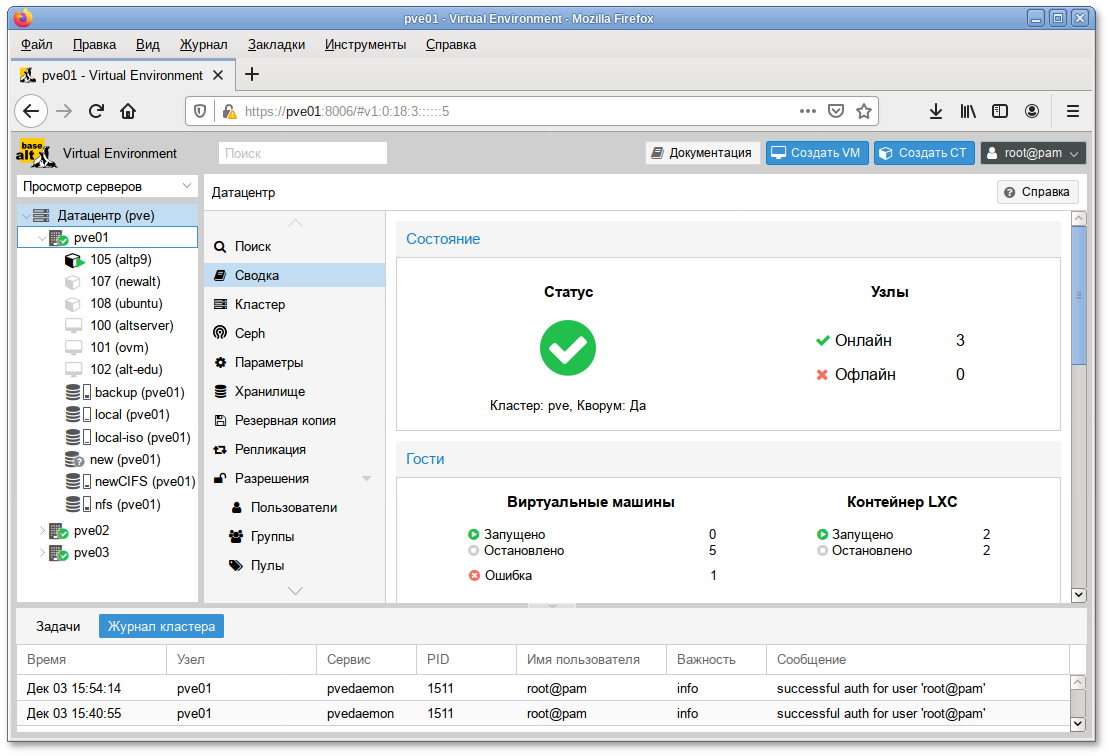

После входа в систему будет доступна панель инструментов:

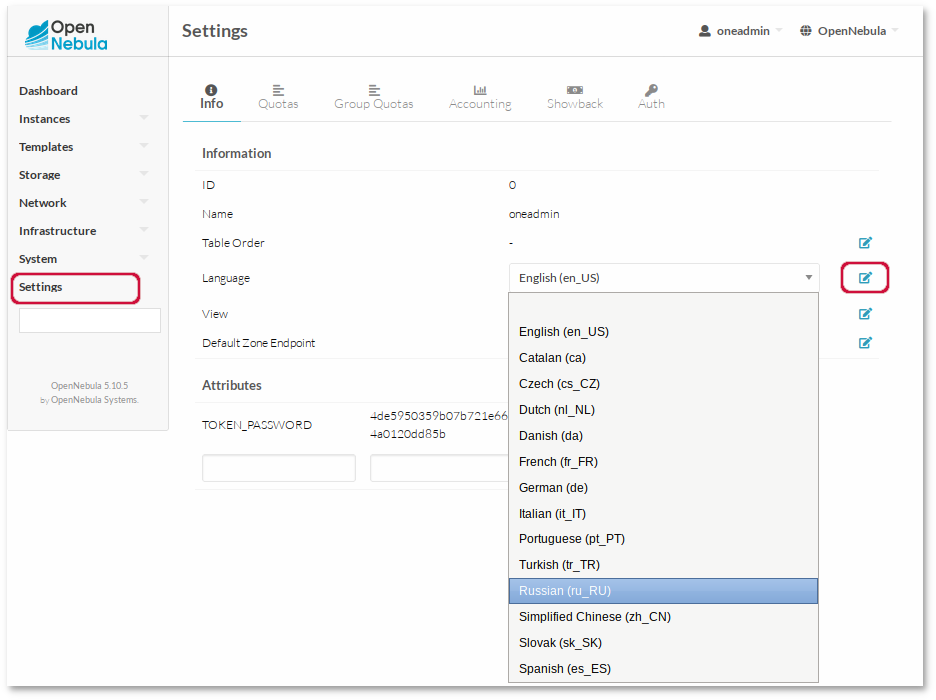

Для смены языка интерфейса необходимо в левом меню выбрать пункт , и на открывшейся странице в выпадающем списке Language выбрать пункт Russian (ru_RU):

Язык интерфейса будет изменён на русский:

25.5. Ключи для доступа по SSH

Сервер управления OpenNebula подключается к хостам гипервизора по SSH. Необходимо распространить открытый ключ пользователя oneadmin со всех машин в файл /var/lib/one/.ssh/authorized_keys на всех машинах.

При установке сервера управления OpenNebula ключ SSH был сгенерирован добавлен в авторизованные ключи. Необходимо синхронизировать id_rsa, id_rsa.pub и authorized_keys сервера управления и узлов. Кроме того, следует создать файл known_hosts и также синхронизировать его с узлами. Чтобы создать файл known_hosts, необходимо выполнить следующую команду (от пользователя oneadmin на сервере управления) со всеми именами узлов и именем сервера управления в качестве параметров:

$ ssh-keyscan <сервер управления> <узел1> <узел2> <узел3> ... >> /var/lib/one/.ssh/known_hosts

Команду

ssh-keyscan необходимо выполнить, как для имён, так и для IP-адресов узлов/сервера управления:

$ ssh-keyscan <IP-узел1> <hostname-узел1> ... >> /var/lib/one/.ssh/known_hosts

Например,

$ ssh-keyscan 192.168.0.185 server 192.168.0.190 host01 >> /var/lib/one/.ssh/known_hosts

Далее необходимо нужно скопировать каталог

/var/lib/one/.ssh на все узлы. Самый простой способ — установить временный пароль для oneadmin на всех хостах и скопировать каталог с сервера управления:

$ scp -rp /var/lib/one/.ssh <узел1>:/var/lib/one/

$ scp -rp /var/lib/one/.ssh <узел2>:/var/lib/one/

$ scp -rp /var/lib/one/.ssh <узел3>:/var/lib/one/

...

После этого необходимо убедиться, что при подключении от сервера управления под пользователем oneadmin к узлам и самому серверу управления, а также от узлов к серверу управления пароль не запрашивается.

Если требуется дополнительный уровень безопасности, можно хранить закрытый ключ только на сервере управления, а не копировать его на весь гипервизор. Таким образом, пользователь oneadmin в гипервизоре не сможет получить доступ к другим гипервизорам. Это достигается путем изменения

/var/lib/one/.ssh/config на сервере управления и добавления параметра ForwardAgent к хостам гипервизора для пересылки ключа:

$ cat /var/lib/one/.ssh/config

Host host1

User oneadmin

ForwardAgent yes

Host host2

User oneadmin

ForwardAgent yes

Сервисам, работающим на сервере управления, необходим доступ к узлам с целью управления гипервизорами и их мониторинга, а также для передачи файлов образов. Для этой цели рекомендуется использовать выделенную сеть.

Настройка сети необходима только на серверах с виртуальными машинами. Точное имя ресурсов (br0, br1 и т.д.) значения не имеет, но важно, чтобы мосты и сетевые карты имели одно и то же имя на всех узлах.

Глава 26. Добавление узлов в OpenNebula

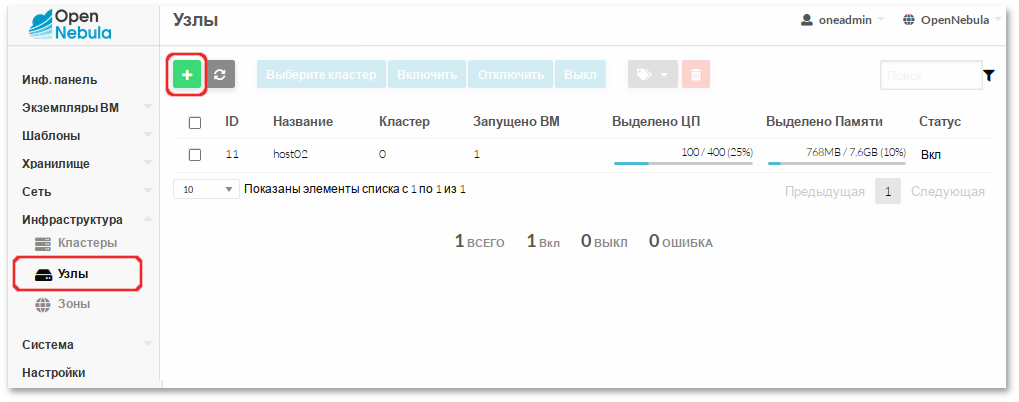

Чтобы использовать существующие физические узлы, их необходимо зарегистрировать в OpenNebula. Этот шаг может быть выполнен в командной строке или в графическом пользовательском интерфейсе Sunstone.

Перед добавлением узла следует убедиться, что к узлу можно подключиться по SSH без запроса пароля.

26.1. Добавление узла в OpenNebula-Sunstone

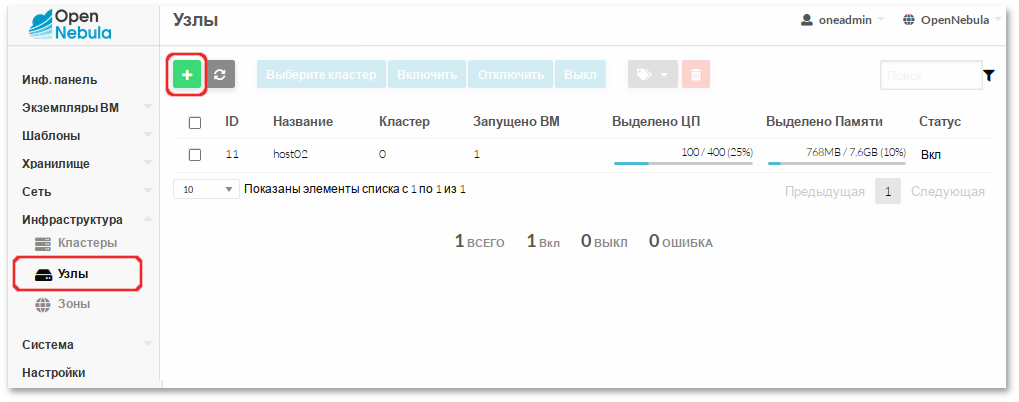

Для добавления узла, необходимо в левом меню выбрать → и на загруженной странице нажать кнопку +:

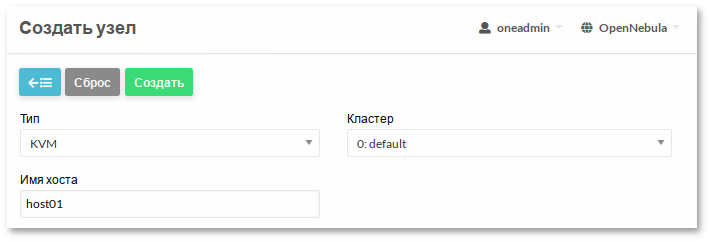

Далее необходимо указать тип виртуализации, заполнить поле Имя хоста (можно ввести Ip-адрес узла, или его имя) и нажать кнопку Создать:

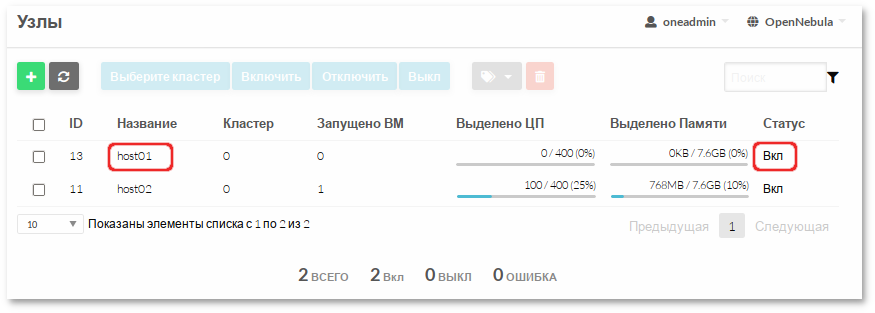

Затем следует вернуться к списку узлов и убедиться, что узел перешел в состояние ВКЛ (это должно занять от 20 секунд до 1 минуты, можно нажать кнопку Обновить для обновления состояния):

Далее на этой вкладке можно включать, отключать, удалять и просматривать информацию об узлах.

26.2. Работа с узлами в командной строке

onehost — это инструмент управления узлами в OpenNebula. Описание всех доступных опций утилиты

onehost можно получить, выполнив команду:

$ man onehost

Для добавления узла в облако, необходимо выполнить следующую команду от oneadmin на сервере управления:

$ onehost create host01 -im kvm -vm kvm

ID: 1

Список узлов можно просмотреть, выполнив команду:

$ onehost list

ID NAME CLUSTER TVM ALLOCATED_CPU ALLOCATED_MEM STAT

1 host01 default 0 0 / 400 (0%) 0K / 7.6G (0%) on

Если возникли проблемы с добавлением узла, то скорее всего неправильно настроен ssh. Ошибки можно просмотреть в /var/log/one/oned.log.

Для указания узла можно использовать его ID или имя. Например, удаление узла с указанием ID:

$ onehost delete host01

или имени:

$ onehost delete 1

Изменение статуса узла:

$ onehost disable host01 // деактивировать узел

$ onehost enable host01 // активировать узел

$ onehost offline host01 // полностью выключить узел

Просмотр информации об узле:

$ onehost show 1

Информация об узле содержит:

общую информацию, включая имя и драйверы, используемые для взаимодействия с ним;

информацию об объёме (Host Shares) процессора и памяти;

информацию о локальном хранилище данных (Local System Datastore), если хост настроен на использование локального хранилища данных;

информацию мониторинга;

активных ВМ на узле.

Глава 27. Управление пользователями

OpenNebula включает полную систему управления пользователями и группами.

Ресурсы, к которым пользователь может получить доступ в OpenNebula, контролируются системой разрешений. По умолчанию только владелец ресурса может использовать и управлять им. Пользователи могут делиться ресурсами, предоставляя разрешения на использование или управление другим пользователям в своей группе или любому другому пользователю в системе.

oneuser — инструмент командной строки для управления пользователями в OpenNebula.

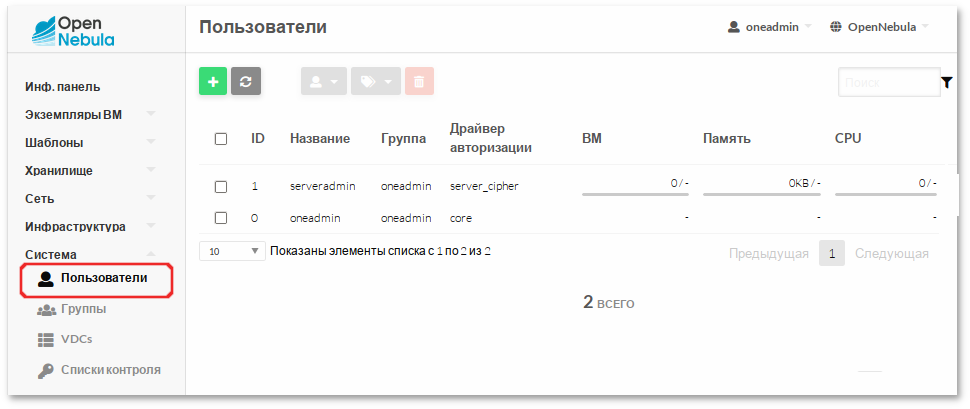

При установке OpenNebula создаются две административные учетные записи (oneadmin и serveradmin), и две группы (oneadmin и users):

$ oneuser list

ID NAME GROUP AUTH VMS MEMORY CPU

1 serveradmin oneadmin server_c 0 / - 0M / 0.0 / -

0 oneadmin oneadmin core - - -

$ onegroup list

ID NAME USERS VMS MEMORY CPU

1 users 0 0 / - 0M / - 0.0 / -

0 oneadmin 2 - - -

Создание нового пользователя:

$ oneuser create <user_name> <password>

По умолчанию новый пользователь будет входить в группу users. Изменить группу пользователя:

$ oneuser chgrp <user_name> oneadmin

Что бы удалить пользователя из группы, необходимо переместить его обратно в группу users.

Временно отключить пользователя:

$ oneuser disable <user_name>

Включить отключённого пользователя:

$ oneuser enable <user_name>

Удалить пользователя:

$ oneuser delete <user_name>

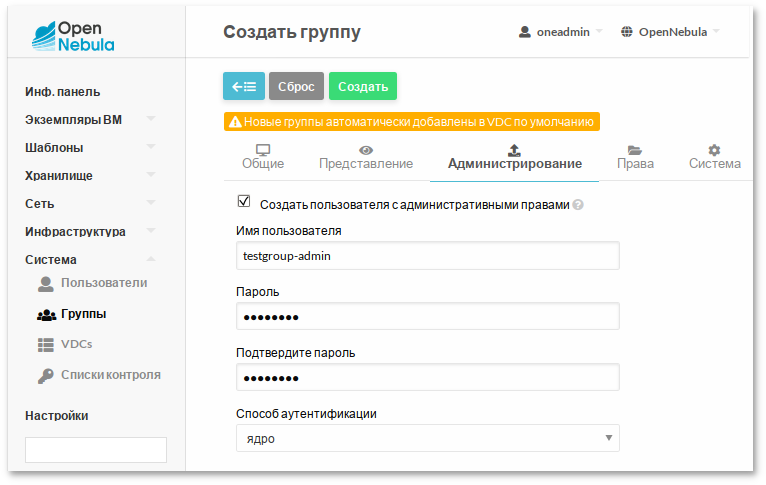

onegroup — инструмент командной строки для управления группами в OpenNebula.

Создание новой группы:

$ onegroup create group_name

ID: 100

Новая группа получила идентификатор 100, чтобы отличать специальные группы от созданных пользователем.

После создания группы может быть создан связанный пользователь-администратор. По умолчанию этот пользователь сможет создавать пользователей в новой группе.

Пример создания новой группы с указанием, какие ресурсы могут быть созданы пользователями группы (по умолчанию VM+IMAGE+TEMPLATE):

$ onegroup create --name testgroup \

--admin_user testgroup-admin --admin_password somestr \

--resources TEMPLATE+VM

При выполнении данной команды также будет создан администратор группы.

Сделать существующего пользователя администратором группы:

$ onegroup addadmin <groupid_list> <userid>

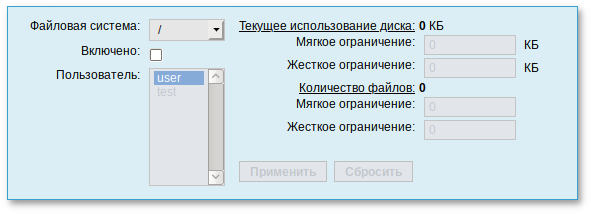

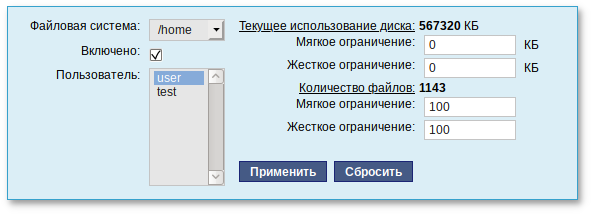

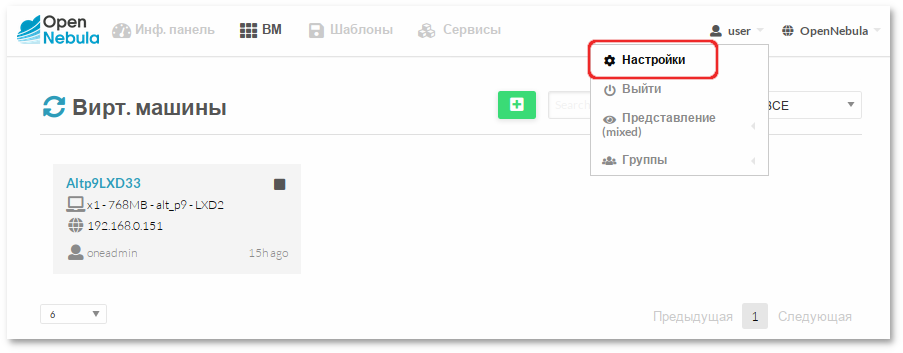

Все операции с пользователями можно производить в веб-интерфейсе:

Созданный пользователь может аутентифицироваться в веб-интерфейсе OpenNebula и изменить настройки (изменить язык интерфейса, пароль, добавить ssh-ключ для доступа на ВМ и т.д.):

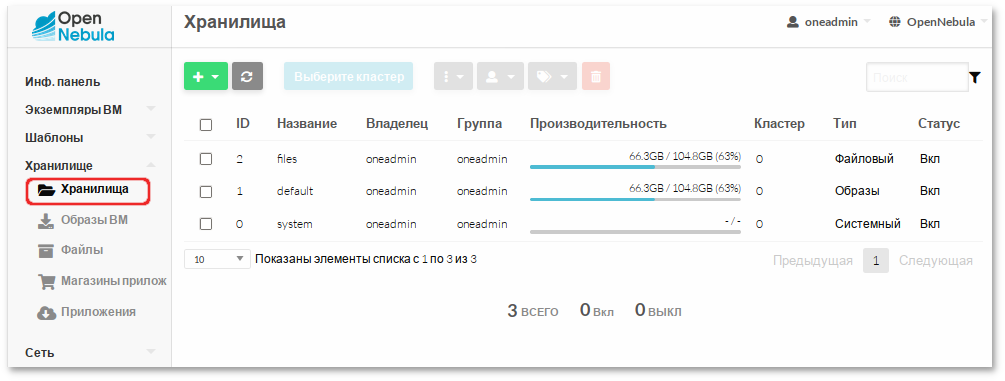

Глава 28. Работа с хранилищами в OpenNebula

По умолчанию в OpenNebula созданы хранилище образов (Images), системное (System) и файлов (Files).

onedatastore — инструмент управления хранилищами в OpenNebula. Описание всех доступных опций утилиты

onedatastore можно получить, выполнив команду:

$ man onedatastore

Вывести список хранилищ данных можно, выполнив команду:

$ onedatastore list

ID NAME SIZE AVA CLUSTERS IMAGES TYPE DS TM STAT

2 files 104.8G 32% 0 1 fil fs ssh on

1 default 104.8G 32% 0 8 img fs ssh on

0 system - - 0 0 sys - ssh on

Информация о хранилище:

$ onedatastore show default

Создавать, включать, отключать, удалять и просматривать информацию о хранилищах можно в веб-интерфейсе:

Глава 29. Работа с образами в OpenNebula

Система хранилищ позволяет пользователям настраивать/устанавливать образы, которые могут быть образами ОС или данных, для использования в ВМ. Данные образы могут использоваться несколькими ВМ одновременно, а также предоставляться другим пользователями.

Типы образов для дисков ВМ (хранятся в хранилище образов):

OS — образ загрузочного диска;

CDROM — файл образа, содержащий CDROM. Эти образы предназначены только для чтения. В каждом шаблоне ВМ, можно использовать только один образ данного типа;

DATABLOCK — файл образа, содержащий блок данных (например, базу данных) или может быть отформатирован как пустой диск.

Типы файлов (хранятся в файловом хранилище):

KERNEL — файл, который будет использоваться в качестве ядра ВМ (kernels);

RAMDISK — файл, для использования в качестве виртуального диска;

CONTEXT — файл для включения в контекстный CD-ROM.

Образы могут работать в двух режимах:

persistent (постоянные) — изменения, внесенные в такие образы, будут сохранены после завершения работы ВМ. В любой момент времени может быть только одна ВМ, использующая постоянный образ.

non-persistent (непостоянный) — изменения не сохранятся после завершения работы ВМ. Непостоянные образы могут использоваться несколькими ВМ одновременно, поскольку каждая из них будет работать со своей собственной копией.

Управлять образами можно, используя интерфейс командной строки — команда oneimage.

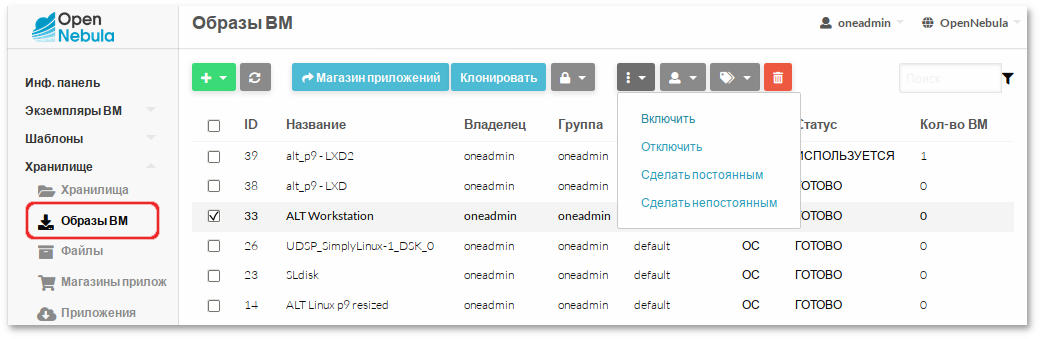

Также управлять образами можно в веб-интерфейсе, на вкладке .

29.1. Создание образа ОС в среде OpenNebula

Для создания образа ОС, необходимо подготовить ВМ и извлечь её диск.

29.1.1. Создание образов дисков

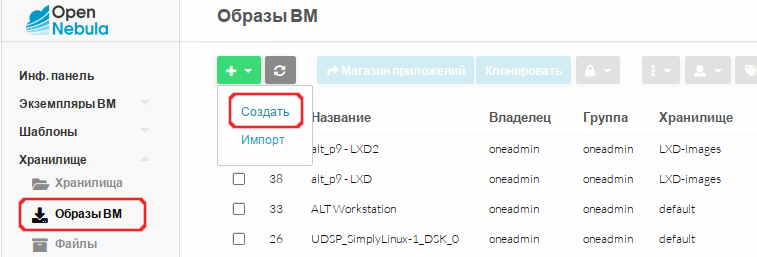

Создать образ типа CDROM с установочным ISO-образом.

Для этого перейти в раздел → , на загруженной странице нажать → :

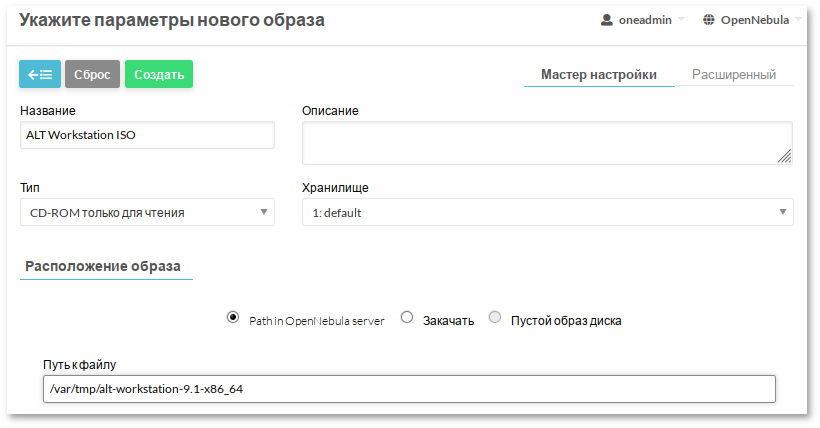

В открывшемся окне заполнить поле Название, выбрать тип образа CD-ROM только для чтения, выбрать хранилище, выбрать расположение образа Путь на сервере OpenNebula (Path in OpenNebula Server), указать путь к файлу (.iso) и нажать кнопку Создать:

ISO-образ должен быть загружен в папку, к которой имеет доступ пользователь oneadmin.

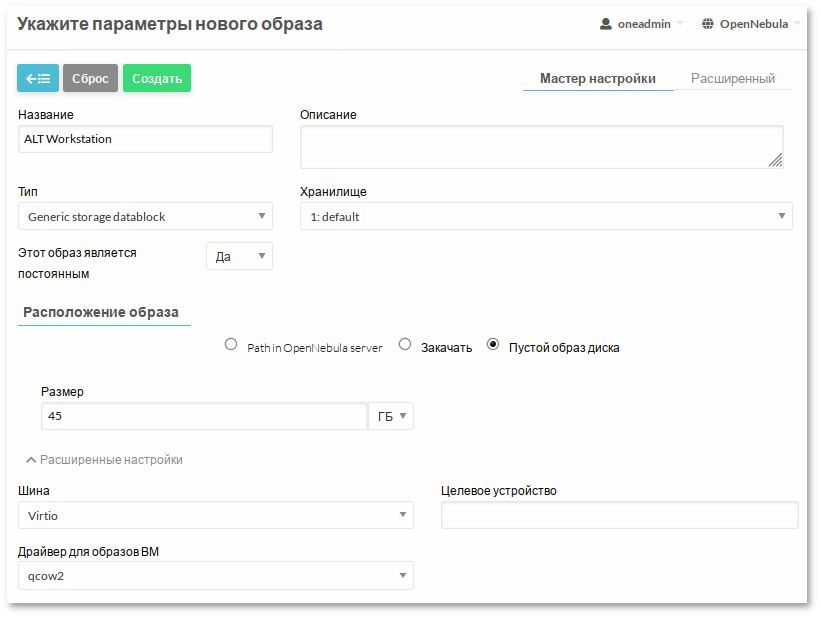

Создать пустой образ диска, на который будет установлена операционная система.

Для этого создать новый образ. Заполнить поле Название, в выпадающем списке Тип выбрать значение Generic storage datablock, в выпадающем списке Этот образ является постоянным выбрать значение Да, выбрать хранилище, в разделе Расположение образа выбрать пункт Пустой образ диска, установить размер выбранного блока, например 45GB, в разделе Расширенные настройки указать драйвер qcow2 и нажать кнопку Создать:

Эти же действия можно выполнить в командной строке.

Создать образ типа CDROM в хранилище данных по умолчанию (ID = 1):

$ oneimage create -d 1 --name "ALT Workstation ISO" --path /var/tmp/alt-workstation-9.1-x86_64.iso --type CDROM

ID: 31

Создать пустой образ диска (тип образа — DATABLOCK, размер 45 ГБ, драйвер qcow2):

$ oneimage create -d 1 --name "ALT Workstation" --type DATABLOCK --size 45G --persistent --driver qcow2

ID: 33

29.1.2. Создание шаблона ВМ

Создание шаблона в командной строке:

Создать файл template со следующим содержимым:

NAME = "ALT Workstation"

CONTEXT = [

NETWORK = "YES",

SSH_PUBLIC_KEY = "$USER[SSH_PUBLIC_KEY]" ]

CPU = "0.25"

DISK = [

IMAGE = "ALT Workstation ISO",

IMAGE_UNAME = "oneadmin" ]

DISK = [

DEV_PREFIX = "vd",

IMAGE = "ALT Workstation",

IMAGE_UNAME = "oneadmin" ]

GRAPHICS = [

LISTEN = "0.0.0.0",

TYPE = "SPICE" ]

HYPERVISOR = "kvm"

INPUTS_ORDER = ""

LOGO = "images/logos/alt.png"

MEMORY = "1024"

MEMORY_UNIT_COST = "MB"

NIC = [

NETWORK = "VirtNetwork",

NETWORK_UNAME = "oneadmin",

SECURITY_GROUPS = "0" ]

NIC_DEFAULT = [

MODEL = "virtio" ]

OS = [

BOOT = "disk1,disk0" ]

SCHED_REQUIREMENTS = "ID=\"0\""

Создать шаблон:

$ onetemplate create template

ID: 22

Ниже рассмотрен пример создания шаблона в веб-интерфейсе.

В левом меню выбрать → , на загруженной странице нажать кнопку + и выбрать пункт Создать.

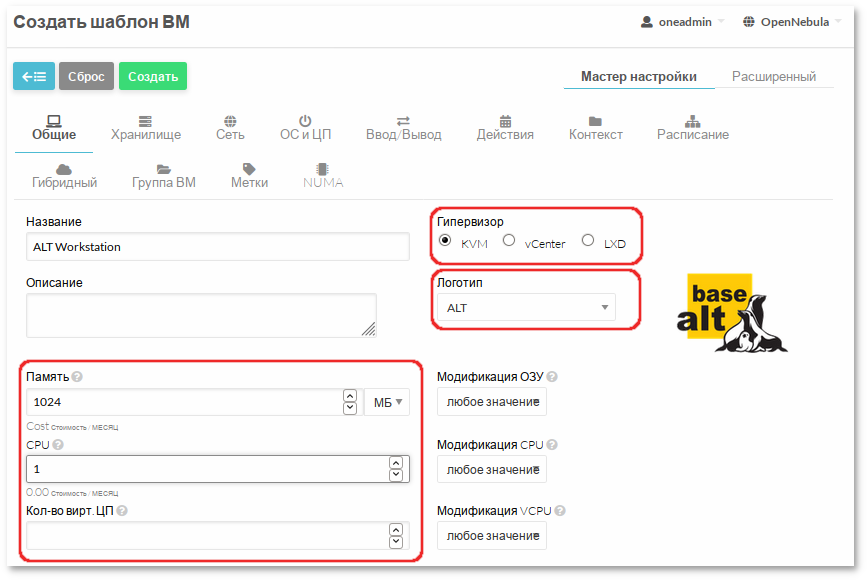

На вкладке необходимо указать параметры процессора, оперативной памяти, а также гипервизор:

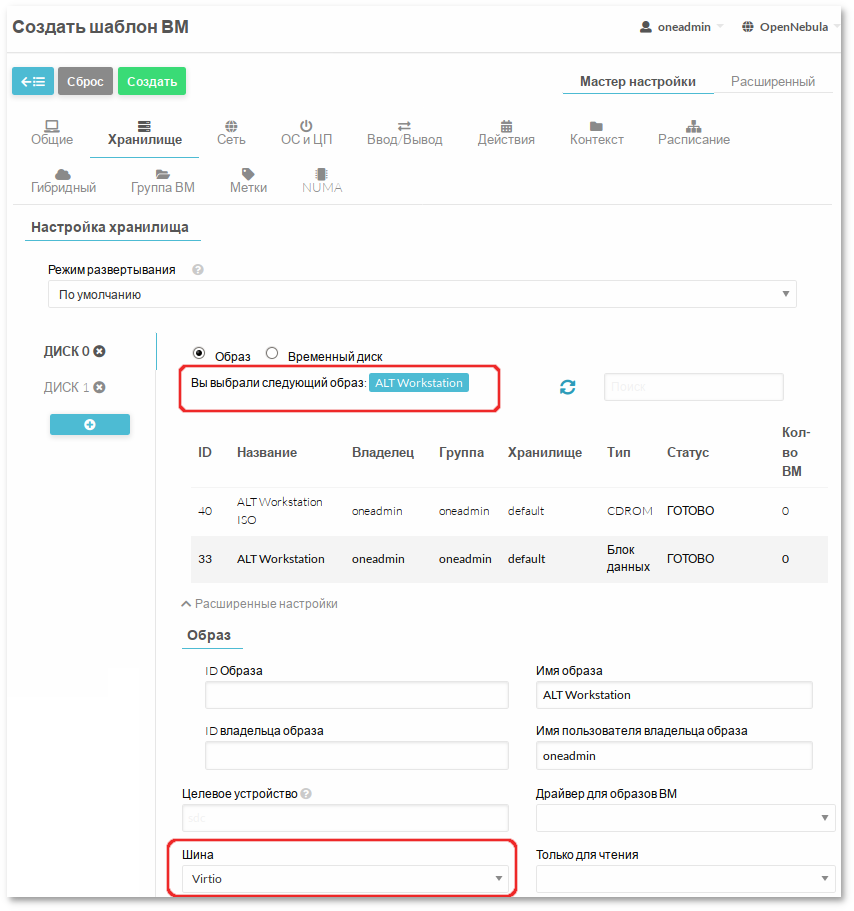

На вкладке необходимо указать ранее созданный пустой диск (DATABLOCK), в разделе Расширенные настройки в выпадающем списке Шина выбрать Virtio. Далее следует добавить новый диск и указать диск с установщиком ОС.

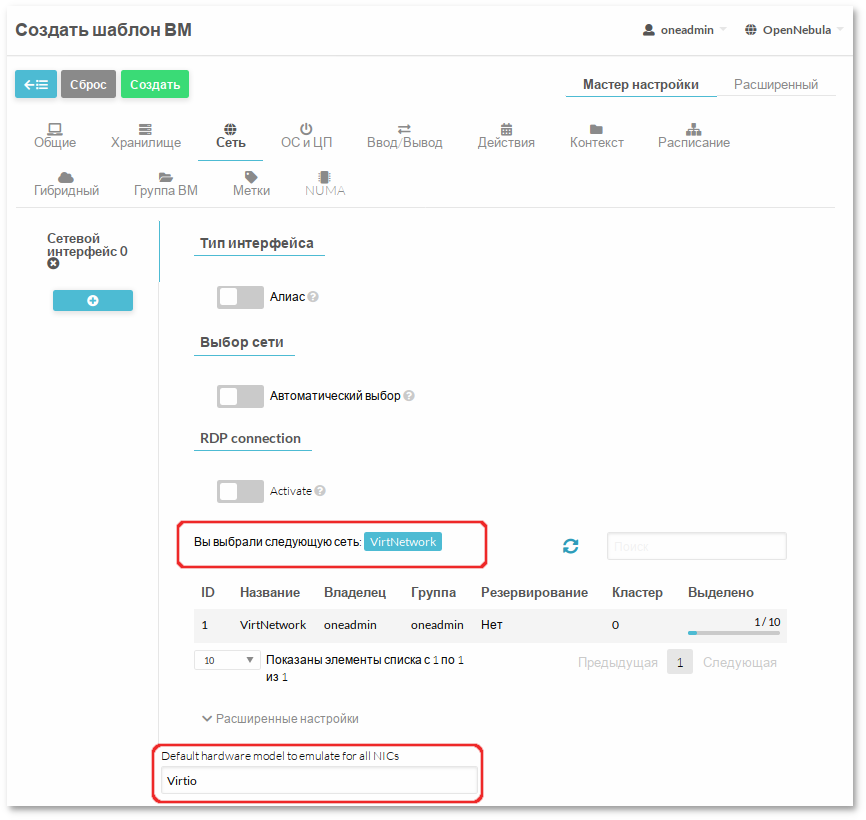

На вкладке в поле Default hardware model to emulate for all NICs указать Virtio и если необходимо выбрать сеть:

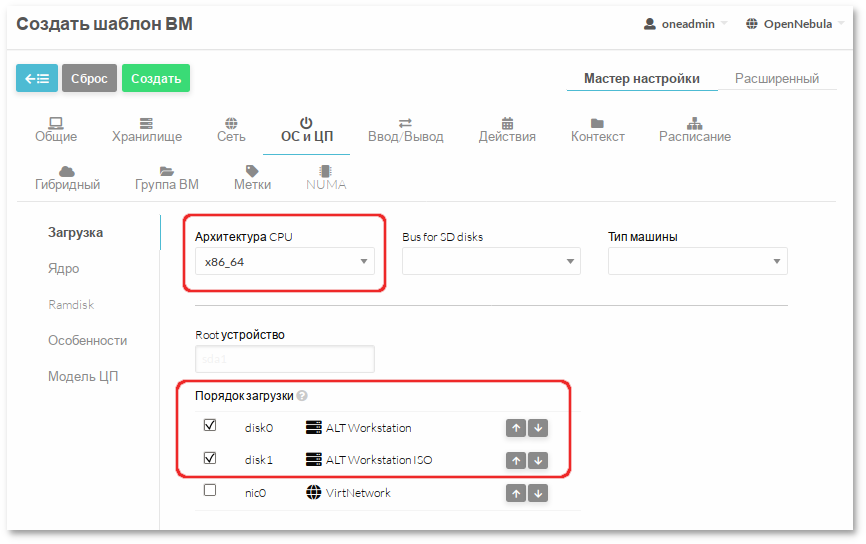

На вкладке необходимо указать архитектуру устанавливаемой системы и выбрать порядок загрузки. Можно установить в качестве первого загрузочного устройства — пустой диск (DATABLOCK), а в качестве второго — CDROM (при такой последовательности загрузочных устройств при пустом диске загрузка произойдёт с CDROM, а в дальнейшем, когда ОС будет уже установлена на диск, загрузка будет осуществляться с него).

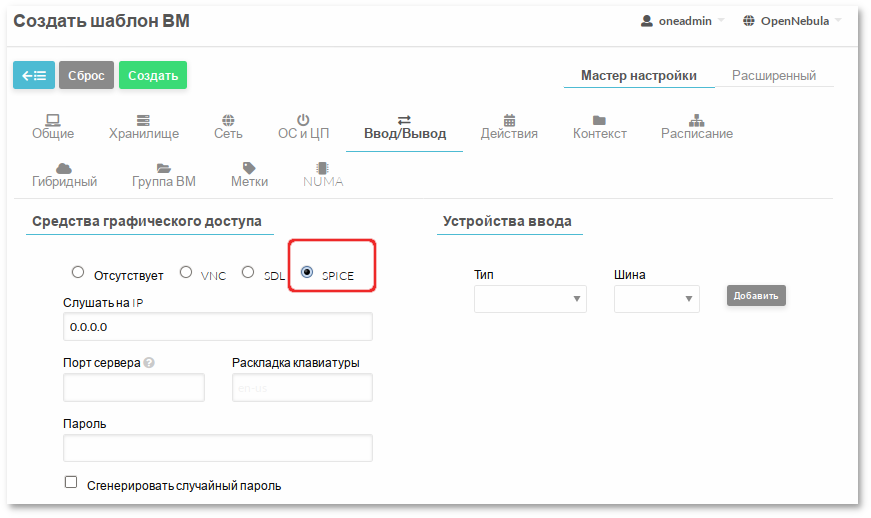

На вкладке следует включить SPICE:

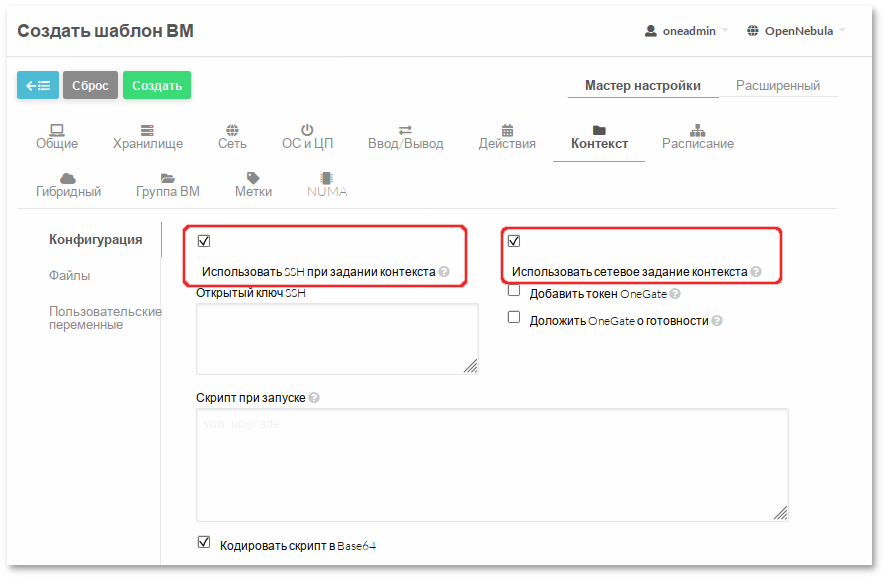

На вкладке необходимо включить параметр Использовать сетевое задание контекста, а также авторизацию по RSA-ключам (укажите свой открытый SSH (.pub) для доступа к ВМ по ключу, если оставить поле пустым, будет использована переменная $USER[SSH_PUBLIC_KEY]):

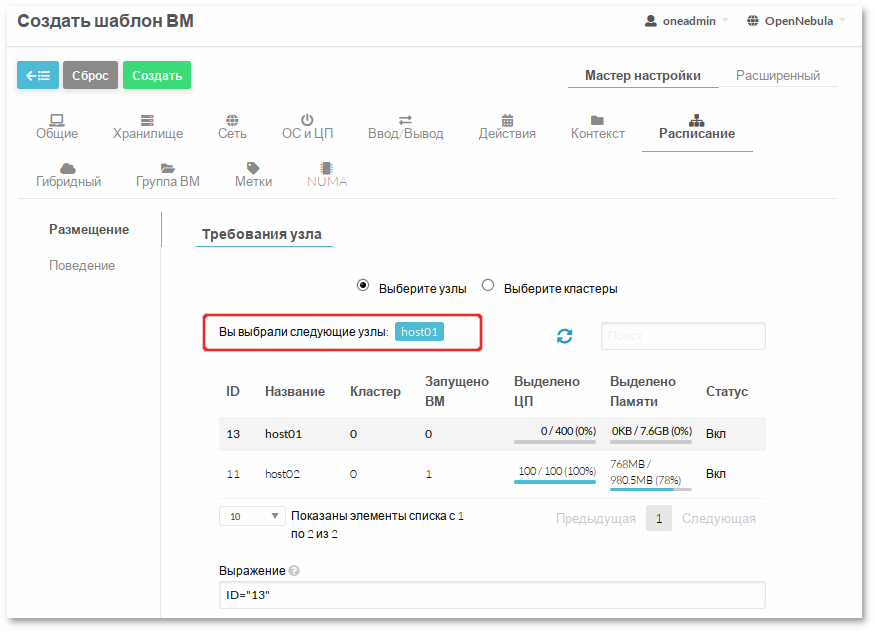

На вкладке если необходимо можно выбрать кластер/хост, на котором будет размещаться виртуальное окружение:

Для создания шаблона ВМ нажать кнопку Создать.

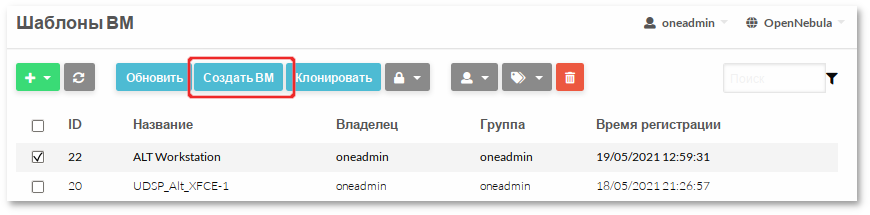

Для инициализации создания ВМ из шаблона в левом меню следует выбрать пункт → , выбрать шаблон и нажать кнопку Создать ВМ:

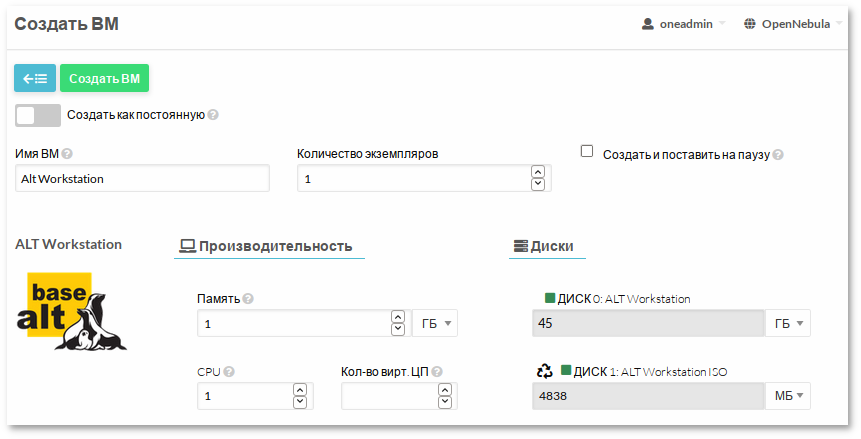

В открывшемся окне необходимо указать имя ВМ и нажать кнопку Создать ВМ:

Создание экземпляра ВМ из шаблона в командной строке:

$ onetemplate instantiate 22

VM ID: 94

29.1.4. Подключение к ВМ и установка ОС

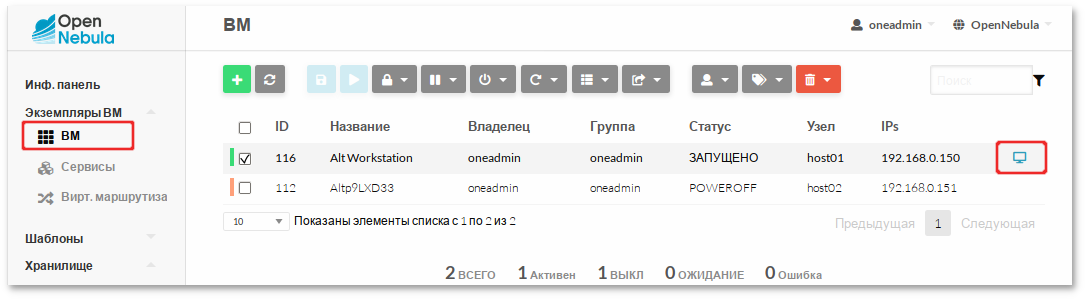

Процесс создания ВМ может занять несколько минут. Следует дождаться статуса — «ЗАПУЩЕНО» («RUNNING»).

Подключиться к ВМ можно как из веб-интерфейса Sunstone, раздел → выбрать ВМ и подключиться по SPICE:

Так и используя, любой клиент SPICE:

spice://192.168.0.190:5994

где 192.168.0.190 адрес хоста с ВМ, а 94 идентификатор ВМ (номер порта 5900 + 94).

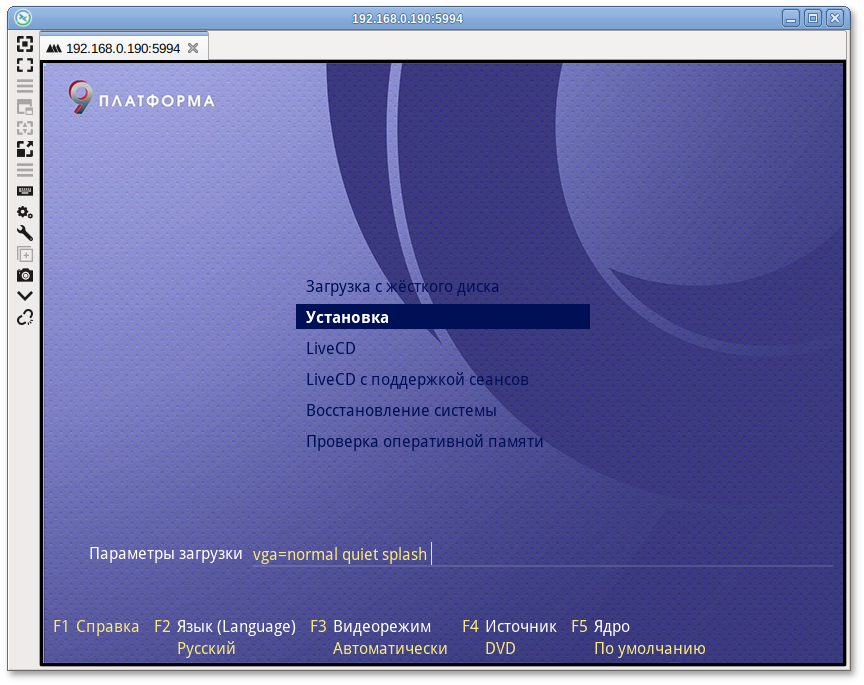

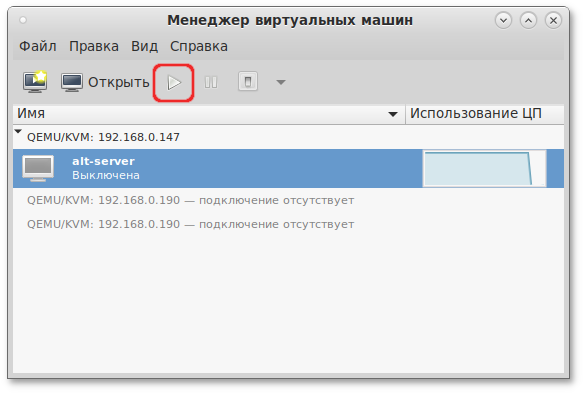

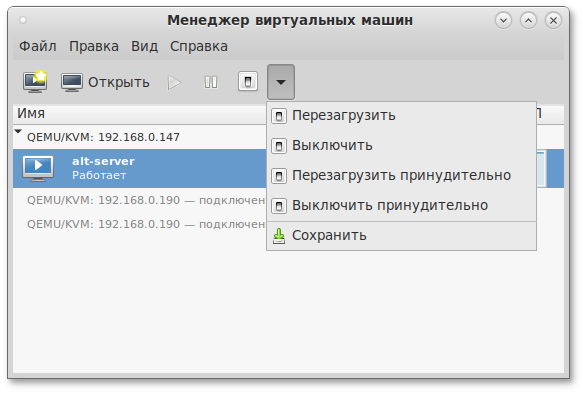

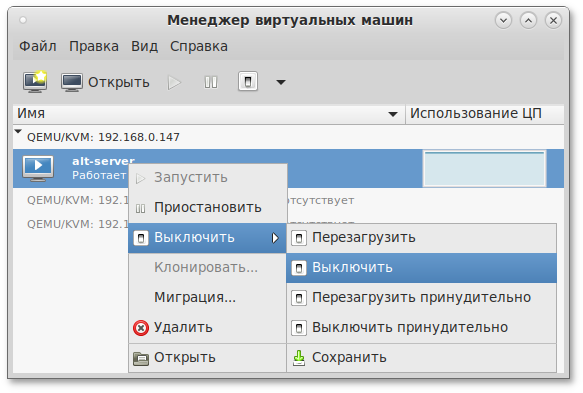

Далее необходимо провести установку системы:

29.1.5. Настройка контекстуализации

OpenNebula использует метод, называемый контекстуализацией, для отправки информации на ВМ во время загрузки. Контекстуализация позволяет установить или переопределить данные ВМ, имеющие неизвестные значения или значения по умолчанию (имя хоста, IP-адрес, .ssh/authorized_keys).

Пример настройки контекстуализации на установленной ОС Альт:

Подключиться к ВМ через SPICE или по ssh.

Установить пакет opennebula-context:

# apt-get update && apt-get install opennebula-context

Переключиться на systemd-networkd:

установить пакет systemd-timesyncd:

# apt-get install systemd-timesyncd

создать файл автонастройки всех сетевых интерфейсов по DHCP

/etc/systemd/network/lan.network со следующим содержимым:

[Match]

Name = *

[Network]

DHCP = ipv4

переключиться с etcnet/NetworkManager на systemd-networkd:

# systemctl disable network NetworkManager && systemctl enable systemd-networkd systemd-timesyncd

Перезагрузить систему.

После перезагрузки доступ в систему будет возможен по ssh-ключу, ВМ будет назначен IP-адрес, который OpenNebula через механизм IPAM (подсистема IP Address Management) выделит из пула адресов.

29.1.6. Создание образа типа OS

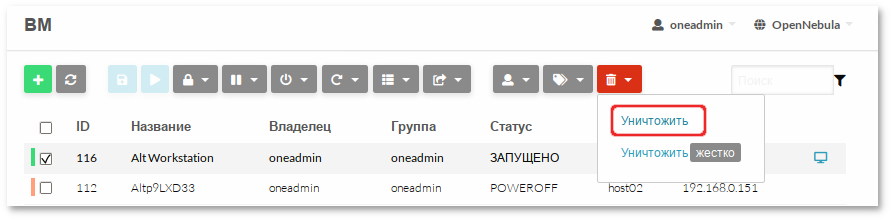

После завершения установки и настройки системы следует выключить и удалить ВМ. Диск находится в состоянии Persistent, поэтому все внесенные изменения будут постоянными.

Для удаления ВМ в левом меню следует выбрать пункт → , выбрать ВМ и нажать кнопку Уничтожить:

Удаление ВМ в командной строке:

$ onevm terminate 94

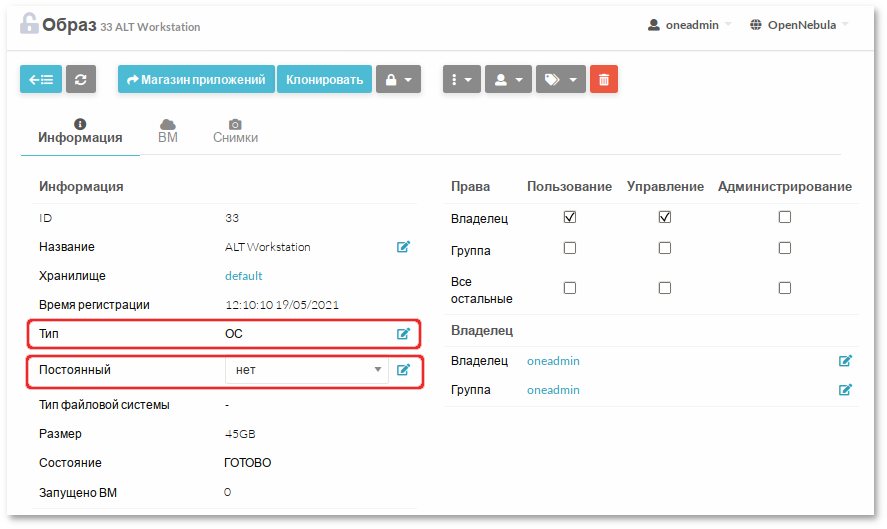

Затем перейти в → , выбрать образ с установленной ОС (ALT Workstation) и изменить тип блочного устройства с Datablock на ОС и состояние на Non Persistent:

Изменить тип блочного устройства на

ОС и состояние на

Non Persistent:

$ oneimage chtype 33 OS

$ oneimage nonpersistent 33

Образ готов. Далее можно использовать как имеющийся шаблон, так и создать новый на основе образа диска «ALT Workstation».

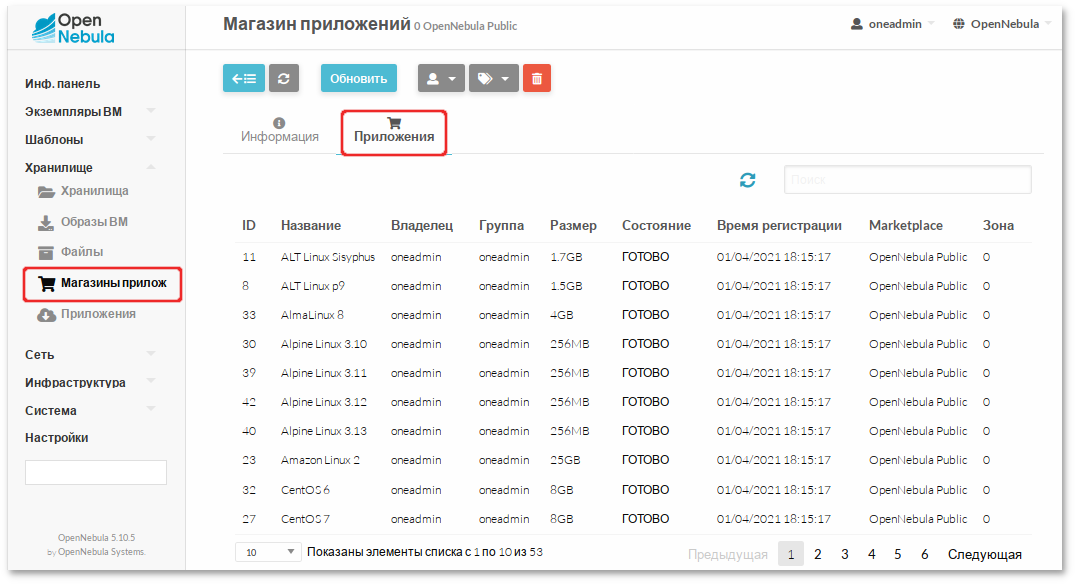

29.2. Использование магазина приложений OpenNebula

Для загрузки приложения из магазина необходимо перейти в → , выбрать → . Появится список доступных приложений:

Каждое приложение содержит образ и шаблон.

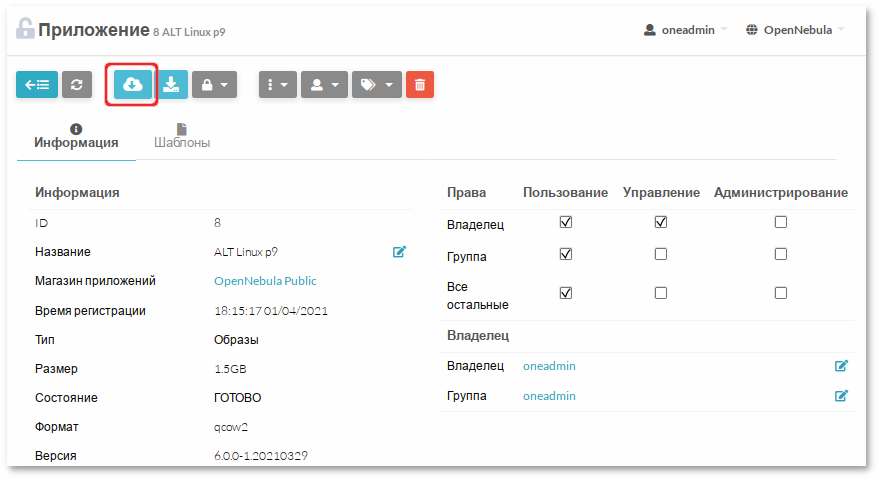

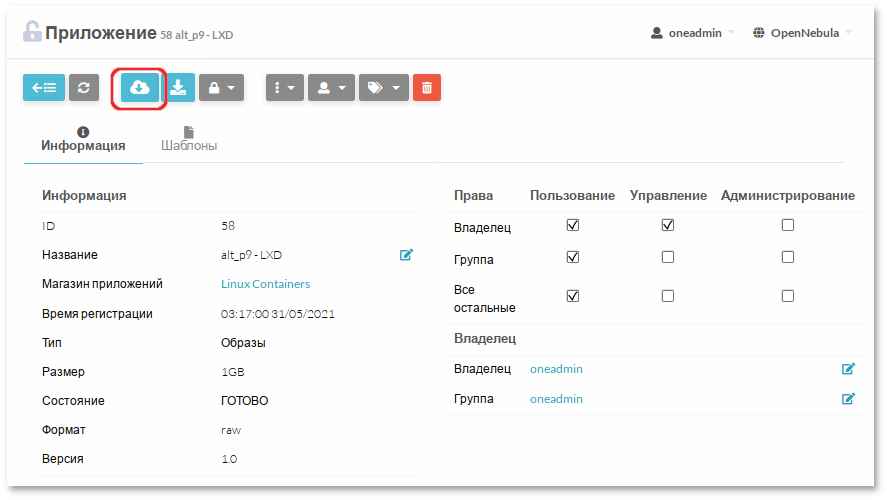

Чтобы импортировать приложение, необходимо его выбрать и нажать кнопку Import into Datastore:

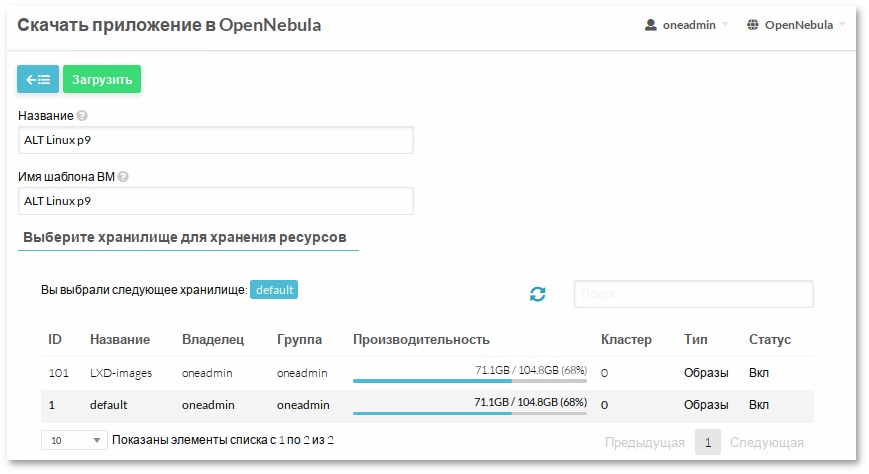

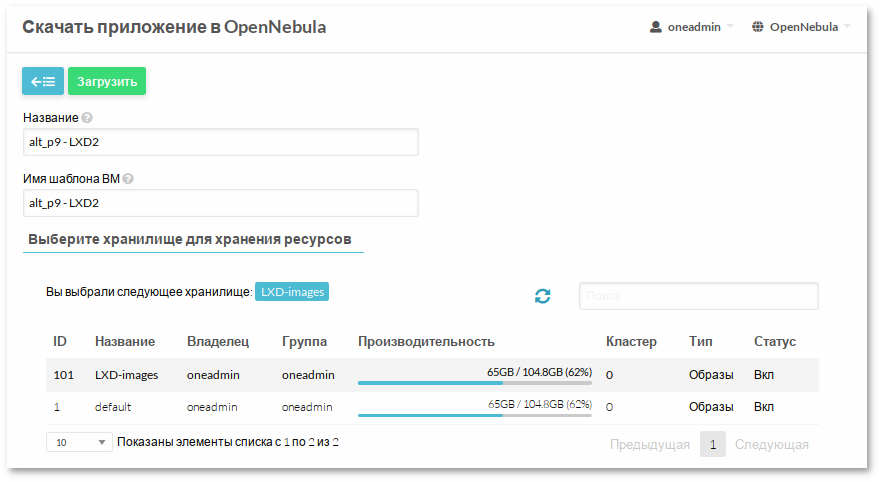

В открывшемся окне указать имя для образа и шаблона, выбрать хранилище и нажать кнопку Загрузить:

Настройка образов, загруженных из магазина приложений:

Изменить состояние образа на Постоянный (необходимо дождаться состояния ГОТОВО).

Настроить шаблон.

Создать на основе шаблона ВМ.

Подключиться к ВМ. Установить/настроить необходимые компоненты.

Удалить ВМ.

Изменить состояние образа на Не постоянный.

Далее можно создать новые шаблоны на основе этого образа или использовать существующий.

Глава 30. Установка и настройка LXD

LXD — это гипервизор LXC контейнеров.

Для работы с LXD в OpenNebula должна быть настроена пара хранилищ (хранилище образов и системное) НЕ типа qcow2 (например, shared или ssh).

Перед добавлением хоста типа LXD на сервер OpenNebula следует настроить узел LXD.

30.1. Настройка узла OpenNebula LXD

Для создания узла типа LXD, при установке дистрибутива нужно выбрать профиль

Вычислительный узел Opennebula LXD (см. главу

Установка системы):

В уже установленной системе можно установить пакет opennebula-node-lxd:

# apt-get install opennebula-node-lxd

И инициализировать lxd, выполнив команду из файла /usr/share/doc/opennebula-node-lxd-5.10.5/README.opennebula-lxd

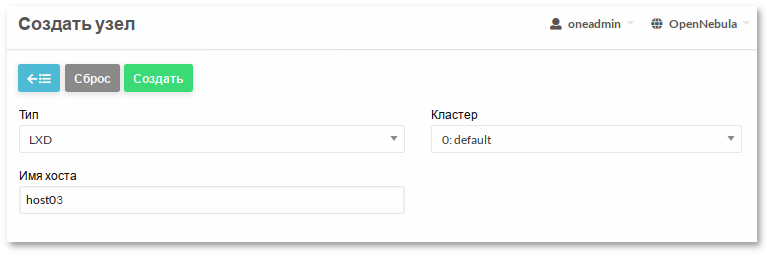

30.2. Добавление узла типа LXD в OpenNebula

Для добавления узла типа LXD на сервере OpenNebula, необходимо в левом меню выбрать → и на загруженной странице нажать кнопку +:

Далее необходимо указать тип виртуализации — LXD, заполнить поле Имя хоста (можно ввести Ip-адрес узла, или его имя) и нажать кнопку Создать:

Затем следует вернуться к списку узлов и убедиться, что узел перешел в состояние ВКЛ (это должно занять от 20 секунд до 1 минуты).

Для добавления узла типа LXD в командной строке:

$ onehost create host03 -im lxd -vm lxd

ID: 3

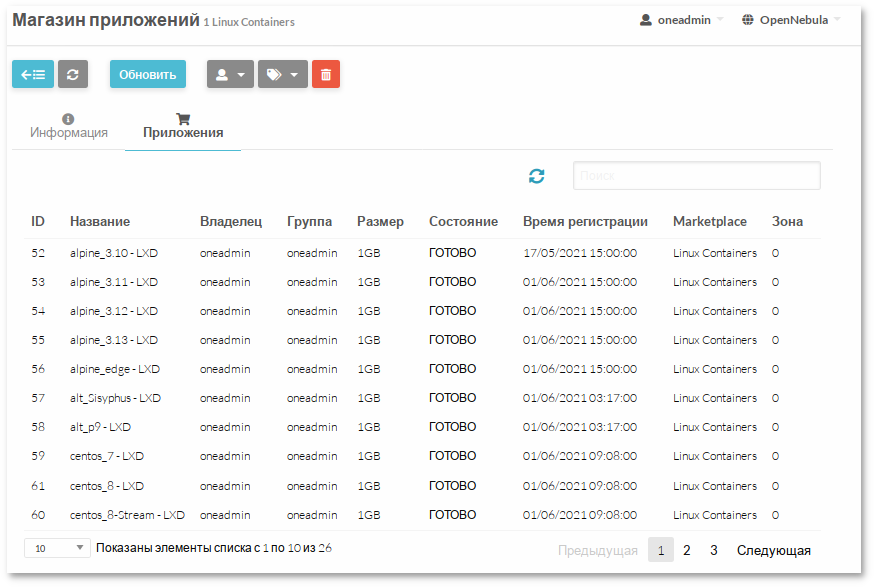

30.3. Скачивание шаблона контейнера из магазина приложений

Для загрузки контейнера из магазина необходимо перейти в → , выбрать → :

Выбрать LXD образ. Чтобы импортировать приложение, необходимо его выбрать и нажать кнопку Import into Datastore:

Каждый контейнер содержит образ и шаблон.

В открывшемся окне указать название для образа и шаблона, выбрать хранилище и нажать кнопку Загрузить:

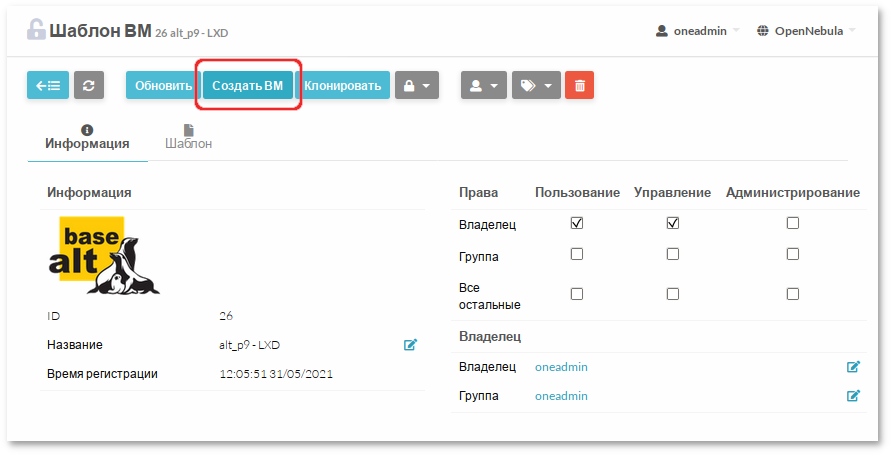

Из полученного шаблона можно разворачивать контейнеры (ВМ в терминологии Opennebula). Процесс разворачивания контейнера из шаблона такой же, как и процесс разворачивания ВМ из шаблона:

Глава 31. Настройка отказоустойчивого кластера

В данном разделе рассмотрена настройка отказоустойчивого кластера (High Available, HA) для основных служб OpenNebula: core (oned), scheduler (mm_sched).

OpenNebula использует распределенный консенсусный протокол Raft, для обеспечения отказоустойчивости и согласованности состояний между службами. Алгоритм консенсуса построен на основе двух концепций:

Состояние системы — данные, хранящиеся в таблицах базы данных (пользователи, списки управления доступом или виртуальные машины в системе).

Журнал (Log) — последовательность операторов SQL, которые последовательно применяются к базе данных OpenNebula на всех серверах для изменения состояния системы.

Чтобы сохранить согласованное представление о системе на всех серверах, изменения состояния системы выполняются через специальный узел, лидер или ведущий (Leader). Leader периодически посылает запросы (heartbeats) другим серверам, ведомым (Follower), чтобы сохранить свое лидерство. Если Leader не может послать запрос, Follower-серверы продвигаются к кандидатам и начинают новые выборы.

Каждый раз, когда система изменяется (например, в систему добавляется новая ВМ), Leader обновляет журнал и реплицирует запись у большинства Follower, прежде чем записывать её в базу данных. Таким образом, увеличивается задержка операций с БД, но состояние системы безопасно реплицируется, и кластер может продолжить свою работу в случае отказа узла.

Для настройки High Available требуется:

нечетное количество серверов (рекомендуемый размер развертывания — 3 или 5 серверов, что обеспечивает отказоустойчивость при отказе 1 или 2 серверов соответственно);

рекомендуется идентичная конфигурация серверов;

идентичная программная конфигурация серверов (единственное отличие — это поле SERVER_ID в /etc/one/oned.conf);

рекомендуется использовать подключение к базе данных одного типа (MySQL);

серверы должны иметь беспарольный доступ для связи друг с другом;

плавающий IP, который будет назначен лидеру;

общая файловая система.

Добавлять дополнительные серверы или удалять старые можно после запуска кластера.

В данном примере показана настройка HA кластера из трех серверов:

31.1. Первоначальная конфигурация Leader

Запустить сервис OpenNebula и добавить локальный сервер в существующую или новую зону (в примере зона с ID 0):

$ onezone list

C ID NAME ENDPOINT FED_INDEX

* 0 OpenNebula http://localhost:2633/RPC2 -1

$ onezone server-add 0 --name opennebula --rpc http://192.168.0.186:2633/RPC2

$ onezone show 0

ZONE 0 INFORMATION

ID : 0

NAME : OpenNebula

ZONE SERVERS

ID NAME ENDPOINT

0 opennebula http://192.168.0.186:2633/RPC2

HA & FEDERATION SYNC STATUS

ID NAME STATE TERM INDEX COMMIT VOTE FED_INDEX

0 opennebula solo 0 -1 0 -1 -1

ZONE TEMPLATE

ENDPOINT="http://localhost:2633/RPC2"

Остановить сервис opennebula и обновить конфигурацию SERVER_ID в файле

/etc/one/oned.conf:

FEDERATION = [

MODE = "STANDALONE",

ZONE_ID = 0,

SERVER_ID = 0, # изменить с -1 на 0 (0 — это ID сервера)

MASTER_ONED = ""

]

Включить Raft-обработчики, чтобы добавить плавающий IP-адрес в кластер (файл

/etc/one/oned.conf):

RAFT_LEADER_HOOK = [

COMMAND = "raft/vip.sh",

ARGUMENTS = "leader enp0s3 192.168.0.200/24"

]

# Executed when a server transits from leader->follower

RAFT_FOLLOWER_HOOK = [

COMMAND = "raft/vip.sh",

ARGUMENTS = "follower enp0s3 192.168.0.200/24"

]

Запустить сервис OpenNebula и проверить зону:

$ onezone show 0

ZONE 0 INFORMATION

ID : 0

NAME : OpenNebula

ZONE SERVERS

ID NAME ENDPOINT

0 opennebula http://192.168.0.186:2633/RPC2

HA & FEDERATION SYNC STATUS

ID NAME STATE TERM INDEX COMMIT VOTE FED_INDEX

0 opennebula leader 1 5 5 0 -1

ZONE TEMPLATE

ENDPOINT="http://localhost:2633/RPC

Сервер opennebula стал Leader-сервером, так же ему был присвоен плавающий адрес (Floating IP):

$ ip -o a sh enp0s3

2: enp0s3 inet 192.168.0.186/24 brd 192.168.0.255 scope global enp0s3\ valid_lft forever preferred_lft forever

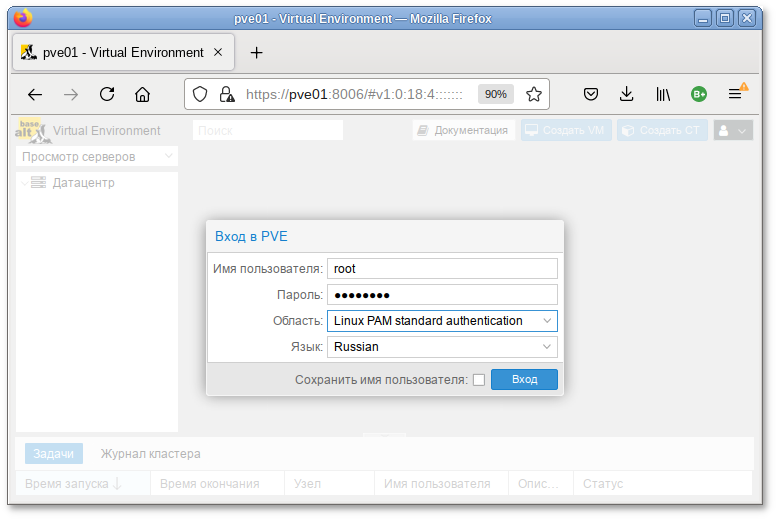

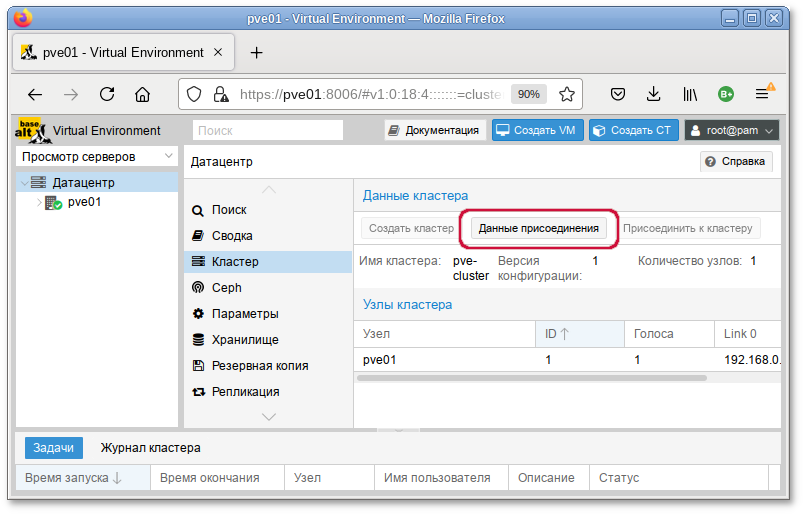

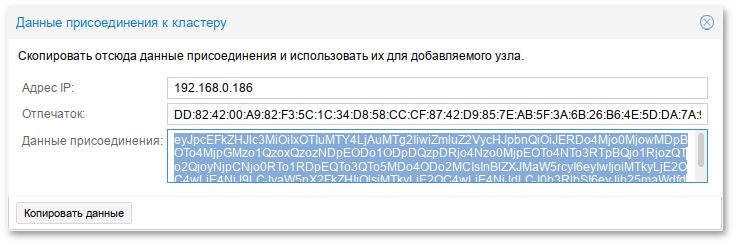

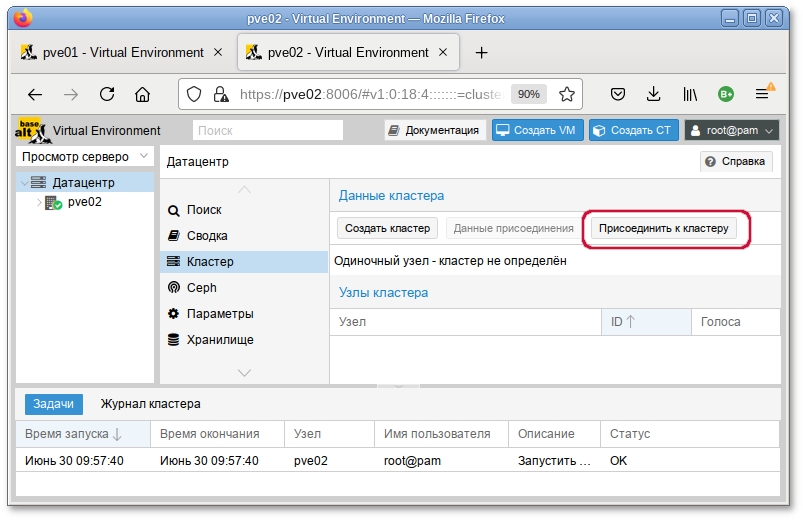

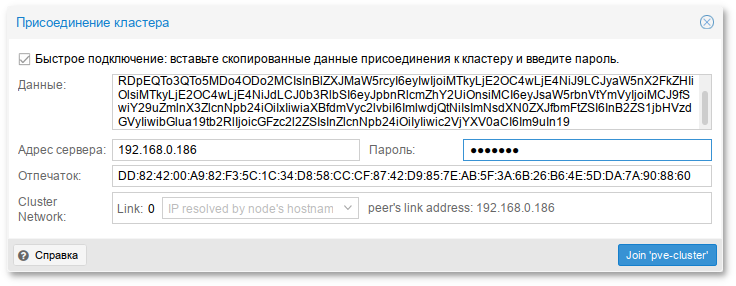

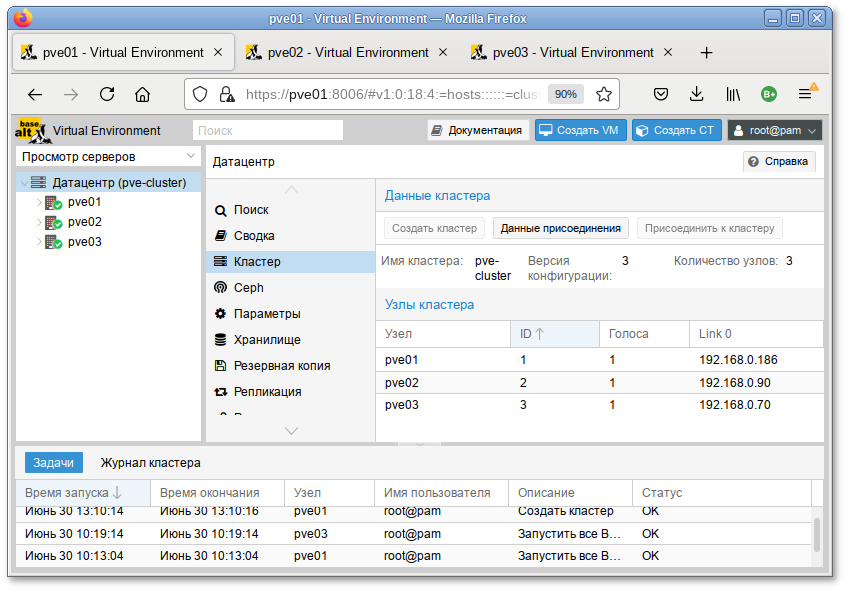

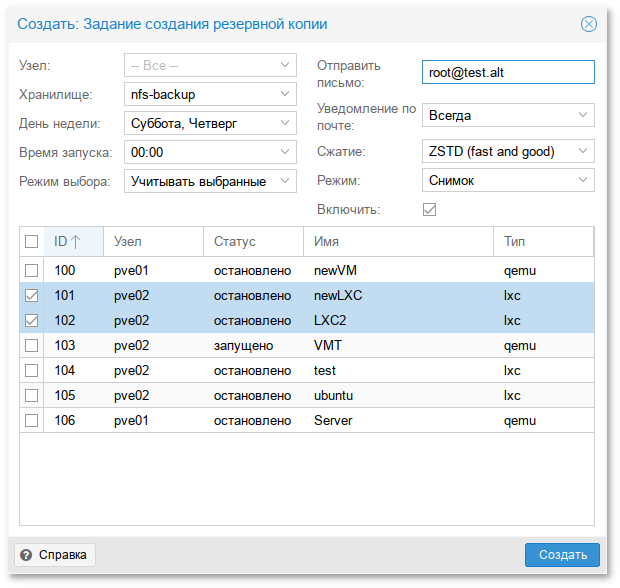

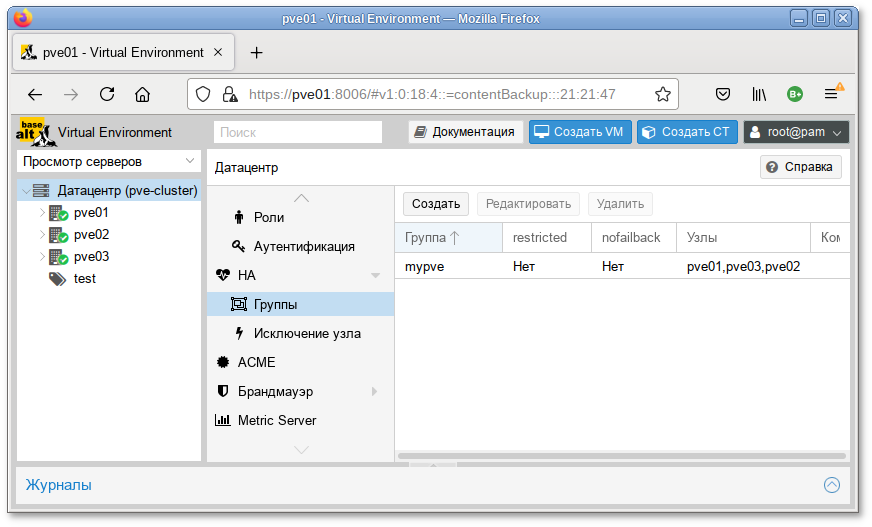

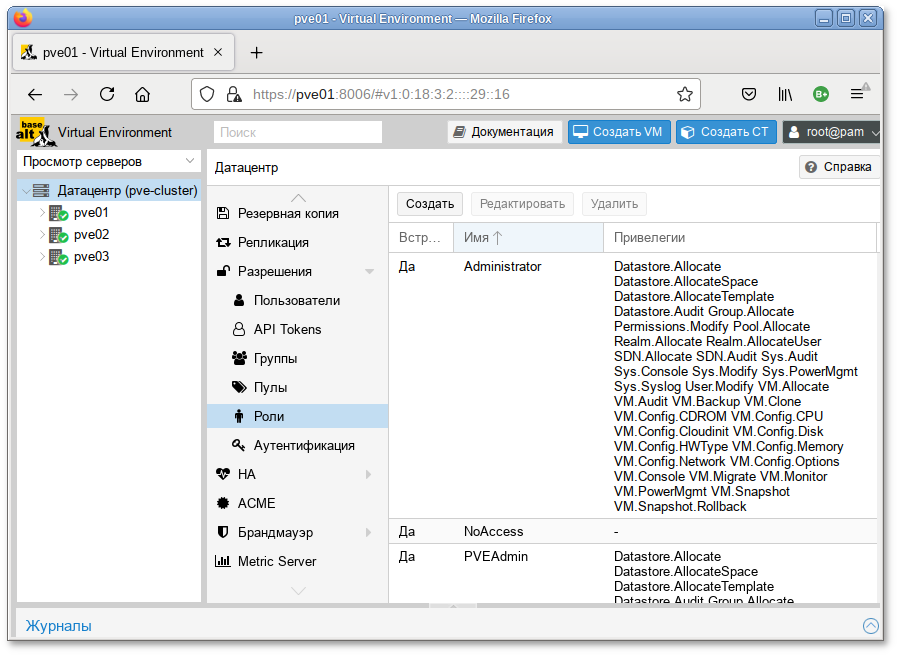

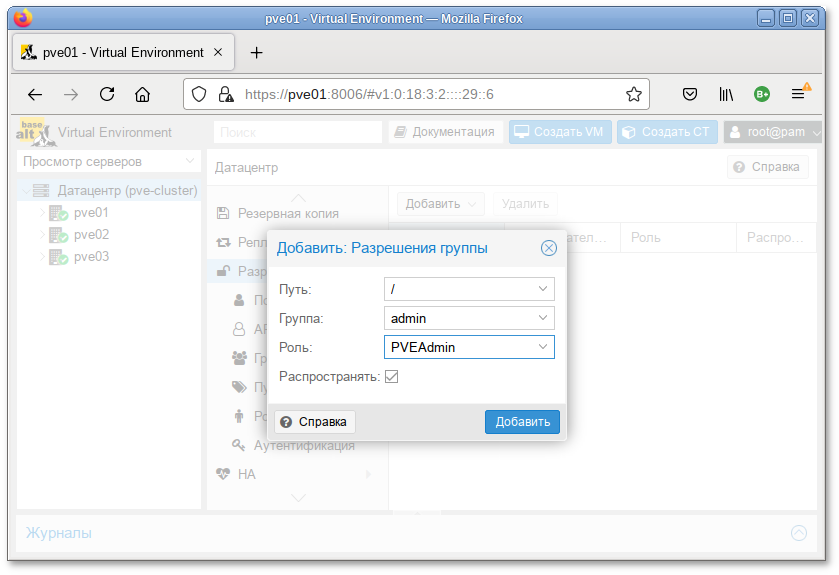

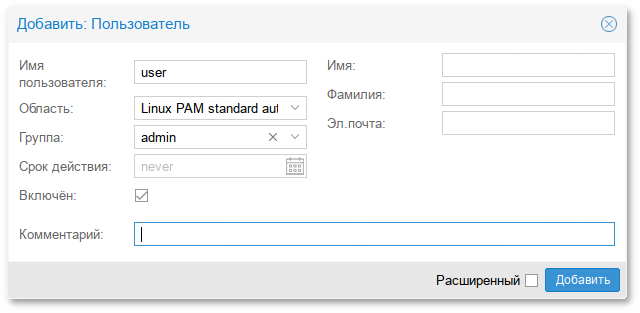

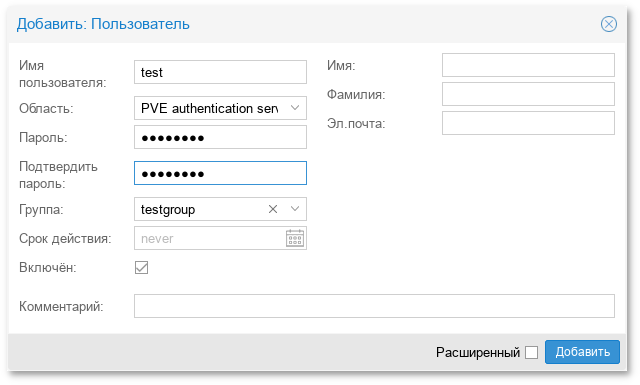

2: enp0s3 inet 192.168.0.200/24 scope global secondary enp0s3\ valid_lft forever preferred_lft forever