Часть II. Установка дистрибутива

В этой части рассматривается процесс установки дистрибутива.

Глава 4. Подготовка установочного диска

Наиболее частый способ установки операционной системы на компьютер представляет собой установку с установочного DVD-диска. В этой главе описываются различные способы записи дистрибутива на DVD-диск.

Установочные образы являются гибридными, что позволяет производить установку, записав такой образ на USB Flash. О записи установочного образа на USB Flash также рассказано в этой главе.

4.1. Запись ISO-образа дистрибутива на DVD

4.1.1. Запись образа диска под операционной системой MS Windows

Файл ISO-образа диска — это файл специального формата, подготовленный для записи на диск. Для записи ISO-образа под операционной системой MS Windows используйте специальные программы:

SCDWriter,

Nero BurningROM и другие. Рекомендуем для записи использовать новые диски от известных производителей, таких как: Verbatim, TDK. Записанный на плохой диск образ может вызвать неразрешимые проблемы при установке.

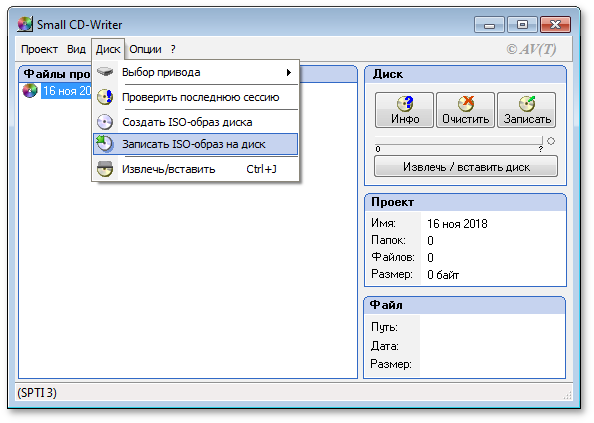

4.1.1.1. Запись образа диска с помощью Small CD-Writer

Весь процесс записи установочного диска при помощи

Small CD-Writer состоит из следующих шагов:

скачать образ дистрибутива;

распаковать файлы программы из архива в любой каталог;

вставить чистый диск в привод;

войти в распакованный каталог и запустить программу SCDWriter.exe;

открыть пункт меню → и, в появившемся окне, указать путь к образу диска;

нажать кнопку Записать.

4.1.1.2. Запись образа диска с помощью Nero BurningROM

Процесс записи установочного диска при помощи

Nero BurningROM состоит из следующих шагов:

скачать образ дистрибутива;

запустить программу и выбрать в списке устройств необходимый для записи CD/DVD дисковод;

нажать кнопку Открыть проект в главном окне. В появившемся окне выбрать необходимый ISO-образ для записи и нажать кнопку Открыть;

в окне Запись проекта (Записать образ) настроить необходимые параметры;

записать ISO-образа на диск, щёлкнув по кнопке Запись (Burn).

4.1.2. Запись образа диска под операционной системой Linux

Для записи ISO-образов можно использовать множество утилит и программ с графическим или текстовым интерфейсом. Наиболее удобно использовать программы K3b или Brasero, которые поставляются в комплекте любого дистрибутива операционной системы Linux.

4.1.2.1. Запись образа диска с помощью K3b

Весь процесс записи установочного диска при помощи

K3b состоит из следующих шагов:

если программа k3b отсутствует, необходимо установить её в систему, используя стандартные для вашего дистрибутива инструменты установки программ;

запустить программу k3b. При правильных настройках программа сообщит об отсутствии проблем с системой и предложит перейти к записи на диск;

в меню главного окна выбрать пункт ;

в появившемся окне Записать образ DVD (Burn DVD image) нажать на кнопку Выбор файла для записи. Откроется диалог, в котором необходимо выбрать ISO-образ для записи и после выбора нажать кнопку ОК;

программа k3b покажет информацию о ISO-файле и начнёт вычислять контрольную сумму. Эта операция может занять несколько минут. Полученную контрольную сумму можно сравнить с MD5SUM суммой на странице дистрибутива;

если контрольные суммы не совпадают, значит, для записи был выбран не тот файл или скачанный ISO-образ был испорчен во время передачи данных по сети;

если контрольные суммы совпадают, вставить диск для записи в дисковод. Дождаться активации кнопки Начать (Start);

нажать на кнопку Начать (Start).

4.2. Запись установочного образа на USB Flash

Запись образа дистрибутива на flash-диск приведёт к изменению таблицы разделов на носителе, таким образом, если flash-диск выполнил функцию загрузочного\установочного устройства и требуется вернуть ему функцию переносного накопителя данных, то необходимо удалить все имеющиеся разделы на flash-диске и создать нужное их количество заново.

Для восстановления совместимости flash-диска с операционными системами семейства Windows может понадобиться также пересоздание таблицы разделов (например, при помощи parted). Нужно удалить таблицу GPT и создать таблицу типа msdos. Кроме того, должен быть только один раздел с FAT или NTFS.

Для создания загрузочного flash-диска понадобится файл ISO-образа установочного диска с дистрибутивом. ISO-образы установочных дисков являются гибридными (Hybrid ISO/IMG), что позволяет записать их на flash-накопитель.

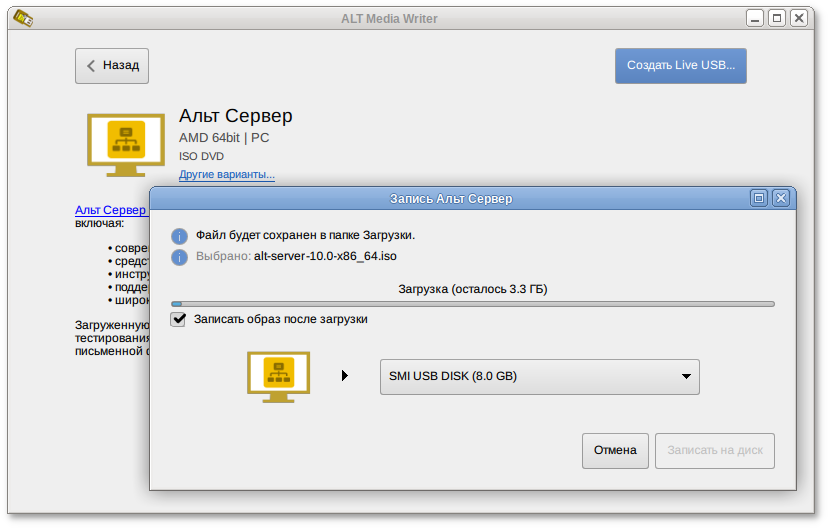

4.2.1. В операционной системе Windows

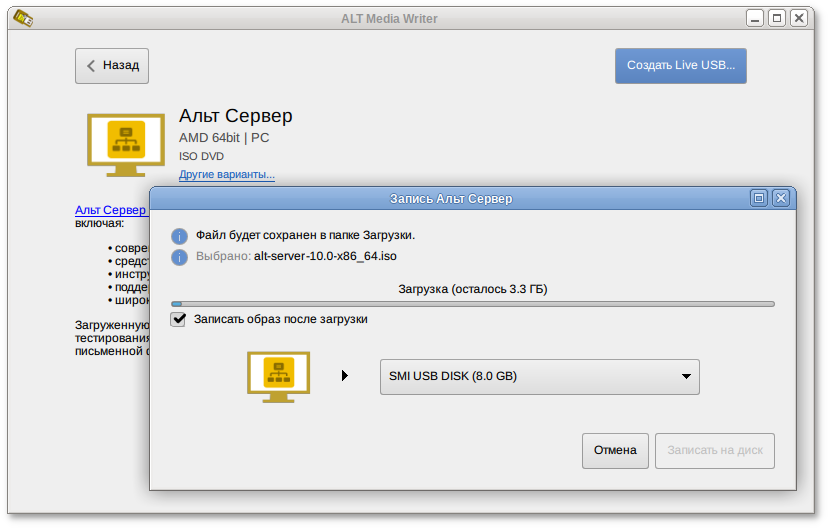

ALT Media Writer — это инструмент, который помогает записывать образы ALT на портативные накопители, такие как flash-диски. Он может автоматически загружать образы из интернета и записывать их. Для записи образа на flash-диск необходимо:

скачать и установить

ALT Media Writer;

вставить flash-диск в USB-разъем;

запустить ALT Media Writer;

выбрать дистрибутив и нажать кнопку

Создать Live USB…:

начнётся загрузка образа из интернета;

выбрать устройство (flash-диск);

после окончания загрузки нажать кнопку Записать на диск (если был отмечен пункт Записать образ после загрузки, запись образа начнётся автоматически).

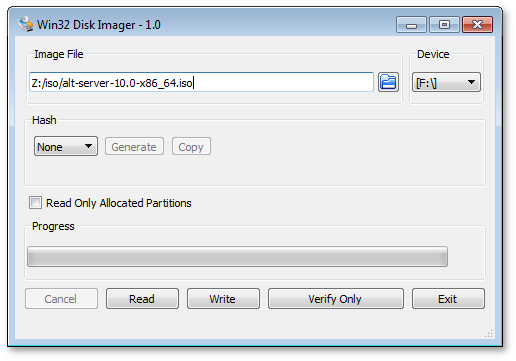

Инструкция для записи образа в программе

Win32 Disk Imager:

скачать образ дистрибутива;

вставить flash-диск в USB-разъем (размер flash-диска должен быть не меньше размера скачанного образа диска);

запустить Win32 Disk Imager;

в появившимся окне выбрать ISO-образ дистрибутива, выбрать устройство (flash-диск):

нажать кнопку Write для записи образа на flash-диск.

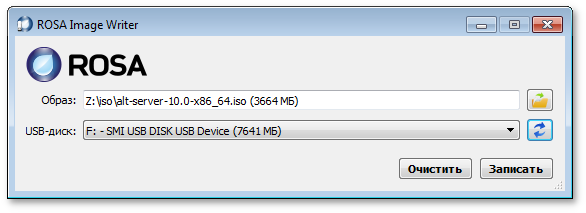

Инструкция для записи образа в программе

ROSA Image Writer:

распаковать файлы программы из архива в любой каталог;

скачать образ дистрибутива;

вставить flash-диск в USB-разъем (размер flash-диска должен быть не меньше размера скачанного образа диска);

запустить файл .exe;

в появившимся окне выбрать ISO-образ дистрибутива, выбрать устройство (flash-диск):

нажать кнопку Записать для записи образа на flash-диск.

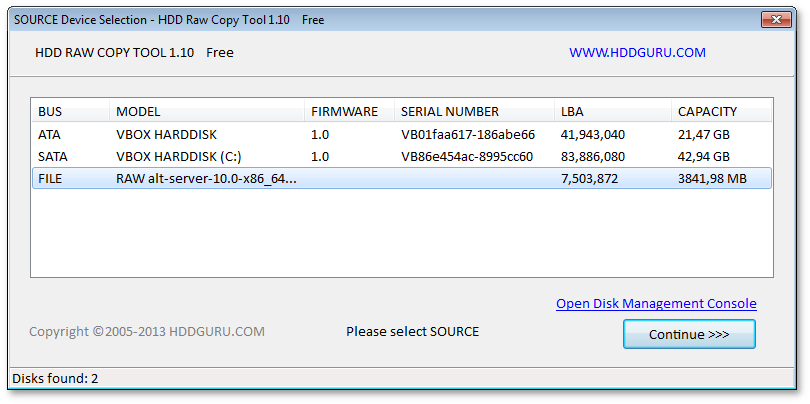

Для записи образа на flash-диск подойдёт и утилита

HDD Raw Copy Tool. На первом шаге нужно выбрать файл с образом диска:

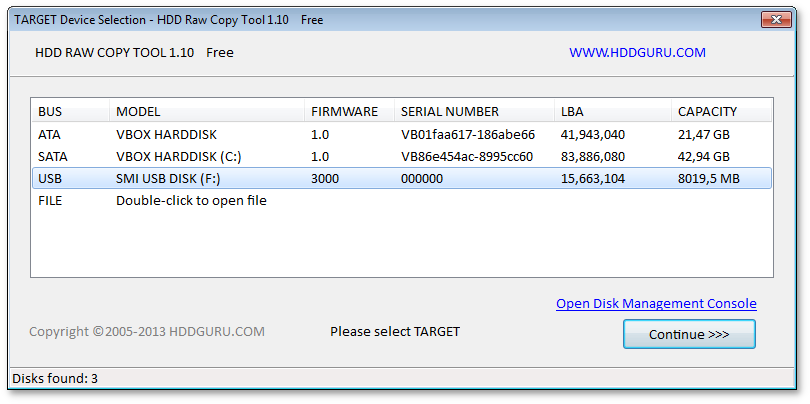

На втором шаге нужно выбрать flash-диск, на который будет записан образ:

Будьте внимательны при указании имени usb-устройства — запись образа по ошибке на свой жёсткий диск приведёт к почти гарантированной потере данных на нём!

После проверки правильности выбранных параметров и нажатия кнопки Continue можно приступать к записи, нажав кнопку START. По успешному завершению записи окно с индикацией процесса записи закроется, после чего можно закрыть и окно самой программы.

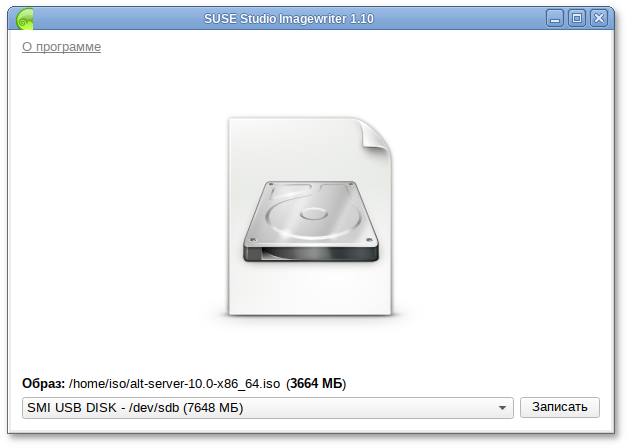

4.2.2. В операционной системе Linux

Для записи образа на flash-диск можно воспользоваться одной из программ с графическим интерфейсом:

Для записи установочного образа можно воспользоваться утилитой командной строки dd:

dd oflag=direct if=<файл-образа.iso> of=/dev/sdX bs=1M status=progress

sync

где <файл-образа.iso> — образ диска ISO, а

/dev/sdX — устройство, соответствующее flash-диску.

Для удобства показа прогресса записи можно установить пакет pv и использовать команду:

pv <файл-образа.iso> | dd oflag=direct of=/dev/sdX bs=1M;sync

где <файл-образа.iso> — образ диска ISO, а

/dev/sdX — устройство, соответствующее flash-диску.

Просмотреть список доступных устройств можно командой lsblk или (если такой команды нет): blkid.

Например, так можно определить имя flash-диска:

$ lsblk | grep disk

sda 8:0 0 931,5G 0 disk

sdb 8:16 0 931,5G 0 disk

sdc 8:32 1 7,4G 0 disk

flash-диск имеет имя устройства sdc.

Затем записать:

# dd oflag=direct if=/home/iso/alt-server-10.0-x86_64.iso of=/dev/sdc bs=1M status=progress; sync

или, например, так:

# pv /home/iso/alt-server-10.0-x86_64.iso | dd oflag=direct of=/dev/sdc bs=1M;sync

dd: warning: partial read (524288 bytes); suggest iflag=fullblock

3GiB 0:10:28 [4,61MiB/s] [===================================> ] 72% ETA 0:04:07

Будьте внимательны при указании имени usb-устройства — запись образа по ошибке на свой жёсткий диск приведёт к почти гарантированной потере данных на нём!

Не добавляйте номер раздела, образ пишется на flash-диск с самого начала!

Не извлекайте flash-диск, пока образ не запишется до конца! Определить финал процесса можно по прекращению моргания индикатора flash-диска либо посредством виджета "Безопасное извлечение съемных устройств". В консоли можно подать команду

eject /dev/sdX

и дождаться ее успешного завершения.

4.2.3. В операционной системе OS X

В операционной системе OS X для создания загрузочного flash-диска можно использовать команду:

sudo dd if=alt-server-10.0-x86_64.iso of=/dev/diskX bs=1M

sync

где alt-server-10.0-x86_64.iso — образ диска ISO, а /dev/diskX — flash-диск.

Просмотреть список доступных устройств можно командой:

diskutil list

Будьте внимательны при указании имени usb-устройства — запись образа по ошибке на свой жёсткий диск приведёт к почти гарантированной потере данных на нём!

4.2.4. Проверка целостности записанного образа

Внимание! Если речь идёт о записи на flash-диск образа LiveCD, проверка должна быть выполнена сразу же после записи на USB Flash, без запуска с него. Причина в том, что остаток flash-диска, при первом запуске LiveCD, форматируется, как r/w раздел, при этом меняется и таблица разделов.

Для проверки целостности записанного образа необходимо выполнить следующие шаги:

определить длину образа в байтах:

$ du -b alt-server-10.0-x86_64.iso | cut -f1

3506438144

посчитать контрольную сумму образа (или просмотреть контрольную сумму образа из файла MD5SUM на сервере FTP):

$ md5sum alt-server-10.0-x86_64.iso

cf0024eceae6d290be95672adc9290ef alt-server-10.0-x86_64.iso

подсчитать контрольную сумму записанного образа на DVD или USB Flash (выполняется под правами пользователя root):

# head -c 3506438144 /dev/sdd | md5sum

cf0024eceae6d290be95672adc9290ef

где размер после -c — вывод в п.1, а /dev/sdd — устройство DVD или USB Flash, на которое производилась запись.

Глава 5. Альтернативные способы установки

Обычно для установки дистрибутива используется установочный загрузочный CD/DVD-диск или USB flash-накопитель. Если вы производите установку именно таким образом, можете пропустить этот раздел и сразу перейти к разделу

Последовательность установки.

Установка с загрузочного диска — это один из возможных способов установки системы. Он является самым распространённым способом установки системы, но не работает, например, в случае отсутствия на компьютере CD/DVD-привода. Для таких случаев поддерживаются альтернативные методы установки.

Необходимо понимать, что для начала процесса установки необходимо присутствие двух составляющих: возможности загрузить компьютер и доступа к установочным файлам. В случае загрузки с установочного диска эти две возможности предоставляются самим диском: он является загрузочным и содержит все необходимые для установки файлы. Однако, вполне допустим и такой вариант: первоначальная загрузка происходит со специально подготовленного USB flash-накопителя, а установочные файлы берутся с FTP-сервера сети.

Таким образом, для альтернативной установки дистрибутива необходимо:

5.1. Источники установки

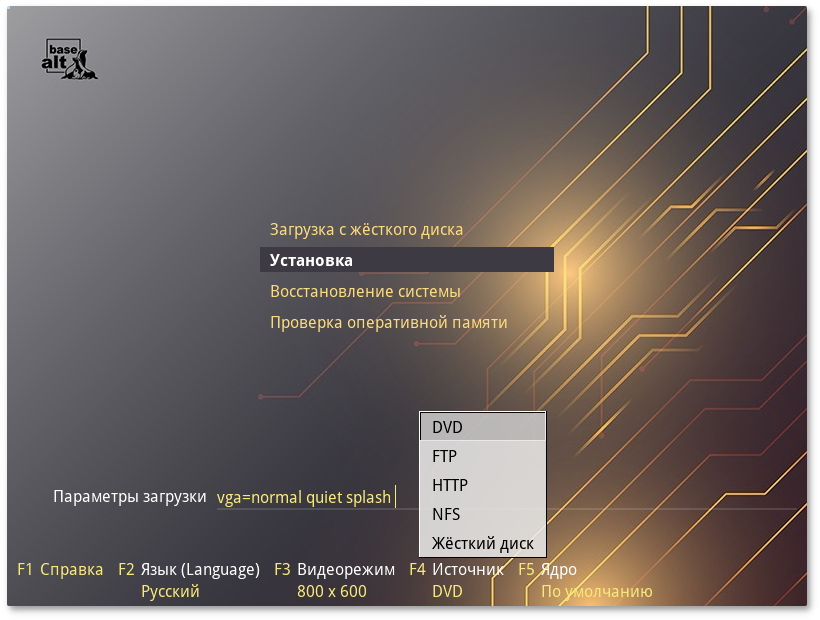

После первоначальной загрузки с одного из поддерживаемых носителей можно выбрать — место, откуда программа установки будет брать все необходимые при установке данные (прежде всего устанавливаемое ПО). Так как установка системы возможна не только с лазерного диска, то можно выбрать один из поддерживаемых альтернативных источников установки. Для выбора источника установки необходимо в меню установки нажать кнопку

F4:

Источники установки:

Сетевые:

FTP-сервер;

HTTP-сервер;

NFS-сервер.

Условием для всех способов установки является доступность дерева файлов, аналогичного содержимому установочного диска.

5.1.1. Запуск сетевой установки

Кнопка F4 позволяет выбрать источник сетевой установки: FTP, HTTP или NFS-сервер. Нужно указать имя или IP-адрес сервера и каталог (начиная с /), в котором размещён дистрибутив. В случае установки по протоколу FTP может понадобиться также ввести имя и пароль пользователя.

Пример установки:

имя сервера: 192.168.0.1

каталог:

/pub/netinstall/. В данном каталоге на сервере должны находиться:

Для получения подобного дерева каталогов на стороне сервера достаточно скопировать содержимое установочного лазерного диска в один из подкаталогов FTP-сервера (либо HTTP или NFS-сервера). В описанном примере это каталог /pub/netinstall.

При сетевой установке со стороны клиента (компьютера, на который производится установка) может понадобиться определить параметры соединения с сервером. В этом случае на экране будут появляться диалоги, например, с предложением выбрать сетевую карту (если их несколько) или указать тип IP-адреса: статический (потребуется вписать его самостоятельно) или динамический (DHCP).

После успешного соединения с сервером в память компьютера будет загружен образ установочного диска. После этого начнётся установка системы подобно установке с лазерного диска.

5.1.2. Установка с жёсткого диска

Установка Альт Сервер с жёсткого диска происходит аналогично установке по сети. Для этого понадобится подключить дополнительный жёсткий диск с дистрибутивом. Чтобы выбрать подключённый диск в качестве источника установки, нужно кнопкой

F4 выбрать источник установки . Затем выбрать пункт в загрузочном меню. По нажатию

Enter на экране появится диалог выбора дискового раздела, а после — диалог выбора пути к каталогу с дистрибутивом. После указания пути начнётся установка системы. Можно сразу указать путь к дистрибутиву, сделав в строке параметров загрузки запись вида:

automatic=method:disk,disk:hdb,partition:hdbX,directory:<путь_к_каталогу_с_дистрибутивом>

В данной команде «путь_к_каталогу_с_дистрибутивом» — полный путь к образу дистрибутива, например,

/home/test/alt-server.iso, или путь к каталогу с содержимым образа дистрибутива (распакованный образ диска), например,

/home/test/alt-server-dir.

Глава 6. Сохранение данных и меры предосторожности

Если необходимо установить ОС Альт Сервер и при этом сохранить уже установленную на компьютере операционную систему (например, другую версию GNU/Linux или Microsoft Windows), то нужно обязательно позаботиться о подготовке компьютера к установке второй системы и о сохранении ценных для вас данных.

Если у вас нет загрузочного диска для уже установленной системы, создайте его. В случае прерванной установки ОС Альт Сервер или неправильной настройки загрузчика, вы можете потерять возможность загрузиться в вашу предыдущую ОС.

Если на диске, выбранном для установки ОС Альт Сервер, не осталось свободного раздела, то программа установки должна будет изменить размер существующего раздела. От этой операции могут пострадать ваши данные, поэтому предварительно надо сделать следующие действия.

Выполнить проверку раздела, который вы собираетесь уменьшать. Для этого воспользуйтесь соответствующим программным обеспечением (далее — ПО), входящим в состав уже установленной ОС. Программа установки Альт Сервер может обнаружить некоторые очевидные ошибки при изменении размера раздела, но специализированное ПО предустановленной ОС справится с этой задачей лучше.

Выполнить дефрагментацию уменьшаемого раздела в целях повышения уровня безопасности данных. Это действие не является обязательным, но мы настоятельно рекомендуем его произвести: изменение размера раздела пройдёт легче и быстрее.

Полной гарантией от проблем, связанных с потерей данных, является резервное копирование!

Глава 7. Начало установки: загрузка системы

7.1. Способы первоначальной загрузки

Для загрузки компьютера с целью установки системы необходимо воспользоваться носителем, содержащим начальный загрузчик.

Простейший способ запустить программу установки — загрузить компьютер с помощью загрузочного носителя, находящегося на установочном DVD с дистрибутивом (при условии, что система поддерживает загрузку с устройства для чтения DVD).

Также программу установки можно запустить с другого загрузочного носителя. Например, в качестве загрузочного носителя может использоваться загрузочный USB-flash-накопитель.

Для того чтобы начать установку ОС Альт Сервер, достаточно загрузиться с носителя, на котором записан дистрибутив.

Предварительно следует включить в BIOS опцию загрузки с оптического привода или с USB-устройства.

В большинстве случаев указание способа входа в BIOS отображается на вашем мониторе непосредственно после включения компьютера. Способ входа в меню BIOS и информация о расположении настроек определяется производителем используемого оборудования. За информацией можно обратиться к документации на ваше оборудование.

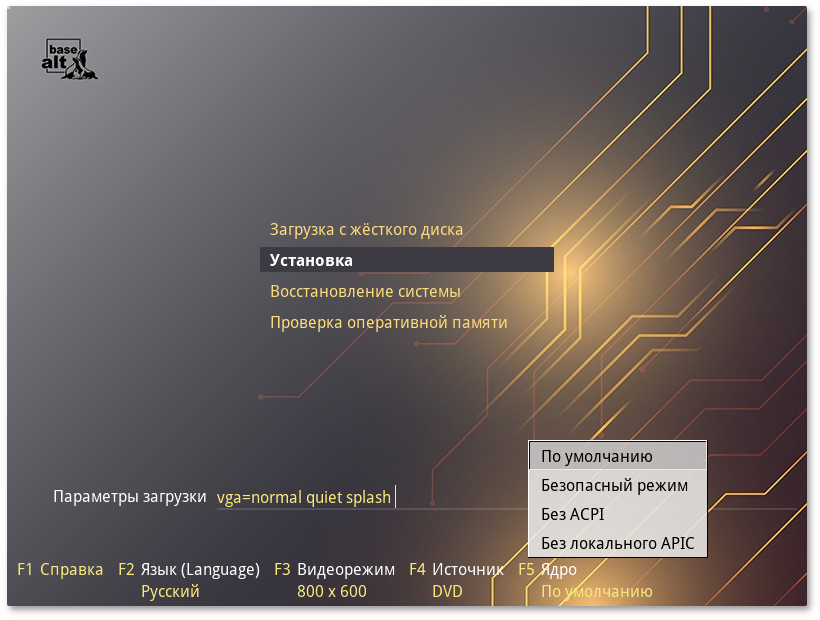

Загрузка с установочного диска или специально подготовленного USB-flash-накопителя начинается с меню, в котором перечислено несколько вариантов загрузки:

— запуск уже установленной на жестком диске операционной системы;

— установка операционной системы;

— восстановление уже установленной, но так или иначе поврежденной ОС Linux путем запуска небольшого образа ОС в оперативной памяти. Восстановление системы потребует некоторой квалификации. Этот пункт также может быть использован для сбора информации об оборудовании компьютера, которую можно отправить разработчикам, если ОС Альт Сервер устанавливается и работает неправильно. Загрузка восстановительного режима заканчивается приглашением командной строки:

[root@localhost /]#;

— проверка целостности оперативной памяти. Процесс диагностики заключается в проведении нескольких этапов тестирования каждого отдельного модуля ОЗУ (данный процесс будет выполняться бесконечно, пока его не остановят, необходимо дождаться окончания хотя бы одного цикла проверки).

Мышь на этом этапе установки не поддерживается. Для выбора опций установки и различных вариантов необходимо использовать клавиатуру.

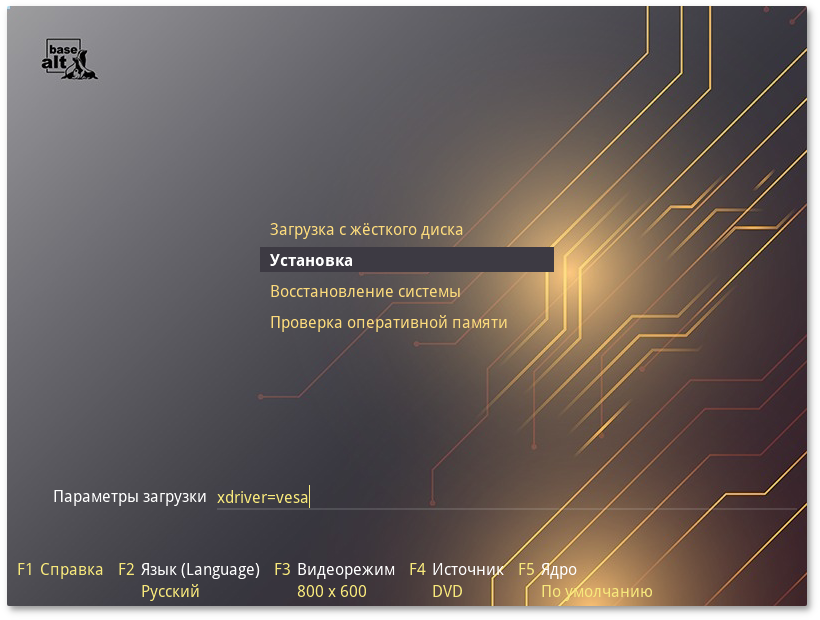

В строке

Параметры загрузки, меню начального загрузчика, можно вручную задать параметры, передаваемые ядру. Например,

nomodeset — не использовать modeset-драйверы для видеокарты;

vga=normal — отключить графический экран загрузки установщика;

xdriver=vesa — явно использовать видеодрайвер vesa. Данным параметром можно явно указать нужный вариант драйвера;

acpi=off noapic — отключение ACPI (управление питанием), если система не поддерживает ACPI полностью.

В нижней части экрана отображаются дополнительные опции, влияющие на дальнейший ход установки:

Можно получить справку по любому пункту меню, выбрав этот пункт и нажав клавишу F1.

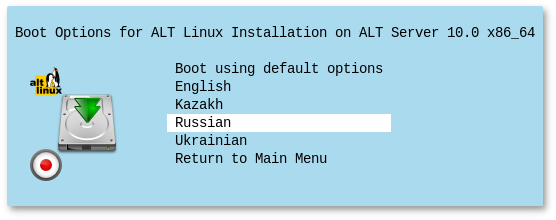

Нажатием клавиши F2 осуществляется выбор языка. От выбора языка в загрузчике зависит язык интерфейса загрузчика и программы установки.

По нажатию клавиши F3 открывается меню доступных видеорежимов (разрешений экрана). Это разрешение будет использоваться во время установки и загрузки установленной системы.

Выбрать источник установки можно, нажав клавишу

F4 (подробнее рассказано в разделе

Источники установки).

Нажатие клавиши F5 выполняет переход к списку модулей для определения состава системных служб и сервисов, с которыми ядро ОС Альт Сервер будет установлено на загрузочный носитель.

Сочетание клавиш Ctrl+Alt+F1 — выдает технические сведения о выполнении процесса установки ОС Альт Сервер.

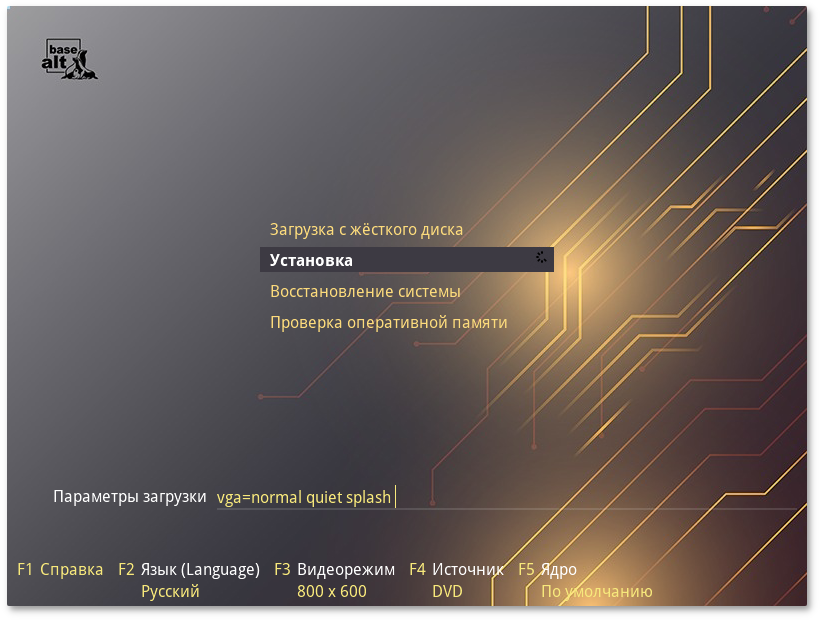

Чтобы начать процесс установки, нужно клавишами перемещения курсора вверх и вниз, выбрать пункт меню , и нажать Enter. Начальный этап установки не требует вмешательства пользователя: происходит автоматическое определение оборудования и запуск компонентов программы установки. Сообщения о происходящем на данном этапе можно просмотреть, нажав клавишу ESC.

В начальном загрузчике установлено небольшое время ожидания: если в этот момент не предпринимать никаких действий, то будет загружена та система, которая уже установлена на жестком диске. Если вы пропустили нужный момент, перезагрузите компьютер и вовремя выберите пункт .

Глава 8. Последовательность установки

До того, как будет произведена установка базовой системы на жёсткий диск, программа установки работает с образом системы, загруженным в оперативную память компьютера.

Если инициализация оборудования завершилась успешно, будет запущен графический интерфейс программы-установщика. Процесс установки разделён на шаги. Каждый шаг посвящён настройке или установке определённого свойства системы. Шаги нужно проходить последовательно. Переход к следующему шагу происходит по нажатию кнопки Далее. При помощи кнопки Назад, при необходимости, можно вернуться к уже пройденному шагу и изменить настройки. Однако возможность перехода к предыдущему шагу ограничена теми шагами, в которых нет зависимости от данных, введённых ранее.

Если по каким-то причинам возникла необходимость прекратить установку, необходимо нажать кнопку <Reset> на корпусе системного блока компьютера.

Совершенно безопасно выполнить отмену установки только до шага «

Подготовка диска», поскольку до этого момента не производится никаких изменений на жёстком диске. Если прервать установку между шагами «

Подготовка диска» и «

Установка загрузчика», существует вероятность, что после этого с жёсткого диска не сможет загрузиться ни одна из установленных систем (если такие имеются).

Технические сведения о ходе установки можно посмотреть, нажав Ctrl+Alt+F1, вернуться к программе установки — Ctrl+Alt+F7. По нажатию Ctrl+Alt+F2 откроется отладочная виртуальная консоль.

Каждый шаг сопровождается краткой справкой, которую можно вызвать, щёлкнув кнопку Справка или нажав клавишу F1.

Во время установки системы выполняются следующие шаги:

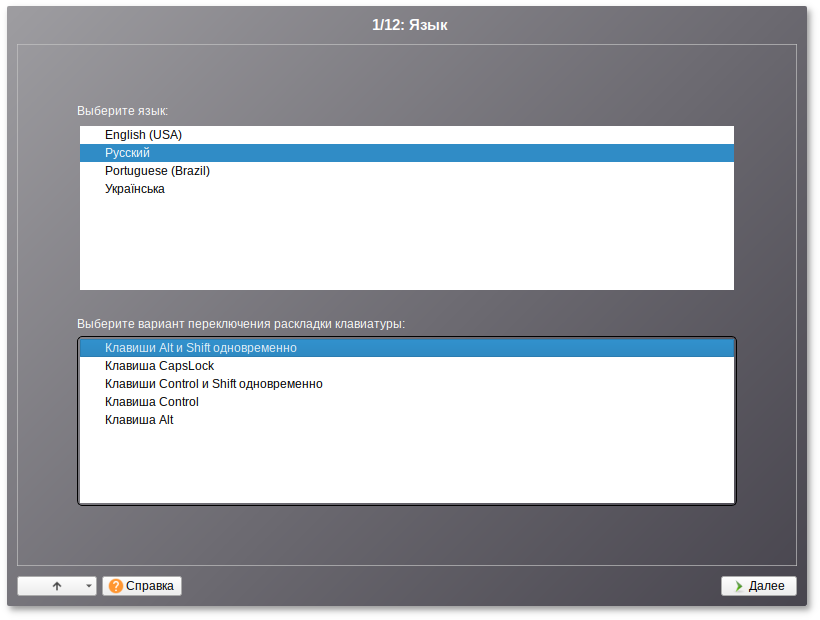

Установка Альт Сервер начинается с выбора основного языка — языка интерфейса программы установки и устанавливаемой системы. В списке, помимо доступных языков региона (выбранного на этапе начальной загрузки), указан и английский язык.

На этом же этапе выбирается вариант переключения раскладки клавиатуры. Раскладка клавиатуры — это привязка букв, цифр и специальных символов к клавишам на клавиатуре. Помимо ввода символов на основном языке, в любой системе Linux необходимо иметь возможность вводить латинские символы (имена команд, файлов и т.п.). Для этого обычно используется стандартная английская раскладка клавиатуры. Переключение между раскладками осуществляется при помощи специально зарезервированных для этого клавиш. Для русского языка доступны следующие варианты переключения раскладки:

Если выбранный основной язык имеет всего одну раскладку (например, при выборе английского языка в качестве основного), эта единственная раскладка будет принята автоматически.

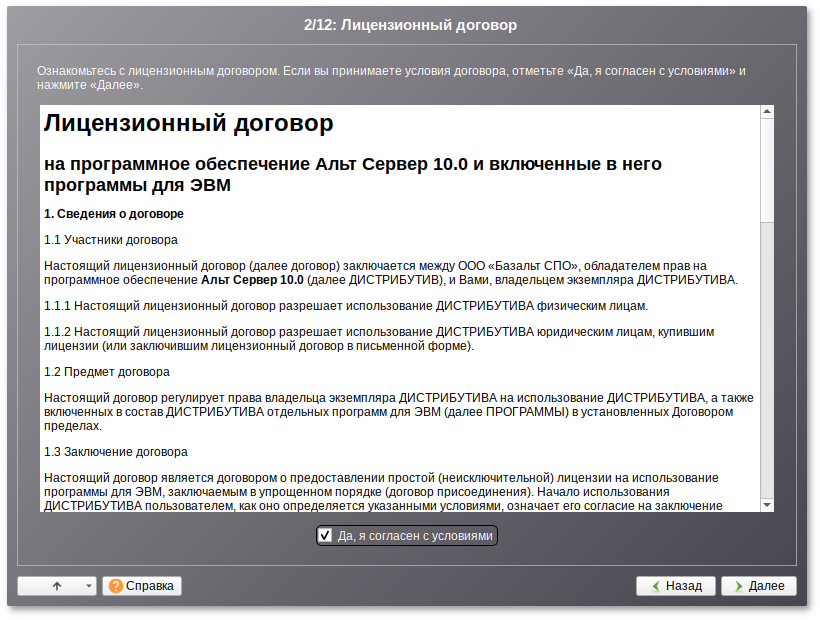

Глава 10. Лицензионный договор

Перед продолжением установки следует внимательно прочитать условия лицензии. В лицензии говорится о ваших правах. В частности, за вами закрепляются права на:

эксплуатацию программ на любом количестве компьютеров и в любых целях;

распространение программ (сопровождая их копией авторского договора);

получение исходных текстов программ.

Если вы приобрели дистрибутив, то данное лицензионное соглашение прилагается в печатном виде к вашей копии дистрибутива. Лицензия относится ко всему дистрибутиву Альт Сервер. Если вы согласны с условиями лицензии, отметьте пункт Да, я согласен с условиями и нажмите кнопку Далее.

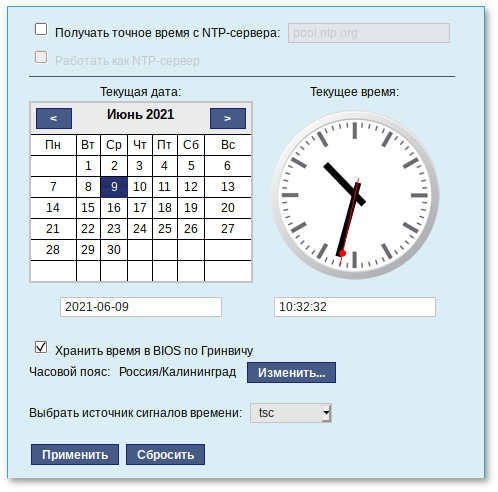

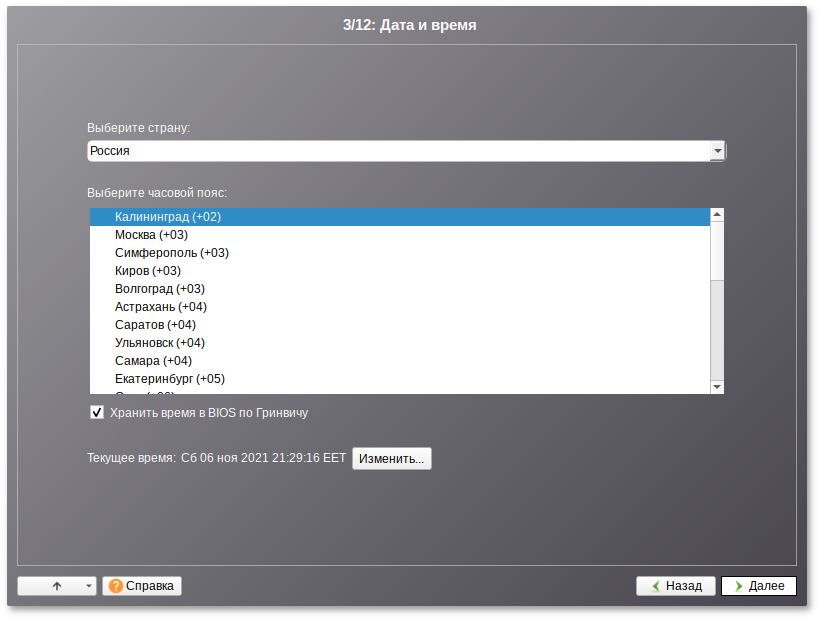

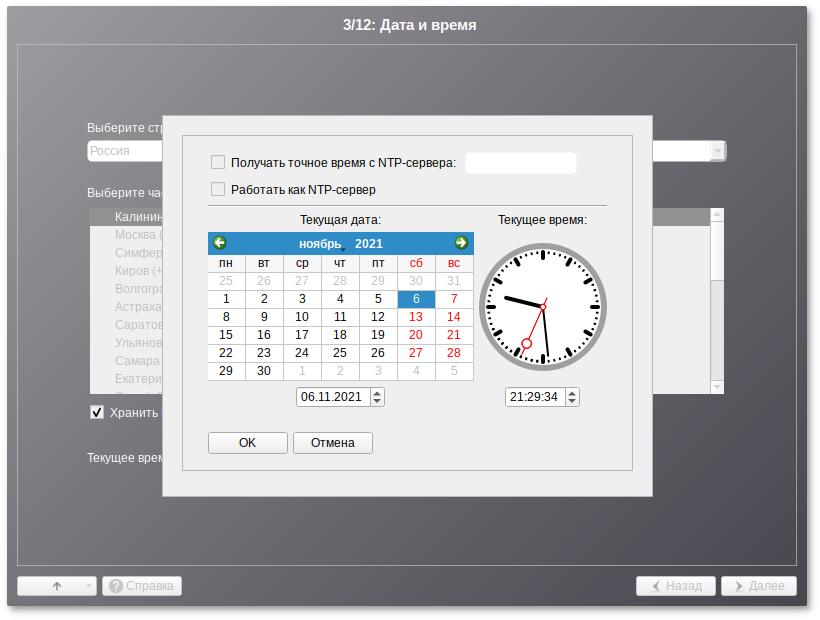

На данном этапе выполняется выбор страны и города, по которым будет определен часовой пояс и установлены системные часы.

Для корректной установки даты и времени достаточно правильно указать часовой пояс и выставить желаемые значения для даты и времени.

На этом шаге следует выбрать часовой пояс, по которому нужно установить часы. Для этого в соответствующих списках выберите страну, а затем регион. Поиск по списку можно ускорить, набирая на клавиатуре первые буквы искомого слова.

Пункт Хранить время в BIOS по Гринвичу выставляет настройки даты и времени в соответствии с часовыми поясами, установленными по Гринвичу, и добавляет к местному времени часовую поправку для выбранного региона.

После выбора часового пояса будут предложены системные дата и время по умолчанию.

Для ручной установки текущих даты и времени нужно нажать кнопку Изменить…. Откроется окно ручной настройки системных параметров даты и времени.

Для сохранения настроек и продолжения установки системы в окне ручной установки даты и времени необходимо нажать кнопку ОК и затем в окне Дата и время нажать кнопку Далее.

В случае если ОС Альт Сервер устанавливается как вторая ОС, необходимо снять отметку с пункта Хранить время в BIOS по Гринвичу, иначе время в уже установленной ОС может отображаться некорректно.

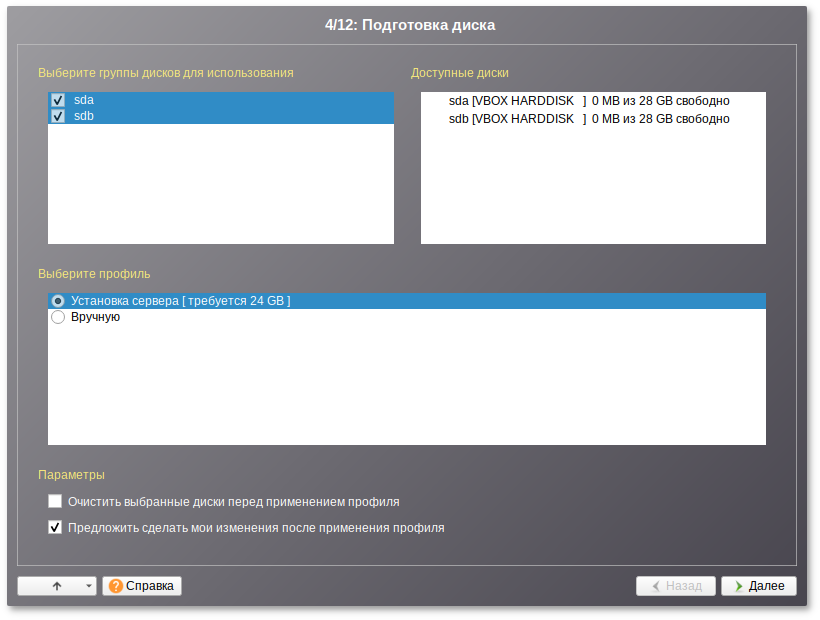

Глава 12. Подготовка диска

На этом этапе подготавливается площадка для установки Альт Сервер, в первую очередь — выделяется свободное место на диске.

Переход к этому шагу может занять некоторое время. Время ожидания зависит от производительности компьютера, объёма жёсткого диска, количества разделов на нём и других параметров.

12.1. Выбор профиля разбиения диска

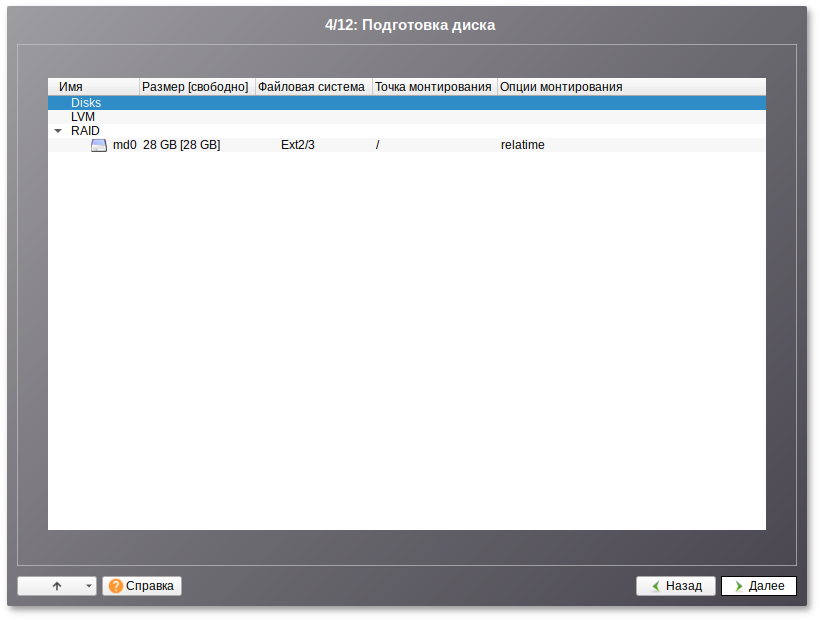

После завершения первичной конфигурации загрузочного носителя откроется окно Подготовка диска. В списке разделов перечислены уже существующие на жёстких дисках разделы (в том числе здесь могут оказаться съёмные flash-диски, подключённые к компьютеру в момент установки).

В списке

Выберите профиль перечислены доступные профили разбиения диска. Профиль — это шаблон распределения места на диске для установки ОС. Можно выбрать один из профилей:

установка сервера;

вручную.

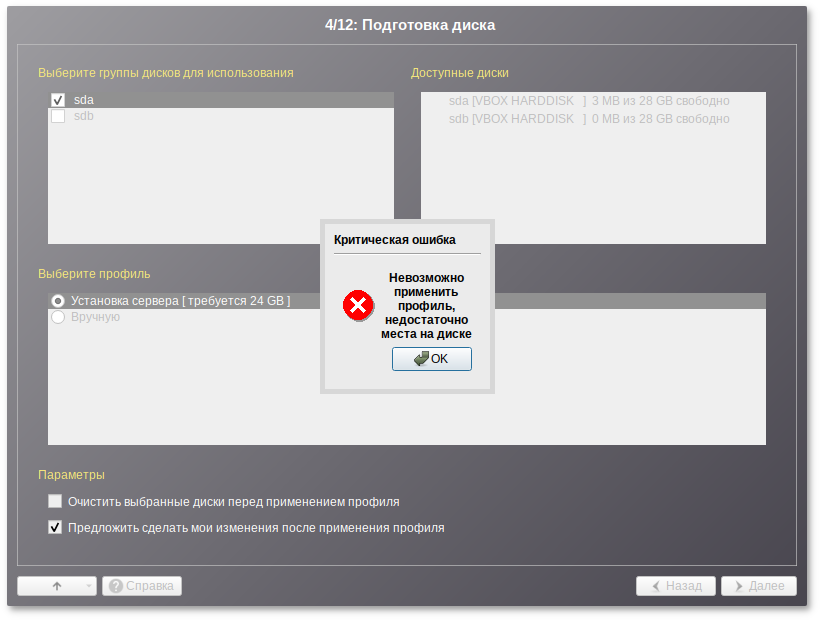

12.2. Автоматический профиль разбиения диска

Первый профиль предполагает автоматическое разбиение диска.

Если при применении профиля автоматического разбиения диска доступного места на диске окажется недостаточно, то на монитор будет выведено сообщение об ошибке:

Невозможно создать все разделы, недостаточно места на диске.

Для решения этой проблемы можно полностью очистить место на диске, отметив пункт Очистить все диски перед применением профиля и применить профиль повторно.

Если сообщение о недостатке места на диске появляется и при отмеченном пункте Очистить все диски перед применением профиля, то это связано с недостаточным для использования автоматических методов разметки объёмом всего диска. В этом случае вы можете воспользоваться методом ручной разметки: профиль Вручную.

При отмеченном пункте Очистить все диски перед применением профиля будут удалены все данные со всех дисков (включая внешние USB-носители) без возможности восстановления. Рекомендуется использовать эту возможность при полной уверенности в том, что диски не содержат никаких ценных данных.

12.3. Ручной профиль разбиения диска

При необходимости освободить часть дискового пространства следует воспользоваться профилем разбиения Вручную. В этом случае можно удалить некоторые из существующих разделов или содержащиеся в них файловые системы. После этого можно создать необходимые разделы самостоятельно или вернуться к шагу выбора профиля и применить автоматический профиль. Выбор этой возможности требует знаний об устройстве диска и технологиях его разметки.

По нажатию кнопки Далее будет произведена запись новой таблицы разделов на диск и форматирование разделов. Только что созданные на диске программой установки разделы пока не содержат данных и поэтому форматируются без предупреждения. Уже существовавшие, но изменённые разделы, которые будут отформатированы, помечаются специальным значком в колонке Файловая система слева от названия. При уверенности в том, что подготовка диска завершена, подтвердите переход к следующему шагу нажатием кнопки Далее.

Не следует форматировать разделы с теми данными, которые вы хотите сохранить, например, со старыми пользовательскими данными (/home) или с другими операционными системами. С другой стороны, отформатировать можно любой раздел, который вы хотите «очистить» (удалить все данные).

Не уменьшайте NTFS-раздел с установленной Microsoft Windows Vista/Windows 7 средствами программы установки. В противном случае вы не сможете загрузить Microsoft Windows Vista/Windows 7 после установки Альт Сервер. Для выделения места под установку Альт Сервер воспользуйтесь средствами, предоставляемыми самой Microsoft Windows Vista/Windows 7: Управление дисками → Сжать.

12.4. Дополнительные возможности разбиения диска

Ручной профиль разбиения диска позволяет установить ОС на программный RAID-массив, разместить разделы в томах LVM и использовать шифрование на разделах. Данные возможности требуют от пользователя понимания принципов функционирования указанных технологий.

12.4.1. Создание программного RAID-массива

Избыточный массив независимых дисков RAID (redundant array of independent disks) — технология виртуализации данных, которая объединяет несколько НЖМД в логический элемент для избыточности и повышения производительности.

Для создания программного RAID-массива потребуется минимум два жёстких диска.

Программа установки поддерживает создание программных RAID-массивов следующих типов:

RAID 1;

RAID 0;

RAID 4/5/6;

RAID 10.

Процесс подготовки к установке на RAID условно можно разбить на следующие шаги:

создание разделов на жёстких дисках;

создание RAID-массивов на разделах жёсткого диска;

создание файловых систем на RAID-массиве.

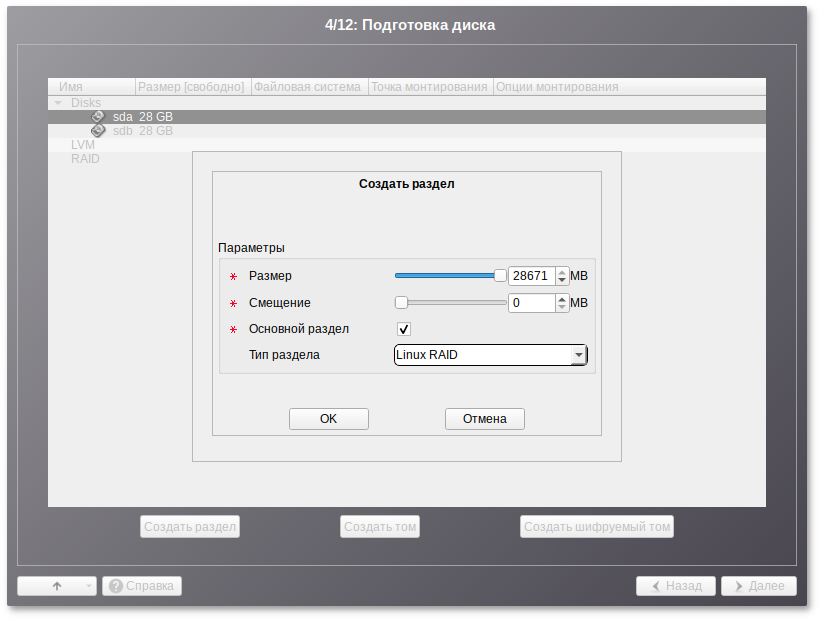

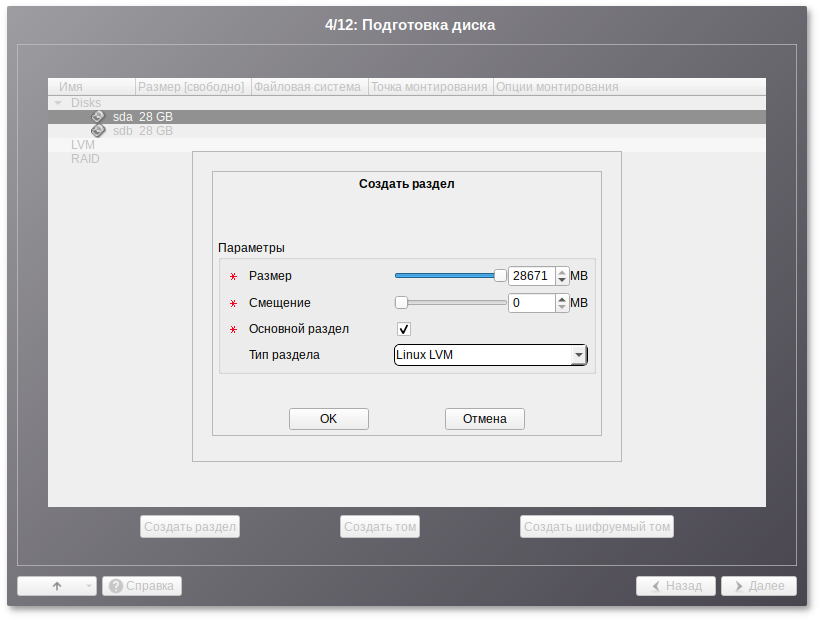

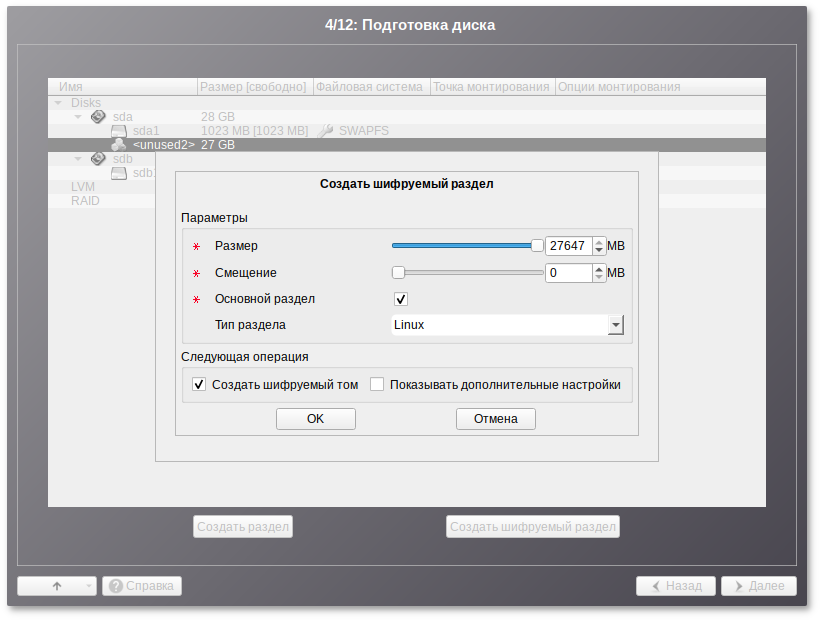

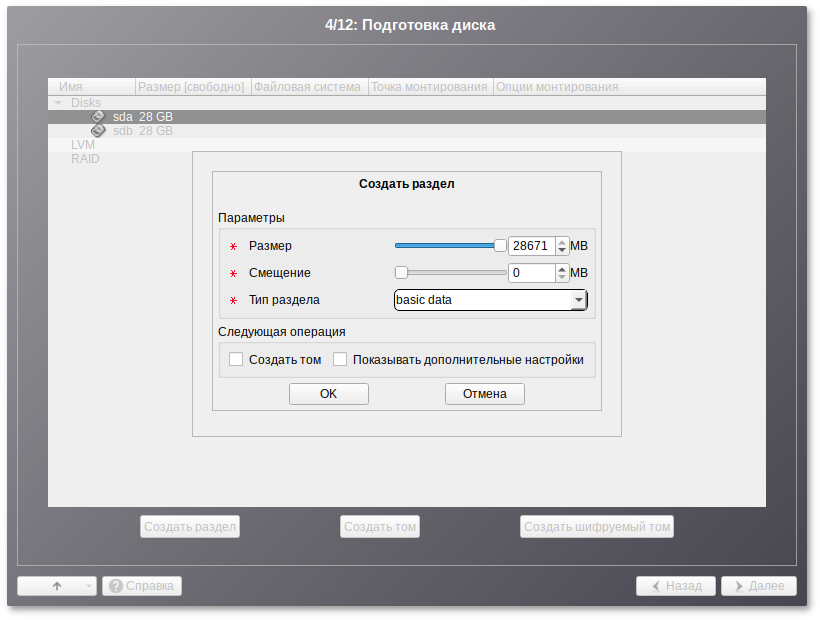

Для настройки параметров нового раздела из состава RAID-массива необходимо выбрать неразмеченный диск в окне профиля разбивки пространства Подготовить разделы вручную и нажать кнопку Создать раздел.

При создании разделов на жёстких дисках для последующего включения их в RAID-массивы следует указать Тип раздела для них равным :

В этом окне необходимо настроить следующие параметры:

Размер — в поле необходимо указать размер будущего раздела в Мбайт;

Смещение — в поле необходимо указать смещение начала данных на диске в Мбайт;

Основной раздел — необходимо отметить этот пункт, если раздел является основным для установки ОС;

Тип раздела — в выпадающем поле нужно выбрать значение для последующего включения раздела в RAID-массив.

При создании разделов следует учесть, что объём результирующего массива может зависеть от размера, включённых в него разделов жёсткого диска. Например, при создании RAID 1, результирующий размер массива будет равен размеру минимального участника.

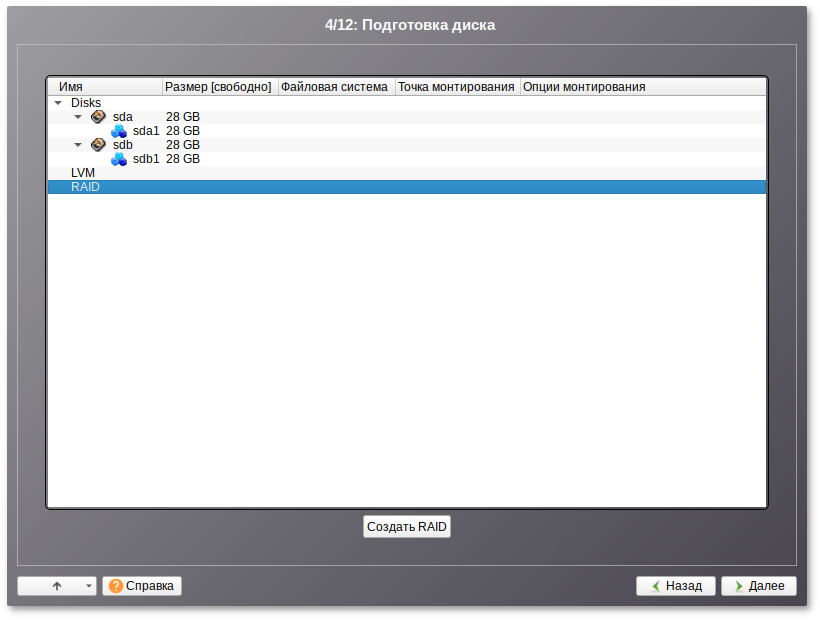

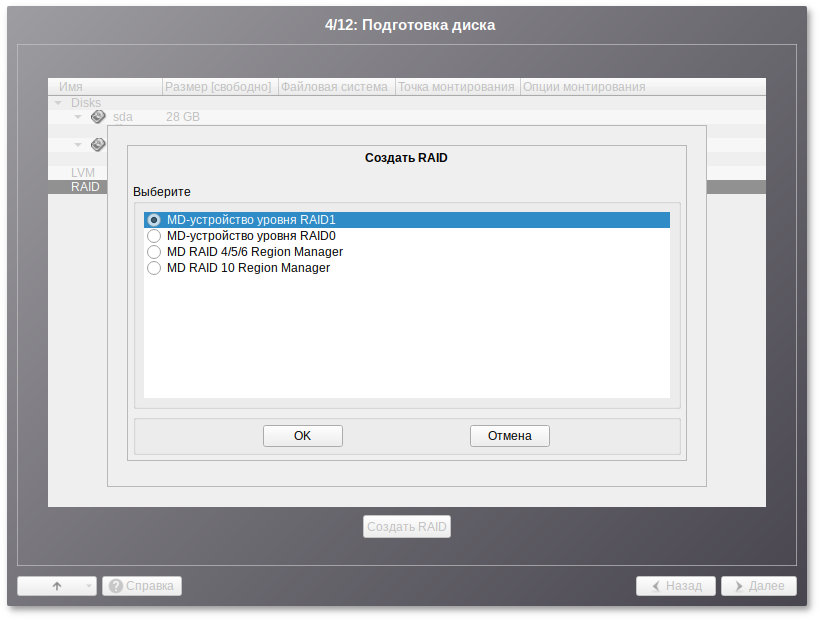

После создания разделов на дисках можно переходить к организации самих RAID-массивов. Для этого в списке следует выбрать пункт RAID, после чего нажать кнопку Создать RAID:

Далее мастер предложит выбрать тип массива:

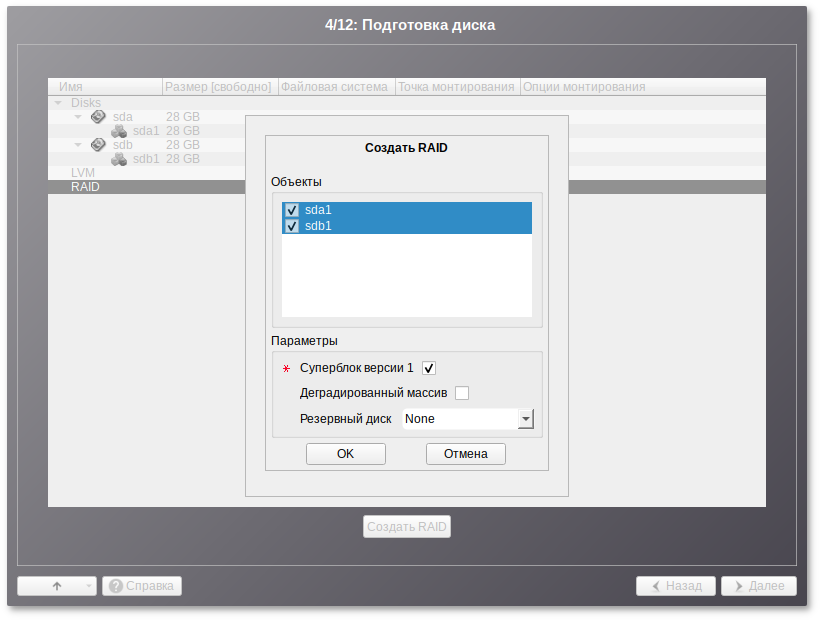

И указать участников RAID-массива:

После создания RAID-массивов их можно использовать как обычные разделы на жёстких дисках, то есть, на них можно создавать файловые системы или же, например, включать их в LVM-тома.

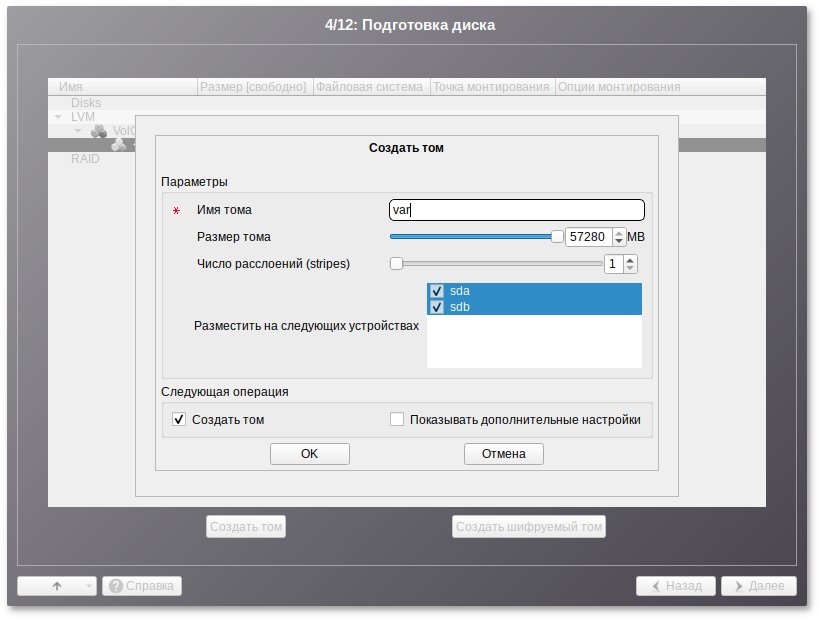

12.4.2. Создание LVM-томов

Менеджер логических дисков LVM (Logical Volume Manager) — средство гибкого управления дисковым пространством, позволяющее создавать поверх физических разделов (либо неразбитых дисков) логические тома, которые в самой системе будут видны как обычные блочные устройства с данными (обычные разделы).

Процесс подготовки к установке на LVM условно можно разбить на следующие шаги:

создание разделов на жёстких дисках;

создание группы томов LVM;

создание томов LVM;

создание файловых систем на томах LVM.

Для создания группы томов LVM может потребоваться предварительно удалить существующую таблицу разделов с жёсткого диска.

Для настройки параметров нового раздела необходимо выбрать неразмеченный диск в окне профиля разбивки пространства Подготовить разделы вручную и нажать кнопку Создать раздел. При создании разделов на жёстких дисках для последующего включения их в LVM-тома следует указать Тип раздела для них равным :

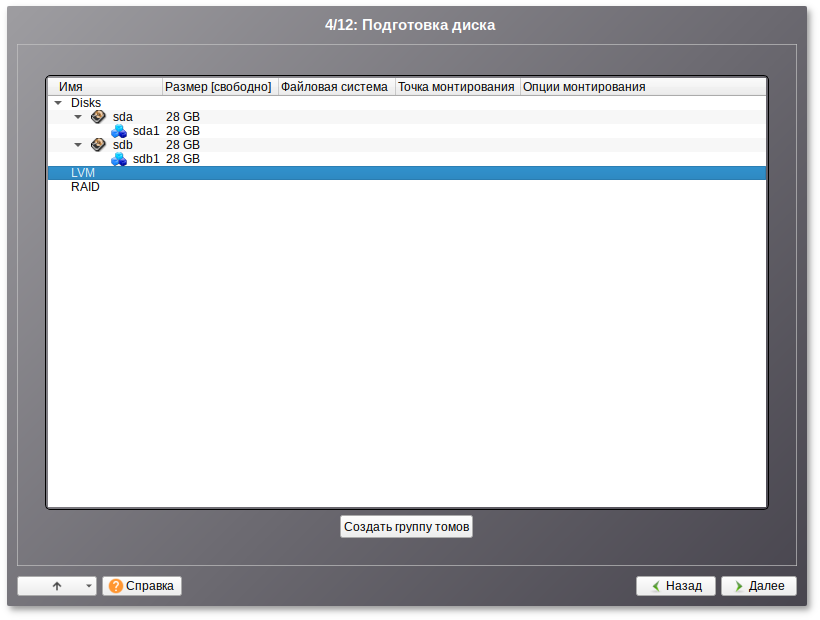

После создания разделов на дисках можно переходить к созданию группы томов LVM. Для этого в списке следует выбрать пункт LVM, после чего нажать кнопку Создать группу томов:

В открывшемся окне необходимо выбрать разделы, которые будут входить в группу томов, указать название группы томов и выбрать размер экстента:

Размер экстента представляет собой наименьший объем пространства, который может быть выделен тому. Размер экстента по умолчанию 65536 (65536*512 байт = 32 Мб, где 512 байт — размер сектора).

После создания группы томов LVM её можно использовать как обычный жёсткий диск, то есть внутри группы томов можно создавать тома (аналог раздела на физическом жёстком диске) и файловые системы внутри томов.

12.4.3. Создание шифрованных разделов

Программа установки Альт Сервер позволяет создавать шифрованные разделы.

Процесс создания шифрованного раздела ничем не отличается от процесса создания обычного раздела и инициируется нажатием на кнопку Создать шифруемый раздел.

После создания шифрованного раздела мастер, как и при создании обычного раздела, предложит создать на нём файловую систему и при необходимости потребует указать точку монтирования.

Установка загрузчика на шифрованный раздел не поддерживается.

Для сохранения всех внесенных настроек и продолжения установки в окне Подготовка диска нужно нажать кнопку Далее.

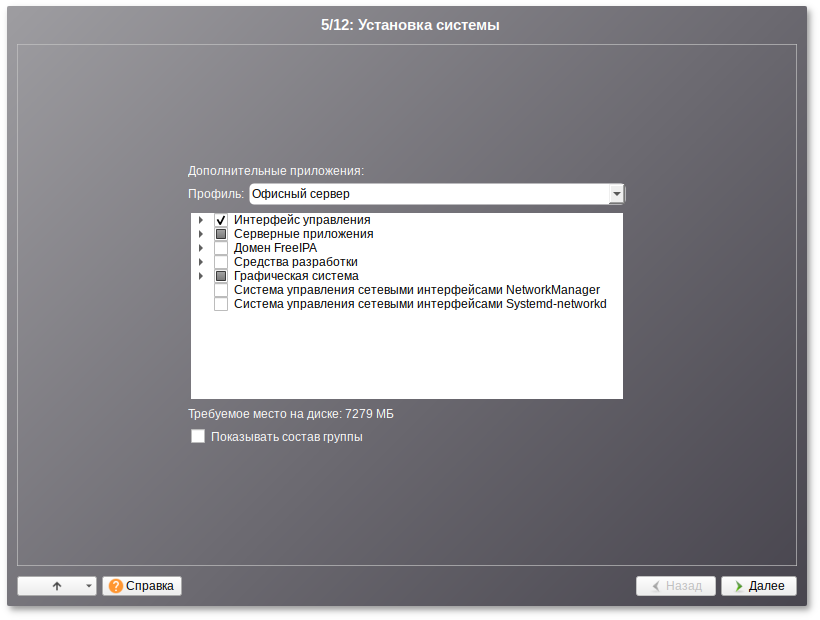

Глава 13. Установка системы

На данном этапе происходит распаковка ядра и установка набора программ, необходимых для работы Альт Сервер.

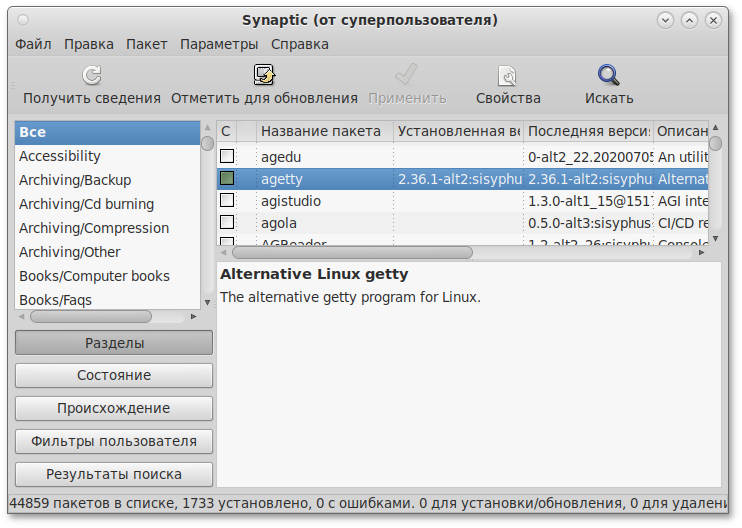

Программа установки предлагает выбрать дополнительные пакеты программ, которые будут включены в состав Альт Сервер и установлены вместе с ней на диск.

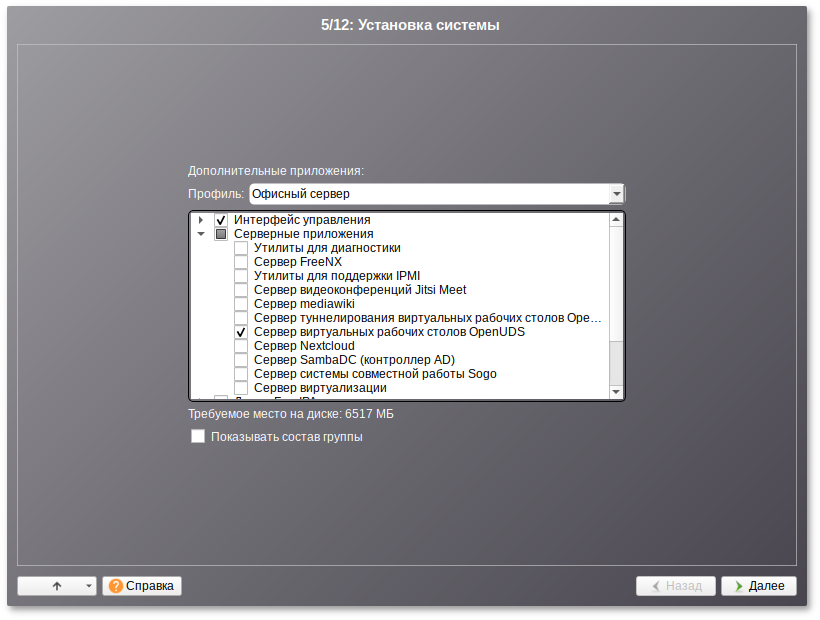

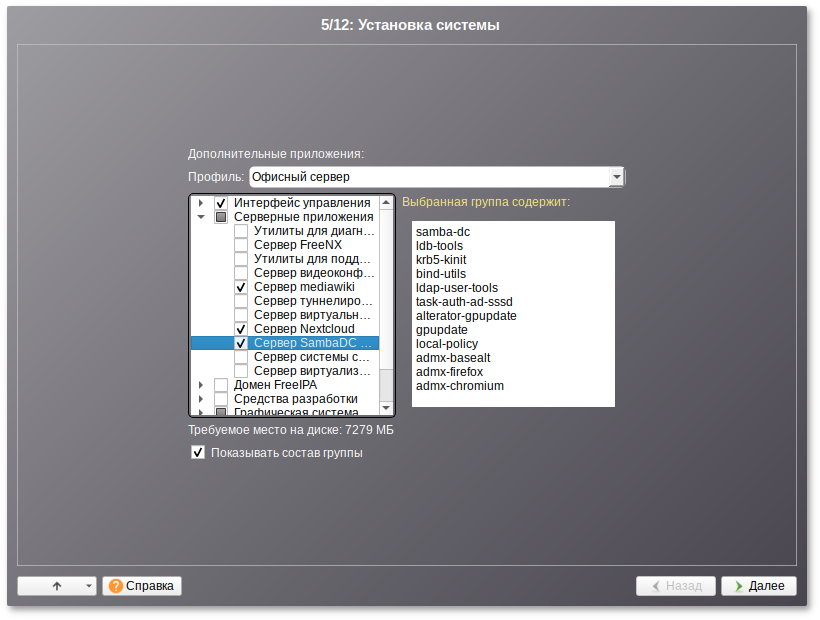

13.1. Дополнительные приложения

В дистрибутиве Альт Сервер доступно значительное количество программ (до нескольких тысяч), часть из них составляет саму операционную систему, а остальные — это прикладные программы и утилиты.

В Альт Сервер все операции установки и удаления производятся над пакетами — отдельными компонентами системы. Пакет и программа соотносятся неоднозначно: иногда одна программа состоит из нескольких пакетов, иногда один пакет включает несколько программ.

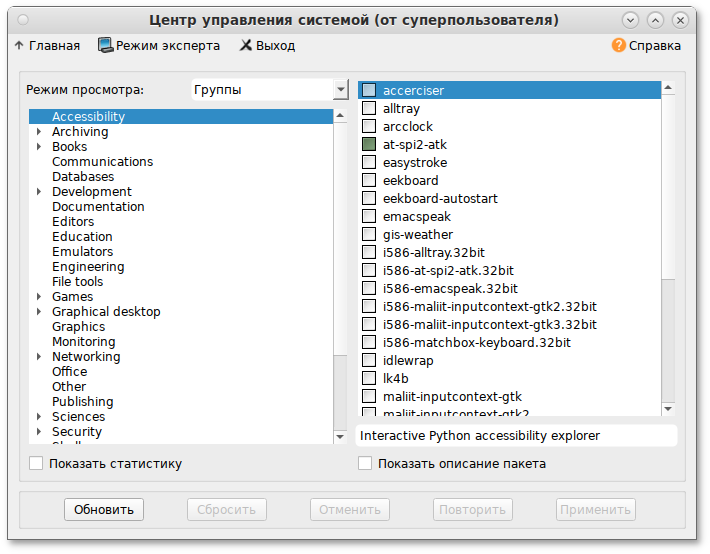

В процессе установки системы обычно не требуется детализированный выбор компонентов на уровне пакетов — это требует слишком много времени и знаний от проводящего установку. Тем более, что комплектация дистрибутива подбирается таким образом, чтобы из имеющихся программ можно было составить полноценную рабочую среду для соответствующей аудитории пользователей. Поэтому, в процессе установки системы пользователю предлагается выбрать из небольшого списка групп пакетов, объединяющих пакеты, необходимые для решения наиболее распространённых задач. Под списком групп на экране отображается информация об объёме дискового пространства, которое будет занято после установки пакетов, входящих в выбранные группы.

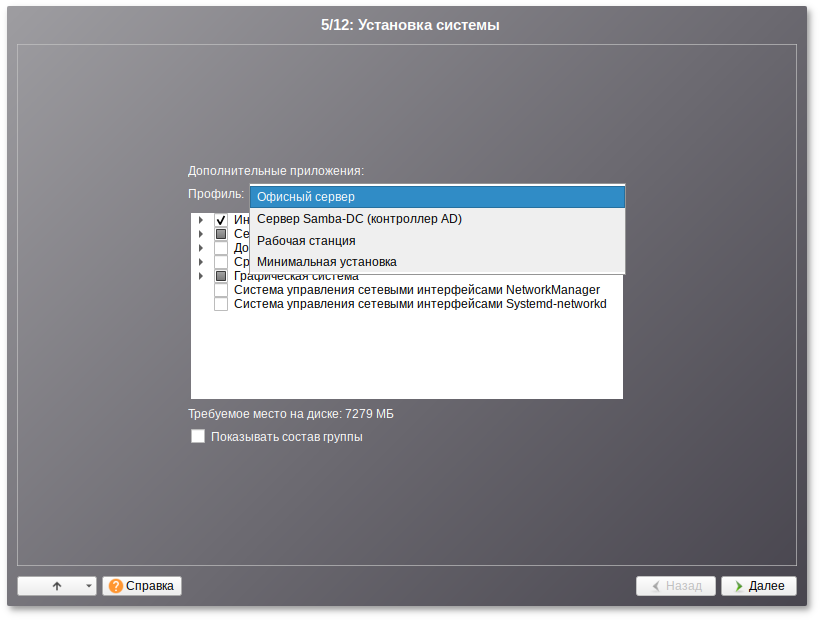

При установке сервера доступны следующие профили:

Офисный сервер – для установки будут предложены группы пакетов с серверными приложениями;

Сервер Samba-DC (контроллер AD) – для установки будут предложена группа пакетов для конфигурации сервера в качестве контроллера AD;

Рабочая станция – серверные приложения в состав устанавливаемых пакетов включаться не будут;

Минимальная установка – дополнительное ПО в состав устанавливаемых пакетов включаться не будет.

После выбора профиля можно изменить состав устанавливаемых пакетов.

Под списком групп на экране отображается информация об объёме дискового пространства, которое будет занято после установки пакетов, входящих в выбранные группы.

Опция Показать состав группы выводит список программных пакетов, входящих в состав той или иной группы пакетов.

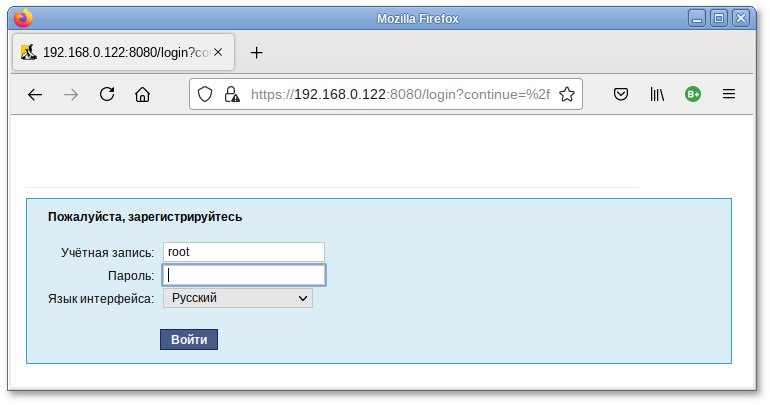

При установке серверных приложений (Сервер mediawiki и Сервер Nextcloud) после загрузки доступны службы Mediawiki 1.36 и Nextcloud 20. Для доступа, к административным функциям этих приложений через веб-интерфейс необходимо сменить пароль администратора в «Центре управления системой» (пароль должен быть достаточно сложным и содержать не менее 10 символов).

MediaWiki установленная при установке системы доступна по адресу https://localhost/wiki/. Администратор: WikiSysop, пароль: пароль пользователя root.

Веб-приложение Nextcloud установленное при установке системы доступно по адресу https://localhost/nextcloud/. Администратор: root, пароль: пароль пользователя root.

Выбрав необходимые группы, следует нажать кнопку Далее, после чего начнётся установка пакетов.

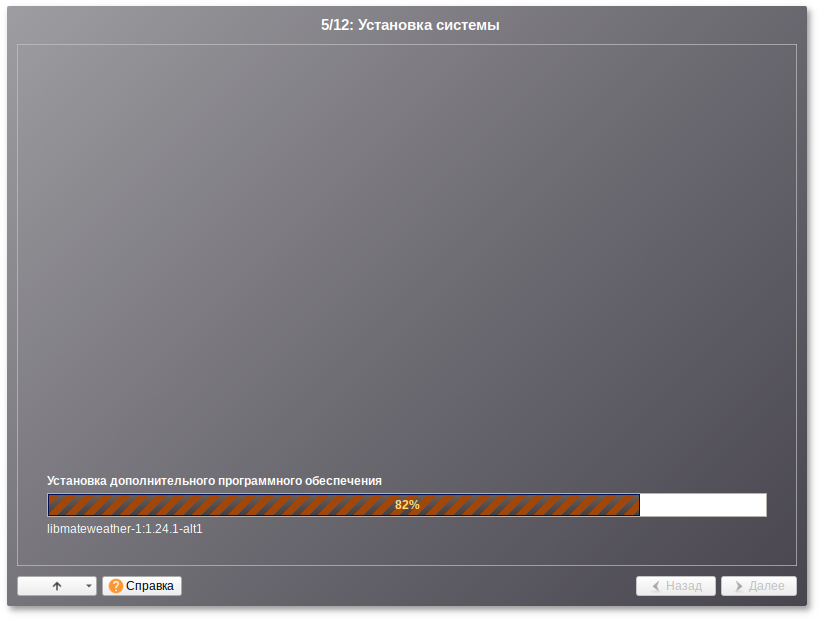

На этом этапе происходит установка набора программ, необходимых для работы системы.

Установка происходит автоматически в два этапа:

получение пакетов;

установка пакетов.

Получение пакетов осуществляется из источника, выбранного на этапе начальной загрузки. При сетевой установке (по протоколу FTP или HTTP) время выполнения этого шага будет зависеть от скорости соединения и может быть значительно большим в сравнении с установкой с лазерного диска.

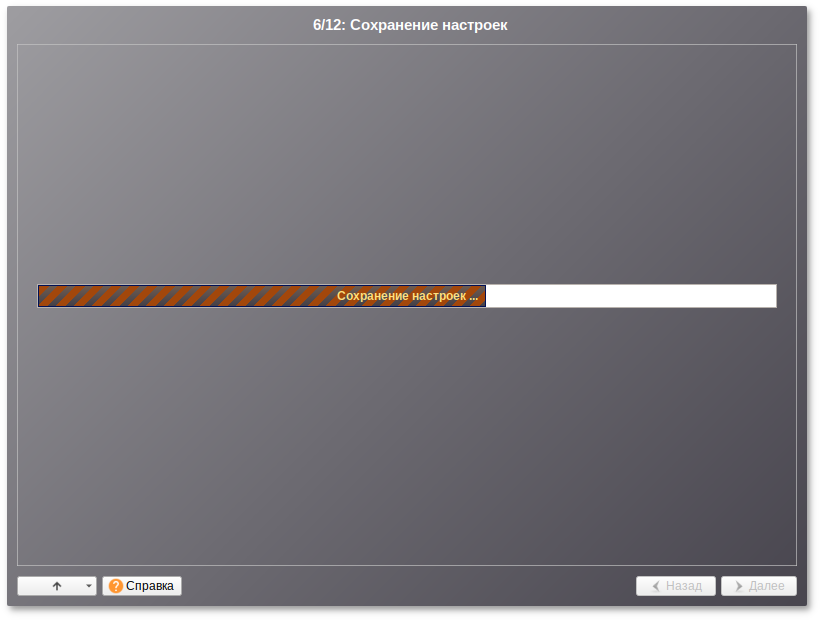

Глава 14. Сохранение настроек

Начиная с данного этапа, программа установки работает с файлами только что установленной базовой системы. Все последующие изменения можно будет совершить после завершения установки посредством редактирования соответствующих конфигурационных файлов или при помощи модулей управления, включенных в дистрибутив.

По завершении установки базовой системы начинается шаг сохранения настроек. Он проходит автоматически и не требует вмешательства пользователя. На экране отображается индикатор выполнения.

На этом шаге производится перенос настроек, выполненных на первых шагах установки, в только что установленную базовую систему. Также производится запись информации о соответствии разделов жесткого диска смонтированным на них файловым системам (заполняется конфигурационный файл /etc/fstab).

После сохранения настроек осуществляется автоматический переход к следующему шагу.

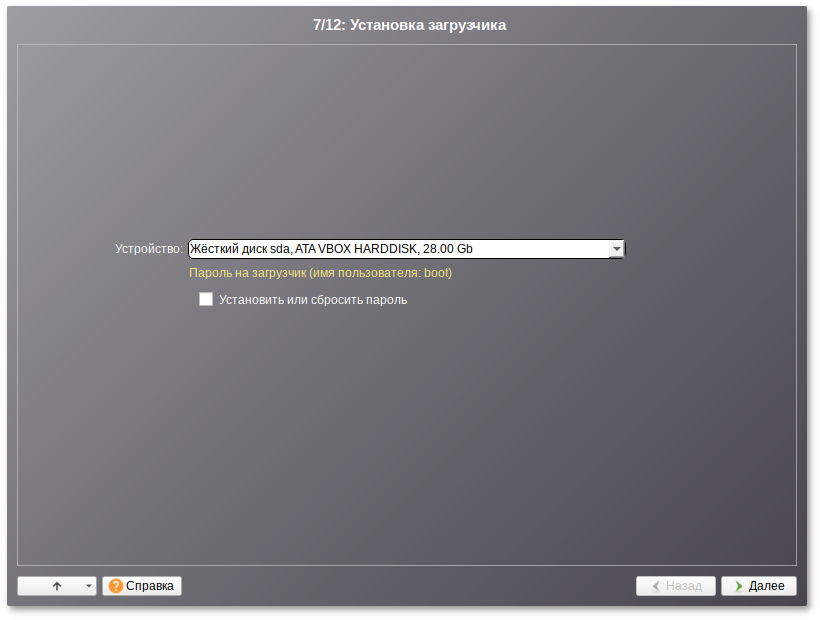

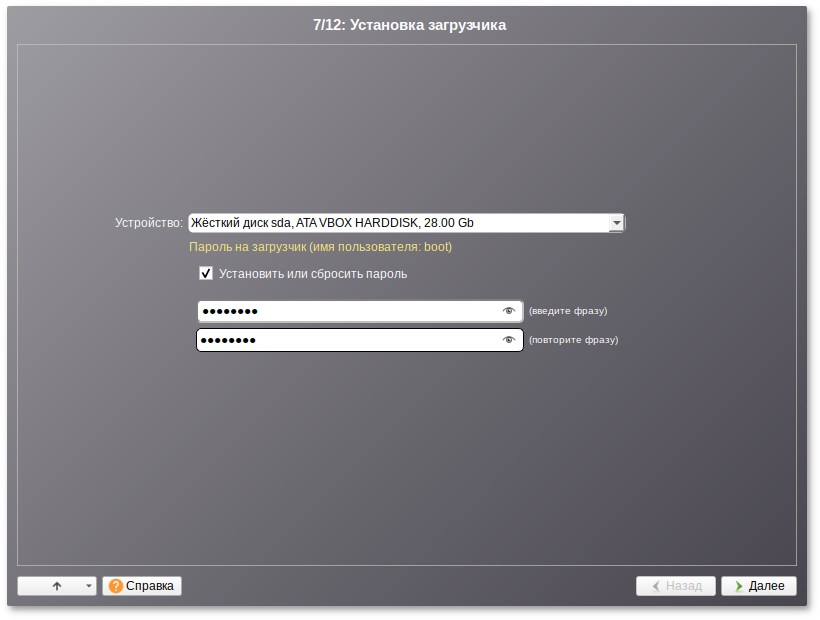

Глава 15. Установка загрузчика

Загрузчик ОС — это программа, которая позволяет загружать Альт Сервер и другие ОС, если они установлены на данной машине.

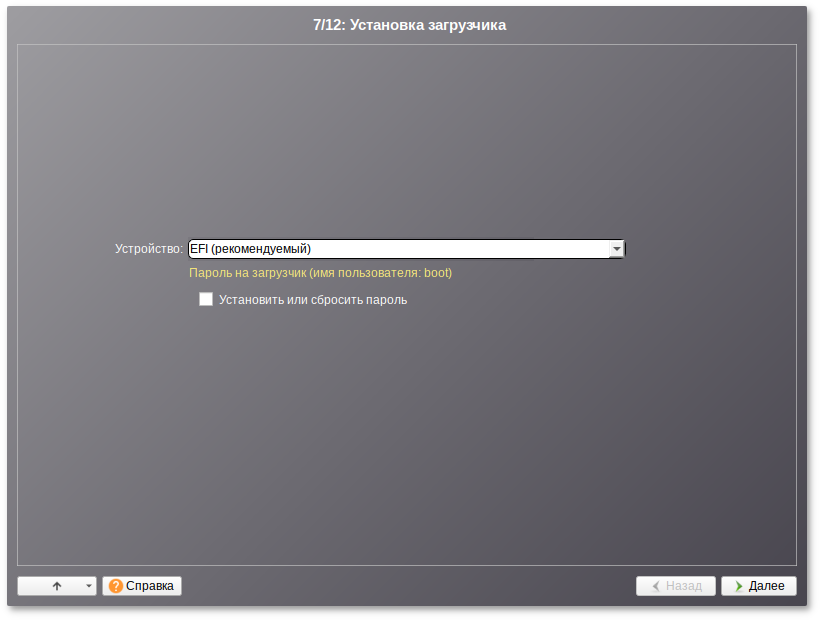

Программа установки автоматически определяет, в каком разделе НЖМД следует располагать загрузчик для возможности корректного запуска ОС Альт Сервер. Положение загрузчика, в случае необходимости, можно изменить в выпадающем списке Устройство, выбрав другой раздел.

Если же вы планируете использовать и другие ОС, уже установленные на этом компьютере, тогда имеет значение на каком жёстком диске или в каком разделе будет расположен загрузчик.

Для ограничения доступа к опциям загрузки можно установить пароль на загрузчик. Для этого необходимо отметить пункт Установить или сбросить пароль и, в появившихся полях для ввода, задать пароль.

При необходимости изменения опций загрузки при старте компьютера потребуется ввести имя пользователя «boot» и заданный на этом шаге пароль.

При установке на

EFI выберите в качестве устройства для установки «». Рекомендуется выбрать автоматическое разбиение на этапе разметки диска для создания необходимых разделов для загрузки с

EFI.

Для подтверждения выбора и продолжения работы программы установки необходимо нажать кнопку Далее.

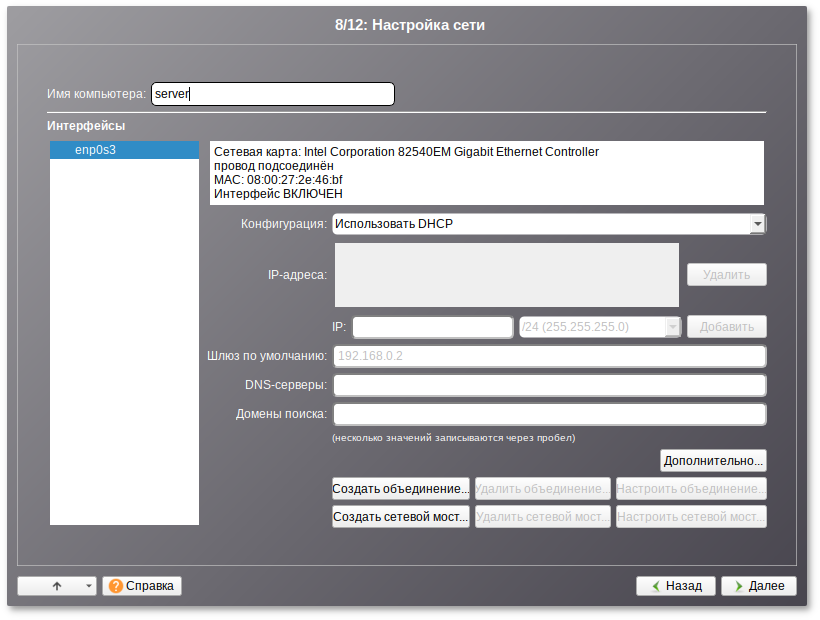

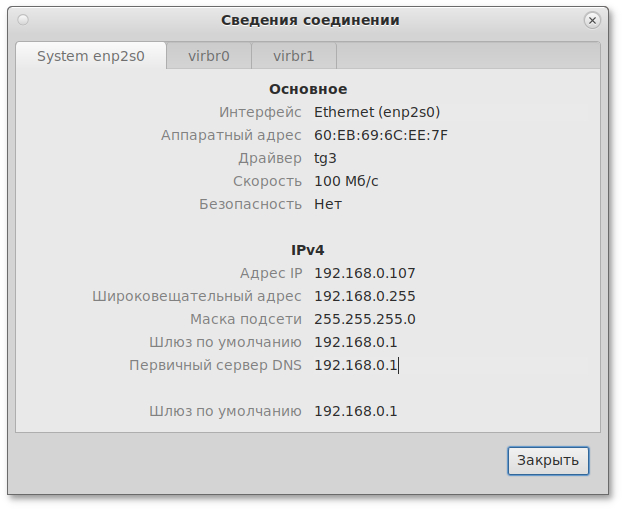

Глава 16. Настройка сети

На этом этапе необходимо задать параметры работы сетевой карты и настройки сети: IP-адреса сетевых интерфейсов, DNS-сервер, шлюз и т.п. Конкретные значения будут зависеть от используемого вами сетевого окружения. Ручного введения настроек можно избежать при наличии в сети настроенного DHCP-сервера. В этом случае все необходимые сетевые настройки будут получены автоматически.

Для сохранения настроек сети и продолжения работы программы установки необходимо нажать кнопку Далее.

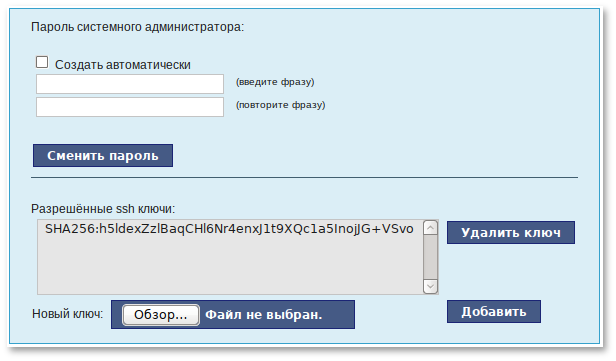

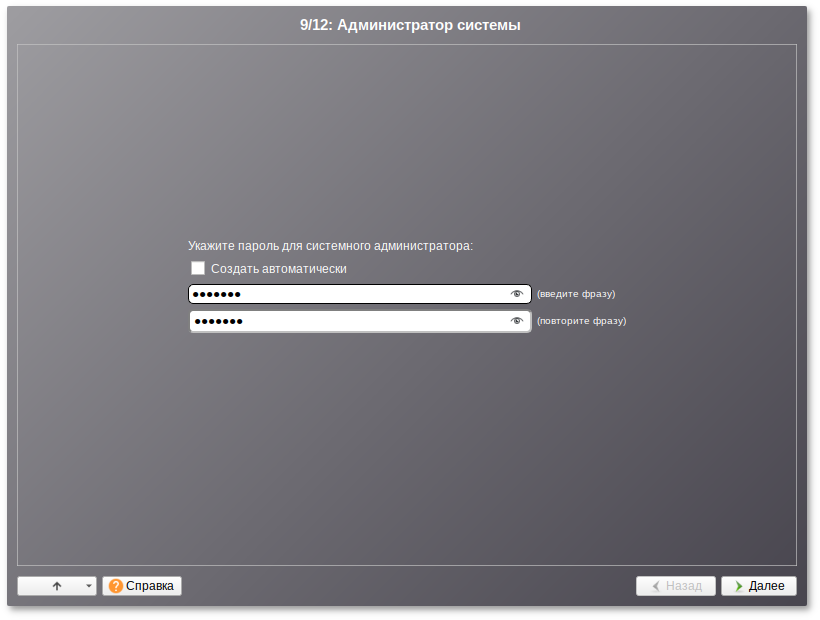

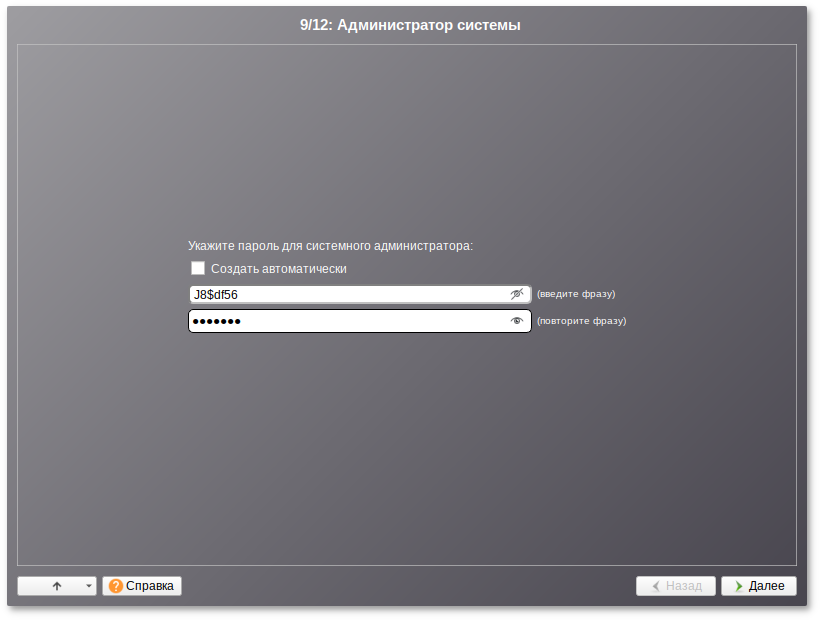

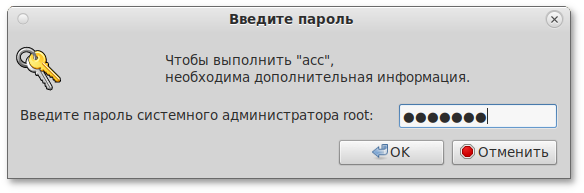

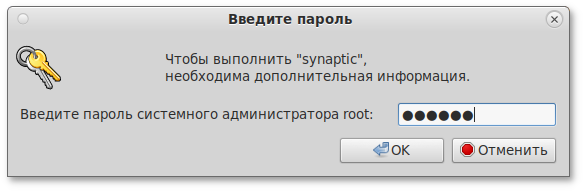

Глава 17. Администратор системы

На данном этапе загрузчик создает учетную запись администратора. В открывшемся окне необходимо ввести пароль учетной записи администратора (root). Чтобы исключить опечатки при вводе пароля, пароль учетной записи вводится дважды.

Чтобы избежать последствий неверной раскладки клавиатуры можно просмотреть пароль, который будет сохранен. Для этого нажмите на значок стрелки в поле ввода:

Для автоматической генерации пароля необходимо отметить пункт Создать автоматически. Система предложит пароль, сгенерированный автоматическим образом в соответствии с требованиями по стойкости паролей.

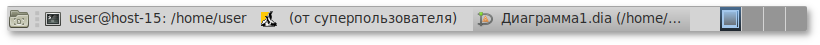

В любой системе Linux всегда присутствует один специальный пользователь — администратор системы, он же суперпользователь. Для него зарезервировано стандартное системное имя — root.

Администратор системы отличается от всех прочих пользователей тем, что ему позволено производить любые, в том числе самые разрушительные изменения в системе. Поэтому выбор пароля администратора системы — очень важный момент для безопасности. Любой, кто сможет ввести его правильно (узнать или подобрать), получит неограниченный доступ к системе. Даже ваши собственные неосторожные действия от имени root могут иметь катастрофические последствия для всей системы.

Стоит запомнить пароль root — его нужно будет вводить для получения права изменять настройки системы с помощью стандартных средств настройки Альт Сервер. Более подробную информацию о режиме суперпользователя вы можете прочитать в главе

Режим суперпользователя.

Подтверждение введенного (или сгенерированного) пароля учетной записи администратора (root) и продолжение работы программы установки выполняется нажатием кнопки Далее.

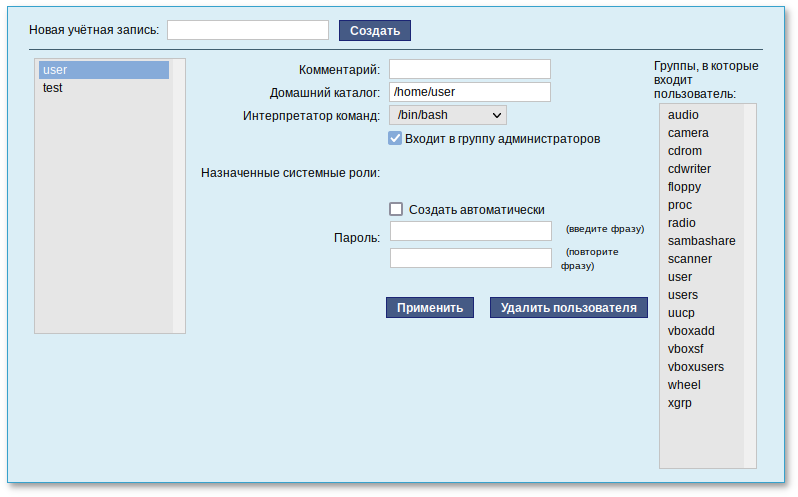

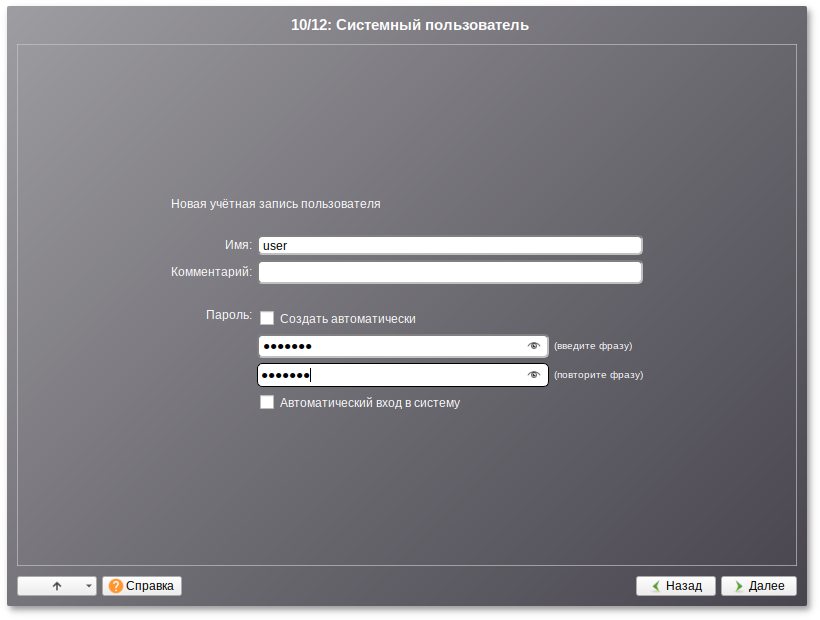

Глава 18. Системный пользователь

На данном этапе программа установки создает учетную запись системного пользователя (пользователя) Альт Сервер.

Помимо администратора (root) в систему необходимо добавить, по меньшей мере, одного обычного системного пользователя. Работа от имени администратора системы считается опасной, поэтому повседневную работу в Linux следует выполнять от имени ограниченного в полномочиях системного пользователя.

При добавлении системного пользователя предлагается ввести имя учётной записи пользователя. Имя учётной записи всегда представляет собой одно слово, состоящее только из строчных латинских букв (заглавные запрещены), цифр и символа подчёркивания «_» (причём цифра и символ «_» не могут стоять в начале слова).

Для того чтобы исключить опечатки, пароль пользователя вводится дважды. Пароль пользователя можно создать автоматически, по аналогии с автоматическим созданием пароля суперпользователя.

Для автоматической генерации пароля необходимо отметить пункт Создать автоматически. Система предложит пароль, сгенерированный автоматическим образом в соответствии с требованиями по стойкости паролей.

В процессе установки предлагается создать только одну учётную запись системного пользователя — от его имени можно выполнять задачи, не требующие привилегий суперпользователя. Учётные записи для всех прочих пользователей системы можно будет создать в любой момент после установки операционной системы.

Подтверждение введенного (или сгенерированного) пароля учетной записи системного пользователя и продолжение работы программы установки выполняется нажатием кнопки Далее.

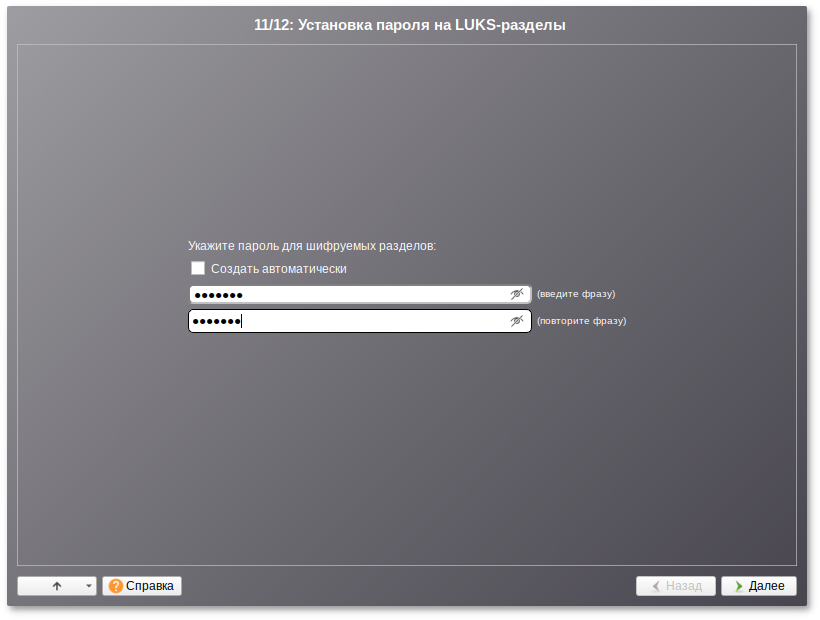

Глава 19. Установка пароля на шифрованные разделы

Если вы не создавали шифруемые разделы, то этот шаг пропускается автоматически. В этом случае сразу переходите к главе

Завершение установки.

На этом этапе требуется ввести пароль для шифруемых разделов. Этот пароль потребуется вводить для того, чтобы получать доступ к информации на данных разделах.

Например, если вы зашифровали /home, то во время загрузки системы будет необходимо ввести пароль для этого раздела, иначе вы не сможете получить доступ в систему под своим именем пользователя.

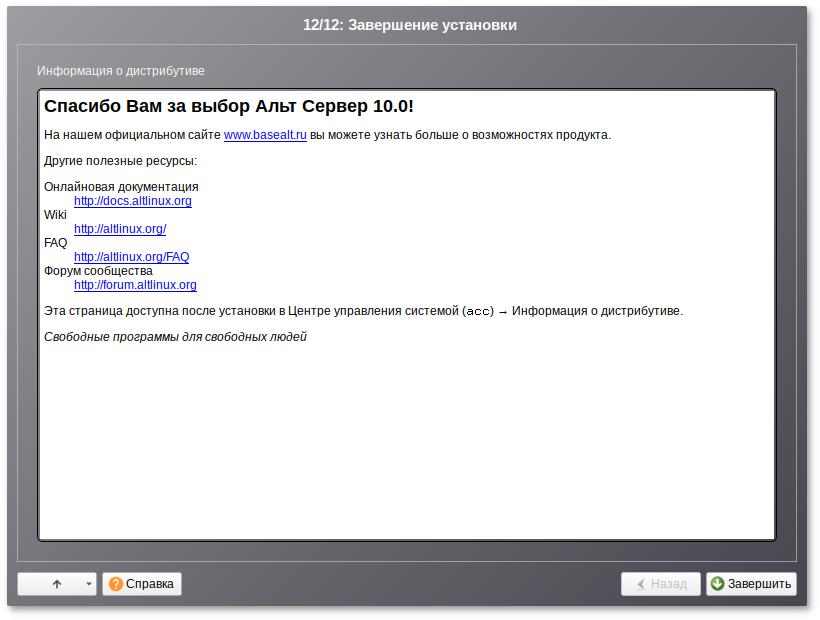

Глава 20. Завершение установки

На экране последнего шага установки отображается информация о завершении установки Альт Сервер.

После нажатия кнопки Завершить автоматически начнется перезагрузка системы.

Не забудьте извлечь установочный DVD (если это не происходит автоматически). Далее можно загружать установленную систему в обычном режиме.

Глава 21. Особенности установки в UEFI-режиме

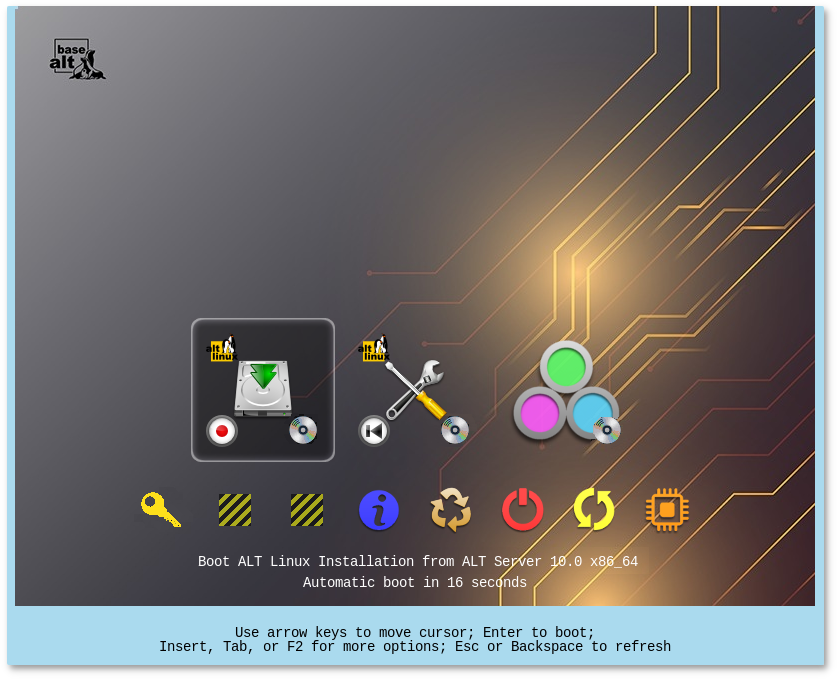

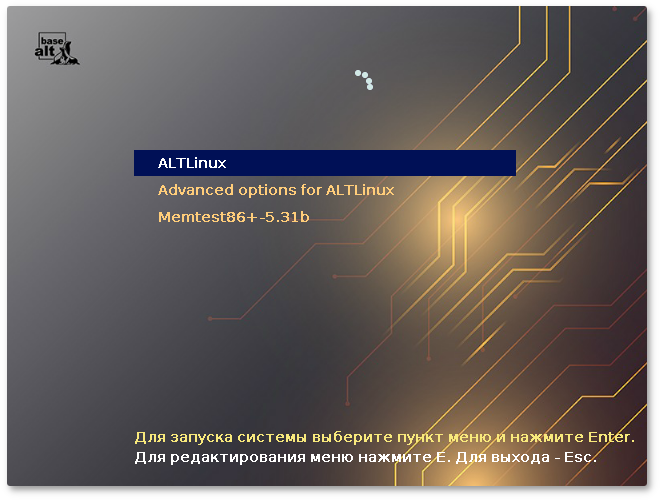

21.1. Начальный загрузчик EFI

После загрузки компьютера с установочного диска выводится меню, в котором можно выбрать варианты загрузки системы. Начальный загрузчик EFI не похож на обычный. Меню загрузчика горизонтальное, графическое:

Мышь на этом этапе установки не поддерживается. Для выбора опций установки и различных вариантов необходимо использовать клавиатуру.

В нижней части экрана отображаются подсказки по использованию клавиатуры:

для перемещения курсора необходимо использовать клавиши со стрелками;

нажатие клавиши Enter приводит к активированию выбранного пункта меню;

по нажатию клавиши F2 открывается меню доступных параметров, каждого пункта. Например, при установке системы можно выбрать язык интерфейса загрузчика и программы установки:

Особенности разбиения диска:

для того, чтобы система правильно работала (в частности могла загрузиться) с UEFI, при ручном разбиении диска надо обязательно сделать точку монтирования /boot/efi, в которую нужно смонтировать vfat раздел с загрузочными записями. Если такого раздела нет, то его надо создать вручную. При разбивке жёсткого диска в автоматическом режиме такой раздел создаёт сам установщик;

требуется создать новый или подключить существующий FAT32-раздел с GPT-типом ESP (efi system partition) размером ~100—500 Мб (будет смонтирован в /boot/efi);

может понадобиться раздел типа bios boot partition минимального размера, никуда не подключенный и предназначенный для встраивания grub2-efi;

остальные разделы — и файловая система, и swap — имеют GPT-тип basic data; актуальный тип раздела задаётся отдельно.

Ручной профиль разбиения диска позволяет установить ОС на программный RAID-массив, разместить разделы в томах LVM и использовать шифрование на разделах.

Для создания программного массива на GPT-разделах, следует сначала создать разделы типа basic data и не создавать на них том (снять отметку с пункта Создать том):

Затем можно переходить к организации самих RAID-массивов, для этого в списке необходимо выбрать пункт RAID, после чего нажать кнопку Создать RAID.

21.3. Установка загрузчика

Программа установки автоматически определяет, в каком разделе следует располагать загрузчик. Модуль установки загрузчика предложит установить загрузчик в специальный раздел EFI.

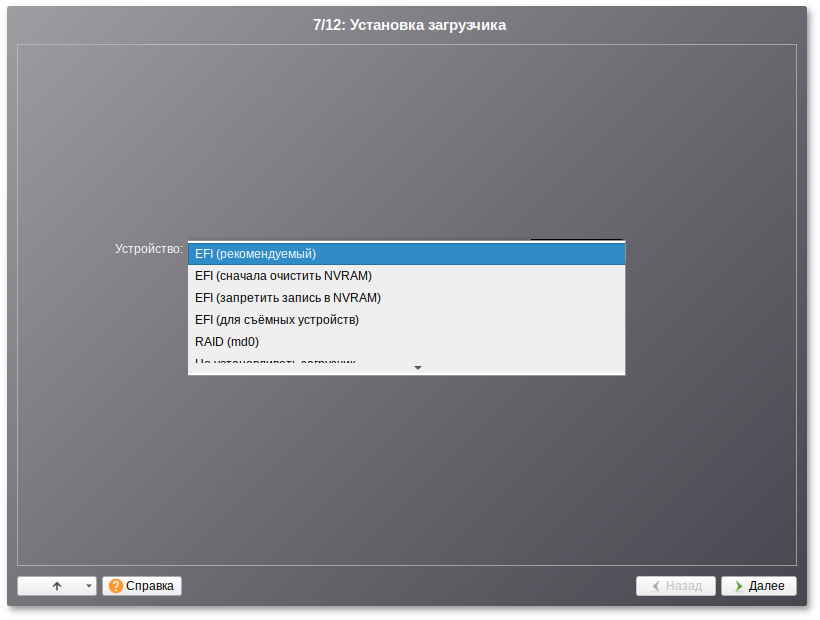

Варианты установки загрузчика при установке в режиме UEFI:

— при установке загрузчика, в NVRAM будет добавлена запись, без которой большинство компьютеров не смогут загрузиться во вновь установленную ОС;

— перед добавлением записи в NVRAM, её содержимое будет сохранено в /root/.install-log, после чего из неё будут удалены все загрузочные записи, что приведёт к восстановлению полностью заполненной NVRAM и гарантирует загрузку вновь установленной ОС;

— этот вариант следует выбрать только, если инсталлятор не может создать запись в NVRAM или если заведомо известно, что запись в NVRAM может вывести компьютер из строя (вероятно, запись в NVRAM придётся создать после установки ОС средствами BIOS Setup);

— этот вариант следует выбрать только, если ОС устанавливается на съёмный накопитель. Также этот вариант можно использовать вместо варианта при условии, что это будет единственная ОС на данном накопителе. Создавать запись в NVRAM не потребуется.

Выбор варианта установки загрузчика, зависит от вашего оборудования. Если не работает один вариант, попробуйте другие.

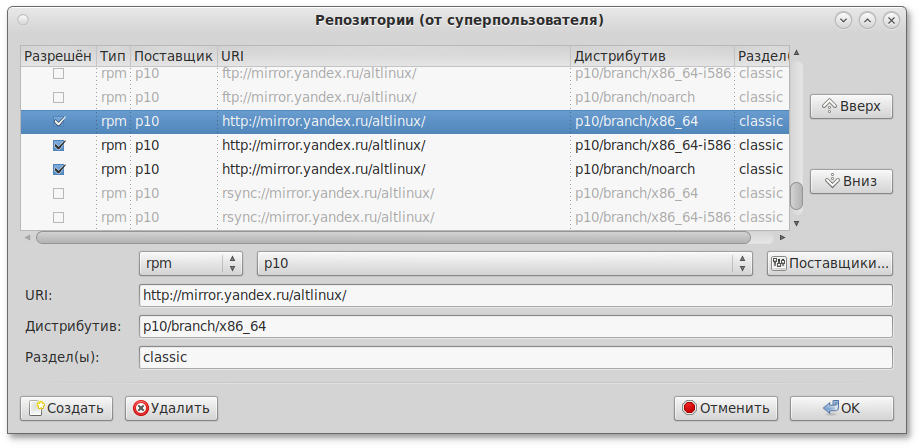

Глава 22. Обновление системы до актуального состояния

После установки системы, её лучше сразу обновить до актуального состояния. Можно не обновлять систему и сразу приступать к работе только в том случае, если вы не планируете подключаться к сети или Интернету, не собираетесь устанавливать дополнительных программ.

Для обновления системы необходимо выполнить команды (с правами администратора):

# apt-get update

# apt-get dist-upgrade

# update-kernel

# apt-get clean

# reboot

Получить права администратора можно, выполнив в терминале команду:

$ su -

или зарегистрировавшись в системе (например, на второй консоли

Ctrl+

Alt+

F2) под именем

root. Про режим суперпользователя можно почитать в главе

Режим суперпользователя.

В случае возникновения каких-либо неприятностей не паникуйте, а спокойно разберитесь в сложившейся ситуации. Linux не так уж просто довести до полной неработоспособности и утраты ценных данных. Поспешные действия отчаявшегося пользователя могут привести к плачевным результатам. Помните, что решение есть, и оно обязательно найдётся!

23.1. Проблемы при установке системы

Если в системе не произошла настройка какого-либо компонента после стадии установки пакетов, не отчаивайтесь, доведите установку до конца, загрузитесь в систему и попытайтесь в спокойной обстановке повторить настройку.

В случае возникновения проблем с установкой, вы можете вручную задать необходимые параметры в строке

Параметры загрузки меню начального загрузчика:

xdriver — графический установщик предпринимает попытку автоматического подбора драйвера видеокарты, но иногда это ему не удаётся. Данным параметром можно отключить «искусственный интеллект» и явно указать нужный вариант драйвера;

instdebug — если будет присутствовать этот параметр, то перед запуском и после завершения работы графического установщика будет запущена оболочка shell. Это очень полезное средство для выявления причин отсутствия запуска графической части программы установки. Последовательность работы внутренних сценариев следующая: install2 → xinit → alterator-install2 → alterator-wizard. При необходимости можно вручную загрузить Xorg (команда xinit) и в открывшемся окне терминала запустить alterator-install2 (или alterator-wizard) вручную.

Если вы вообще не смогли установить систему (не произошла или не завершилась стадия установки пакетов), то сначала попробуйте повторить попытку в режиме . В безопасном режиме отключаются все параметры ядра, (apm=off acpi=off mce=off barrier=off vga=normal) которые могут вызвать проблемы при загрузке. В этом режиме установка будет произведена без поддержки APIC. Возможно, у вас какое-то новое или нестандартное оборудование, но может оказаться, что оно отлично настраивается со старыми драйверами.

Если вы хотите получить точный ответ, то сообщите, пожалуйста, подробный состав вашего оборудования и подробное описание возникшей проблемы.

23.2. Проблемы с загрузкой системы

Если не загружается ни одна из установленных операционных систем, то значит, есть проблема в начальном загрузчике. Такие проблемы могут возникнуть после установки системы, в случае если загрузчик все-таки не установлен или установлен с ошибкой. При установке или переустановке Windows на вашем компьютере загрузчик Linux будет перезаписан в принудительном порядке, и станет невозможно запускать Linux.

Повреждение или перезапись загрузчика никак не затрагивает остальные данные на жёстком диске, поэтому в такой ситуации очень легко вернуть работоспособность: для этого достаточно восстановить загрузчик.

Если у вас исчез загрузчик другой операционной системы или другого производителя, то внимательно почитайте соответствующее официальное руководство на предмет его восстановления. Но в большинстве случаев вам это не потребуется, так как загрузчик, входящий в состав Альт Сервер, поддерживает загрузку большинства известных операционных систем.

Для восстановления загрузчика достаточно любым доступным способом загрузить Linux и получить доступ к тому жёсткому диску, на котором находится повреждённый загрузчик. Для этого проще всего воспользоваться восстановительным режимом, который предусмотрен на установочном диске дистрибутива (пункт ).

Загрузка восстановительного режима заканчивается приглашением командной строки: [root@localhost /]#. Начиная с этого момента, система готова к вводу команд.

В большинстве случаев для восстановления загрузчика можно просто воспользоваться командой fixmbr без параметров. Программа попытается переустановить загрузчик в автоматическом режиме.

Часть III. Начало использования Альт Сервер

В этой части рассматривается загрузка установленной операционной системы и вход в среду рабочего стола.

Глава 24. Загрузка системы

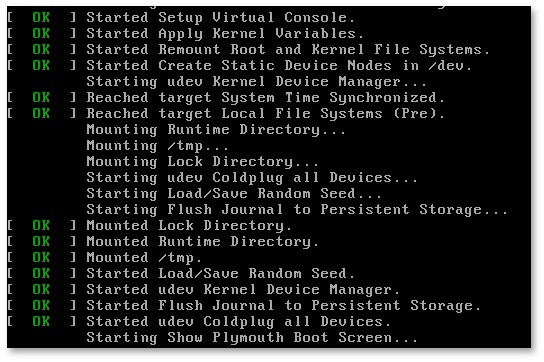

Запуск Альт Сервер выполняется автоматически после запуска компьютера и отработки набора программ BIOS.

На экране появляется меню, в котором перечислены возможные варианты загрузки операционной системы.

При первом старте, в условиях установки нескольких ОС на один компьютер, возможно отсутствие в загрузочном меню пункта/пунктов с другой/другими операционными системами, они будут добавлены в список при последующей перезагрузке. Все перечисленные в меню после перезагрузки варианты могут быть загружены загрузчиком Linux.

Стрелками клавиатуры Вверх и Вниз выберите нужную операционную систему. Дополнительно к основным вариантам запуска ОС из этого меню можно загрузить Linux в безопасном режиме или запустить проверку памяти.

Загрузка операционной системы по умолчанию (первая в списке) начинается автоматически после небольшого времени ожидания (обычно несколько секунд). Нажав клавишу Enter, можно начать загрузку немедленно.

Нажатием клавиши E можно вызвать редактор параметров текущего пункта загрузки. Если система настроена правильно, то редактировать их нет необходимости.

В процессе загрузки Альт Сервер пользователь может следить за информацией процесса загрузки, которая отображает этапы запуска различных служб и программных серверов в виде отдельных строк, на экране монитора.

При этом каждая строка начинается словом вида [XXXXXXX] (FAILED или OK), являющегося признаком нормального или ненормального завершения этапа загрузки. Слово XXXXXXX=FAILED (авария) свидетельствует о неуспешном завершении этапа загрузки, что требует вмешательства и специальных действий администратора системы.

Загрузка операционной системы может занять некоторое время, в зависимости от производительности компьютера. Основные этапы загрузки операционной системы — загрузка ядра, подключение (монтирование) файловых систем, запуск системных служб — периодически могут дополняться проверкой файловых систем на наличие ошибок. В этом случае время ожидания может быть занять больше времени, чем обычно. Подробную информацию о шагах загрузки можно получить, нажав клавишу Esc.

Глава 25. Получение доступа к зашифрованным разделам

В случае, если вы создали шифрованный раздел, вам потребуется вводить пароль при обращении к этому разделу.

Например, если был зашифрован домашний раздел /home, то для того, чтобы войти в систему под своим именем пользователя, вам потребуется ввести пароль этого раздела и затем нажать Enter.

Если не ввести пароль за отведенный промежуток времени, то загрузка системы завершится ошибкой. В этом случае вам следует перезагрузить систему, нажав для этого два раза Enter, а затем клавиши Ctrl+Alt+Delete.

Глава 26. Вход в систему

26.1. Вход и работа в консольном режиме

Стандартная установка Альт Сервер включает базовую систему, работающую в консольном режиме.

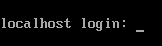

При загрузке в консольном режиме работа загрузчика Альт Сервер завершается запросом на ввод логина и пароля учетной записи. В случае необходимости на другую консоль можно перейти, нажав Ctrl+Alt+F2.

Для дальнейшего входа в систему необходимо ввести логин и пароль учетной записи пользователя.

В случае успешного прохождения процедуры аутентификации и идентификации будет выполнен вход в систему. ОС Альт Сервер перейдет к штатному режиму работы и предоставит дальнейший доступ к консоли.

26.2. Виртуальная консоль

В процессе работы ОС Альт Сервер активно несколько виртуальных консолей. Каждая виртуальная консоль доступна по одновременному нажатию клавиш Ctrl, Alt и функциональной клавиши с номером этой консоли от F1 до F6.

При установке системы в профиле по умолчанию на первой виртуальной консоли пользователь может зарегистрироваться и работать в графическом режиме. При нажатии Ctrl+Alt+F1 осуществляется переход на первую виртуальную консоль в графический режим.

Двенадцатая виртуальная консоль (Ctrl+Alt+F12) выполняет функцию системной консоли — на неё выводятся сообщения о происходящих в системе событиях.

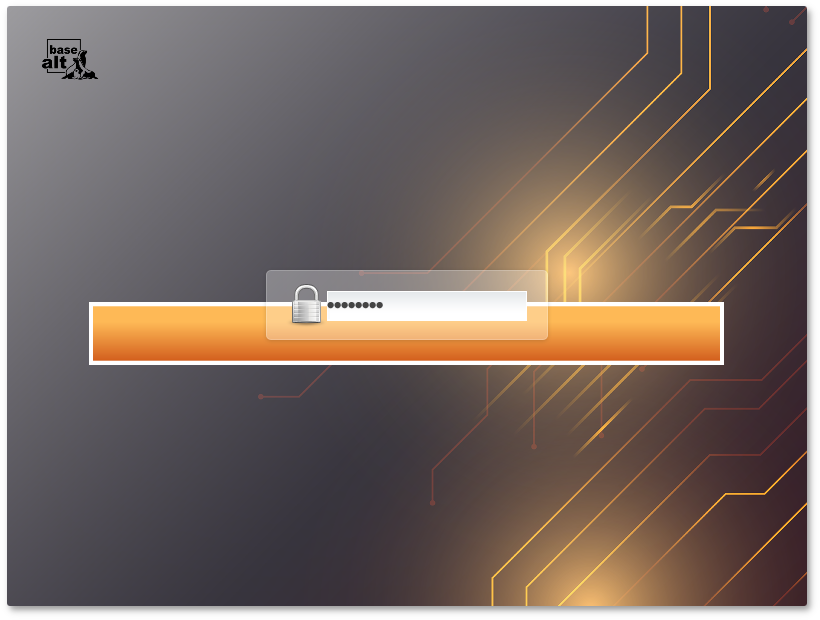

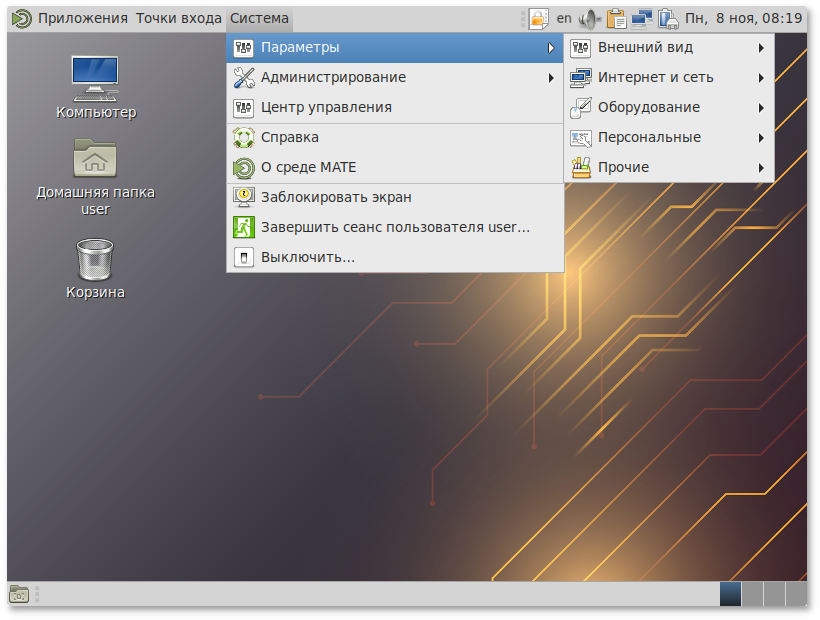

26.3. Вход и работа в системе в графическом режиме

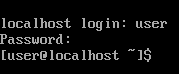

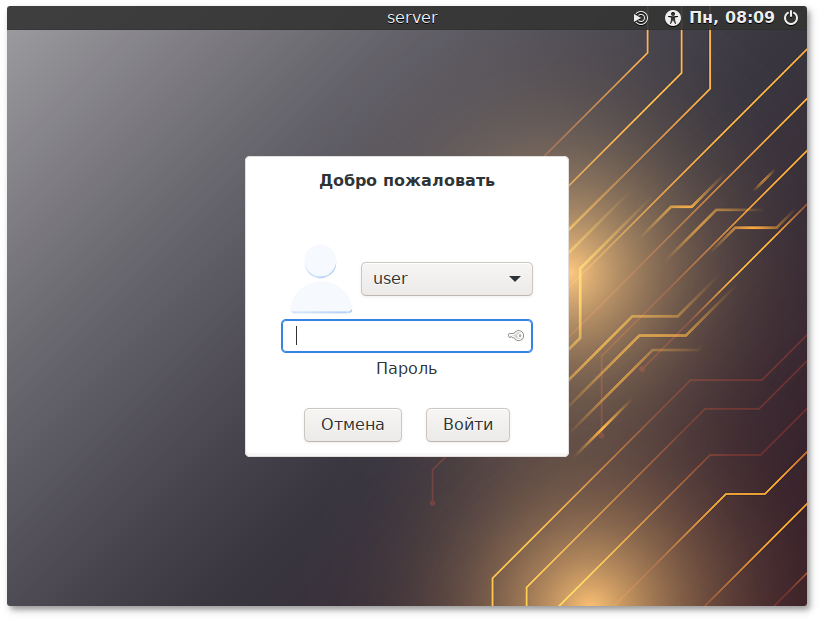

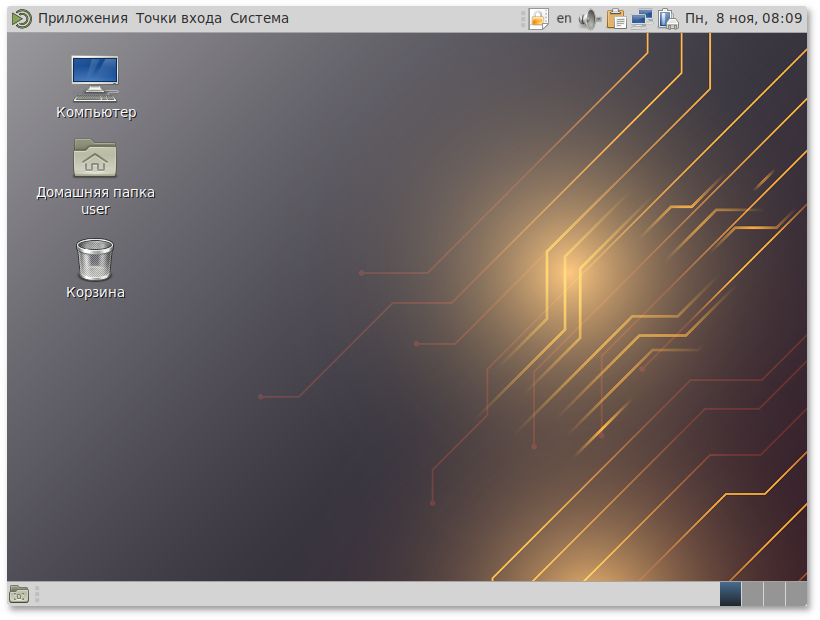

В состав ОС Альт Сервер также может входить графическая оболочка MATE. Графическая оболочка состоит из набора различных программ и технологий, используемых для управления ОС и предоставляющих пользователю удобный графический интерфейс для работы в виде графических оболочек и оконных менеджеров.

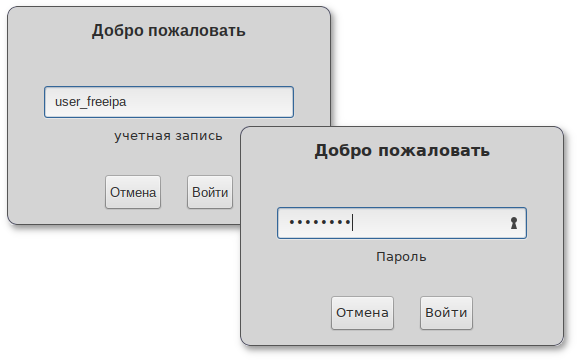

При загрузке в графическом режиме работа загрузчика ОС заканчивается переходом к окну входа в систему.

Для регистрации в системе необходимо выбрать имя пользователя из выпадающего списка. Далее необходимо ввести пароль, затем нажать Enter или щелкнуть на кнопке Войти. После непродолжительного времени ожидания запустится графическая оболочка операционной системы.

Добавлять новых пользователей или удалять существующих можно после загрузки системы с помощью стандартных средств управления пользователями.

Если систему устанавливали не вы, то имя системного пользователя и его пароль вам должен сообщить системный администратор, отвечающий за настройку данного компьютера.

Поскольку работа в системе с использованием учётной записи администратора системы небезопасна, вход в систему в графическом режиме для суперпользователя root запрещён. Попытка зарегистрироваться в системе будет прервана сообщением об ошибке.

Часть VIII. Организация сетевой инфраструктуры с помощью сервера

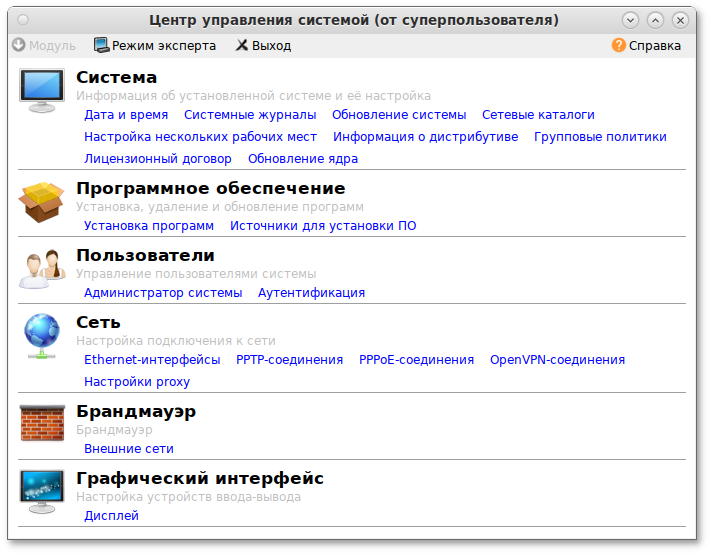

Альт Сервер в сети организации может быть использован для решения различных задач. Он может предоставлять компьютерам сети общий доступ в Интернет, выступать в роли почтового сервера, файлового хранилища, веб-сервера и т.д. Все эти возможности обеспечиваются соответствующими службами, запускаемыми на сервере.

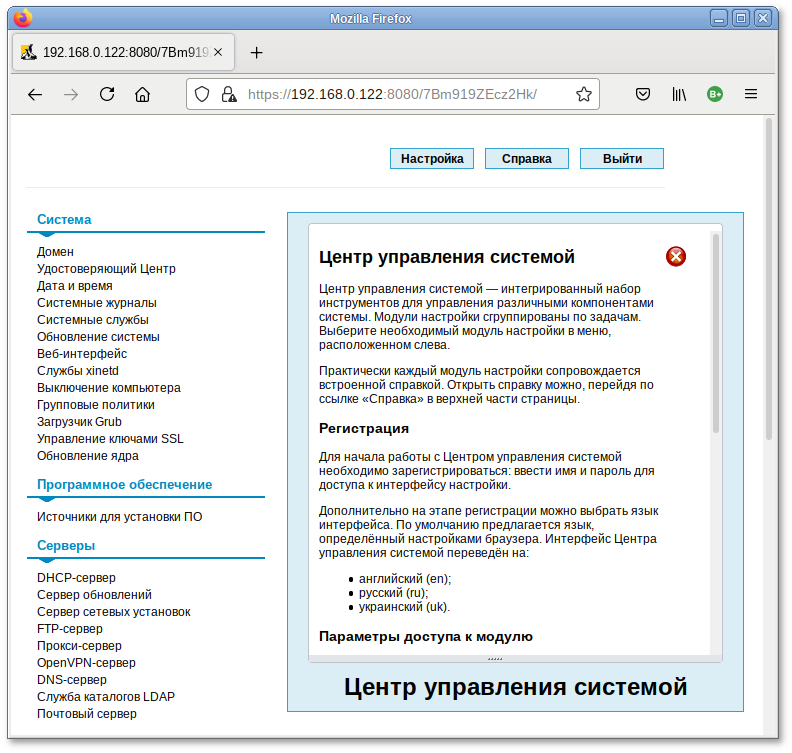

Дальнейшие разделы описывают некоторые возможности использования Альт Сервер, настраиваемые в ЦУС.

Эта и последующие главы рекомендуются к прочтению опытным пользователям и системным администраторам.

Глава 36. Настройка подключения к Интернету

Помимо множества различных служб, которые Альт Сервер может предоставлять компьютерам сети, важно определить, будет ли сервер предоставлять общий доступ в Интернет для компьютеров домена или нет. В зависимости от этого сервер можно рассматривать как:

Сервер без подключения к сети Интернет

Типичный случай — это сервер с одним сетевым интерфейсом (одной сетевой картой), который и связывает его с компьютерами локальной сети. Такой сервер называется также

сервер рабочей группы.

Шлюз

В этом случае сервер обычно имеет два сетевых интерфейса (например, две сетевые карты), одна из которых служит для подключения к локальной сети, а другая — для подключения к сети Интернет.

Как для обеспечения доступа в сеть Интернет самого Альт Сервер, так и для настройки общего выхода в Интернет для компьютеров сети необходимо настроить подключение к Интернету на самом сервере. Альт Сервер поддерживает самые разные способы подключения к сети Интернет:

Ethernet;

PPTP;

PPPoЕ;

и т.д.

Для настройки подключения воспользуйтесь одним из разделов ЦУС .

Доступные разделы:

PPTP-соединения;

PPPoE-соединения;

Выберите раздел, соответствующий вашему типу подключения, и приступайте к настройке.

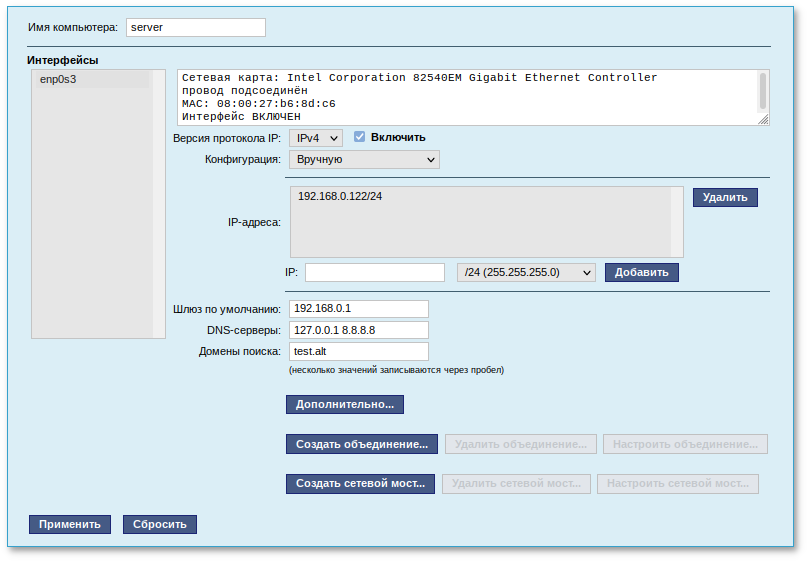

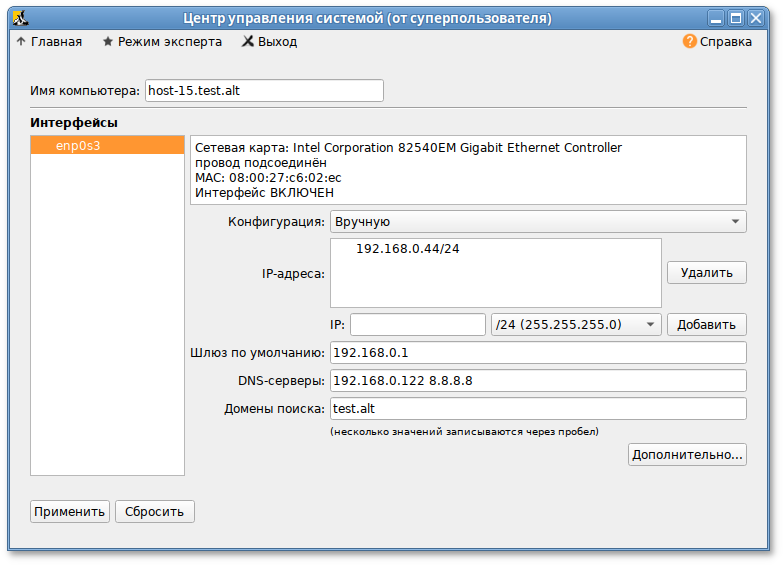

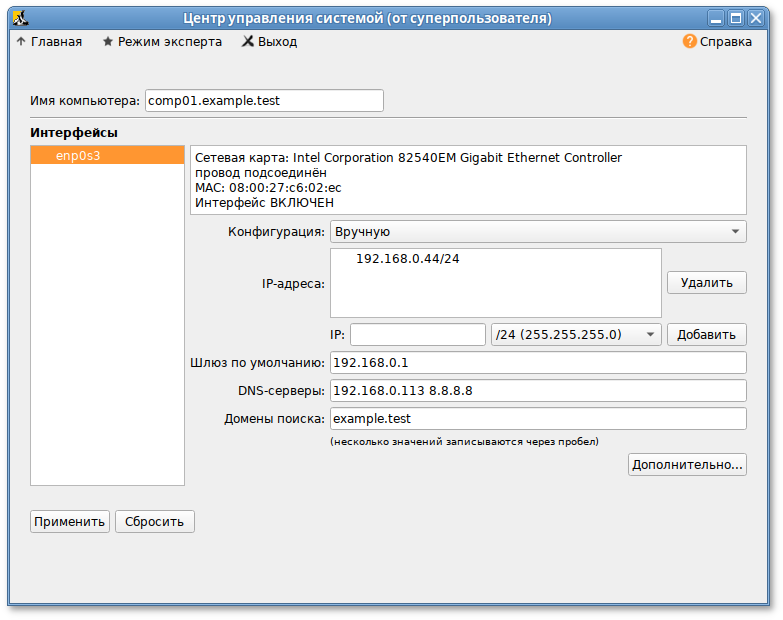

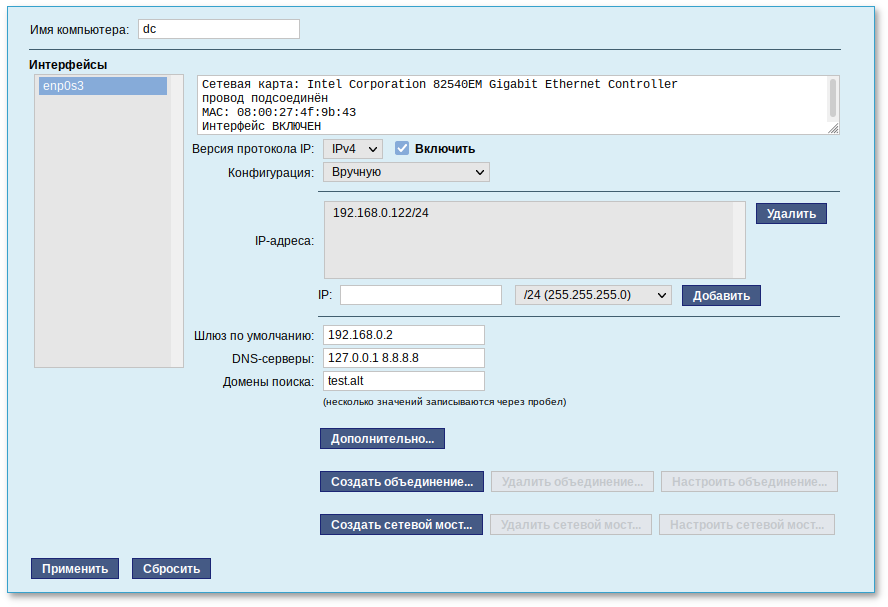

36.1. Конфигурирование сетевых интерфейсов

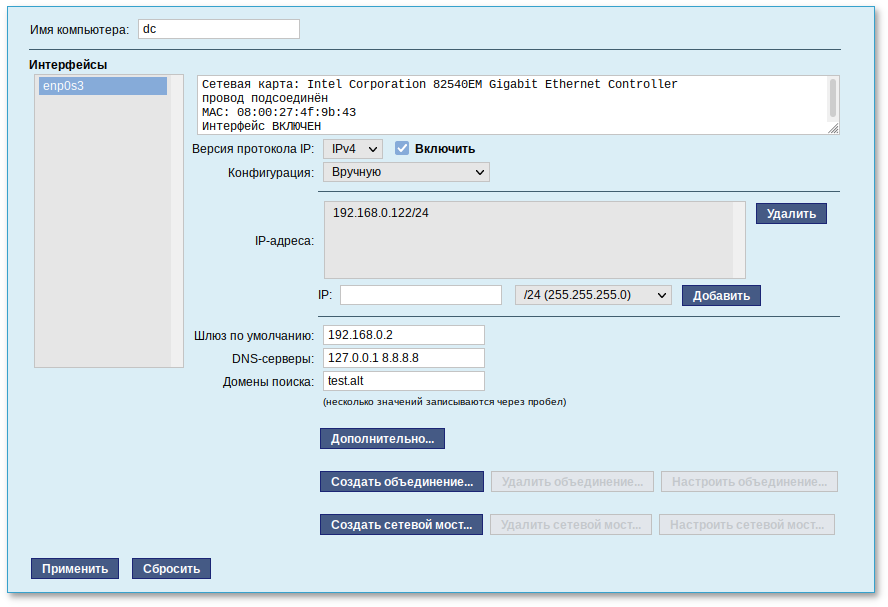

Конфигурирование сетевых интерфейсов осуществляется в модуле ЦУС (пакет alterator-net-eth) из раздела :

В модуле можно заполнить следующие поля:

Имя компьютера — указать сетевое имя ПЭВМ в поле для ввода имени компьютера (это общий сетевой параметр, не привязанный, к какому-либо конкретному интерфейсу). Имя компьютера, в отличие от традиционного имени хоста в Unix (hostname), не содержит названия сетевого домена;

Интерфейсы — выбрать доступный сетевой интерфейс, для которого будут выполняться настройки;

Версия протокола IP — указать в выпадающем списке версию используемого протокола IP (IPv4, IPv6) и убедиться, что пункт Включить, обеспечивающий поддержку работы протокола, отмечен;

Конфигурация — выбрать способ назначения IP-адресов (службы DHCP, Zeroconf, вручную);

IP-адреса — пул назначенных IP-адресов из поля IP, выбранные адреса можно удалить нажатием кнопки Удалить;

IP — ввести IP-адрес вручную и выбрать в выпадающем поле предпочтительную маску сети, затем нажать кнопку Добавить для переноса адреса в пул поля IP-адреса;

Шлюз по умолчанию — в поле для ввода необходимо ввести адрес шлюза, который будет использоваться сетью по умолчанию;

DNS-серверы — в поле для ввода необходимо ввести список предпочтительных DNS-серверов, которые будут получать информацию о доменах, выполнять маршрутизацию почты и управлять обслуживающими узлами для протоколов в домене;

Домены поиска — в поле для ввода необходимо ввести список предпочтительных доменов, по которым будет выполняться поиск. Если в поле Домены поиска перечислить наиболее часто используемые домены (например, domain), то можно пользоваться неполными именами машин (computer вместо computer.domain).

IP-адрес и Маска сети — обязательные параметры каждого узла IP-сети. Первый параметр – уникальный идентификатор машины, от второго напрямую зависит, к каким машинам локальной сети данная машина будет иметь доступ. Если требуется выход во внешнюю сеть, то необходимо указать параметр Шлюз по умолчанию.

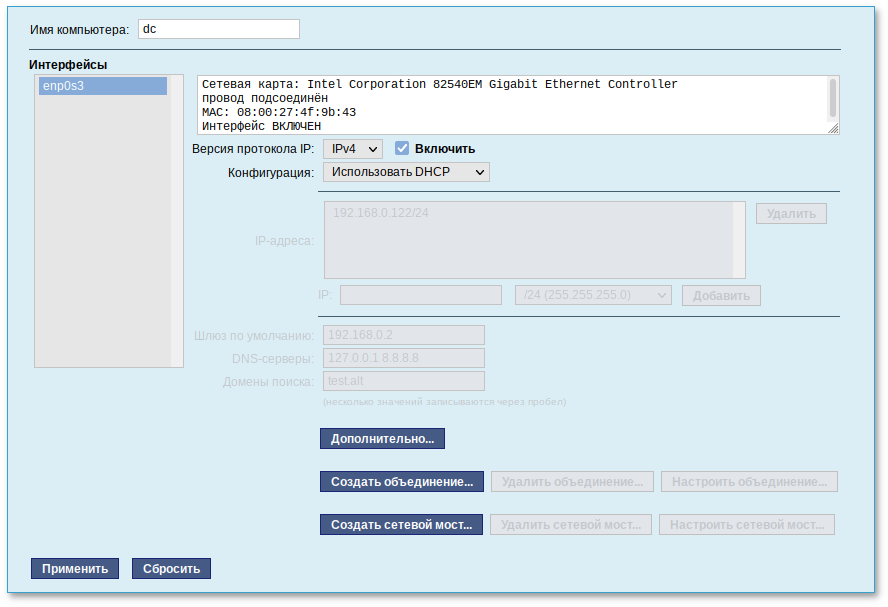

В случае наличия DHCP-сервера можно все вышеперечисленные параметры получить автоматически – выбрав в списке Конфигурация пункт Использовать DHCP:

Если в компьютере имеется несколько сетевых карт, то возможна ситуация, когда при очередной загрузке ядро присвоит имена интерфейсов (enp0s3, enp0s8) в другом порядке. В результате интерфейсы получат не свои настройки. Чтобы этого не происходило, можно привязать интерфейс к имени по его аппаратному адресу (MAC) или по местоположению на системной шине.

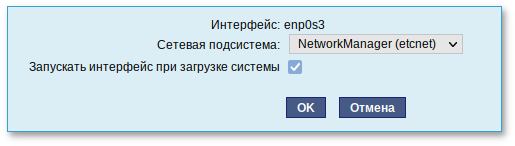

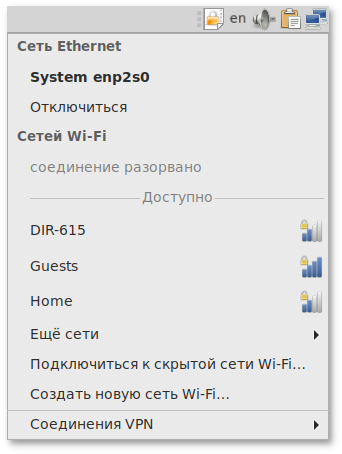

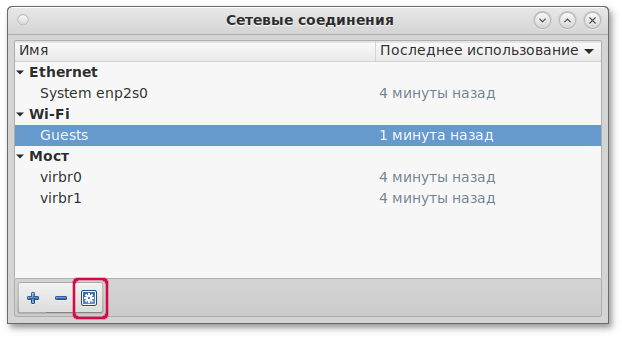

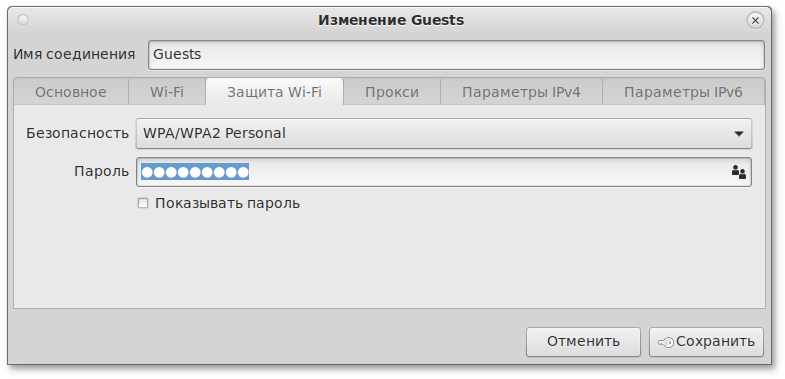

Дополнительно для каждого интерфейса можно настроить сетевую подсистему (NetworkManager, Etcnet), а также должен ли запускаться данный интерфейс при загрузке системы:

В списке Сетевая подсистема можно выбрать следующие режимы:

Etcnet

В этом режиме настройки берутся исключительно из файлов находящихся в каталоге настраиваемого интерфейса

/etc/net/ifaces/<интерфейс>. Настройки сети могут изменяться либо в ЦУС в данном модуле, либо напрямую через редактирование файлов

/etc/net/ifaces/<интерфейс>.

NetworkManager (etcnet)

В этом режиме

NetworkManager сам инициирует сеть, используя в качестве параметров — настройки из файлов Etcnet. Настройки сети могут изменяться либо в ЦУС в данном модуле, либо напрямую через редактирование файлов

/etc/net/ifaces/<интерфейс>. В этом режиме можно просмотреть настройки сети, например полученный по DHCP IP-адрес, через графический интерфейс

NetworkManager.

NetworkManager (native)

В данном режиме управление настройками интерфейса передаётся

NetworkManager и не зависит от файлов Etcnet. Управлять настройками можно через графический интерфейс

NetworkManager. Файлы с настройками находятся в директории

/etc/NetworkManager/system-connections. Этот режим особенно актуален для задач настройки сети на клиенте, когда IP-адрес необходимо получать динамически с помощью DHCP, а DNS-сервер указать явно. Через ЦУС так настроить невозможно, так как при включении DHCP отключаются настройки, которые можно задавать вручную.

Не контролируется

В этом режиме интерфейс находится в состоянии DOWN (выключен).

36.2. Настройка общего подключения к сети Интернет

Пользователи корпоративных сетей обычно подключаются к сети Интернет через один общий канал. Для организации совместного доступа к сети Интернет стандартными средствами поддерживаются две технологии, которые могут использоваться как по отдельности, так и совместно:

Оба способа предполагают, что соединение с Интернет компьютера, через который предполагается настроить общий выход, предварительно

сконфигурировано . Сделать это можно в разделе ЦУС .

Отличительной особенностью использования прокси-сервера является то, что, помимо предоставления доступа к веб-сайтам, прокси-сервер кэширует загруженные страницы, а при повторном обращении к ним — отдаёт их из своего кэша. Это может существенно снизить потребление трафика.

У прокси-сервера есть два основных режима работы:

Для работы с прокси-сервером в прозрачном режиме не потребуется специальная настройка рабочих станций. Они лишь должны использовать сервер в качестве шлюза по умолчанию. Этого можно добиться, сделав соответствующие настройки на DHCP-сервере.

Для использования прокси-сервера в обычном режиме потребуется на каждом клиенте в настройках браузера указать данные прокси-сервера (IP-адрес и порт).

Преимуществом обычного режима работы, требующего перенастройки программ локальной сети, является возможность производить аутентификацию пользователей и контролировать их доступ во внешнюю сеть.

В различных браузерах местоположение формы настройки на прокси-сервер различное. Например, в браузере Firefox она доступна через меню → → → +кнопка Настроить… напротив текста «Настройка параметров соединения Firefox с Интернетом». Здесь следует выбрать Ручная настройка сервиса прокси и указать IP-адрес и порт прокси-сервера.

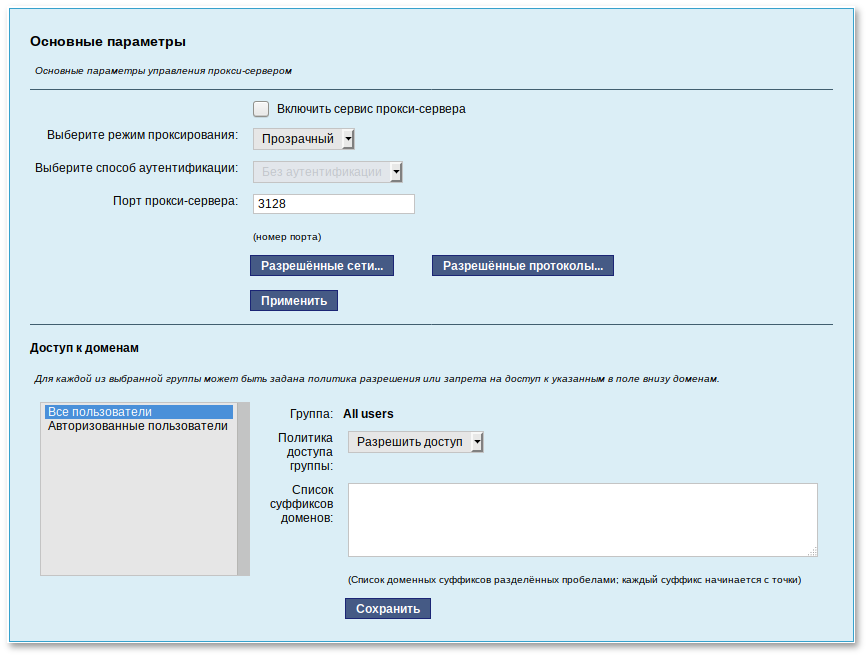

По умолчанию прокси-сервер не предоставляет доступ в Интернет никому кроме себя самого. Список сетей, обслуживаемых прокси-сервером можно изменить, нажав на кнопку «Разрешённые сети…» в модуле ЦУС (пакет alterator-squid) из раздела .

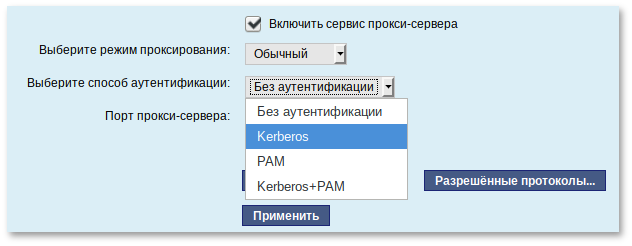

Для того чтобы включить аутентификацию пользователей и контролировать их доступ во внешнюю сеть, необходимо выбрать обычный режим проксирования и способ аутентификации, отличный от Без аутентификации:

Прокси-сервер принимает запросы из локальной сети и, по мере необходимости, передаёт их во внешнюю сеть. Поступление запроса ожидается на определённом порту, который по умолчанию имеет стандартный номер 3128. Если по каким-то причинам не желательно использовать данный порт, то можно поменять его значение на любое другое.

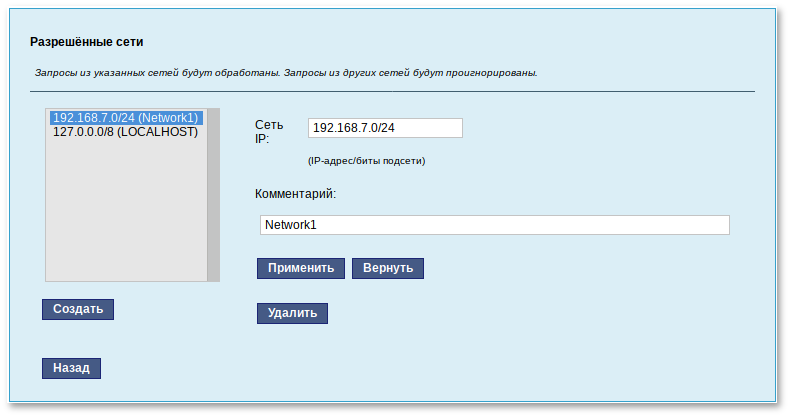

Перед тем как выполнить перенаправление запроса, прокси-сервер проверяет принадлежность сетевого адрес узла, с которого запрос был отправлен к группе внутренних сетевых адресов. Для того чтобы запросы, отправленные из локальной сети, обрабатывались прокси-сервером, необходимо добавить соответствующую группу адресов (адрес подсети и адресную маску) в список внутренних сетей в разделе :

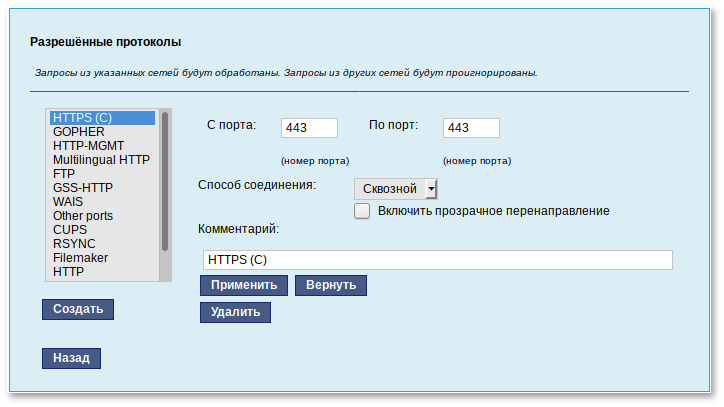

Вторым условием передачи запроса является принадлежность целевого порта к разрешённому диапазону. Посмотреть и отредактировать список разрешённых целевых портов можно в разделе :

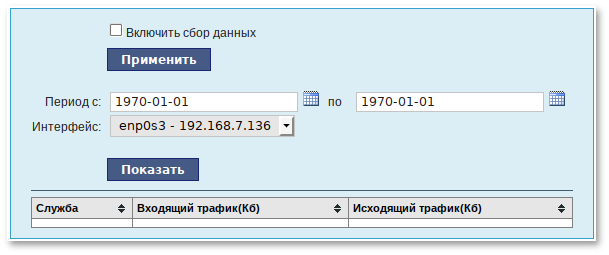

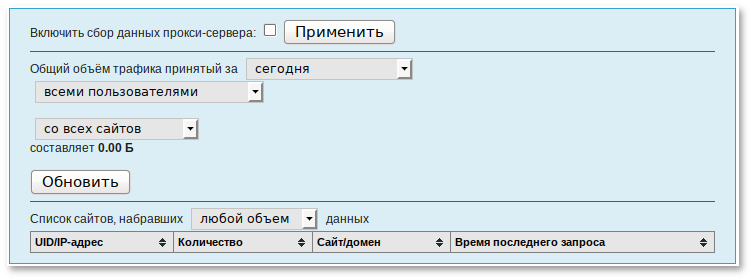

Прокси-сервер позволяет вести

статистику посещений страниц в Интернете. Она доступна в модуле ЦУС (пакет

alterator-squidmill) в разделе . Основное предназначение статистики — просмотр отчёта об объёме полученных из Интернета данных в привязке к пользователям (если включена аутентификация) или к IP-адресам клиентов.

Статистика не собирается по умолчанию. Включить её сбор следует в модуле ЦУС (раздел ). Для этого отметьте Включить сбор данных прокси-сервера и нажмите кнопку Применить.

Для учёта пользователей в статистике нужно добавить хотя бы одно правило. Самое очевидное — запрет не аутентифицированных пользователей. Только после этого в статистике начнут показываться пользователи.

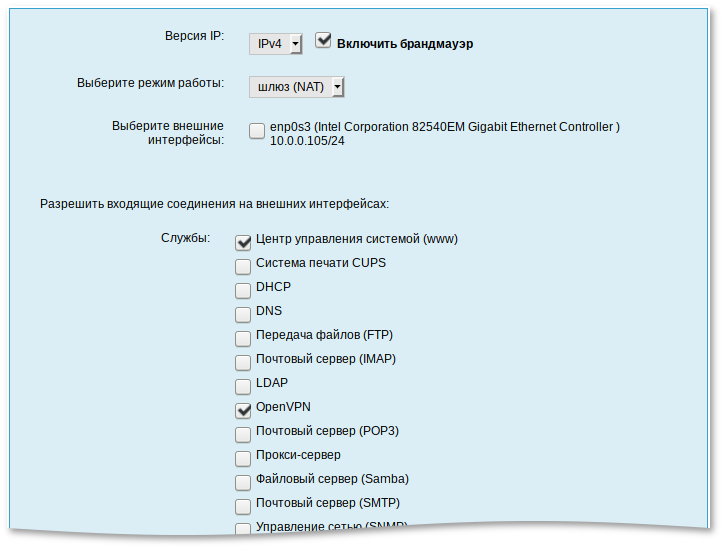

NAT (Network Address Translation, преобразование сетевых адресов) — это механизм в сетях TCP/IP, позволяющий преобразовывать IP-адреса транзитных пакетов. Таким образом, компьютеры локальной сети, имеющие IP-адреса, зарезервированные для использования исключительно в локальных сетях, могут использовать общий канал доступа к Интернет (общий внешний IP-адрес). При этом на компьютере-шлюзе, непосредственно подключённом к Интернет, выполняется преобразование адресов.

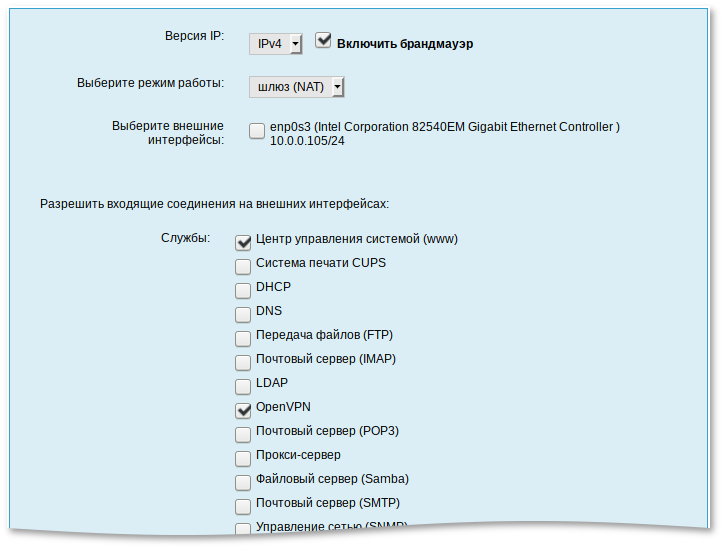

Настройка NAT осуществляется в модуле ЦУС (пакет alterator-net-iptables) из раздела . Для минимальной настройки достаточно выбрать режим работы Шлюз (NAT), отметить правильный внешний сетевой интерфейс и нажать на кнопку Применить.

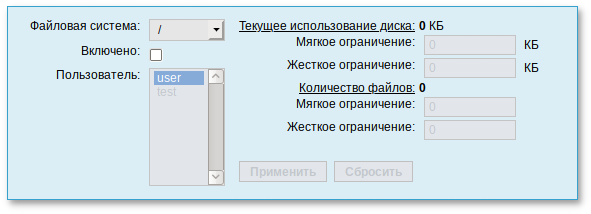

36.3. Автоматическое присвоение IP-адресов (DHCP-сервер)

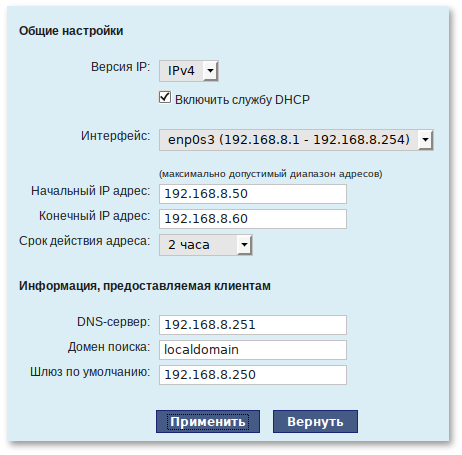

DHCP (Dynamic Host Configuration Protocol) — протокол, позволяющий клиенту самостоятельно получить IP-адрес из зарезервированного диапазона адресов, а также дополнительную информацию о локальной сети (DNS-сервер сети, домен поиска, шлюз по умолчанию). Это облегчает администрирование клиентских машин, избавляя администратора домена от необходимости вручную настраивать сетевые интерфейсы на компьютерах локальной сети.

Чтобы настраивать DHCP-сервер, на машине должен быть хотя бы один статически сконфигурированный Ethernet-интерфейс.

Настройка DHCP-сервера осуществляется в модуле ЦУС (пакет alterator-dhcp) из раздела .

Для включения DHCP-сервера необходимо установить флажок Включить службу DHCP, указать начальный и конечный IP-адрес, а также шлюз по умолчанию (обычно, это IP-адрес сервера на сетевом интерфейсе, обслуживающем локальную сеть).

Теперь при включении любой клиентской машины с настройкой получение ip и dns автоматически будет присваиваться шлюз 192.168.8.250, DNS 192.168.8.251 и адреса начиная с 192.168.8.50 по порядку включения до 192.168.8.60.

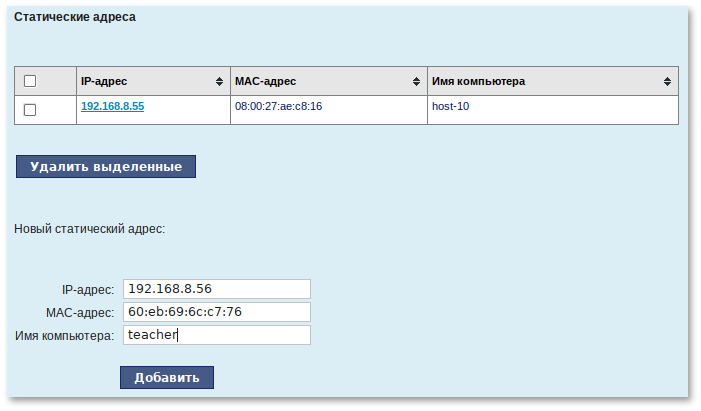

Иногда бывает полезно выдавать клиенту один и тот же IP-адрес независимо от момента обращения. В этом случае он определяется по аппаратному адресу (MAC-адресу) сетевой карты клиента. Для добавления своих значений в таблицу соответствия статических адресов введите IP-адрес и соответствующий ему MAC-адрес и нажмите кнопку Добавить.

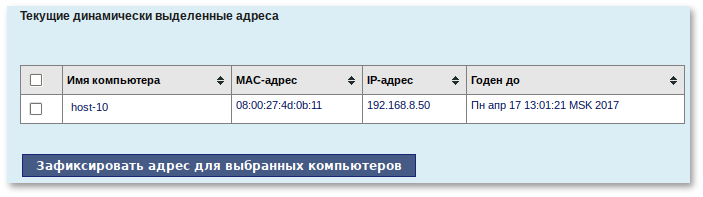

Выданные IP-адреса можно увидеть в списке Текущие динамически выданные адреса. Здесь также имеется возможность зафиксировать выданные адреса, за данными компьютерами. Для этого необходимо отметить хост, за которым нужно закрепить IP-адрес и нажать кнопку Зафиксировать адрес для выбранных компьютеров.

За дополнительной информацией по настройке обращайтесь к встроенной справке модуля ЦУС.

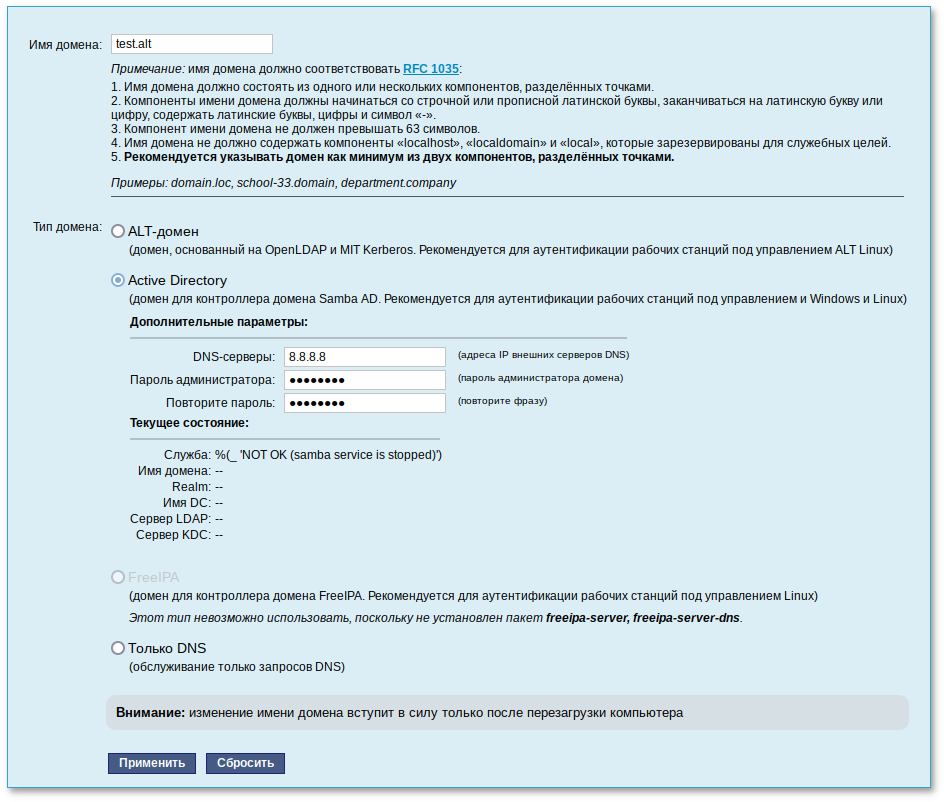

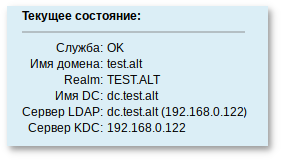

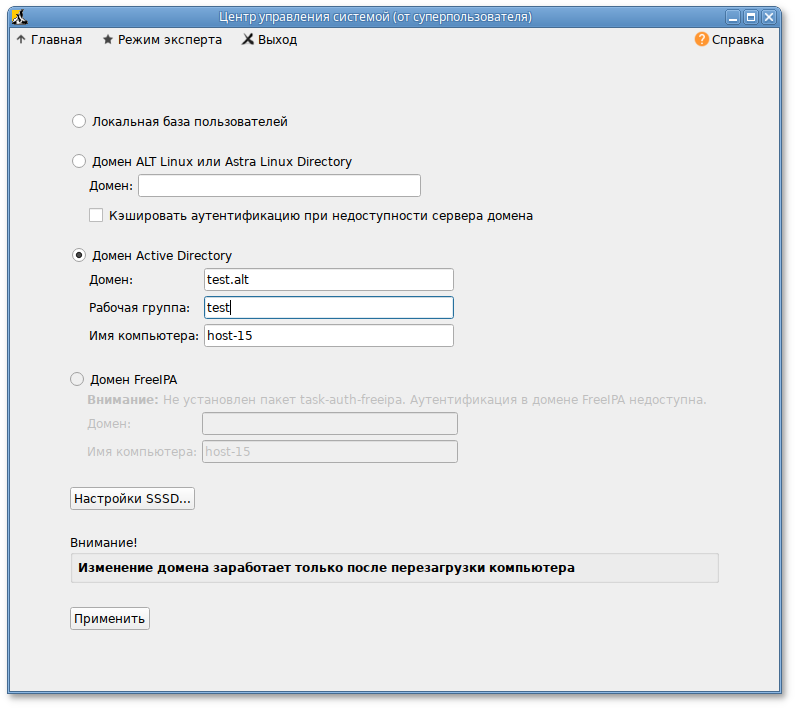

Глава 37. Развертывание доменной структуры

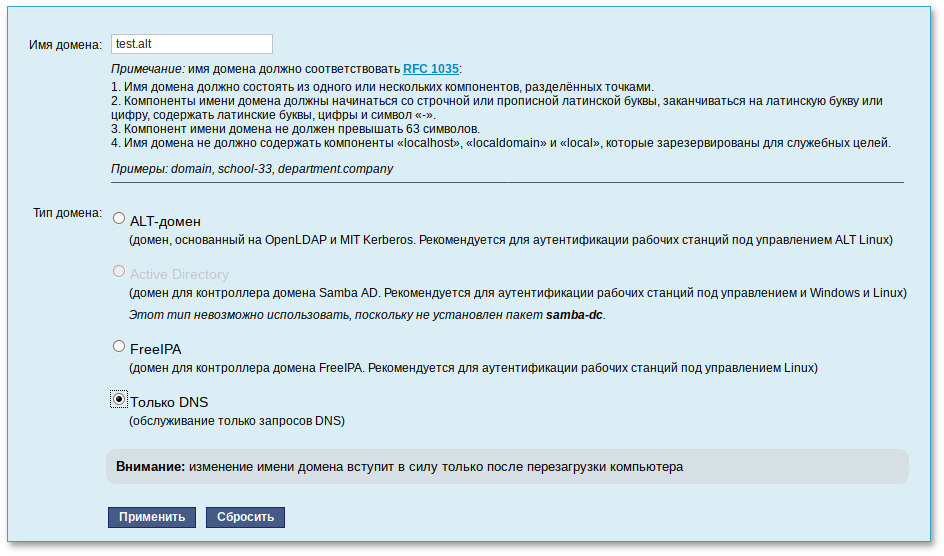

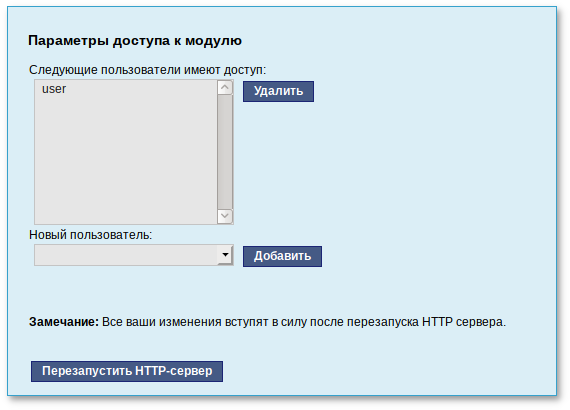

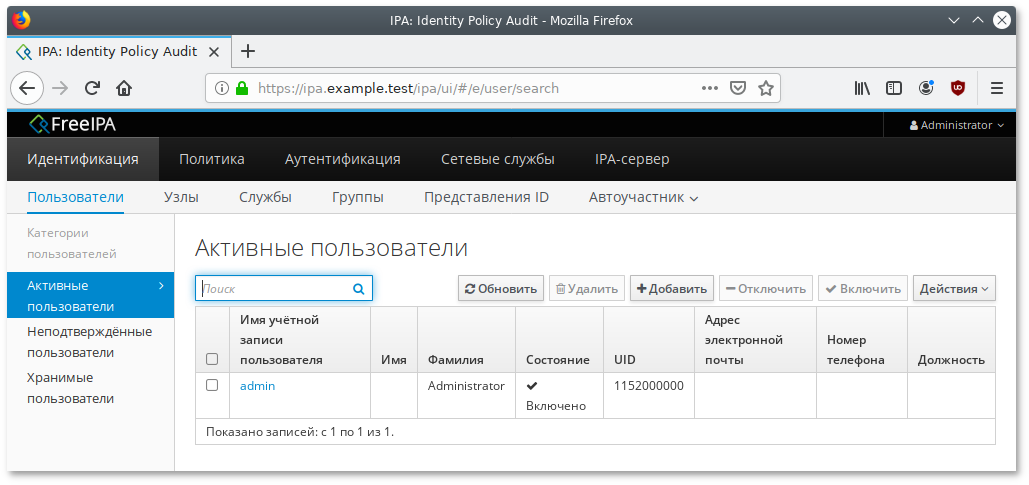

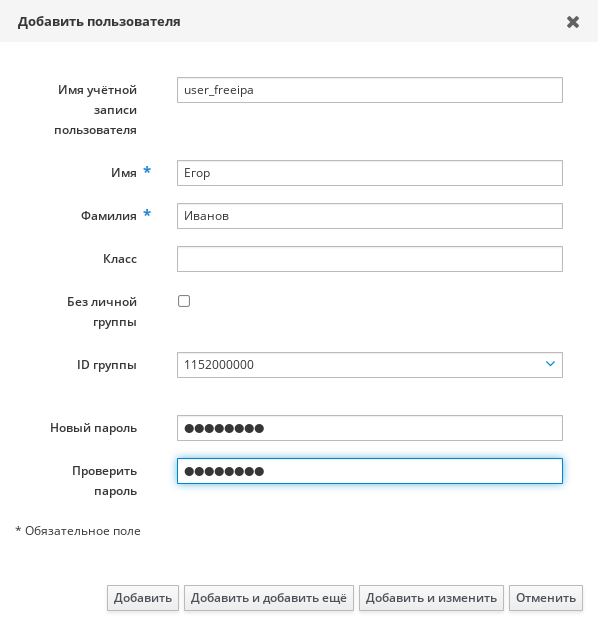

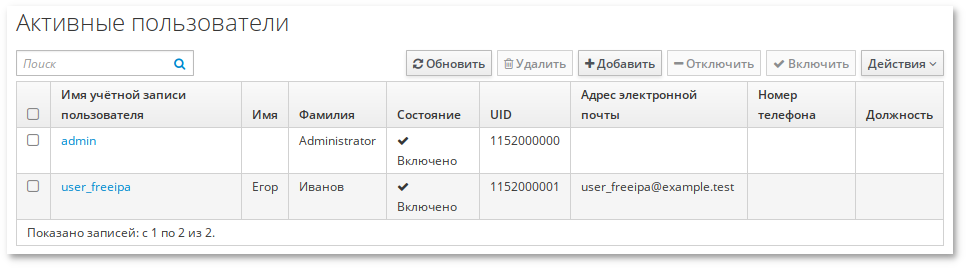

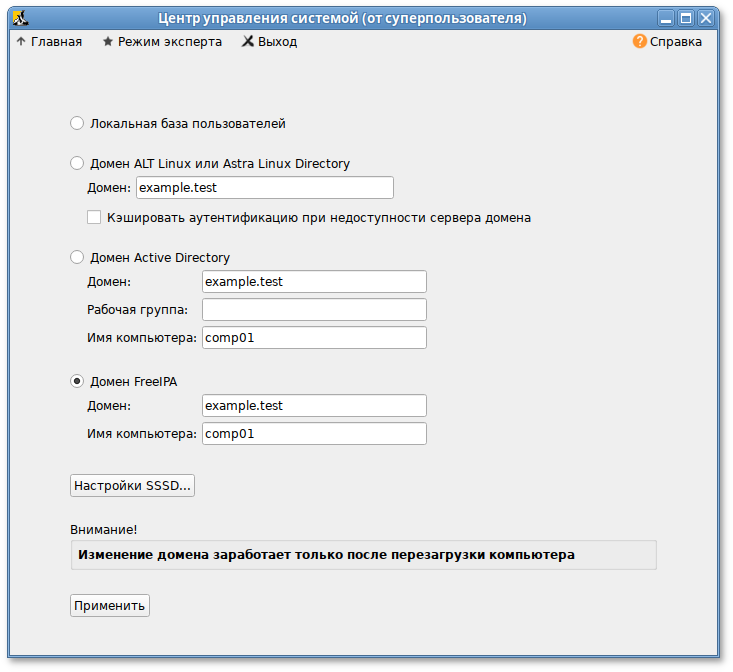

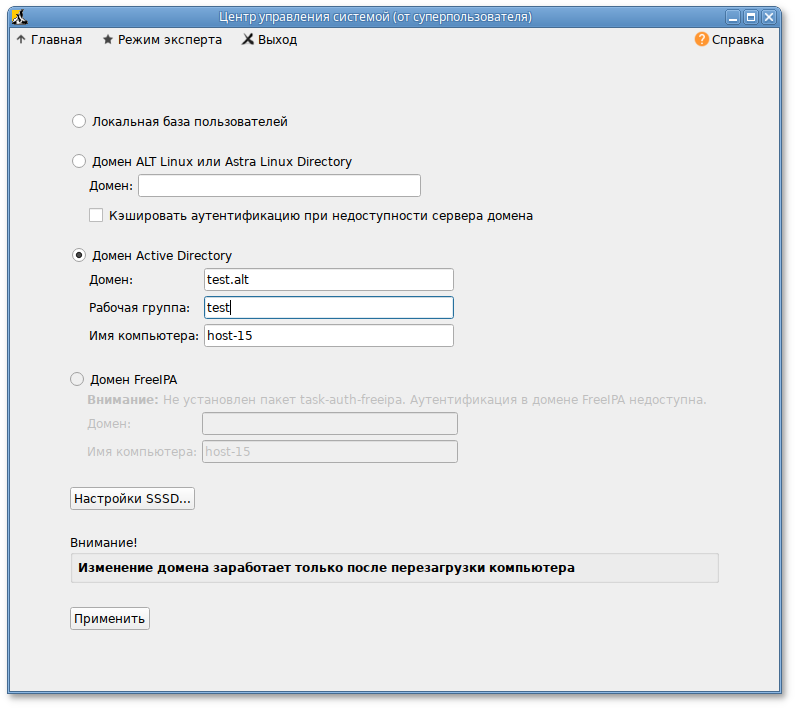

Для развертывания доменной структуры предназначен модуль ЦУС из раздела (пакет alterator-net-domain):

Модуль поддерживает следующие виды доменов:

ALT-домен. Домен, основанный на OpenLDAP и MIT Kerberos. Домен нужно устанавливать только после настройки сервера DHCP. В противном случае придётся выбирать другое имя домена.

Active Directory. Домен для контроллера домена Samba AD. Рекомендуется для аутентификации рабочих станций под управлением и Windows и Linux.

FreeIPA. Домен для контроллера домена FreeIPA. Рекомендуется для аутентификации рабочих станций под управлением Linux.

DNS. Обслуживание только запросов DNS указанного домена сервисом BIND.

Глава 38. Сетевая установка операционной системы на рабочие места

Одной из удобных возможностей Альт Сервер при разворачивании инфраструктуры является сетевая установка. При помощи сетевой установки можно производить установку Альт Сервер не с DVD-диска, а загрузив инсталлятор по сети.

38.1. Подготовка сервера

При сетевой установке с сервера будут переняты настройки домена, и включена централизованная аутентификация. Если вы устанавливаете Альт Сервер с DVD-диска, то настройку домена и аутентификации надо будет производить отдельно на каждой рабочей стации.

Локальный файл должен быть доступен для nobody и должен находиться на сервере, где запущен alterator-netinst.

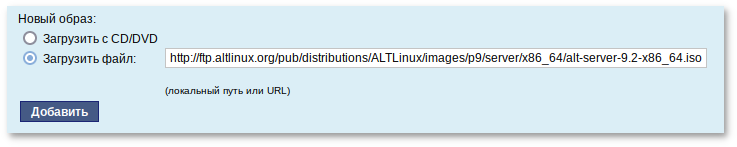

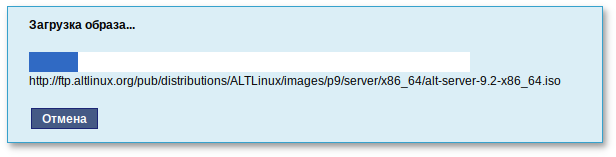

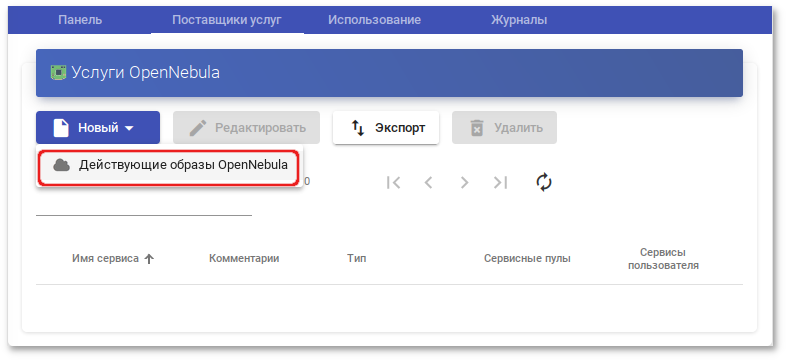

В разделе (пакет alterator-netinst), укажите откуда импортировать новый образ и нажмите кнопку Добавить.

Процесс добавления образа занимает какое-то время. Пожалуйста, дождитесь окончания этого процесса.

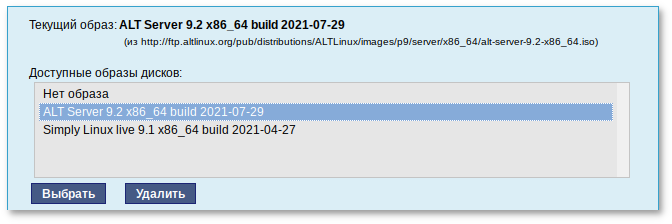

После добавления образа он появится в списке Доступные образы дисков. Необходимо выбрать из списка один из образов и нажать кнопку Выбрать.

На этом подготовка сервера к сетевой установке рабочих станций завершена.

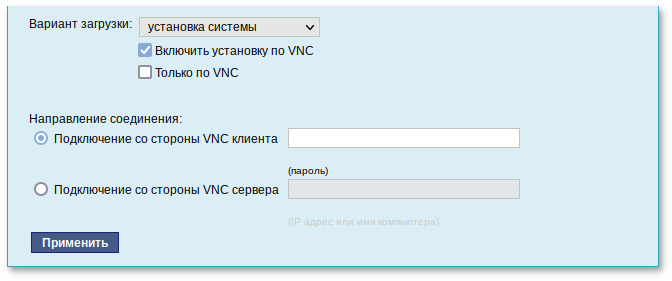

Далее следует выбрать направление соединения. Удалённый доступ к компьютеру может быть двух видов:

Со стороны клиента. Во время установки администратор может с помощью VNC-клиента подключиться к компьютеру, на которой производится установка, зная его IP-адрес и заданный пароль.

Со стороны сервера. Во время установки с каждого компьютера инициируется подключение к запущенному на заданном компьютере VNC-клиенту. Компьютер-приёмник соединений задаётся IP-адресом или именем.

В случае, когда работа с аппаратной подсистемой ввода-вывода невозможна (например, если клавиатура, мышь или монитор отсутствуют), можно использовать вариант Только по VNC.

Если необходимо управлять установкой удалённо, отметьте пункт Включить установку по VNC и пункт Подключение со стороны VNC сервера раздела , и там укажите адрес компьютера, с которого будет происходить управление. Для приёма подключения можно запустить, например, vncviewer -listen.

Не забудьте отключить сетевую установку по окончании процесса установки ОС на рабочих станциях. Это можно сделать, выбрав в списке Доступные образы дисков пункт и подтвердив действие нажатием кнопки Выбрать.

За дополнительной информацией по настройке обращайтесь к встроенной справке соответствующих модулей Центра управления системой.

38.2. Подготовка рабочих станций

Для сетевой установки следует обеспечить возможность загрузки по сети рабочих станций, на которых будет производиться установка ОС.

Большинство современных материнских плат имеют возможность загрузки по сети, однако она по умолчанию может быть отключена в BIOS. Различные производители материнских плат дают разные названия данной возможности, например: "Boot Option ROM" или "Boot From Onboard LAN".

Некоторые материнские платы позволяют выбрать источник загрузки во время включения компьютера. Эта возможность может называться, например, "Select boot device" или "Boot menu".

Последовательность установки при установке с DVD-диска и при сетевой установке не отличаются друг от друга. Обратитесь к разделу руководства

Последовательность установки.

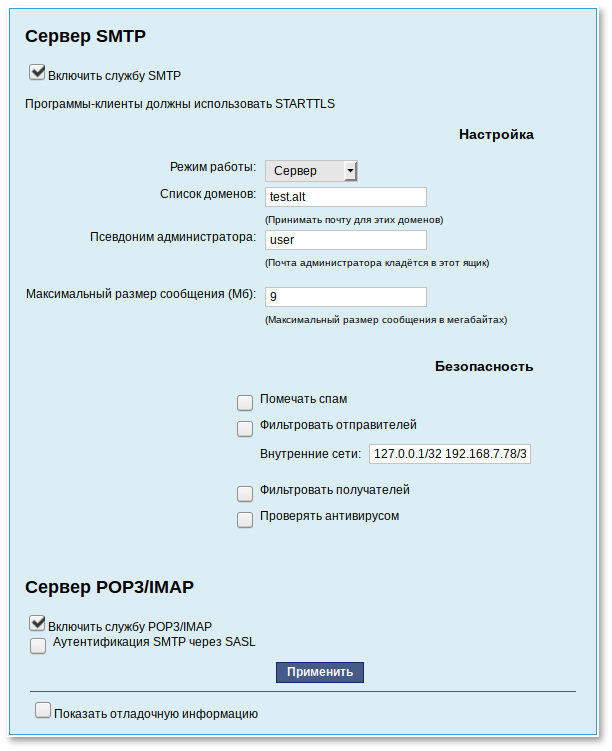

Глава 39. Сервер электронной почты (SMTP, POP3/IMAP)

39.1. Сервер электронной почты

После установки сервера и первоначальной настройки вы уже имеете преднастроенный почтовый сервер, обслуживающий почтовый домен, указанный при первоначальной настройке в поле домен.

Альт Сервер может служить как почтовым сервером, обслуживающим определённый домен, так и посредником (шлюзом) для пересылки почты. Почтовый сервер отвечает как за отправку писем (SMTP-сервер) исходящих от почтовых клиентов рабочих станций, так и за предоставление им входящей почты (Сервер POP3/IMAP).

Для настройки параметров работы сервера предусмотрен модуль ЦУС (пакет alterator-postfix-dovecot) из раздела .

Сервер SMTP отвечает за отправку сообщений и может работать в двух режимах:

Посредник

В этом режиме исходящая почта пересылается для дальнейшей отправки на указанный сервер.

Сервер

В этом режиме сервер доставляет почту самостоятельно.

Сервер POP3/IMAP используется для доступа пользователей к электронной почте на сервере.

Для доступа к службам POP3 и IMAP пользователь должен включить в своём почтовом клиенте аутентификацию и указать своё имя и пароль.

Выбор конкретного используемого протокола для получения почты зависит от предпочтений пользователя.

POP

При проверке почты почтовым клиентом почта передаётся на клиентскую машину, где и сохраняется. Возможность просмотра принятой/отправленной почты при этом существует даже если клиент не имеет соединения с сервером.

IMAP

Все сообщения хранятся на сервере. Почтовый клиент может просматривать их только при наличии соединения с сервером.

Помимо включения/отключения служб, модуль ЦУС позволяет произвести дополнительные настройки: фильтрацию спама, настройку параметров аутентификации и т.д.

За дополнительной информацией по использованию модуля обращайтесь к встроенной справке модуля ЦУС.

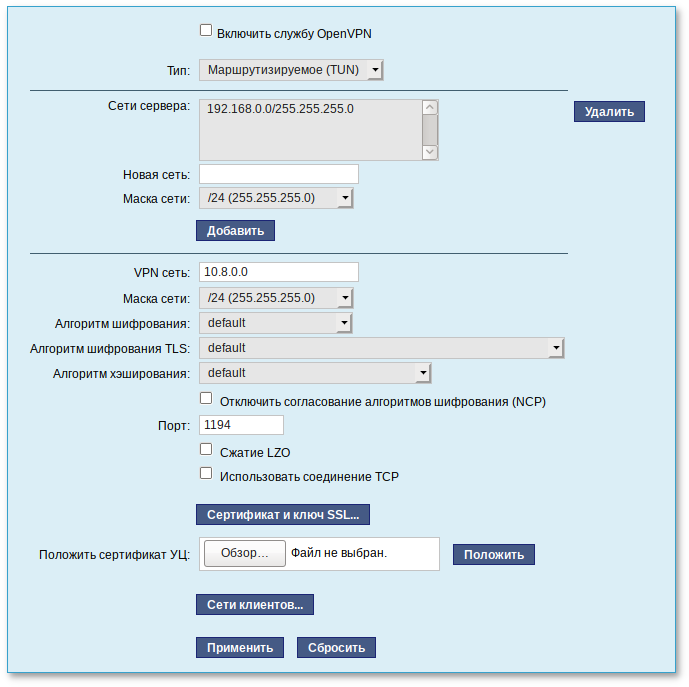

Глава 40. Соединение удалённых офисов (OpenVPN-сервер)

Альт Сервер предоставляет возможность безопасного соединения удалённых офисов используя технологию

VPN (англ. Virtual Private Network — виртуальная частная сеть), которая позволяет организовать безопасные шифрованные соединения через публичные сети (например, Интернет) между удалёнными офисами или локальной сетью и удалёнными пользователями. Таким образом, вы можете связать два офиса организации, что, делает работу с документами, расположенными в сети удалённого офиса, более удобной.

Помимо соединения целых офисов, также существует возможность организовать доступ в офисную сеть для работы в ней извне. Это означает, например, что сотрудник может работать в своём привычном окружении, даже находясь в командировке или просто из дома.

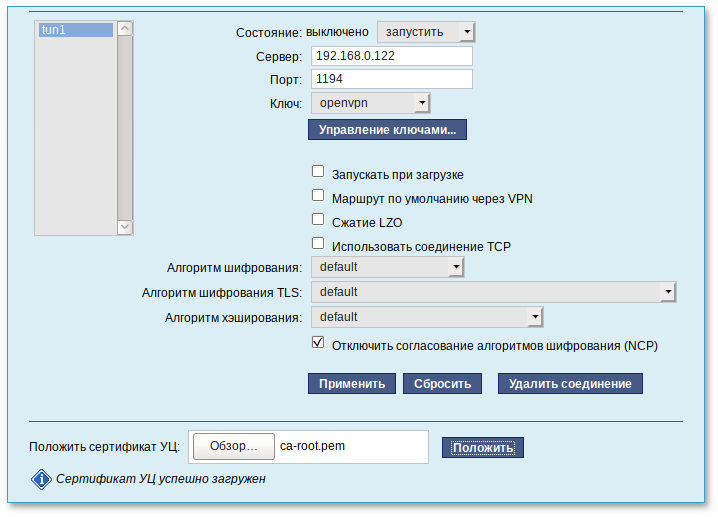

40.1. Настройка OpenVPN-сервера

Для организации VPN соединения на стороне сервера предусмотрен модуль ЦУС (пакет alterator-openvpn-server) из раздела .

Используя модуль можно:

включить/отключить OpenVPN-сервер;

настроить параметры сервера: тип, сети сервера, использование сжатия и т.д.;

управлять сертификатами сервера;

настроить сети клиентов.

Особое внимание при планировании и настройке подключений следует обратить на используемые сети. Они не должны пересекаться.

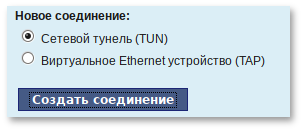

Для создания соединения необходимо установить флажок Включить службу OpenVPN, выбрать тип подключения: маршрутизируемое (используется TUN) или через мост (используется TAP), и проверить открываемую по соединению сеть (обычно это локальная сеть в виде IP-адреса и маски подсети).

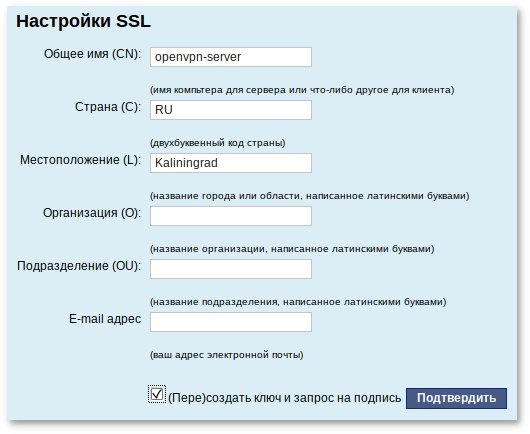

Для настройки сертификата и ключа ssl необходимо нажать на кнопку Сертификат и ключ ssl... Откроется окно модуля (пакет alterator-sslkey):

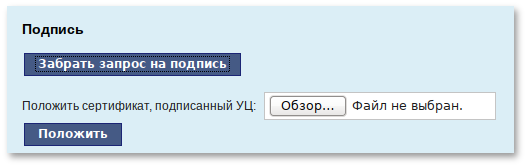

Здесь нужно заполнить поле Общее имя (CN) и поле Страна (С) (прописными буквами), отметить пункт (Пере)создать ключ и запрос на подпись и нажать кнопку Подтвердить. После чего станет активной кнопка Забрать запрос на подпись:

Если нажать на кнопку Забрать запрос на подпись, появится диалоговое окно с предложением сохранить файл openvpn-server.csr. Необходимо сохранить этот файл на диске.

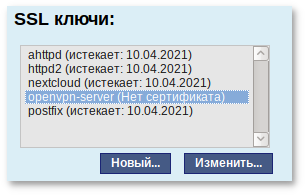

В модуле появился новый ключ openvpn-server (Нет сертификата):

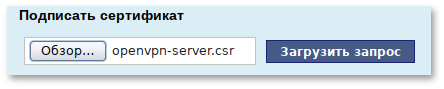

Чтобы подписать сертификат, необходимо перейти в модуль → , нажать кнопку Обзор, указать путь до полученного файла openvpn-server.csr и загрузить запрос:

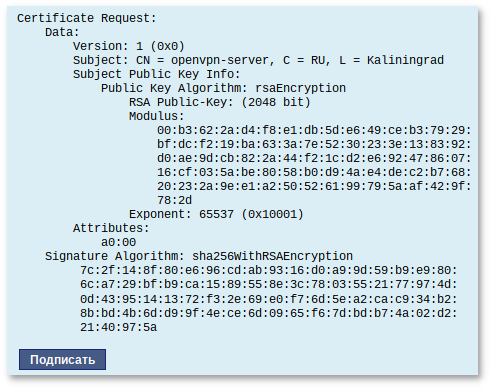

В результате на экране появится две группы цифр и кнопка Подписать. Необходимо нажать на кнопку Подписать и сохранить файл output.pem (подписанный сертификат).

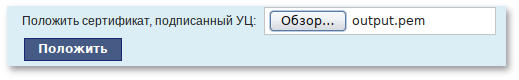

Далее в разделе , необходимо выделить ключ openvpn-server (Нет сертификата) и нажать кнопку Изменить. В появившемся окне, в пункте Положить сертификат, подписанный УЦ нужно нажать кнопку Обзор, указать путь до файла output.pem и нажать кнопку Положить:

В модуле , видно, что изменился ключ openvpn-server (истекает_и_дата). Ключ создан и подписан.

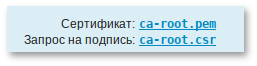

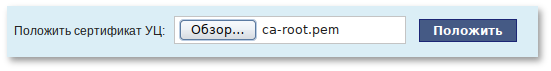

Для того чтобы положить сертификат УЦ, необходимо найти его в модуле , нажать на ссылку Управление УЦ и забрать сертификат, нажав на ссылку Сертификат: ca-root.pem: