Редакция январь, 2026

Аннотация

Примечание

apt-get позволяют пользователям легко обновлять свои системы и быть в курсе актуальных новинок мира свободных программ.

Содержание

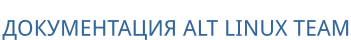

SCDWriter.exe;

Предупреждение

Предупреждение

Предупреждение

Предупреждение

dd:

#где <файл-образа.iso> — ISO-образ установочного диска с дистрибутивом, аddoflag=direct if=<файл-образа.iso> of=/dev/sdX bs=1M status=progress;sync

/dev/sdX — устройство, соответствующее flash-диску.

#где <файл-образа.iso> — ISO-образ диска, аpv<файл-образа.iso> | dd oflag=direct of=/dev/sdX bs=1M;sync

/dev/sdX — устройство, соответствующее flash-диску.

lsblk или (если такой команды нет) blkid.

$ lsblk | grep disk

sda 8:0 0 931,5G 0 disk

sdb 8:16 0 931,5G 0 disk

sdc 8:32 1 7,4G 0 disk

USB-диск имеет имя устройства sdc.

# dd oflag=direct if=/iso/alt-virtualization-one-11.0-x86_64.iso of=/dev/sdc bs=1M status=progress; sync

# pv /iso/alt-virtualization-one-11.0-x86_64.iso | dd oflag=direct of=/dev/sdc bs=1M;sync

dd: warning: partial read (524288 bytes); suggest iflag=fullblock

3GiB 0:10:28 [4,61MiB/s] [===================================> ] 72% ETA 0:04:07

Предупреждение

sudo dd if=alt-virtualization-one-11.0-x86_64.isoof=/dev/rdiskX bs=10Msync

alt-virtualization-one-11.0-x86_64.iso — ISO-образ диска, а /dev/rdiskX — flash-диск.

diskutil list

Предупреждение

$ du -b alt-virtualization-one-11.0-x86_64.iso | cut -f1

2760607744

$ md5sum alt-virtualization-one-11.0-x86_64.iso

e182bf50725dbdef572b9a61af83367e alt-virtualization-one-11.0-x86_64.iso

# head -c 2760607744 /dev/sdd | md5sum

e182bf50725dbdef572b9a61af83367e

где размер после -c — вывод в п.1, а /dev/sdd — устройство DVD или USB Flash, на которое производилась запись.

Предупреждение

Примечание

vncviewer --listen):

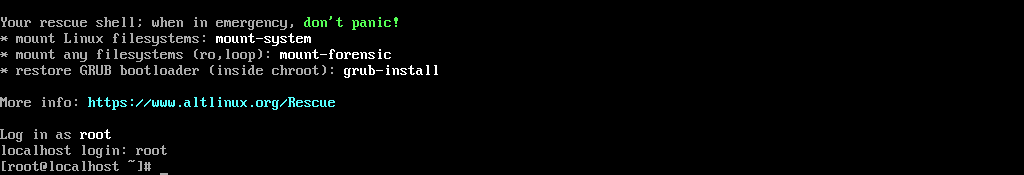

Log in as root localhost login:

Примечание

Примечание

Примечание

Примечание

… Running initinstall script [15-expert.sh] [ DONE ] 14:19:54 Running initinstall script [20-nodesign.sh] [ DONE ] 14:19:54 Running initinstall script [20-pts.sh] [ DONE ] 14:19:54 Running initinstall script [25-setup-dhcp.sh] [ DONE ] 14:19:54 Running initinstall script [26-metadata-autoinstall.sh] [ DONE ] 14:19:54 Running initinstall script [27-metadata-install-scripts.sh] [ DONE ] 14:19:54 Running initinstall script [30-ntp-client.sh] [ DONE ] 14:19:54 Running initinstall script [40-xorg.sh] [ DONE ] 14:19:54 Running initinstall script [50-removable] [ DONE ] 14:19:54 Running initinstall script [80-stop-md-dm.sh] [ DONE ] 11:19:59 Running initinstall script [85-start-multipath.sh] [ DONE ] 11:19:59 Running initinstall script [90-alteratord.sh] [ DONE ] 11:19:59 Running initinstall script [90-date.sh] [ DONE ] 11:19:59 Running initinstall script [90-pkg.sh] [ DONE ] 11:20:00 Running initinstall script [91-pkg-size.sh] [ DONE ] 11:20:01 Running initinstall script [95-virt-env.sh] [ DONE ] 11:20:01 Running initinstall script [98-oem.sh] [ DONE ] 11:20:01 Open debug shell on tty2 [ DONE ] 11:20:01 Open debug shell on tty3 [ DONE ] 11:20:01 ** IP(s): 192.168.0.95 ** VNC cmdline: vncpassword=Pa$$word The VNC desktop is: localhost.localdomain:0 PORT=5900

$ vncviewer 192.168.0.95

Примечание

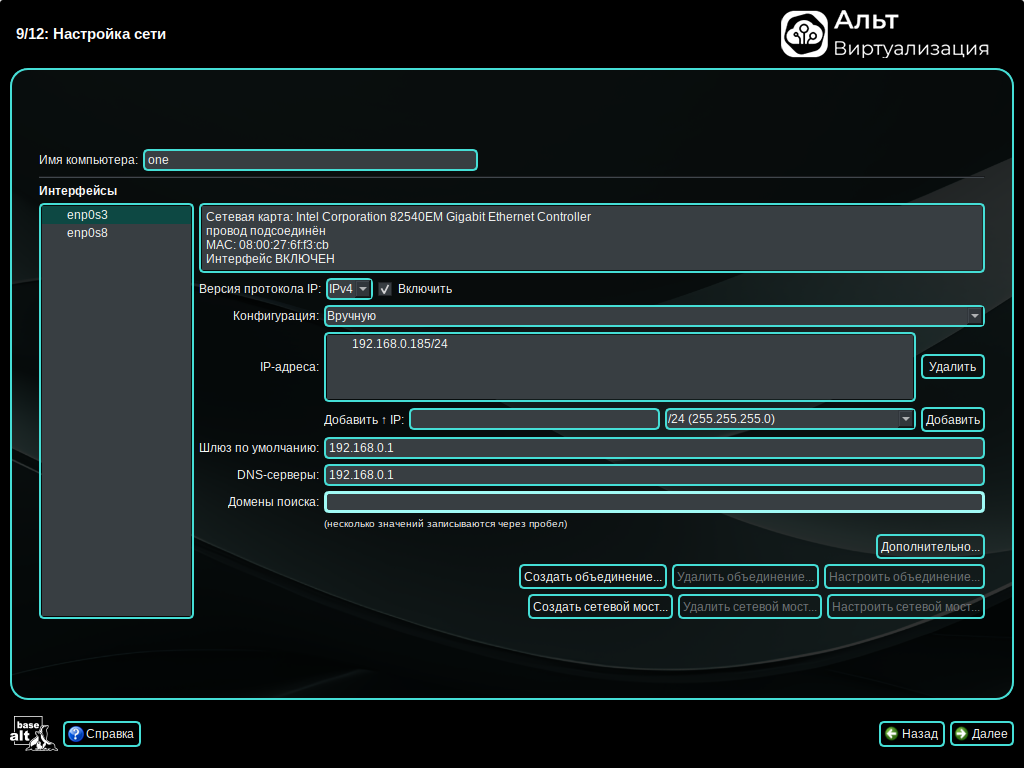

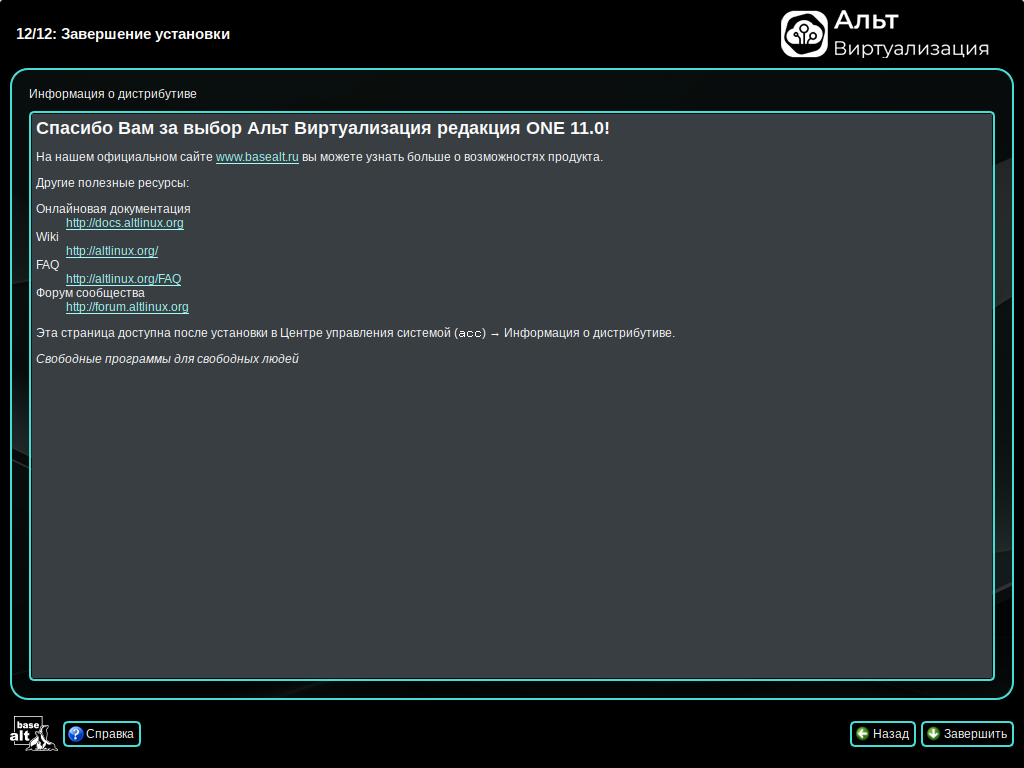

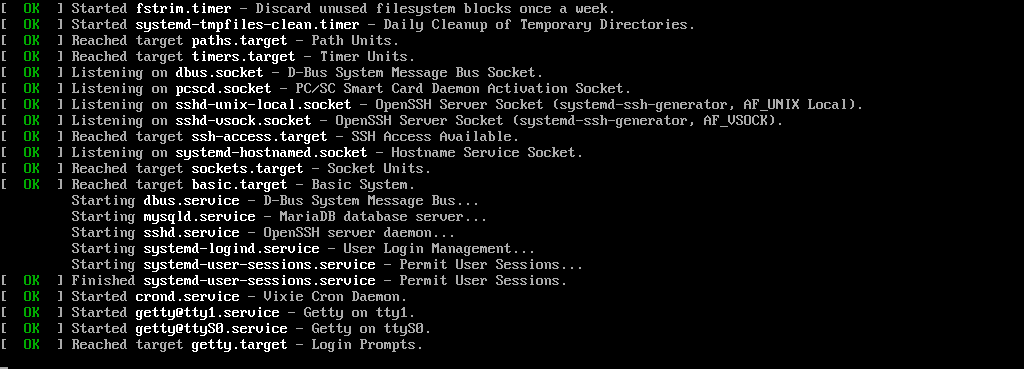

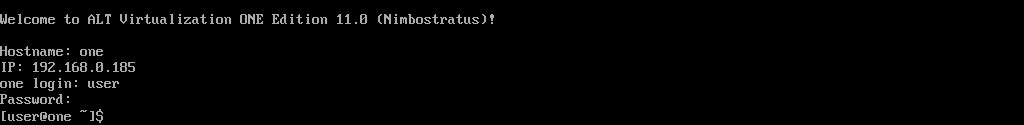

Welcome to ALT Virtualization ONE Edition 11.0 (Nimbostratus)! Hostname: one IP: 192.168.0.185 one login:

Примечание

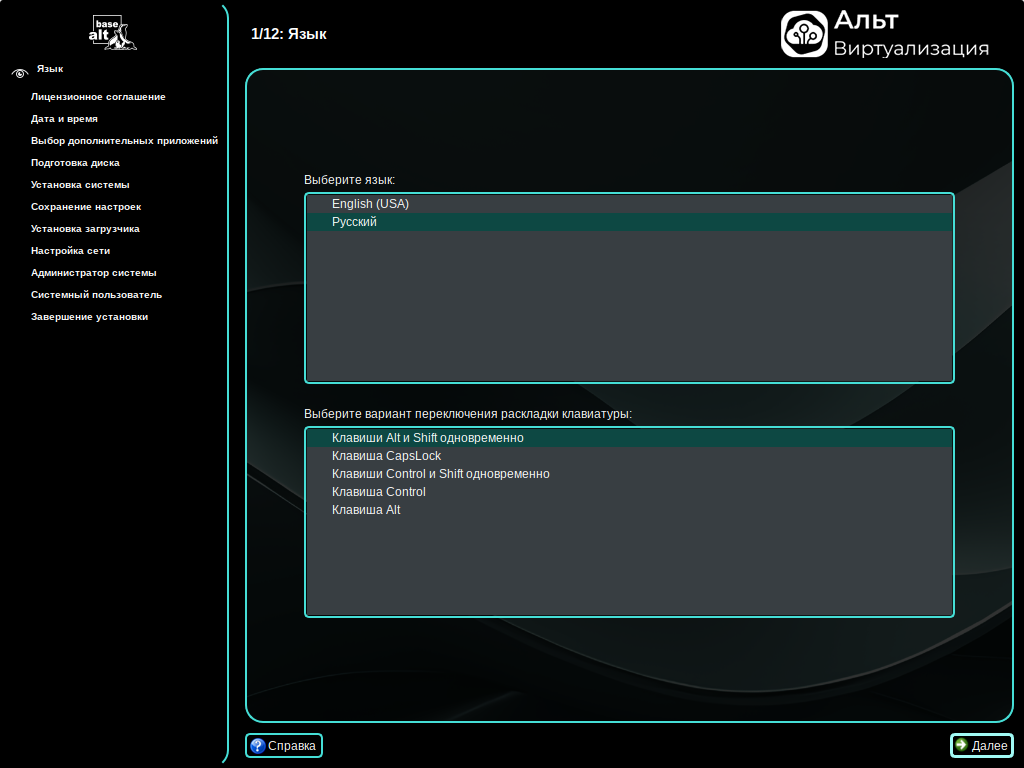

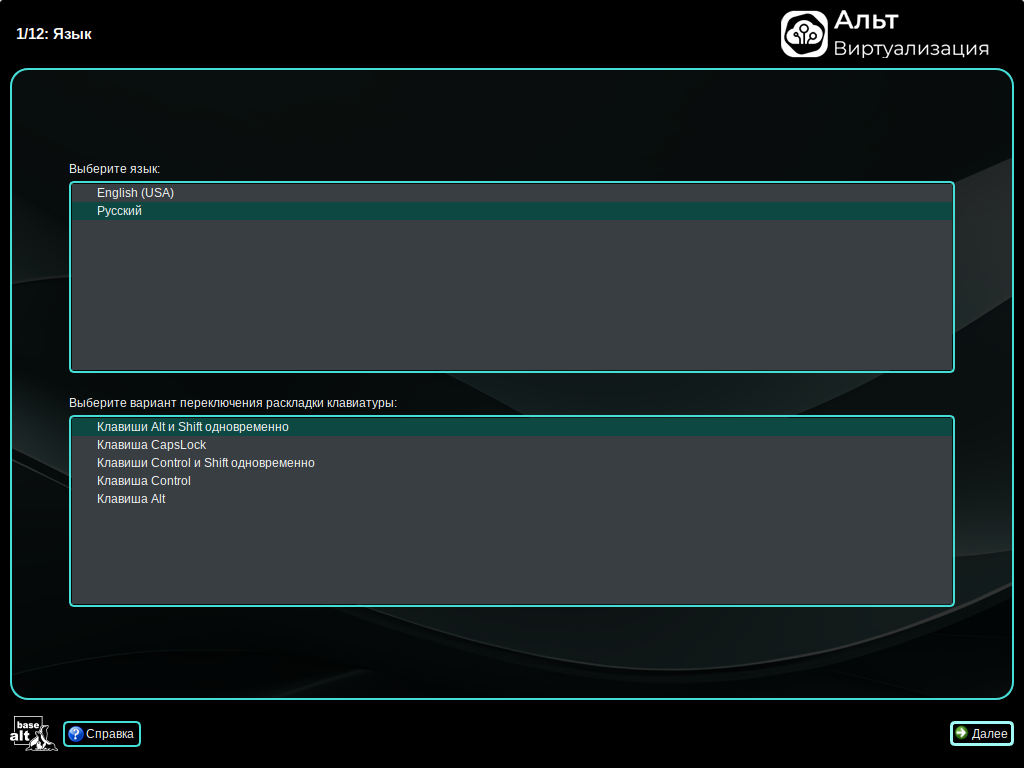

позволяет показать/скрыть панель со списком шагов установки:

позволяет показать/скрыть панель со списком шагов установки:

Примечание

Примечание

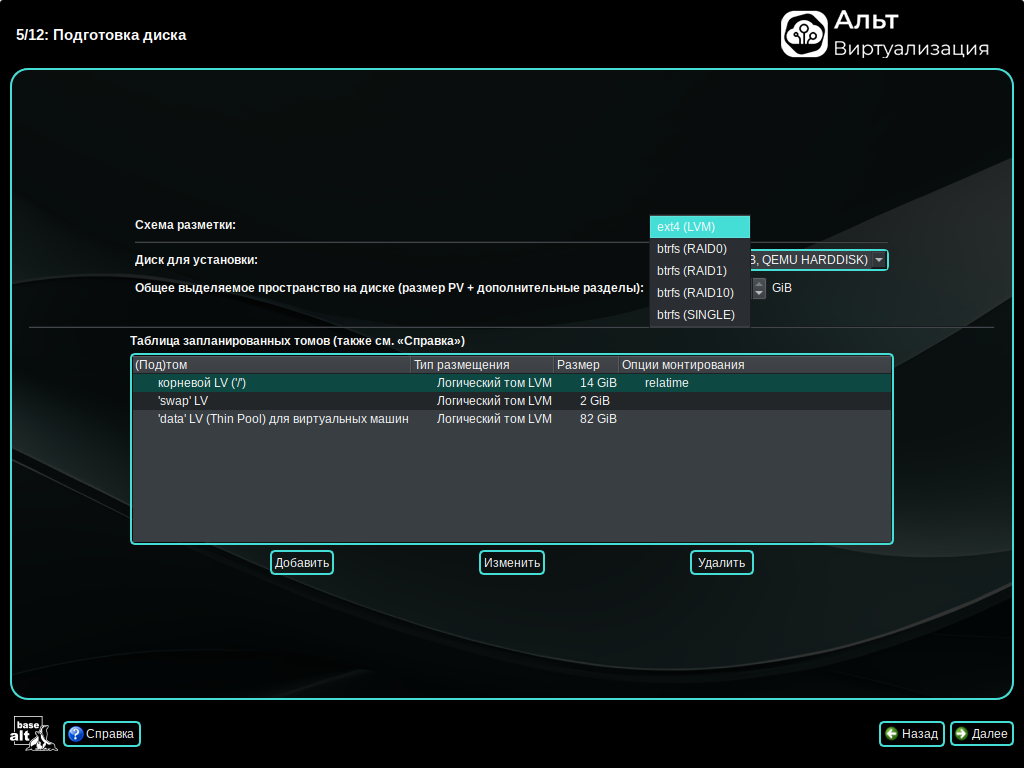

/boot);

Примечание

Примечание

Предупреждение

Примечание

# lsblk

NAME MAJ:MIN RM SIZE RO TYPE MOUNTPOINTS

sda 8:0 0 100G 0 disk

├─sda1 8:1 0 600M 0 part /boot/efi

└─sda2 8:2 0 99,4G 0 part

├─one-swap 253:0 0 2G 0 lvm [SWAP]

└─one-root 253:1 0 14G 0 lvm /

sr0 11:0 1 2,6G 0 rom

Примечание

Примечание

Примечание

Примечание

# btrfs subvolume list /

ID 256 gen 23 top level 5 path root

ID 257 gen 15 top level 256 path var/lib/machines

Предупреждение

/etc/fstab).

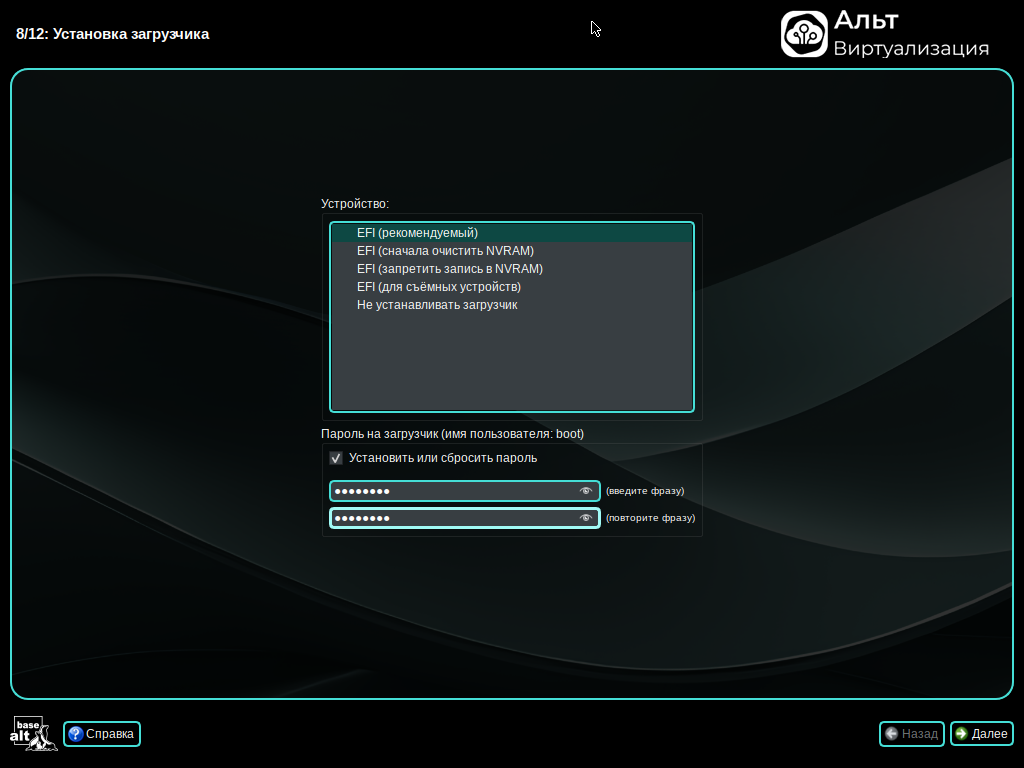

/root/.install-log, после чего из неё будут удалены все загрузочные записи, что приведёт к восстановлению полностью заполненной NVRAM и гарантирует загрузку вновь установленной ОС;

Примечание

Примечание

Примечание

Важно

#apt-get update#apt-get dist-upgrade#update-kernel#apt-get clean#reboot

Примечание

$ su -

или зарегистрировавшись в системе (например, на второй консоли Ctrl+Alt+F2) под именем root. Про режим суперпользователя можно почитать в главе Режим суперпользователя.

Примечание

Важно

Важно

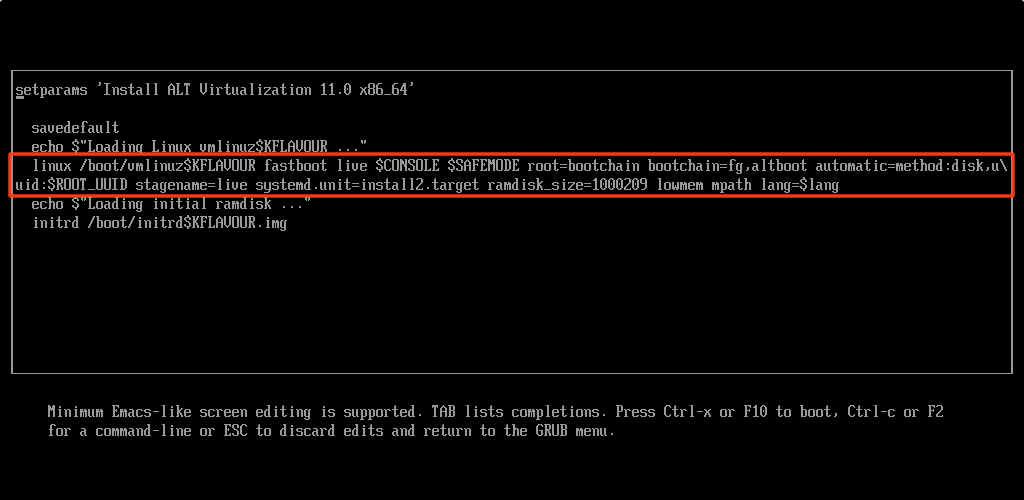

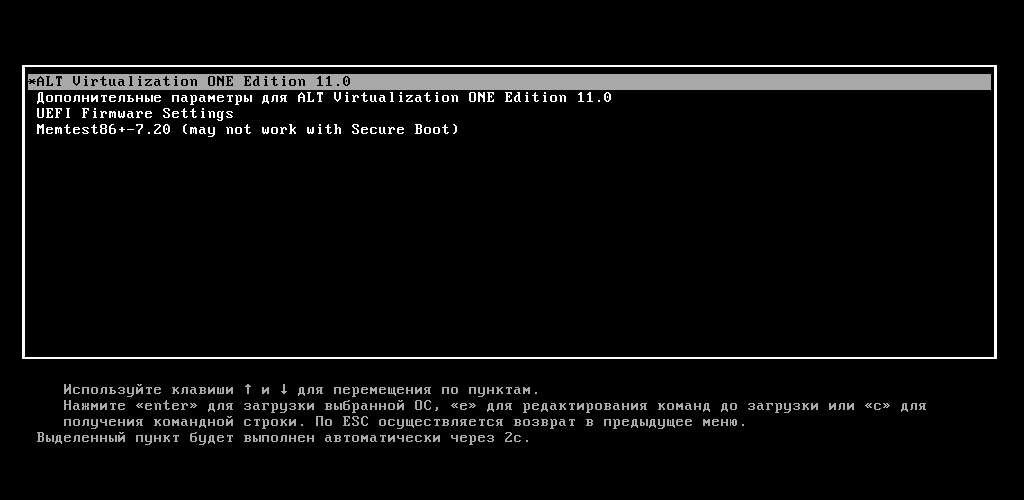

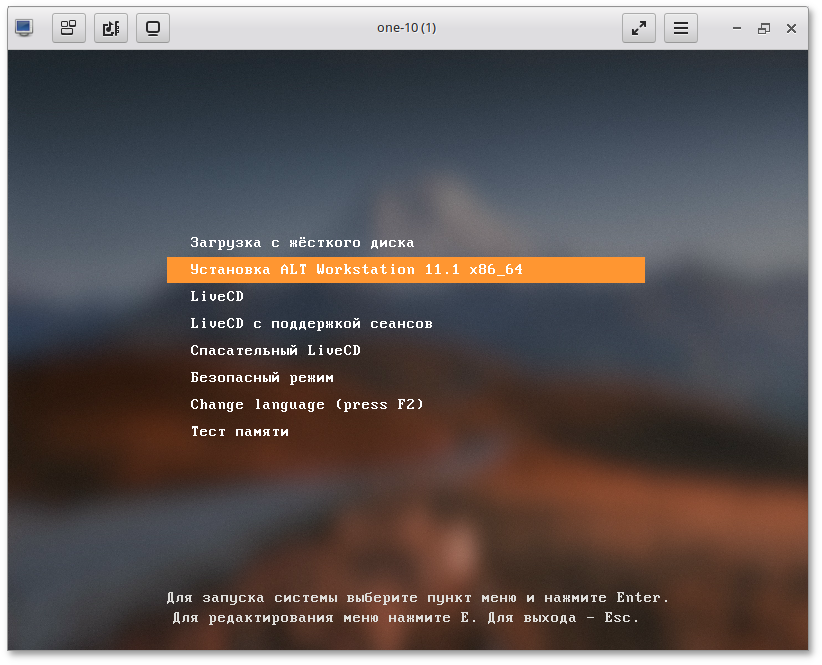

nomodeset — не использовать modeset-драйверы для видеокарты;

vga=normal — отключить графический экран загрузки установщика;

xdriver=vesa — явно использовать видеодрайвер vesa. Данным параметром можно явно указать нужный вариант драйвера;

acpi=off noapic — отключение ACPI (управление питанием), если система не поддерживает ACPI полностью.

apm=off acpi=off mce=off barrier=off vga=normal). В безопасном режиме отключаются все параметры ядра, которые могут вызвать проблемы при загрузке. В этом режиме установка будет произведена без поддержки APIC. Возможно, у вас какое-то новое или нестандартное оборудование, но может оказаться, что оно отлично настраивается со старыми драйверами.

Log in as root localhost login:После ввода логина логина суперпользователя (root) появится приглашение командной строки:

[root@localhost /]#. Начиная с этого момента, система готова к вводу команд.

fixmbr без параметров. Программа попытается переустановить загрузчик в автоматическом режиме.

Содержание

Важно

Примечание

Содержание

Таблица 24.1. Минимальные требования к серверу управления

|

Ресурс

|

Минимальное значение

|

|---|---|

|

Оперативная память

|

2 ГБ

|

|

CPU

|

1 CPU (2 ядра)

|

|

Диск

|

100 ГБ

|

|

Сеть

|

2 сетевых интерфейса

|

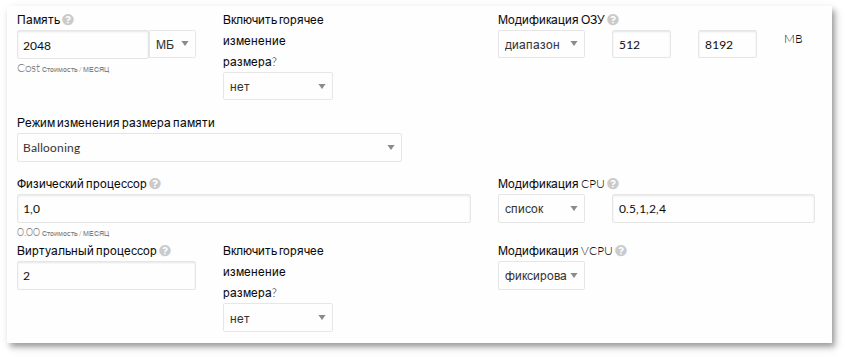

CPU и VCPU:

CPU определяет количество физических ядер, выделяемых ВМ;

VCPU — количество виртуальных процессоров, видимых гостевой ОС.

Важно

Примечание

/var/lib/one/.one/one_auth со случайно сгенерированным паролем. Необходимо изменить этот пароль перед первым запуском OpenNebula:

# passwd oneadmin

/var/lib/one/.one/one_auth. Он должен содержать следующее: oneadmin:<пароль>. Например:

$ echo "oneadmin:mypassword" > ~/.one/one_auth

Примечание

# mysql_secure_installation

$mysql -u root -pEnter password: MariaDB >CREATE USER 'oneadmin'@'localhost' IDENTIFIED BY '<пароль>';Query OK, 0 rows affected (0,007 sec) MariaDB >GRANT ALL PRIVILEGES ON opennebula.* TO 'oneadmin'@'localhost';Query OK, 0 rows affected (0,004 sec) MariaDB >SET GLOBAL TRANSACTION ISOLATION LEVEL READ COMMITTED;Query OK, 0 rows affected (0.001 sec) MariaDB >FLUSH PRIVILEGES;Query OK, 0 rows affected (0,001 sec) MariaDB >exit

/etc/one/oned.conf закомментируйте секцию sqlite, раскомментируйте и настройте секцию MySQL:

#DB = [ BACKEND = "sqlite",

# TIMEOUT = 2500 ]

# Sample configuration for MySQL

DB = [ BACKEND = "mysql",

SERVER = "localhost",

PORT = 0,

USER = "oneadmin",

PASSWD = "<пароль>",

DB_NAME = "opennebula",

CONNECTIONS = 25,

COMPARE_BINARY = "no" ]

где:

SERVER — IP-адрес/имя машины, на которой запущен сервер MySQL;

PORT — порт для подключения к СУБД. Значение 0 означает использование порта по умолчанию (3306 для MySQL/MariaDB);

USER — имя пользователя MySQL;

PASSWD — пароль MySQL;

DB_NAME — имя базы данных MySQL, которую будет использовать OpenNebula;

CONNECTIONS — максимальное количество подключений;

COMPARE_BINARY — включает учёт регистра при сравнении имён (используется оператор BINARY в SQL-запросах).

#systemctl enable --now opennebula#systemctl enable --now opennebula-sunstone

$ oneuser show

USER 0 INFORMATION

ID : 0

NAME : oneadmin

GROUP : oneadmin

PASSWORD : 3bc15c8aae3e4124dd409035f32ea2fd6835efc9

AUTH_DRIVER : core

ENABLED : Yes

USER TEMPLATE

TOKEN_PASSWORD="ec21d27e2fe4f9ed08a396cbd47b08b8e0a4ca3c"

VMS USAGE & QUOTAS

VMS USAGE & QUOTAS - RUNNING

DATASTORE USAGE & QUOTAS

NETWORK USAGE & QUOTAS

IMAGE USAGE & QUOTAS

http://<IP-адрес_сервера>:9869/var/lib/one/.one/one_auth):

Примечание

Важно

/var/lib/one/.ssh/authorized_keys на всех узлах инфраструктуры.

/var/lib/one/.ssh/id_rsa и /var/lib/one/.ssh/id_rsa.pub), а также открытый ключ добавляется в файл /var/lib/one/.ssh/authorized_keys.

Примечание

$ ssh-keygen -t rsa -f /var/lib/one/.ssh/id_rsa -N ""

known_hosts), чтобы все взаимодействующие стороны могли идентифицировать друг друга без запроса подтверждения.

/var/lib/one/.ssh/known_hosts. Для его создания и обновления используется команда ssh-keyscan, например:

$ ssh-keyscan <сервер_управления> <узел1> <узел2> <узел3> ... >> /var/lib/one/.ssh/known_hosts

Команду следует выполнить от имени пользователя oneadmin на сервере управления, после чего полученный файл необходимо скопировать на все узлы гипервизора.

Примечание

ssh-keyscan необходимо выполнять как для имён узлов, так и для их IP-адресов:

$ ssh-keyscan <IP-узел1> <hostname-узел1> ... >> /var/lib/one/.ssh/known_hosts

Например:

$ ssh-keyscan 192.168.0.185 server 192.168.0.190 host-01 >> /var/lib/one/.ssh/known_hosts

Важно

known_hosts необходимо обновлять и распространять заново каждый раз, когда:

known_hosts, созданный на предыдущем шаге;

#Распространение файлаsu - oneadmin$ssh-copy-id -i /var/lib/one/.ssh/id_rsa.pub <узел1>$ssh-copy-id -i /var/lib/one/.ssh/id_rsa.pub <узел2>$ssh-copy-id -i /var/lib/one/.ssh/id_rsa.pub <узел3>...

known_hosts:

$scp -p /var/lib/one/.ssh/known_hosts <узел1>:/var/lib/one/.ssh/$scp -p /var/lib/one/.ssh/known_hosts <узел2>:/var/lib/one/.ssh/$scp -p /var/lib/one/.ssh/known_hosts <узел3>:/var/lib/one/.ssh/...

Примечание

# от сервера управления к самому серверу управления ssh <сервер_управления> exit # от сервера управления к узлу1, обратно на сервер управления и к другим узлам ssh <узел1> ssh <сервер_управления> exit ssh <узел2> exit ssh <узел3> exit exitАналогичную проверку следует выполнить для всех узлов гипервизора.

Примечание

Примечание

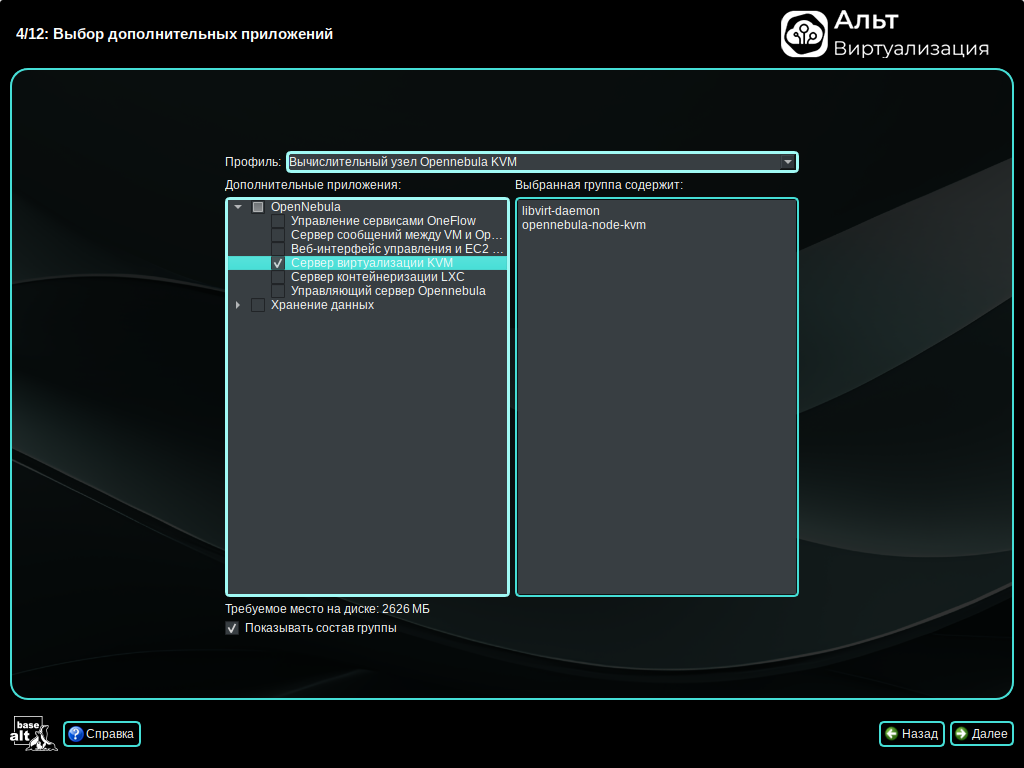

# apt-get install opennebula-node-kvm

Затем включите и запустите службу libvirtd:

# systemctl enable --now libvirtd

# passwd oneadmin

Важно

Примечание

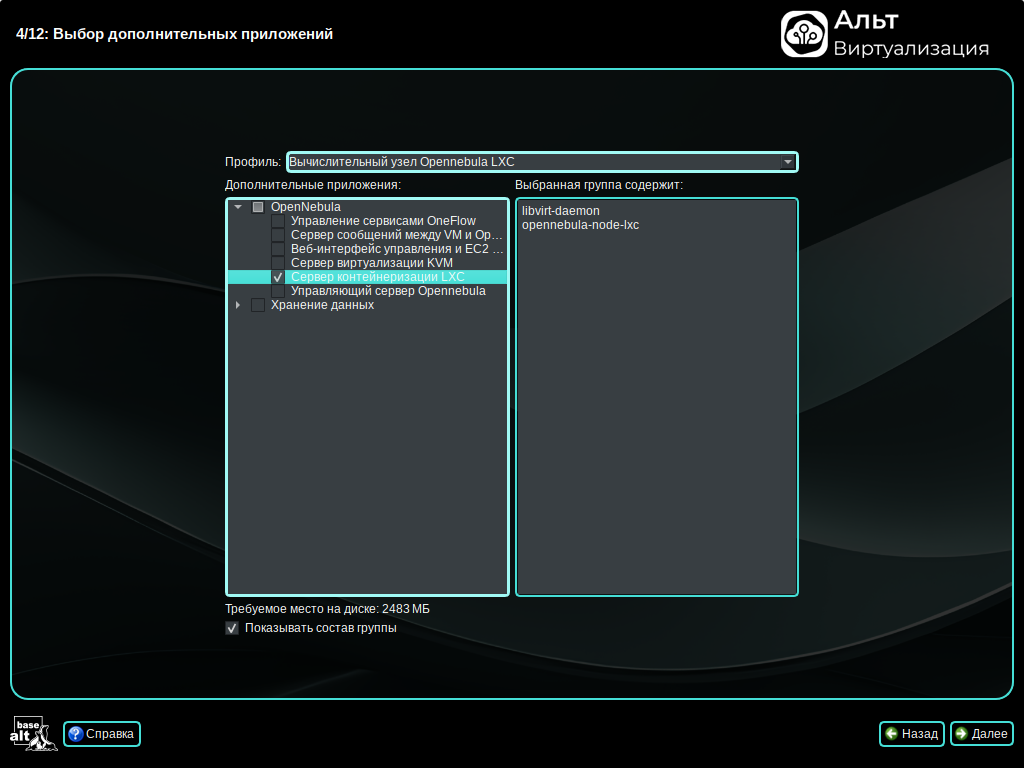

# apt-get install opennebula-node-lxc

# passwd oneadmin

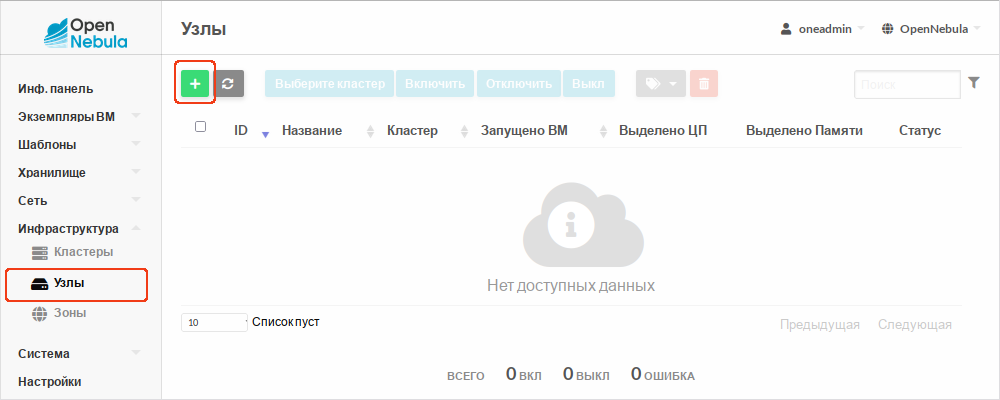

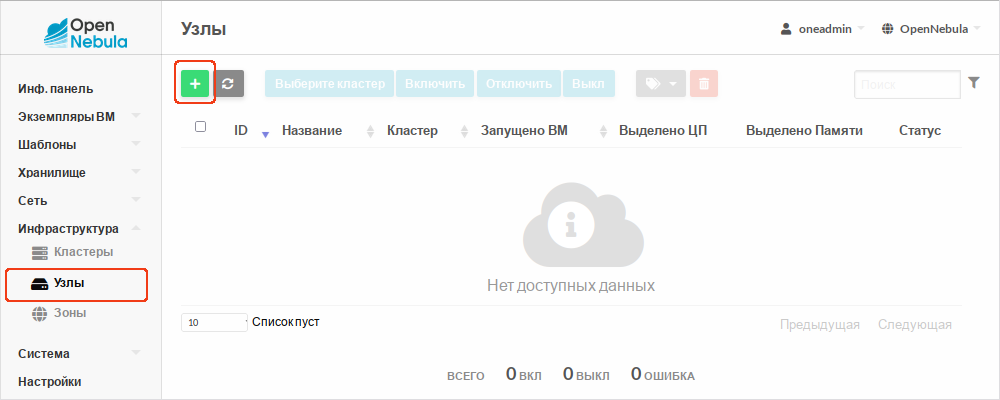

onehost);

Примечание

Примечание

/var/log/one/oned.log. Проблема может быть связана с подключением по SSH.

onehost предоставляет полный контроль над узлами OpenNebula. Описание всех доступных опций утилиты onehost можно получить, выполнив команду:

$ man onehost

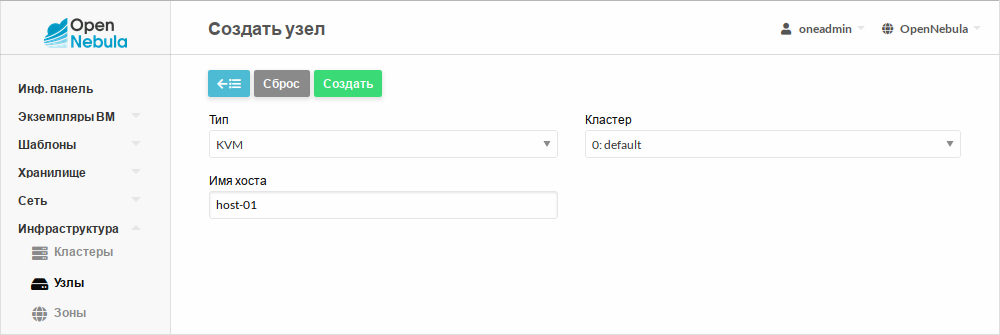

$ onehost create host-01 --im kvm --vm kvm

ID: 0

где:

--im — драйвер Information Manager;

--vm — драйвер Virtual Machine Manager.

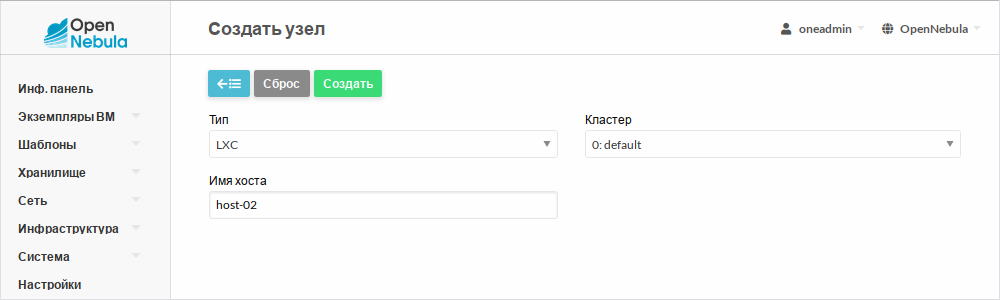

$ onehost create host-02 --im lxc --vm lxc

ID: 1

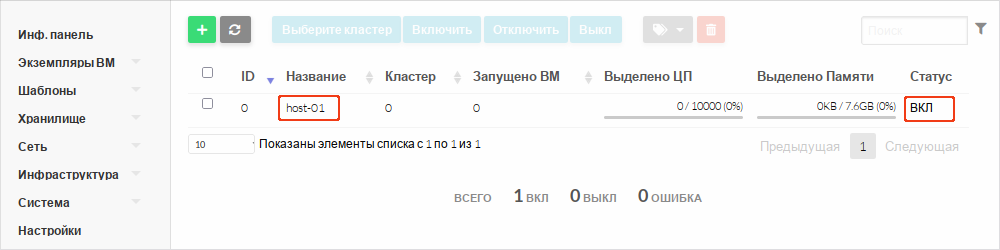

$ onehost list

ID NAME CLUSTER TVM ALLOCATED_CPU ALLOCATED_MEM STAT

1 host-02 default 0 0 / 100 (0%) 0K / 945M (0%) on

0 host-01 default 0 0 / 10000 (0%) 0K / 7.6G (0%) on

$onehost delete 1# с указанием ID $onehost delete host-02# с указанием имени

$onehost disable host-01// деактивировать (новые ВМ не запускаются) $onehost enable host-01// активировать $onehost offline host-01// перевести в автономный режим

disable и offline не останавливают и не мигрируют уже запущенные ВМ. Чтобы безопасно вывести узел из эксплуатации, следует использовать команду flush:

$ onehost flush host-01

Эта команда мигрирует все активные ВМ на другие узлы и отключает указанный узел.

flush можно настроить в файле конфигурации CLI /etc/one/cli/onehost.yaml:

:default_actions: - :flush: resched # или delete-recreateгде:

resched — перепланирование (миграция);

delete-recreate — остановка и пересоздание ВМ на другом узле.

$ onehost show host-01

Вывод данной команды содержит:

Таблица 27.1. Режимы работы

|

Режим

|

Мониторинг

|

Запуск ВМ (ручной)

|

Запуск ВМ (через планировщик)

|

Описание

|

|---|---|---|---|---|

|

ENABLED (on)

|

Да

|

Да

|

Да

|

Узел полностью рабочий

|

|

DISABLED (dsbl)

|

Да

|

Да

|

Нет

|

Узел отключен от планировщика (для обслуживания), но можно запускать ВМ вручную

|

|

OFFLINE (off)

|

Нет

|

Нет

|

Нет

|

Узел полностью выключен из системы

|

|

ERROR (err)

|

Да

|

Да

|

Нет

|

Ошибка мониторинга

|

|

RETRY (retry)

|

Да

|

Да

|

Нет

|

Повторная попытка мониторинга после ошибки

|

onevnet);

Примечание

onevnet доступно в справочном руководстве:

$ man onevnet

$ onevnet list

ID USER GROUP NAME CLUSTERS BRIDGE LEASES

2 oneadmin oneadmin VirtNetwork 0 onebr2 0

0 oneadmin oneadmin LAN 0 vmbr0 1

$ onevnet show 0

VN_MAD в шаблоне виртуальной сети.

dummy — без настройки моста (только для тестирования);

bridge () — стандартный мост без фильтрации трафика;

fw () — мост с применением правил групп безопасности с использованием iptables.

Примечание

/var/lib/one/remotes/etc/vnm/OpenNebulaNetwork.conf (см. табл. Параметры конфигурации).

Таблица 28.1. Параметры конфигурации

|

Параметр

|

Описание

|

|---|---|

:ipset_maxelem

|

Максимальное число записей в IP-наборах (для групп безопасности)

|

:keep_empty_bridge

|

Сохранять мосты без подключённых интерфейсов (true/false)

|

:ip_bridge_conf

|

Хеш параметров, передаваемых команде

ip при создании моста (ip link add <bridge> type bridge ...)

|

Примечание

$ onehost sync -f

BRIDGE;

Важно

PHYDEV.

Примечание

BRIDGE, отсутствует, OpenNebula не создаёт его автоматически, кроме случаев, когда задан PHYDEV. В этом случае мост будет создан при первом запуске ВМ.

net-bridged.conf:

NAME = "VirtNetwork"

VN_MAD = "bridge"

BRIDGE = "vmbr0"

PHYDEV = "enp3s0"

AR=[

TYPE = "IP4",

IP = "192.168.0.140",

SIZE = "5"

]

$ onevnet create net-bridged.conf

ID: 1

Таблица 28.2. Параметры виртуальной сети в режиме Bridged

|

Параметр

|

Значение

|

Обязательный

|

|---|---|---|

|

NAME

|

Имя виртуальной сети

|

Да

|

|

VN_MAD

|

Режим:

|

Да

|

|

BRIDGE

|

Имя сетевого моста на узлах виртуализации

|

Нет (кроме dummy)

|

|

PHYDEV

|

Имя физического сетевого устройства на узле виртуализации, подключаемого к мосту (не применяется в режиме dummy)

|

Нет

|

|

AR

|

Диапазон адресов, доступных в виртуальной сети

|

Нет

|

VLAN_TAGGED_ID. Он задаёт диапазон VLAN, разрешённых для трафика ВМ (поддерживаются списки тегов, разделённые запятыми, и диапазоны значений). Пример:

VLAN_TAGGED_ID = "100,105-107"В этом случае ВМ будет разрешено использовать VLAN 100, 105, 106 и 107.

Примечание

PHYDEV) подключается к мосту через VLAN-подынтерфейс (например, enp3s0.100);

Важно

PHYDEV, должен быть настроен в режиме trunk и разрешать передачу соответствующих VLAN.

VLAN_ID.

/etc/one/oned.conf:

VLAN_IDS = [

START = "2",

RESERVED = "0, 1, 4095"

]

где:

START — начальный VLAN ID для автоматического назначения;

RESERVED — список или диапазоны VLAN ID, которые не будут использоваться.

/var/lib/one/remotes/etc/vnm/OpenNebulaNetwork.conf (см. табл. Параметры конфигурации).

Таблица 28.3. Параметры конфигурации

|

Параметр

|

Описание

|

|---|---|

:validate_vlan_id

|

Проверять, что к мосту не подключены другие VLAN (true/false)

|

:keep_empty_bridge

|

Сохранять мосты без подключённых интерфейсов (true/false)

|

:ip_bridge_conf

|

Хеш параметров, передаваемых команде

ip при создании моста (ip link add <bridge> type bridge …)

|

:ip_link_conf

|

Хеш параметров, передаваемых команде

ip при создании VLAN-интерфейса (ip link add)

|

:ip_bridge_conf:

:stp_state: on

:ip_link_conf:

:udp6zerocsumrx:

:tos: 3

Примечание

$ onehost sync -f

net-vlan.conf:

NAME = "VLAN"

VN_MAD = "802.1Q"

BRIDGE = "vmbr1"

PHYDEV = "enp3s0"

AUTOMATIC_VLAN_ID = "Yes"

AR=[

TYPE = "IP4",

IP = "192.168.0.150",

SIZE = "5"

]

$ onevnet create net-vlan.conf

ID: 6

Таблица 28.4. Параметры виртуальной сети в режиме 802.1Q

|

Параметр

|

Значение

|

Обязательный

|

|---|---|---|

|

NAME

|

Имя виртуальной сети

|

Да

|

|

VN_MAD

|

802.1Q

|

Да

|

|

BRIDGE

|

Имя сетевого моста (по умолчанию onebr<net_id> или onebr.<vlan_id>)

|

Нет

|

|

PHYDEV

|

Имя физического сетевого устройства на узле виртуализации

|

Да

|

|

VLAN_ID

|

Идентификатор VLAN (если не указан и AUTOMATIC_VLAN_ID = "YES", генерируется автоматически)

|

Да (если AUTOMATIC_VLAN_ID = "NO")

|

|

AUTOMATIC_VLAN_ID

|

Автоматически генерировать VLAN_ID

|

Да (если не указан VLAN_ID)

|

|

MTU

|

MTU для тегированного интерфейса и моста

|

Нет

|

|

AR

|

Диапазон адресов, доступных в виртуальной сети

|

Нет

|

CVLANS:

VLAN_ID);

CVLANS, инкапсулируется во внешний VLAN;

Примечание

Таблица 28.5. Параметры виртуальной сети в режиме Q-in-Q

|

Параметр

|

Значение

|

Обязательный

|

|---|---|---|

VLAN_ID

|

Внешний (сервисный) VLAN ID

|

Да (если AUTOMATIC_VLAN_ID = "NO")

|

CVLANS

|

Список разрешённых клиентских VLAN (через запятую, поддерживаются диапазоны)

|

Да

|

NAME = "qinq_net" VN_MAD = "802.1Q" PHYDEV = eth0 VLAN_ID = 50 # Идентификатор сервисного VLAN CVLANS = "101,103,110-113" # Список клиентских VLAN

Примечание

CVLANS можно изменять динамически — правила фильтрации будут обновлены без перезапуска ВМ.

CVLANS:

Примечание

Примечание

IP_LINK_CONF.

VLAN_ID.

Примечание

PHYDEV), используемый для передачи трафика, должен иметь назначенный IP-адрес.

PHYDEV — это физический интерфейс, а VXLAN_ID — идентификатор VXLAN (VNI). К этому мосту подключаются сетевые интерфейсы.

Примечание

# ip link set en0s0f0p0 alias vx

и затем использовать устройство vx в качестве PHYDEV.

net.ipv4.igmp_max_memberships. Для постоянного увеличения, например до 150, добавьте в файл /etc/sysctl.conf:

net.ipv4.igmp_max_memberships=150и примените настройки:

# sysctl -p

/etc/one/oned.conf:

VXLAN_IDS = [

START = "2"

]

/var/lib/one/remotes/etc/vnm/OpenNebulaNetwork.conf (см. табл. Параметры конфигурации).

Таблица 28.6. Параметры конфигурации

|

Параметр

|

Описание

|

|---|---|

:vxlan_mc

|

Базовый multicast-адрес (например, "239.0.0.0"). Фактический адрес вычисляется как

vxlan_mc + VNI

|

:vxlan_ttl

|

TTL для multicast-трафика (должен быть >1 при маршрутизации)

|

:validate_vlan_id

|

Проверять конфликты VLAN (true/false)

|

:keep_empty_bridge

|

Сохранять мосты без ВМ (true/false)

|

:ip_bridge_conf

|

Хеш параметров, передаваемых команде

ip при создании моста (ip link add <bridge> type bridge …)

|

:ip_link_conf

|

Хеш параметров, передаваемых команде

ip при создании VXLAN-интерфейса (ip link add)

|

:ip_link_conf:

:udp6zerocsumrx:

:tos: 3

Примечание

$ onehost sync -f

net-vxlan.conf:

NAME = "vxlan"

VN_MAD = "vxlan"

BRIDGE = "vxlan50"

PHYDEV = "enp3s0"

VLAN_ID = 50

AR=[

TYPE = "IP4",

IP = "192.168.0.150",

SIZE = "5"

]

$ onevnet create net-vxlan.conf

ID: 7

Таблица 28.7. Параметры виртуальной сети в режиме VXLAN

|

Параметр

|

Значение

|

Обязательный

|

|---|---|---|

|

NAME

|

Имя виртуальной сети

|

Да

|

|

VN_MAD

|

vxlan

|

Да

|

|

PHYDEV

|

Имя физического сетевого устройства

|

Нет

|

|

BRIDGE

|

Имя сетевого моста (по умолчанию onebr<net_id> или onebr.<vlan_id>)

|

Нет

|

|

VLAN_ID

|

Идентификатор VXLAN (если не указан и AUTOMATIC_VLAN_ID = "YES", генерируется автоматически)

|

Да (если AUTOMATIC_VLAN_ID = "NO")

|

|

AUTOMATIC_VLAN_ID

|

Автоматически генерировать VLAN_ID

|

Да (если не указан VLAN_ID)

|

|

MTU

|

MTU для VXLAN-интерфейса и моста

|

Нет

|

|

VXLAN_MODE

|

Режим работы: multicast (по умолчанию) или evpn

|

Нет

|

|

VXLAN_TEP

|

Тип адреса конечной точки туннеля (только для evpn): dev или local_ip

|

Нет

|

|

VXLAN_MC

|

Базовый multicast-адрес (MC = vxlan_mc + vlan_id)

|

Нет

|

|

IP_LINK_CONF

|

Параметры команды

ip, специфичные для данной сети. Формат: option=value (IP_LINK_CONF="option1=value1,option2=,option3=value3,...")

|

Нет

|

|

AR

|

Диапазон адресов виртуальной сети

|

Нет

|

Примечание

VXLAN_MODE, VXLAN_TEP и VXLAN_MC можно задать глобально в файле /var/lib/one/remotes/etc/vnm/OpenNebulaNetwork.conf. Для переопределения на уровне отдельной сети используйте IP_LINK_CONF, например:

IP_LINK_CONF = "dstport=4789,ttl=16"

Примечание

PHYDEV.

Примечание

# apt-get install openvswitch

# systemctl enable --now openvswitch.service

VLAN_ID.

/etc/one/oned.conf:

VLAN_IDS = [

START = "2",

RESERVED = "0, 1, 4095"

]

где

START — начальный ID для автоматического назначения;

RESERVED — список или диапазоны ID, которые не будут использоваться (например, 100:200).

/var/lib/one/remotes/etc/vnm/OpenNebulaNetwork.conf (см. табл. Параметры конфигурации).

Таблица 28.8. Параметры конфигурации

|

Параметр

|

Описание

|

|---|---|

:arp_cache_poisoning

|

Включить защиту от ARP-spoofing (работает только при активных правилах IP/MAC anti-spoofing) (true/false)

|

:keep_empty_bridge

|

Сохранять мосты без ВМ (true/false)

|

:ovs_bridge_conf

|

Хеш параметров для создания моста Open vSwitch (

ovs-vsctl add-br)

|

Примечание

$ onehost sync -f

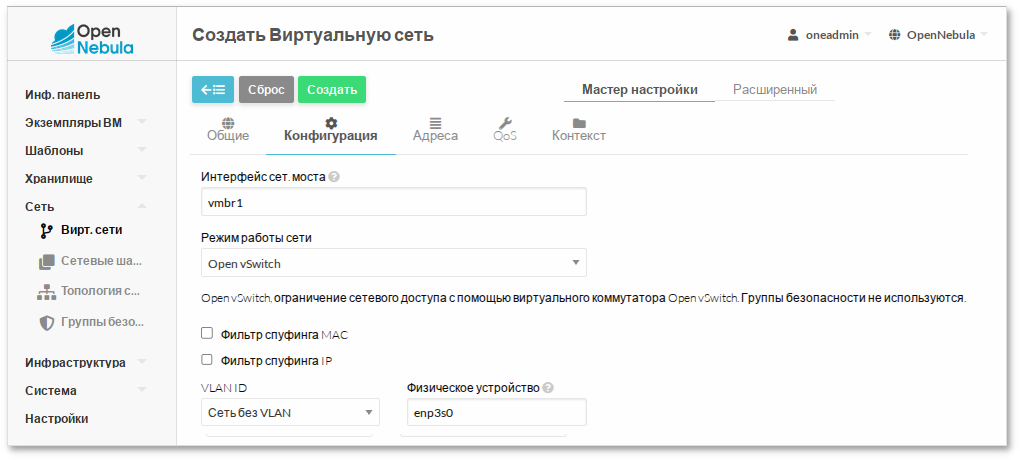

net-ovs.conf:

NAME = "OVS"

VN_MAD = "ovswitch"

BRIDGE = "vmbr1"

AR=[

TYPE = "IP4",

IP = "192.168.0.150",

SIZE = "5"

]

$ onevnet create net-ovs.conf

ID: 8

Таблица 28.9. Параметры виртуальной сети в режиме Open vSwitch

|

Параметр

|

Значение

|

Обязательный

|

|---|---|---|

|

NAME

|

Имя виртуальной сети

|

Да

|

|

VN_MAD

|

ovswitch

|

Да

|

|

BRIDGE

|

Имя моста Open vSwitch

|

Нет

|

|

PHYDEV

|

Физический интерфейс для привязки (обязателен при использовании VLAN)

|

Нет (если не используются VLAN)

|

|

VLAN_ID

|

Идентификатор VLAN (если не указан и AUTOMATIC_VLAN_ID = "YES", генерируется автоматически)

|

Нет

|

|

AUTOMATIC_VLAN_ID

|

Автоматически генерировать VLAN_ID (игнорируется, если задан VLAN_ID)

|

Нет

|

|

MTU

|

MTU для моста Open vSwitch

|

Нет

|

|

AR

|

Диапазон адресов виртуальной сети

|

Нет

|

Примечание

PHYDEV не указан, мост создаётся изолированным и не имеет подключения к физической сети.

VLAN_TAGGED_ID в шаблоне сети или ВМ:

VLAN_TAGGED_ID = "1,10,30,32,100-200"Это настроит порт Open vSwitch в режиме trunk, разрешающем передачу указанных VLAN.

OUTER_VLAN_ID;

VLAN_ID) на портах ВМ.

Важно

net-ovsx.conf:

NAME = "private"

VN_MAD = "ovswitch_vxlan"

PHYDEV = "eth0"

BRIDGE = "ovsvxbr0.10000"

OUTER_VLAN_ID = 10000

VLAN_ID = 50

AR=[

TYPE = "IP4",

IP = "192.168.0.150",

SIZE = "5"

]

$ onevnet create net-ovsx.conf

ID: 11

Таблица 28.10. Параметры виртуальной сети в режиме Open vSwitch VXLAN

|

Параметр

|

Значение

|

Обязательный

|

|---|---|---|

|

NAME

|

Имя виртуальной сети

|

Да

|

|

VN_MAD

|

ovswitch_vxlan

|

Да

|

|

BRIDGE

|

Имя моста Open vSwitch

|

Нет

|

|

PHYDEV

|

Имя физического сетевого устройства

|

Да

|

|

OUTER_VLAN_ID

|

Идентификатор внешней сети VXLAN (если не указан и AUTOMATIC_OUTER_VLAN_ID = "YES", генерируется автоматически)

|

Да (если AUTOMATIC_OUTER_VLAN_ID = "NO")

|

|

AUTOMATIC_OUTER_VLAN_ID

|

Генерировать OUTER_VLAN_ID автоматически (игнорируется, если задан вручную)

|

Да (если не указан OUTER_VLAN_ID)

|

|

VLAN_ID

|

Внутренний VLAN ID 802.1Q (если не указан и AUTOMATIC_VLAN_ID = "YES", генерируется автоматически)

|

Нет

|

|

AUTOMATIC_VLAN_ID

|

Автоматически генерировать VLAN_ID (игнорируется, если определен VLAN_ID)

|

Нет

|

|

MTU

|

MTU для VXLAN-интерфейса и моста

|

Нет

|

|

AR

|

Диапазон адресов виртуальной сети

|

Нет

|

/var/lib/one/datastores/<ID_хранилища>). Кроме того, для каждой запущенной ВМ в системном хранилище создаётся каталог /var/lib/one/datastores/<ID_хранилища>/<ID_ВМ>. В этих каталогах размещаются диски ВМ и дополнительные файлы, например контрольные точки и снимки.

/var/lib/one/datastores |-- 0/ | |-- 0/ | | |-- disk.0 | | `-- disk.1 | |-- 2/ | | `-- disk.0 | `-- 7/ | |-- checkpoint | `-- disk.0 `-- 1 |-- 19217fdaaa715b04f1c740557826514b |-- 99f93bd825f8387144356143dc69787d `-- da8023daf074d0de3c1204e562b8d8d2

Примечание

/var/lib/one/datastores можно изменить в файле /etc/one/oned.conf с помощью параметра DATASTORE_LOCATION.

ssh использует локальные файловые системы узлов для размещения образов работающих ВМ. Все файловые операции выполняются локально, однако образы копируются на узлы по SSH при каждом запуске ВМ. Это может быть ресурсоёмкой операцией, особенно в крупных кластерах.

shared предполагает, что хранилище данных смонтировано на всех узлах кластера (узле управления и вычислительных узлах). Обычно это реализуется с помощью общей файловой системы, например NFS или GlusterFS.

ln, cp и т. д.) выполняются локально на узле. Такой режим передачи, как правило, сокращает время развёртывания ВМ и обеспечивает возможность live-migration, однако может стать узким местом инфраструктуры и негативно повлиять на производительность ВМ при высоких дисковых нагрузках.

disk.i) копируются или связываются в соответствующем каталоге системного хранилища. Эти операции всегда выполняются на целевом узле.

lvm предназначен для работы с SAN-сетями (iSCSI, Fibre Channel). Один и тот же LUN может быть экспортирован на все узлы кластера, при этом виртуальные машины работают непосредственно с SAN.

/var/lib/one/datastores/<ID_хранилища>), однако при запуске ВМ они преобразуются в логические тома (LV) на узле. ВМ запускаются непосредственно на этих логических томах.

/var/lib/one/datastores/<ID_хранилища>) и драйвер передачи ssh.

onedatastore);

Примечание

onedatastore доступно в справочном руководстве:

$ man onedatastore

$ onedatastore list

ID NAME SIZE AVA CLUSTERS IMAGES TYPE DS TM STAT

2 files 195.8G 94% 0 0 fil fs ssh on

1 default 195.8G 94% 0 2 img fs ssh on

0 system - - 0 0 sys - ssh on

$ onedatastore show default

DATASTORE 1 INFORMATION

ID : 1

NAME : default

USER : oneadmin

GROUP : oneadmin

CLUSTERS : 0

TYPE : IMAGE

DS_MAD : fs

TM_MAD : ssh

BASE PATH : /var/lib/one//datastores/1

DISK_TYPE : FILE

STATE : READY

DATASTORE CAPACITY

TOTAL: : 195.8G

FREE: : 183.3G

USED: : 2.5G

LIMIT: : -

PERMISSIONS

OWNER : um-

GROUP : u--

OTHER : ---

DATASTORE TEMPLATE

ALLOW_ORPHANS="YES"

CLONE_TARGET="SYSTEM"

DISK_TYPE="FILE"

DS_MAD="fs"

LN_TARGET="SYSTEM"

RESTRICTED_DIRS="/"

SAFE_DIRS="/var/tmp"

TM_MAD="ssh"

TYPE="IMAGE_DS"

IMAGES

0

1

2

17

$ onedatastore show system

DATASTORE 0 INFORMATION

ID : 0

NAME : system

USER : oneadmin

GROUP : oneadmin

CLUSTERS : 0

TYPE : SYSTEM

DS_MAD : -

TM_MAD : ssh

BASE PATH : /var/lib/one//datastores/0

DISK_TYPE : FILE

STATE : READY

DATASTORE CAPACITY

TOTAL: : -

FREE: : -

USED: : -

LIMIT: : -

PERMISSIONS

OWNER : um-

GROUP : u--

OTHER : ---

DATASTORE TEMPLATE

ALLOW_ORPHANS="YES"

DISK_TYPE="FILE"

DS_MIGRATE="YES"

RESTRICTED_DIRS="/"

SAFE_DIRS="/var/tmp"

SHARED="NO"

TM_MAD="ssh"

TYPE="SYSTEM_DS"

IMAGES

INFORMATION — базовая информация (имя, путь, тип хранилища) и используемые драйверы (DS_MAD и TM_MAD);

CAPACITY — показатели использования дискового пространства (общее, свободное и использованное);

TEMPLATE — атрибуты хранилища;

IMAGES — список образов, размещённых в хранилище.

DS_MAD="fs") и SSH для передачи (TM_MAD="ssh"). Для системного хранилища указывается только драйвер передачи (TM_MAD), а показатели использования (CAPACITY) не отображаются, поскольку драйвер ssh использует локальное хранилище каждого узла.

Примечание

$ onehost show <ID_узла>

Таблица 29.1. Общие атрибуты хранилищ

|

Атрибут

|

Описание

|

|---|---|

Description

|

Произвольное описание

|

RESTRICTED_DIRS

|

Каталоги, запрещённые для размещения образов (через пробел)

|

SAFE_DIRS

|

Исключения из

RESTRICTED_DIRS (через пробел)

|

NO_DECOMPRESS

|

Не распаковывать архивы при регистрации

|

LIMIT_TRANSFER_BW

|

Ограничение скорости загрузки (в байтах/с; допускаются суффиксы K, M, G)

|

DATASTORE_CAPACITY_CHECK

|

Проверять свободное место перед созданием образа

|

LIMIT_MB

|

Максимальный размер хранилища (в МБ)

|

BRIDGE_LIST

|

Список мостов, имеющих доступ к хранилищу (через пробел)

|

STAGING_DIR

|

Каталог для временных файлов (по умолчанию

/var/tmp)

|

DRIVER

|

Драйвер работы с образами (переопределяет настройки образа)

|

COMPATIBLE_SYS_DS

|

Только для хранилищ образов. Список совместимых системных хранилищ (например, «0,100»)

|

CONTEXT_DISK_TYPE

|

Тип диска для контекстуализации: BLOCK или FILE (по умолчанию)

|

Примечание

BRIDGE_LIST на узлах должны быть установлены инструменты доступа к хранилищу и утилиты виртуализации (например, qemu-img).

$onedatastore disable system$onedatastore show systemDATASTORE 0 INFORMATION ID : 0 NAME : system ... STATE : DISABLED ...

/var/lib/one/datastores/ для:

/var/lib/one/datastores/ для хранения дисков ВМ, запущенных на данном узле.

/etc/hosts);

ssh необходимо зарегистрировать два хранилища: системное и хранилище образов.

systemds.conf:

NAME = local_system TM_MAD = ssh TYPE = SYSTEM_DS

$ onedatastore create systemds.conf

ID: 101

NAME — название хранилища;

TYPE — SYSTEM_DS;

TM_MAD — ssh (режим передачи данных).

imageds.conf:

NAME = local_image TM_MAD = ssh TYPE = IMAGE_DS DS_MAD = fs

$ onedatastore create imageds.conf

ID: 102

NAME — название хранилища;

DS_MAD — fs (файловый драйвер хранилища данных);

TYPE — IMAGE_DS;

TM_MAD — ssh (режим передачи данных);

CONVERT — yes (по умолчанию) или no; при значении yes формат образа будет преобразован в формат, поддерживаемый драйвером.

Примечание

TM_MAD), в данном случае — ssh.

ssh могут быть заданы следующие дополнительные параметры:

DD_BLOCK_SIZE — размер блока для операций dd (по умолчанию: 64 КБ). Может быть задан в файле /var/lib/one/remotes/etc/datastore/fs/fs.conf;

SUPPORTED_FS — список файловых систем, поддерживаемых для создания форматированных блоков данных (через запятую). Может быть установлен в файле /var/lib/one/remotes/etc/datastore/datastore.conf;

FS_OPTS_<FS> — параметры создания файловой системы для форматированных блоков данных. Указывается отдельно для каждого типа файловой системы в файле /var/lib/one/remotes/etc/datastore/datastore.conf;

SPARSE — если установлено в NO, файлы будут занимать всё выделенное пространство (неразрежённые файлы). Требует установки параметра QCOW2_STANDALONE="YES" в системном хранилище.

Примечание

TM_MAD=ssh:

qemu-img;

dd или tar;

QCOW2_OPTIONS игнорируется.

Примечание

/var/lib/one/datastores/<ID_хранилища>. Если все хранилища данных относятся к одному типу, допускается монтирование всего каталога /var/lib/one/datastores/.

Примечание

Примечание

soft, intr, rsize=32768, wsize=32768При использовании данной конфигурации libvirt/kvm доступ к файлам образов осуществляется от имени пользователя oneadmin.

no_root_squash на NFS-сервере:

/export *(rw,sync,no_root_squash)

/var/lib/one/datastores/<ID_хранилища>.

systemds.conf:

NAME = nfs_system TM_MAD = shared TYPE = SYSTEM_DS

$ onedatastore create systemds.conf

ID: 103

NAME — название хранилища;

TYPE — SYSTEM_DS;

TM_MAD — shared (режим общей файловой системы);

BRIDGE_LIST — список узлов с подключённым системным хранилищем (через пробел).

imageds.conf:

NAME = nfs_images DS_MAD = fs TM_MAD = shared TYPE = IMAGE_DS

$ onedatastore create imageds.conf

ID: 104

NAME — название хранилища;

DS_MAD — fs (файловый драйвер);

TYPE — IMAGE_DS;

TM_MAD — shared (режим общей файловой системы);

CONVERT — yes (по умолчанию) или no; при yes формат образа будет преобразован в формат, поддерживаемый драйвером.

Примечание

TM_MAD_SYSTEM будет установлен после выбора хранилища данных.

Примечание

TM_MAD).

/var/lib/one/datastores/ будут созданы каталоги 103 и 104. На узлах виртуализации эти каталоги не создаются автоматически, поэтому их необходимо создать вручную:

$mkdir /var/lib/one/datastores/103$mkdir /var/lib/one/datastores/104

/var/lib/one/datastores/<ID_хранилища> на узле управления и на узлах виртуализации необходимо смонтировать удалённый NFS-каталог. Например:

# mount -t nfs 192.168.0.157:/export/storage /var/lib/one/datastores/104

Для автоматического монтирования при загрузке системы добавьте запись в файл /etc/fstab:

192.168.0.157:/export/storage /var/lib/one/datastores/104 nfs intr,soft,nolock,_netdev,x-systemd.automount 0 0

Примечание

# systemctl enable --now nfs-client.target

Список экспортируемых ресурсов NFS-сервера можно получить командой:

# showmount -e 192.168.0.157

Важно

/etc/fstab и перезагрузки системы необходимо назначить владельца каталога хранилища:

# chown oneadmin: /var/lib/one/datastores/104

QCOW2_OPTIONS — дополнительные параметры для qemu-img create (например, -o cluster_size=2M). Задаются в файле /etc/one/tmrc;

DD_BLOCK_SIZE — размер блока для операций dd (по умолчанию 64 КБ). Может быть задан в файле /var/lib/one/remotes/etc/datastore/fs/fs.conf;

SUPPORTED_FS — список поддерживаемых файловых систем (через запятую). Может быть установлен в файле /var/lib/one/remotes/etc/datastore/datastore.conf;

FS_OPTS_<FS> — параметры создания файловой системы для конкретного типа ФС. Указывается отдельно для каждого типа файловой системы в файле /var/lib/one/remotes/etc/datastore/datastore.conf;

SPARSE — если установлено в NO, файлы будут занимать всё выделенное пространство (неразрежённые файлы). Требует установки параметра QCOW2_STANDALONE="YES" в системном хранилище;

QCOW2_STANDALONE — если установлено в YES, создаётся автономный qcow2-диск без backing file.

Примечание

SUPPORTED_FS убедитесь, что команда mkfs.<fs_name> доступна на узле управления и гипервизорах.

TM_MAD=shared);

TM_MAD=ssh).

TM_MAD=shared);

TM_MAD=ssh).

TM_MAD_SYSTEM="ssh"

Примечание

fs_lvm;

fs_lvm_ssh.

BRIDGE_LIST;

/var/lib/one/datastores/<ID_хранилища>.

Примечание

/etc/lvm/lvm.conf необходимо установить:

use_lvmetad = 0и отключить службу, если она запущена:

# systemctl disable --now lvm2-lvmetad.service

# gpasswd -a oneadmin disk

Примечание

# lvchange -ay <DEVICE>

Также можно использовать скрипт активации /var/tmp/one/tm/fs_lvm/activate, доступный в удалённых скриптах OpenNebula.

/var/lib/one/datastores/<ID_хранилища>. Необходимо убедиться, что на локальном хранилище достаточно свободного пространства для этих файлов.

Примечание

systemds.conf:

NAME = lvm-system TM_MAD = fs_lvm_ssh TYPE = SYSTEM_DS BRIDGE_LIST = "host-01 host-02" DISK_TYPE = BLOCK

$ onedatastore create systemds.conf

ID: 105

NAME — название хранилища;

TYPE — SYSTEM_DS;

TM_MAD — fs_lvm (режим NFS), fs_lvm_ssh (режим SSH);

DISK_TYPE — BLOCK. Используется для временных (volatile) дисков;

BRIDGE_LIST — список узлов, имеющих доступ к логическим томам (не требуется, если сервер управления имеет прямой доступ к LUN).

imageds.conf:

NAME = lvm-images TM_MAD = fs_lvm_ssh TYPE = IMAGE_DS DISK_TYPE = "BLOCK" DS_MAD = fs SAFE_DIRS = "/var/tmp /tmp"

$ onedatastore create imageds.conf

ID: 106

NAME — название хранилища;

DS_MAD — fs (файловый драйвер);

TYPE — IMAGE_DS;

TM_MAD — fs_lvm (режим NFS), fs_lvm_ssh (режим SSH);

DISK_TYPE — BLOCK;

BRIDGE_LIST — список узлов с доступом к логическим томам (опционально).

Примечание

TM_MAD).

BRIDGE_LIST можно опустить, если сервер управления имеет прямой доступ к LUN.

/var/lib/one/datastores/ будут автоматически созданы каталоги 105 и 106. На вычислительных узлах эти каталоги необходимо создать вручную:

$ mkdir /var/lib/one/datastores/{105,106}

/var/lib/one/remotes/etc/fs_lvm/fs_lvm.conf:

ZERO_LVM_ON_CREATE — обнулять тома при создании (yes/no);

ZERO_LVM_ON_DELETE — обнулять тома при удалении (рекомендуется включать);

DD_BLOCK_SIZE — размер блока для операций dd (по умолчанию: 64 КБ).

ZERO_LVM_ON_CREATE=no ZERO_LVM_ON_DELETE=yes DD_BLOCK_SIZE=32M

SUPPORTED_FS — список файловых систем, поддерживаемых для создания форматированных блочных устройств (через запятую). Может быть установлен в файле /var/lib/one/remotes/etc/datastore/datastore.conf;

FS_OPTS_<FS> — параметры создания файловой системы для соответствующего типа ФС. Настраиваются в файле /var/lib/one/remotes/etc/datastore/datastore.conf.

Примечание

systool из пакета sysfsutils.

# apt-get install sysfsutils

# systool -c fc_host -A port_name

Пример вывода:

Class = "fc_host" Class Device = "host1" port_name = "0x10000090fa59a61a" Device = "host1" Class Device = "host16" port_name = "0x10000090fa59a61b" Device = "host16"

# lsblk

Пример:

NAME MAJ:MIN RM SIZE RO TYPE MOUNTPOINTS sda 8:0 0 59G 0 disk sdb 8:16 0 931,3G 0 disk └─mpatha 253:0 0 931,3G 0 mpath sdc 8:32 0 931,3G 0 disk └─mpatha 253:0 0 931,3G 0 mpath sdd 8:48 0 931,3G 0 disk └─mpatha 253:0 0 931,3G 0 mpath sde 8:64 0 931,3G 0 disk └─mpatha 253:0 0 931,3G 0 mpathВ данном примере один LUN объёмом ~1 ТБ доступен по четырём путям.

node.startup необходимо задать значение automatic.

node.session.timeo.replacement_timeout по умолчанию составляет 120 секунд. Рекомендуется уменьшить его до 15 секунд.

/etc/iscsi/iscsid.conf (глобально). Если iSCSI-цель уже подключена, необходимо изменить настройки для конкретной цели в файле /etc/iscsi/nodes/<TARGET>/<PORTAL>/default.

#apt-get install open-iscsi#systemctl enable --now iscsid

/etc/iscsi/iscsid.conf:

node.startup = automatic node.session.timeo.replacement_timeout = 15

#iscsiadm -m discovery -t sendtargets -p <iscsi-target-1-ip>#iscsiadm -m discovery -t sendtargets -p <iscsi-target-2-ip>#iscsiadm -m node --login

/etc/iscsi/iscsid.conf:

node.startup = automatic

/var/lib/iscsi/send_targets/<TargetServer>,<Port>/st_config:

discovery.sendtargets.use_discoveryd = Yes

# lsblk

NAME MAJ:MIN RM SIZE RO TYPE MOUNTPOINTS

sda 8:0 0 59G 0 disk

sdb 8:16 0 931,3G 0 disk

└─mpatha 253:0 0 931,3G 0 mpath

sdc 8:32 0 931,3G 0 disk

└─mpatha 253:0 0 931,3G 0 mpath

sdd 8:48 0 931,3G 0 disk

└─mpatha 253:0 0 931,3G 0 mpath

sde 8:64 0 931,3G 0 disk

└─mpatha 253:0 0 931,3G 0 mpath

В данном примере один LUN объёмом ~1 ТБ доступен по четырём путям.

Примечание

iscsiadm:

# iscsiadm -m node --logout

# iscsiadm -m node --targetname "iscsi-target-1.test.alt:server.target1" --logout

# iscsiadm -m node -R

# iscsiadm -m session

# apt-get install multipath-tools

И запустить службу multipathd:

# systemctl enable --now multipathd && sleep 5; systemctl status multipathd

Примечание

multipath используется для обнаружения и управления многопутевыми устройствами.

multipath:

-l — отобразить текущую multipath-топологию, полученную из sysfs и устройства сопоставления устройств;

-ll — отобразить текущую multipath-топологию, собранную из sysfs, устройства сопоставления устройств и всех других доступных компонентов системы;

-f <device> — удалить указанное multipath-устройство;

-F — удалить все неиспользуемые multipath-устройства;

-w <device> — удалить WWID устройства из файла wwids;

-W — сбросить файл wwids, чтобы включить только текущие многопутевые устройства;

-r — принудительно перечитать конфигурацию.

# multipath -ll

mpatha (3600c0ff00014f56ee9f3cf6301000000) dm-0 HP,P2000 G3 FC

size=931G features='1 queue_if_no_path' hwhandler='1 alua' wp=rw

|-+- policy='service-time 0' prio=50 status=active

| |- 1:0:0:1 sdb 8:16 active ready running

| `- 16:0:1:1 sde 8:64 active ready running

`-+- policy='service-time 0' prio=10 status=enabled

|- 1:0:1:1 sdc 8:32 active ready running

`- 16:0:0:1 sdd 8:48 active ready running

# multipath -v3

/etc/multipath.conf. Пример базовой конфигурации:

defaults {

find_multipaths yes

user_friendly_names yes

}

user_friendly_names = no, устройство будет именоваться по WWID /dev/mapper/<WWID> и /dev/dm-X:

#Еслиls /dev/mapper/3600c0ff00014f56ee9f3cf6301000000 #lsblkNAME MAJ:MIN RM SIZE RO TYPE MOUNTPOINTS sda 8:0 0 59G 0 disk sdb 8:16 0 931,3G 0 disk └─3600c0ff00014f56ee9f3cf6301000000 253:0 0 931,3G 0 mpath sdc 8:32 0 931,3G 0 disk └─3600c0ff00014f56ee9f3cf6301000000 253:0 0 931,3G 0 mpath sdd 8:48 0 931,3G 0 disk └─3600c0ff00014f56ee9f3cf6301000000 253:0 0 931,3G 0 mpath sde 8:64 0 931,3G 0 disk └─3600c0ff00014f56ee9f3cf6301000000 253:0 0 931,3G 0 mpath

user_friendly_names = yes, то для имени multipath-устройства задаётся алиас (псевдоним) вида mpathХ. Имя устройства будет /dev/mapper/mpathХ и /dev/dm-X:

#ls /dev/mapper/mpatha #lsblkNAME MAJ:MIN RM SIZE RO TYPE MOUNTPOINTS sda 8:0 0 59G 0 disk sdb 8:16 0 931,3G 0 disk └─mpatha 253:0 0 931,3G 0 mpath sdc 8:32 0 931,3G 0 disk └─mpatha 253:0 0 931,3G 0 mpath sdd 8:48 0 931,3G 0 disk └─mpatha 253:0 0 931,3G 0 mpath sde 8:64 0 931,3G 0 disk └─mpatha 253:0 0 931,3G 0 mpath

/dev/mapper/mpatha). Для этого в файл /etc/multipath.conf добавить секции:

blacklist {

wwid .*

}

blacklist_exceptions {

wwid "3600c0ff00014f56ee9f3cf6301000000"

}

Данная настройка предписывается внести в чёрный список любые найденные устройства хранения данных, за исключением нужного.

multipaths {

multipath {

wwid "3600c0ff00014f56ee9f3cf6301000000"

alias mpatha

}

}

В этом случае устройство всегда будет доступно как /dev/mapper/mpatha. Вместо mpatha можно вписать любое желаемое имя устройства.

Примечание

# /lib/udev/scsi_id -g -u -d /dev/sdb

3600c0ff00014f56ee9f3cf6301000000

Для устройств в одном multipath WWID совпадают.

/etc/multipath.conf может также потребоваться внести рекомендованные производителем СХД параметры.

/etc/multipath.conf необходимо перезапустить службу multipathd:

# systemctl restart multipathd.service

Примечание

/etc/multipath.conf на наличие ошибок можно, выполнив команду:

# multipath -t

# apt-get install ocfs2-tools

Примечание

/etc/ocfs2/cluster.conf. Этот файл должен быть идентичен на всех узлах кластера. При изменении в одном месте его нужно скопировать на остальные узлы. При добавлении нового узла в кластер описание этого узла должно быть добавлено на всех остальных узлах до монтирования OCFS2-раздела с нового узла.

/etc/ocfs2/cluster.conf.

# o2cb_ctl -C -n mycluster -t cluster -a name=mycluster

# o2cb_ctl -C -n <имя_узла> -t node -a number=0 -a ip_address=<IP_узла> -a ip_port=7777 -a cluster=mycluster

/etc/ocfs2/cluster.conf:

cluster: node_count = 3 heartbeat_mode = local name = mycluster node: ip_port = 7777 ip_address = <IP_узла-01> number = 0 name = <имя_узла-01> cluster = mycluster node: ip_port = 7777 ip_address = <IP_узла-02> number = 1 name = <имя_узла-02> cluster = mycluster node: ip_port = 7777 ip_address = <IP_узла-03> number = 2 name = <имя_узла-03> cluster = mycluster

Примечание

/etc/hostname.

/etc/init.d/o2cb:

# /etc/init.d/o2cb configure

Для ручного запуска кластера выполните:

# /etc/init.d/o2cb load

checking debugfs...

Loading filesystem "ocfs2_dlmfs": OK

Creating directory '/dlm': OK

Mounting ocfs2_dlmfs filesystem at /dlm: OK

Затем переведите кластер в онлайн-состояние:

# /etc/init.d/o2cb online mycluster

checking debugfs...

Setting cluster stack "o2cb": OK

Registering O2CB cluster "mycluster": OK

Setting O2CB cluster timeouts : OK

/dev/mapper/mpatha-part1 на устройстве /dev/mapper/mpatha:

# fdisk /dev/mapper/mpatha

# mkfs.ocfs2 -b 4096 -C 4k -L DBF1 -N 3 /dev/mapper/mpatha-part1

mkfs.ocfs2 1.8.7

Cluster stack: classic o2cb

Label: DBF1

…

mkfs.ocfs2 successful

Таблица 29.2. Параметры команды mkfs.ocfs2

|

Параметр

|

Описание

|

|---|---|

-L метка_тома

|

Метка тома, позволяющая его однозначно идентифицировать его при подключении на разных узлах. Для изменения метки можно использовать утилиту

tunefs.ocfs2

|

-C размер_кластера

|

Размер кластера — минимальная единица пространства, выделяемая файлу. Возможные значения: 4, 8, 16, 32, 64, 128, 256, 512 и 1024 КБ. Не может быть изменён после форматирования

|

-N количество_узлов_кластера

|

Максимальное количество узлов, которые могут одновременно монтировать том. Может быть изменено с помощью

tunefs.ocfs2

|

-b размер_блока

|

Наименьшая единица пространства, адресуемая ФС. Возможные значения: 512 байт (не рекомендуется), 1 КБ, 2 КБ или 4 КБ (рекомендуется). Не может быть изменён после форматирования

|

Примечание

/dev/mapper/mpathX (использовать с осторожностью):

# dd if=/dev/zero of=/dev/mapper/mpathX bs=512 count=1 conv=notrunc

# blkid

/dev/mapper/mpatha-part1: LABEL="DBF1" UUID="df49216a-a835-47c6-b7c1-6962e9b7dcb6" BLOCK_SIZE="4096" TYPE="ocfs2" PARTUUID="15f9cd13-01"

/etc/fstab:

UUID=<uuid> /var/lib/one/datastores/<идентификатор_хранилища> ocfs2 _netdev,defaults 0 0Например:

UUID=df49216a-a835-47c6-b7c1-6962e9b7dcb6 /var/lib/one/datastores/102 ocfs2 _netdev,defaults 0 0

# mount -a

Команда должна завершиться без вывода ошибок.

# lsblk

NAME MAJ:MIN RM SIZE RO TYPE MOUNTPOINTS

sda 8:0 0 59G 0 disk

`-sda1 8:1 0 255M 0 part /boot/efi

sdb 8:16 0 931.3G 0 disk

`-mpatha 253:0 0 931.3G 0 mpath

`-mpatha-part1 253:1 0 931.3G 0 part /var/lib/one/datastores/102

sdc 8:32 0 931.3G 0 disk

|-sdc1 8:33 0 931.3G 0 part

`-mpatha 253:0 0 931.3G 0 mpath

`-mpatha-part1 253:1 0 931.3G 0 part /var/lib/one/datastores/102

sdd 8:48 0 931.3G 0 disk

`-mpatha 253:0 0 931.3G 0 mpath

`-mpatha-part1 253:1 0 931.3G 0 part /var/lib/one/datastores/102

sde 8:64 0 931.3G 0 disk

`-mpatha 253:0 0 931.3G 0 mpath

`-mpatha-part1 253:1 0 931.3G 0 part /var/lib/one/datastores/102

Примечание

_netdev гарантирует, что раздел будет монтироваться только после запуска сетевой подсистемы.

Важно

/etc/fstab и перезагрузки ОС необходимо назначить владельцем каталога пользователя oneadmin. Например:

# chown oneadmin: /var/lib/one/datastores/102

Примечание

#mounted.ocfs2 -fDevice Stack Cluster F Nodes /dev/mapper/mpatha-part1 o2cb server, host-02, host-01 #mounted.ocfs2 -dDevice Stack Cluster F UUID Label /dev/mapper/mpatha-part1 o2cb DF49216AA83547C6B7C16962E9B7DCB6 DBF

/etc/lvm/lvm.conf необходимо установить:

use_lvmetad = 0и отключить службу, если она запущена:

# systemctl disable --now lvm2-lvmetad.service

# gpasswd -a oneadmin disk

Примечание

/dev/mapper/ и не содержать разметки.

# wipefs -fa /dev/mapper/[LUN_WWID]

# pvcreate /dev/mapper/mpathb

Physical volume "/dev/mapper/mpathb" successfully created.

# vgcreate vg-one-101 /dev/mapper/mpathb

Volume group "vg-one-101" successfully created

# pvs

PV VG Fmt Attr PSize PFree

/dev/mapper/mpathb vg-one-101 lvm2 a-- 931.32g 931.32g

#где 52 — идентификатор ВМ.lvscanACTIVE '/dev/vg-one-101/lv-one-52-0' [50,00 GiB] inherit #lsblksde 8:64 0 931.3G 0 disk └─mpathb 253:1 0 931.3G 0 mpath └─vg--one--101-lv--one--52--0 253:3 0 51G 0 lvm

kernels_ds.conf:

NAME = kernels DS_MAD = fs TM_MAD = ssh TYPE = FILE_DS SAFE_DIRS = /var/tmp/files

$ onedatastore create kernels_ds.conf

ID: 107

NAME — название хранилища;

TYPE — FILE_DS;

DS_MAD — fs;

TM_MAD — ssh.

Примечание

DS_MAD и TM_MAD являются рекомендованными, однако при необходимости могут использоваться и другие поддерживаемые драйверы.

ssh для хранилища файлов не требует специальной настройки на узлах виртуализации. Достаточно убедиться, что в каталоге размещения хранилищ данных (по умолчанию — /var/lib/one/datastores) имеется достаточно свободного пространства для хранения файлов ВМ.

$ onedatastore update <ID_хранилища> <имя_файла>

Таблица 30.1. Типы образов

|

Тип

|

Описание

|

Хранилище

|

|---|---|---|

|

OS

|

Загрузочный диск с установленной операционной системой

|

Images Datastore

|

|

CDROM

|

ISO-образ (только для чтения). Можно подключить несколько образов, но загрузка возможна только с одного из них

|

Images Datastore

|

|

DATABLOCK

|

Блок данных (например, для размещения базы данных) или пустой диск для установки ОС

|

Images Datastore

|

|

KERNEL

|

Ядро Linux (vmlinuz)

|

Files & Kernels Datastore

|

|

RAMDISK

|

Образ initrd/initramfs

|

Files & Kernels Datastore

|

|

CONTEXT

|

Файл контекстуализации (для автоматической начальной настройки ВМ)

|

Files & Kernels Datastore

|

Примечание

OS[kernel=...] и OS[initrd=...], а не подключаются как отдельные диски.

Примечание

oneimage list отображается сокращённое имя STATE (например, rdy, disa).

Таблица 30.2. Состояния образов

|

Состояние

|

Краткий псевдоним

|

Описание

|

|---|---|---|

|

INIT

|

init

|

Состояние инициализации

|

|

READY (ГОТОВО)

|

rdy

|

Образ готов к использованию

|

|

USED (ИСПОЛЬЗУЕТСЯ), USED_PERS (ЗАНЯТ_ПОСТОЯННЫЙ)

|

used

|

Образ используется как минимум одной ВМ. Образ нельзя удалить или изменить

|

|

DISABLED (Отключен)

|

disa

|

Образ отключён владельцем. Новые ВМ не могут его использовать

|

|

LOCKED (ЗАБЛОКИРОВАН), LOCKED_USED, LOCKED_USED_PERS (ЗАБЛОКИРОВАН_ПОСТОЯННЫЙ)

|

lock

|

Образ копируется или создаётся. ВМ, использующие его, ожидают завершения операции

|

|

ERROR (Ошибка)

|

err

|

Операция завершилась неудачей (см.

oneimage show для получения сообщения об ошибке)

|

|

CLONE (Клонирование)

|

clon

|

Образ клонируется

|

|

DELETE (Удаление)

|

dele

|

Образ удаляется из хранилища данных

|

oneimage);

oneimage:

--name <имя> — имя нового образа;

--datastore <имя|ID> — имя или идентификатор хранилища данных;

--description <описание> — описание образа (необязательно);

--type <тип> — тип образа: OS, CDROM, DATABLOCK, KERNEL, RAMDISK, CONTEXT;

--persistent — создание постоянного образа;

--prefix <префикс> — префикс устройства в гостевой ОС (hd, sd, vd);

--target <устройство> — целевое устройство подключения диска;

--path <путь/URL> — путь к файлу образа или URL-адрес;

--source <источник> — источник данных для использования (применяется для нефайловых образов);

--size <размер> — размер в МБ (используется для DATABLOCK или при изменении размера).

Примечание

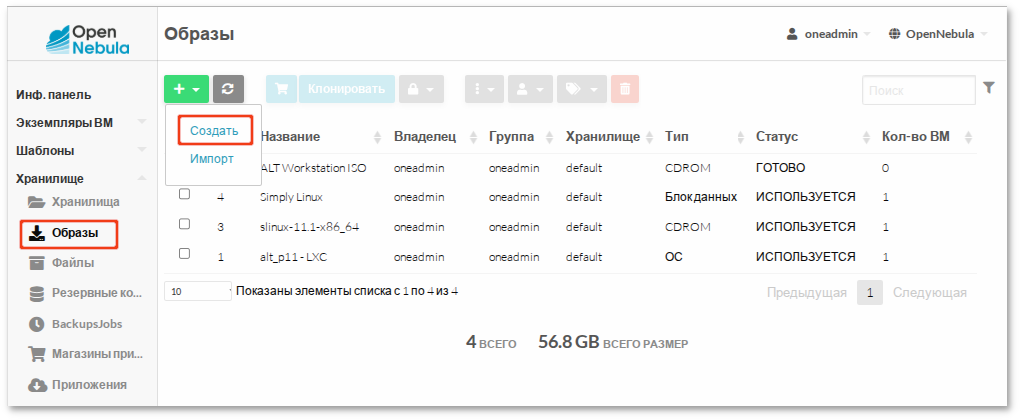

$ oneimage create -d 1 --name "ALT Workstation ISO" \

--path /var/tmp/alt-workstation-11.1-x86_64.iso --type CDROM

ID: 31

где -d 1 — хранилище данных по умолчанию (ID = 1).

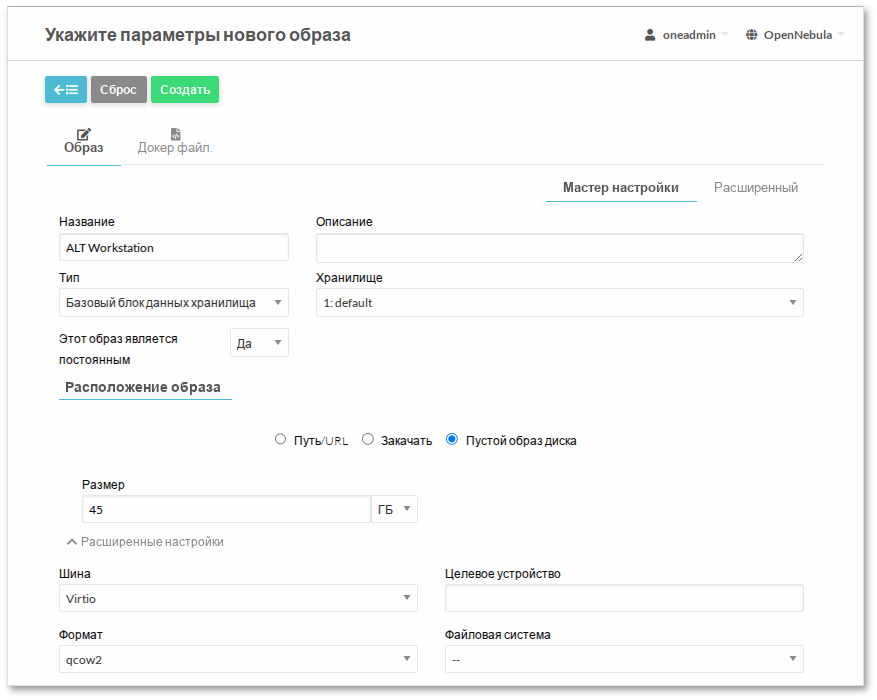

$ oneimage create -d 1 --name "ALT Workstation" \

--type DATABLOCK --size 45G --persistent --driver qcow2

ID: 33

где:

-d 1 — хранилище данных по умолчанию (ID = 1);

--size 45G — размер образа (45 ГБ);

--driver qcow2 — формат образа qcow2.

Примечание

template:

NAME = "ALT Workstation" CPU = "1" MEMORY = "1024" MEMORY_UNIT_COST = "MB" HYPERVISOR = "kvm" DISK = [ IMAGE = "ALT Workstation ISO", IMAGE_UNAME = "oneadmin" ] DISK = [ DEV_PREFIX = "vd", IMAGE = "ALT Workstation", IMAGE_UNAME = "oneadmin" ] NIC = [ NETWORK = "VirtNetwork", NETWORK_UNAME = "oneadmin", SECURITY_GROUPS = "0" ] INPUTS_ORDER = "" LOGO = "images/logos/alt.png" NIC_DEFAULT = [ MODEL = "virtio" ] OS = [ BOOT = "disk1,disk0" # Сначала основной диск (disk1), затем CDROM (disk0) ] GRAPHICS = [ LISTEN = "0.0.0.0", TYPE = "SPICE" ] CONTEXT = [ NETWORK = "YES", SSH_PUBLIC_KEY = "$USER[SSH_PUBLIC_KEY]" ] SCHED_REQUIREMENTS = "ID=\"0\""

$ onetemplate create template

ID: 22

Примечание

Примечание

$USER[SSH_PUBLIC_KEY].

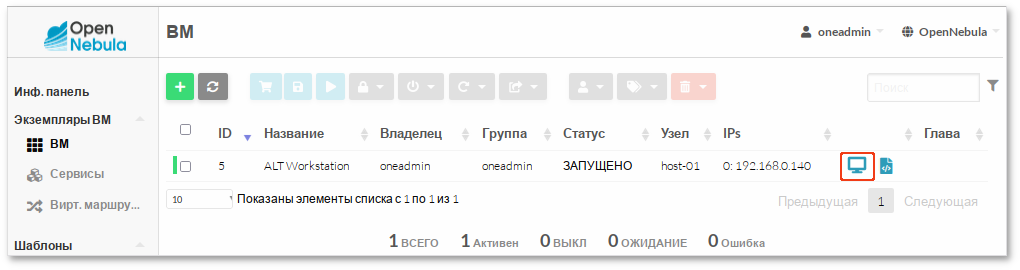

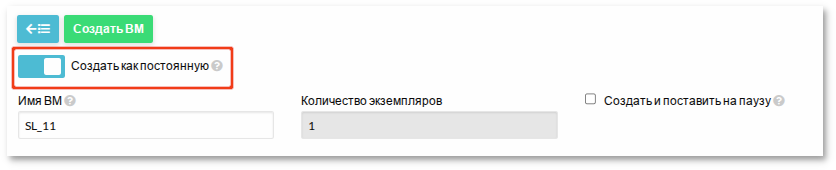

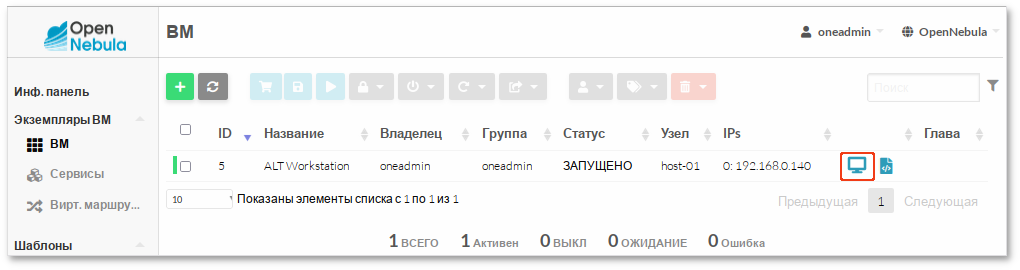

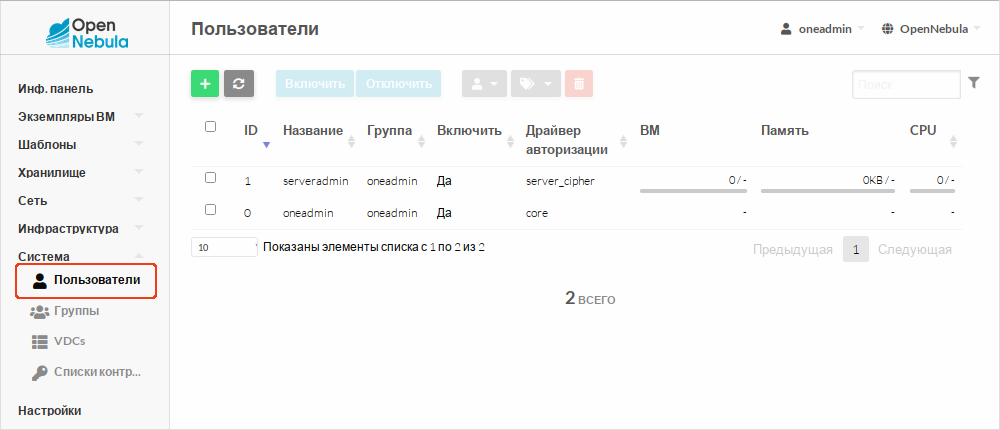

$ onetemplate instantiate 9

VM ID: 5

Примечание

spice://192.168.0.180:5905где:

# apt-get update && apt-get install opennebula-context

# apt-get install systemd-timesyncd

/etc/systemd/network/lan.network для автоматической настройки всех интерфейсов по DHCP:

[Match] Name = * [Network] DHCP = ipv4

# systemctl disable network NetworkManager && systemctl enable systemd-networkd systemd-timesyncd

$ onevm terminate 5

Примечание

$oneimage chtype 1 OS$oneimage nonpersistent 1

Примечание

Примечание

$ onemarket enable <ID_магазина>

$ onemarket disable <ID_магазина>

$ onemarket list

ID NAME SIZE AVAIL APPS MAD ZONE STAT

1 Linux Containers 0M - 0 linuxco 0 off

0 OpenNebula Public 0M - 116 one 0 on

Примечание

Примечание

/var/log/chroot.log содержащий журнал операций установки. В случае ошибок он может помочь в диагностике.

$ onevm create <шаблон>

NAME = "test-vm" CPU = 1 VCPU = 1 MEMORY = 1024 DISK = [ IMAGE = "SL", IMAGE_UNAME = "oneadmin" ] DISK = [ TYPE = "swap", SIZE = "1024" ] NIC = [ NETWORK = "VirtNetwork", NETWORK_UNAME = "oneadmin" ] NIC = [ NETWORK = "Private", NAME = "private_net" ] GRAPHICS = [ TYPE = "vnc", LISTEN = "0.0.0.0" ] OS = [ BOOT = "disk0" ]

Примечание

$ onetemplate create \

--name test-vm \

--cpu 1 \

--vcpu 1 \

--memory 1024 \

--disk "SL" \

--nic VirtNetwork

$ onetemplate create -h

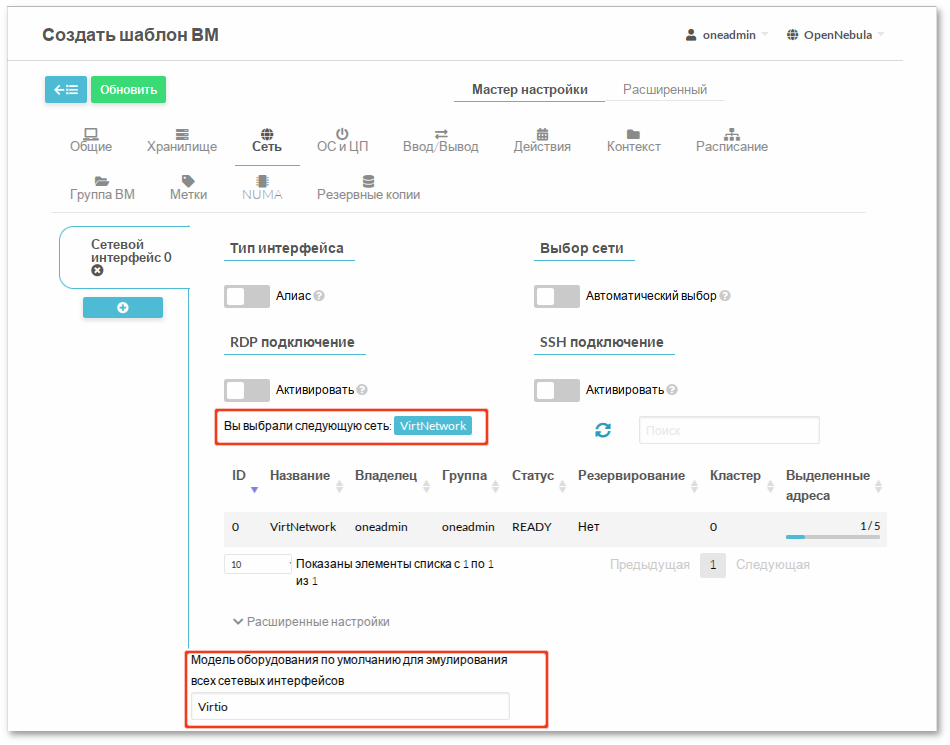

NIC_DEFAULT, через мастер создания шаблонов или глобально — в конфигурации драйвера гипервизора.

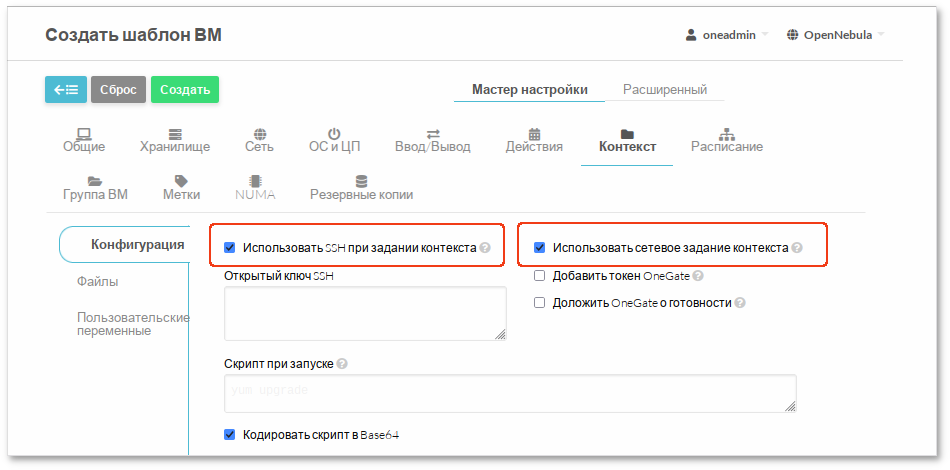

CONTEXT шаблона и обрабатываются агентом контекстуализации внутри гостевой ОС.

CONTEXT = [ NETWORK = "YES", SSH_PUBLIC_KEY = "$USER[SSH_PUBLIC_KEY]", BLOG_TITLE = "$BLOG_TITLE", MYSQL_PASSWORD = "$MYSQL_PASSWORD" ] USER_INPUTS = [ BLOG_TITLE = "M|text|Blog Title", MYSQL_PASSWORD = "M|password|MySQL Password" ]

Примечание

CPU, MEMORY, VCPU могут быть:

USER_INPUTS.

USER_INPUTS:

CPU = "1" MEMORY = "2048" VCPU = "2" USER_INPUTS = [ CPU = "M|list|vCPU count|0.5,1,2,4|1", MEMORY = "M|range|Memory (MB)|512..8192|2048", VCPU = "O|fixed|Virtual CPUs||2" ]

USER_INPUTS:

"<обязательность>|<тип>|<метка>|<значения>|<по умолчанию>"где:

Примечание

Примечание

--user-inputs ui1,ui2,ui3.

SCHED_ACTION = [ ACTION = "poweroff", TIME = "18000" # через 5 часов (в секундах) ]

$ onetemplate instantiate <ID_или_имя_шаблона>

Эта команда развёртывает один экземпляр ВМ. Для создания нескольких экземпляров используется опция --multiple:

$ onetemplate instantiate my-template --multiple 3

VM IDs: 10, 11, 12

Примечание

/etc/one/oned.conf, например:

VM_RESTRICTED_ATTR = "CPU" VM_RESTRICTED_ATTR = "VPU" VM_RESTRICTED_ATTR = "NIC"Пример шаблона ВМ:

CPU = "1" VCPU = "1" MEMORY = "512" DISK = [ IMAGE = "BaseOS" ] NIC = [ NETWORK_ID = "0" ]

$ onetemplate instantiate 0 \

--memory 1G \

--disk "SL"

Примечание

onetemplate instantiate все исходные диски шаблона заменяются. Чтобы сохранить оригинальный диск и добавить новый, необходимо указать все диски явно:

$ onetemplate instantiate 0 \

--memory 1G \

--disk "BaseOS, SL"

$ onevm deploy <ID_ВМ> <ID_узла>

$ onetemplate instantiate <Шаблон> \

--as_uid <ID_пользователя> \

--as_gid <ID_группы>

onetemplate);

Таблица 31.1. Основные операции с шаблонами

|

Операция

|

Команда

|

Описание

|

|---|---|---|

|

Создать

|

onetemplate create file.tmpl

|

Регистрация нового шаблона

|

|

Клонировать

|

onetemplate clone <ID_шаблона> new-name

|

Создание копии шаблона

|

|

Обновить

|

onetemplate update <ID_шаблона>

|

Редактирование шаблона

|

|

Удалить

|

onetemplate delete <ID_шаблона>

|

Удаление (только владелец или админ)

|

Примечание

--recursive OpenNebula создаёт копии всех образов, используемых в шаблоне, и делает их постоянными:

$ onetemplate clone 6 secure-copy --recursive

onetemplate update. Например, если в /etc/one/oned.conf указано:

VM_RESTRICTED_ATTR = "DISK/TOTAL_BYTES_SEC"И шаблон содержит:

DISK = [ IMAGE = "BaseOS", TOTAL_BYTES_SEC = "1048576" ] DISK = [ IMAGE = "DataDisk" ]Пользователь может удалить DataDisk, но не может удалить или изменить BaseOS, так как он содержит ограниченный атрибут.

chmod).

Таблица 31.2. Управление правами доступа

|

Команда

|

Описание

|

|---|---|

onetemplate chmod 0 640

|

Группа может использовать шаблон

|

onetemplate chmod 0 660

|

Группа может использовать и управлять

|

onetemplate chmod 0 664

|

Группа — управление, остальные — использование

|

$onetemplate chmod 0 660$onetemplate show 0... PERMISSIONS OWNER : um- GROUP : um- OTHER : ---

--recursive, чтобы применить права также к всем образам, используемым в шаблоне:

$ onetemplate chmod 0 660 --recursive

chmod --recursive 640 является действие :

Примечание

onevm list отображается сокращённое имя состояния LCM_STATE (например, pend, runn).

Таблица 32.1. Состояния ВМ

|

Краткий псевдоним

|

Состояние

|

Описание

|

|---|---|---|

|

pend

|

Pending

|

ВМ ожидает развёртывания. Планировщик ищет подходящий узел

|

|

hold

|

Hold

|

Запуск ВМ приостановлен владельцем. ВМ может быть развёрнута вручную

|

|

clon

|

Cloning

|

ВМ ожидает завершения первоначального копирования одного или нескольких образов дисков в хранилище (образы находятся в заблокированном состоянии)

|

|

prol

|

Prolog

|

Копирование образов дисков на целевой узел

|

|

boot

|

Boot

|

Запуск гипервизора и загрузка ВМ

|

|

runn

|

Running

|

ВМ запущена и работает на узле

|

|

migr

|

Migrate

|

Выполняется миграция ВМ (live или cold)

|

|

hotp

|

Hotplug

|

Динамическое подключение или отключение дисков и сетевых интерфейсов

|

|

snap

|

Snapshot

|

Создается снимок ВМ

|

|

save

|

Save

|

Сохранение файлов ВМ при миграции, остановке или приостановке

|

|

epil

|

Epilog

|

Очистка ресурсов на узле после завершения работы ВМ

|

|

shut

|

Shutdown

|

Отправка ACPI-сигнала для корректного завершения работы гостевой ОС

|

|

stop

|

Stopped

|

ВМ остановлена, её состояние сохранено в системном хранилище

|

|

susp

|

Suspended

|

ВМ приостановлена; файлы остаются на узле для быстрого возобновления

|

|

poff

|

PowerOff

|

Аналогично состоянию Suspended, но файл контрольной точки не создаётся. Файлы ВМ остаются на узле. После корректного выключения гостевой ОС OpenNebula переводит ВМ в это состояние

|

|

unde

|

Undeployed

|

ВМ выключена, её диски перенесены в системное хранилище. ВМ может быть возобновлена позже

|

|

drsz

|

Disk Resize

|

Выполняется изменение размера дисков ВМ

|

|

back

|

Backup

|

Выполняется резервное копирование ВМ

|

|

rest

|

Restore

|

Диски ВМ восстановлены из образа резервной копии

|

|

fail

|

Failed

|

Ошибка при развёртывании или выполнении операции

|

|

unkn

|

Unknown

|

ВМ недоступна и находится в неизвестном состоянии

|

|

clea

|

Cleanup-resubmit

|

ВМ ожидает завершения очистки узла драйверами после выполнения

onevm recover --recreate

|

|

done

|

Done

|

ВМ завершена и удалена из списка активных, но сохранена в базе данных для учёта

|

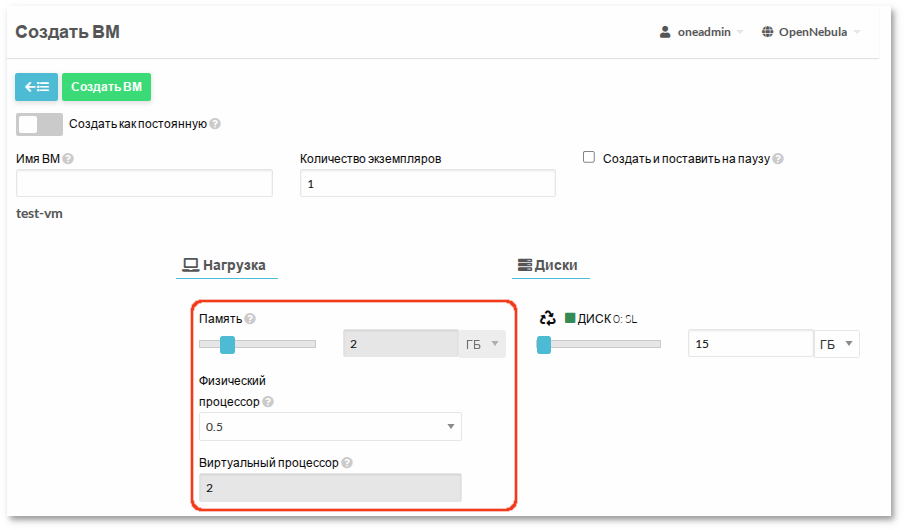

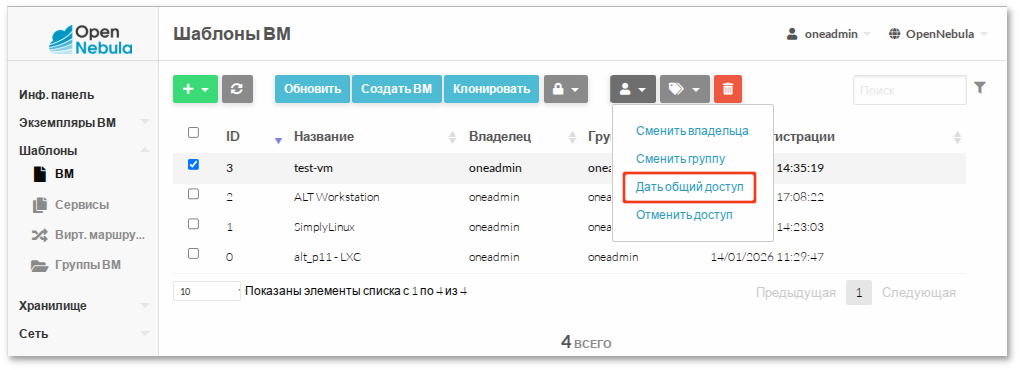

$onetemplate listID USER GROUP NAME REGTIME 3 oneadmin oneadmin test-vm 01/15 14:35:19 2 oneadmin oneadmin ALT Workstation 01/14 17:08:22 1 oneadmin oneadmin SimplyLinux 01/14 14:23:03 0 oneadmin oneadmin alt_p11 - LXC 01/14 11:29:47 $onetemplate instantiate test-vm --name my-vmVM ID: 10

USER_INPUTS, система запросит их значения:

$ onetemplate instantiate test-vm --name my-vm

There are some parameters that require user input. Use the string <<EDITOR>> to launch an editor (e.g. for multi-line inputs)

* (BLOG_TITLE) Blog Title

April

* (CPU)

0 0.5

1 1

2 2

3 4

Please type the selection number: 1

* (MEMORY)

Press enter for default (2048). Integer in the range [512..8192]:

* (MYSQL_PASSWORD) MySQL Password

Password:

* (VCPU)

Fixed value of (2). Cannot be changed

VM ID: 11

$ onevm list

ID USER GROUP NAME STAT CPU MEM HOST TIME

11 oneadmin oneadmin my-vm prol 1 2G host-01 0d 00h00

onevm deploy:

$onehost list# найти подходящий узел ID NAME CLUSTER TVM ALLOCATED_CPU ALLOCATED_MEM STAT 2 host-03 default 0 0 / 200 (0%) 0K / 1.9G (0%) on 1 host-02 default 1 0 / 200 (0%) 0K / 1.9G (0%) on 0 host-01 default 1 100 / 200 (50%) 2G / 7.7G (25%) on $onevm deploy 11 2# развернуть ВМ 0 на узле 2

$ onevm show 0

Вывод команды содержит:

onevm list --search позволяет фильтровать ВМ по атрибутам.

VM.<путь>=<значение>

$ onevm list --search 'VM.TEMPLATE.NIC[*].MAC=02:00:0c:00:3e:dd'

$ onevm list --search 'VM.NAME=test-vm&VM.UNAME=oneadmin'

$ onevm list --search 'VM.NAME=test%'

Примечание

Таблица 32.2. Завершение работы

|

Команда

|

Описание

|

|---|---|

onevm terminate <ID_ВМ>

|

Корректно завершает работу ВМ с помощью ACPI-сигнала. После остановки:

|

onevm terminate --hard <ID_ВМ>

|

Немедленно уничтожает ВМ без отправки ACPI-сигнала. Используется, если гостевая ОС не поддерживает корректное завершение работы или не отвечает

|

Примечание

shutdown -h now), OpenNebula автоматически переводит её в состояние POWEROFF.

Таблица 32.3. Приостановка и выключение

|

Команда

|

Состояние

|

Описание

|

|---|---|---|

onevm suspend <ID_ВМ>

|

SUSPENDED

|

Сохраняет полное состояние ВМ (включая RAM) на узле. При возобновлении ВМ запускается на том же узле без перепланирования

|

onevm poweroff <ID_ВМ>

|

POWEROFF

|

Выключает ВМ через ACPI без сохранения состояния RAM. При запуске выполняется «холодная» загрузка на том же узле

|

onevm poweroff --hard <ID_ВМ>

|

POWEROFF

|

Принудительное выключение ВМ без отправки ACPI-сигнала

|

Таблица 32.4. Долгосрочная пауза (освобождение ресурсов узла)

|

Команда

|

Состояние

|

Описание

|

|---|---|---|

onevm undeploy <ID_ВМ>

|

UNDEPLOYED

|

Корректно выключает ВМ и переносит все её диски в системное хранилище. При возобновлении ВМ переходит в состояние PENDING, и планировщик выбирает новый узел

|

onevm undeploy --hard <ID_ВМ>

|

UNDEPLOYED

|

Принудительное выключение ВМ с немедленным переносом дисков в системное хранилище

|

onevm stop <ID_ВМ>

|

STOPPED

|

Аналогично undeploy, но дополнительно сохраняет состояние RAM для последующего восстановления

|

$ onevm resume <ID_ВМ>

Поддерживаемые состояния: STOPPED, SUSPENDED, UNDEPLOYED, POWEROFF.

Таблица 32.5. Перезагрузка

|

Команда

|

Описание

|

|---|---|

onevm reboot <ID_ВМ>

|

Отправляет ACPI-сигнал перезагрузки гостевой ОС

|

onevm reboot --hard <ID_ВМ>

|

Принудительная перезагрузка (аналог жёсткого выключения и последующего запуска)

|

Таблица 32.6. Управление запуском

|

Команда

|

Описание

|

|---|---|

onevm instantiate --hold <шаблон>

onevm create --hold <файл>

|

Создаёт ВМ в состоянии HOLD (планировщик игнорирует её до снятия удержания)

|

onevm hold <ID_ВМ>

|

Переводит существующую ВМ в состояние HOLD

|

onevm release <ID_ВМ>

|

Снимает удержание — ВМ переходит в состояние PENDING и передаётся под управление планировщика

|

$ onevm disk-attach <ВМ> --image storage

$onevm show <ВМ># определить DISK_ID $onevm disk-detach <ВМ> <ID_диска>

Примечание

$ onevm nic-attach <ВМ> --network <Сеть>

$ onevm nic-detach <ВМ> <NIC_ID>

$ onevm nic-attach <ВМ> --network <Сеть> --pci '00:06.1'

Примечание

$cat update_nic.txtNIC = [ INBOUND_AVG_BW = "512", INBOUND_PEAK_BW = "1024" ] $onevm nic-update <ВМ> <NIC_ID> update_nic.txt

Примечание

$ onevm sg-attach <ВМ> <NIC_ID> <SG_ID>

$ onevm sg-detach <ВМ> <NIC_ID> <SG_ID>

Важно

$ onevm pci-attach <ВМ> \

--pci_class "0c03" \

--pci_vendor "1912" \

--pci_device "0015"

$ onevm pci-detach <ВМ> <PCI_ID>

$ onehost show <HOST_ID> | grep -A5 "PCI"

$onevm snapshot-create 17 "before domain"$onevm show 17... SNAPSHOTS ID TIME NAME HYPERVISOR_ID 0 01/19 18:49 before update snap-0 1 01/20 15:53 before domain $onevm snapshot-revert 17 0 --verboseVM 17: reverting snapshot

Примечание

$ onevm snapshot-delete 17

onevm disk-snapshot-* — управление снимками: создание, восстановление, удаление, переименование;

onevm disk-saveas — экспорт диска или снимка в новый образ.

$ onevm disk-snapshot-create <ID_ВМ> <ID_диска> <имя_снимка>

$ onevm disk-snapshot-revert <ID_ВМ> <ID_диска> <ID_снимка>

$ onevm disk-snapshot-delete <ID_ВМ> <ID_диска> <ID_снимка>

onevm disk-snapshot-revert требует состояния POWEROFF или SUSPENDED;

guest_agent = "YES" в шаблоне);

DISK[CACHE] = "writethrough" (рекомендуется для обеспечения согласованности данных).

$onevm disk-snapshot-create 17 0 newtest$onevm show 17... VM DISK SNAPSHOTS AC ID DISK PARENT DATE SIZE NAME => 0 0 -1 01/19 17:18:28 -/15G test 1 0 -1 01/19 29:19:26 -/15G newtest

Примечание

CPU_HOTPLUG = "YES" MEMORY_HOTPLUG = "YES"

$onevm poweroff web_vm$onevm resize web_vm --memory 2G --vcpu 2$onevm resume web_vm

Примечание

Примечание

$ echo 1 > /sys/devices/system/cpu/cpu<ID>/online

$ onetemplate instantiate <шаблон> --disk "alt:size=20G"

Размер образа alt будет изменен до 20 ГБ

$ onevm disk-resize <ID_ВМ> <ID_диска> <новый_размер>

onevm updateconf позволяет изменить конфигурацию ВМ без её пересоздания.

Таблица 32.7. Поддерживаемые атрибуты

|

Атрибут

|

Податрибуты

|

Требуется перезагрузка

|

|---|---|---|

|

OS

|

ARCH, MACHINE, KERNEL, INITRD, BOOTLOADER, BOOT, KERNEL_CMD, ROOT, SD_DISK_BUS, UUID, FIRMWARE

|

Да

|

|

FEATURES

|

ACPI, PAE, APIC, LOCALTIME, HYPERV, GUEST_AGENT, VIRTIO_SCSI_QUEUES, VIRTIO_BLK_QUEUES, IOTHREADS

|

Нет

|

|

INPUT

|

TYPE, BUS

|

Нет

|

|

GRAPHICS

|

TYPE, LISTEN, PASSWD, KEYMAP, COMMAND

|

Нет

|

|

VIDEO

|

TYPE, IOMMU, ATS, VRAM, RESOLUTION

|

Нет

|

|

RAW

|

DATA, DATA_VMX, TYPE, VALIDATE

|

Да

|

|

CPU_MODEL

|

MODEL, FEATURES

|

Да

|

|

CONTEXT

|

Любые переменные (кроме ETH*)

|

Немедленно

|

Примечание

$cat new_conf.txtGRAPHICS = [ TYPE = "vnc", LISTEN = "0.0.0.0" ] CONTEXT = [ BLOG_TITLE = "Updated Blog" ] $onevm updateconf <ID_ВМ> new_conf.txt

--persistent;

onevm save.

--persistent:

$onetemplate instantiate web_vm --persistent --name my_vmVM ID: 30 $onetemplate list# Появление нового шаблона ID USER GROUP NAME REGTIME 7 oneadmin oneadmin web_vm 05/12 14:53:11 8 oneadmin oneadmin my_vm 05/12 14:53:38 $onevm list# Созданные постоянные образы дисков ID USER GROUP NAME DATASTORE SIZE TYPE PER STAT RVMS 7 oneadmin oneadmin web-img default 200M OS Yes used 1 8 oneadmin oneadmin my_vm-disk-0 default 200M OS Yes used 1

Примечание

onevm save сохраняет текущее состояние работающей или выключенной ВМ в новый шаблон.

$onevm poweroff web_vm# сначала выключите ВМ $onevm save web_vm saved_web_vm --persistentTemplate ID: 26

onevm save:

onevm поддерживают опцию --schedule, позволяющую отложить выполнение действия до указанной даты и времени.

$ onevm suspend 11 --schedule "2026-09-20"

VM 11: suspend scheduled at 2026-09-20 00:00:00 +0200

$ onevm resume 11 --schedule "2026-09-23 14:15"

VM 11: resume scheduled at 2026-09-23 14:15:00 +0200

$ onevm show 11

VIRTUAL MACHINE 11 INFORMATION

ID : 11

NAME : my-vm

[...]

SCHEDULED ACTIONS

ID ACTION ARGS SCHEDULED REPEAT END STATUS

0 suspend - 09/20 00:00 Next in 247.2 days

1 resume - 09/23 14:15 Next in 250.8 days

$ onevm sched-delete <ID_ВМ> <ACTION_ID>

$ onevm sched-update <ID_ВМ> <ACTION_ID>

$ onevm sched-update 11 1

ID="1"

PARENT_ID="11"

TYPE="VM"

ACTION="resume"

TIME="1790165700"

REPEAT="-1"

END_TYPE="-1"

END_VALUE="-1"

DONE="-1"

WARNING="0"

Примечание

Таблица 32.8. Периодические действия

|

Опция

|

Описание

|

Пример

|

|---|---|---|

--hourly <N>

|

Каждые N часов

|

--hourly 6

|

--weekly <дни>

|

Дни недели (0=вс, 6=сб)

|

--weekly "1,3,5"

|

--monthly <дни>

|

Дни месяца (1-31)

|

--monthly "1,15"

|

--yearly <дни>

|

Дни года (0-365)

|

--yearly "1,200"

|

--end <N|дата>

|

Завершить после N повторов или к дате

|

--end "2026-03-31"

|

$ onevm snapshot-create 0 weekly_backup \

--schedule "2025-09-22" \

--weekly "1,5" \

--end "2025-12-31"

SCHED_ACTION:

$ onetemplate update 0

SCHED_ACTION=[

ACTION="terminate",

ID="0",

TIME="+3600" ]

В этом случае ВМ будет автоматически завершена через 1 час после запуска.

Таблица 32.9. Поддерживаемые запланированные действия

|

Действие

|

Аргументы

|

Пример

|

|---|---|---|

terminate

|

[--hard]

|

terminate --hard

|

undeploy

|

[--hard]

|

undeploy

|

hold / release

|

-

|

hold

|

stop / suspend / resume

|

-

|

suspend

|

reboot / poweroff

|

[--hard]

|

reboot --hard

|

snapshot-create

|

<имя>

|

snapshot-create backup

|

snapshot-revert

|

<ID_снимка>

|

snapshot-revert 0

|

disk-snapshot-create

|

<ID_диска>,<имя>

|

disk-snapshot-create 0,daily

|

backup

|

<ID_хранилища>,[reset]

|

backup 100 reset

|

Важно

snapshot-create).

USER TEMPLATE. Это удобно для хранения служебной информации, например: паролей, тегов, идентификаторов интеграций и других параметров, используемых внешними системами.

$ onevm update 11

# В открывшемся редакторе добавьте:

ROOT_PASSWORD="s3cr3t"

Просмотр добавленных данных:

$ onevm show 0

...

USER TEMPLATE

BLOG_TITLE="April"

ROOT_PASSWORD="s3cr3t"

Примечание

onevm show, а также в веб-интерфейсе Sunstone.

Таблица 32.10. Метрики мониторинга

|

Ключ

|

Описание

|

Единицы

|

|---|---|---|

|

CPU

|

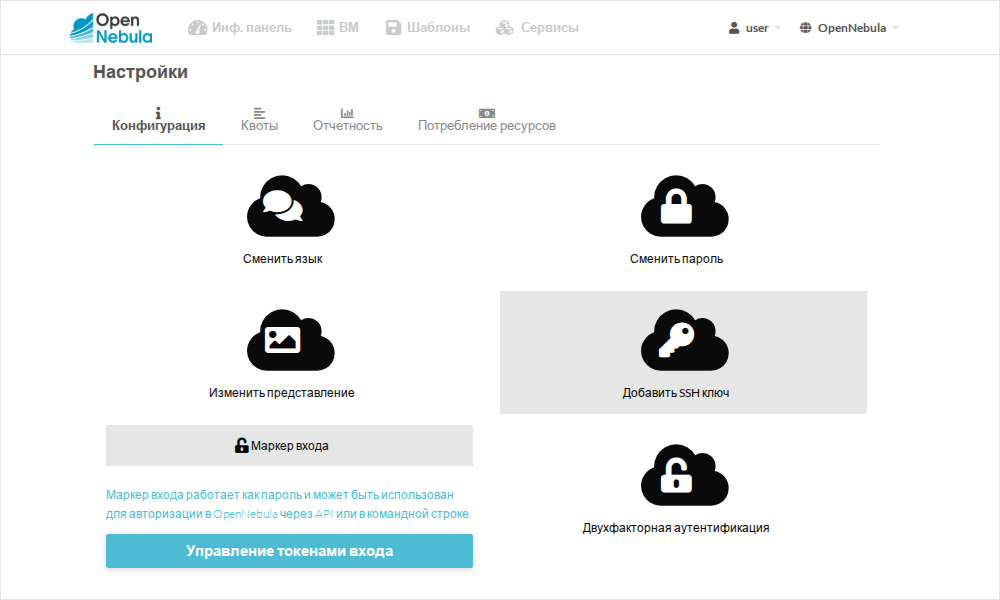

Загрузка CPU