Редакция июнь, 2025

Аннотация

qmПримечание

apt-get позволяют пользователям легко обновлять свои системы и быть в курсе актуальных новинок мира свободных программ.

Содержание

SCDWriter.exe;

Предупреждение

Предупреждение

Предупреждение

Предупреждение

dd:

#где <файл-образа.iso> — ISO-образ установочного диска с дистрибутивом, аddoflag=direct if=<файл-образа.iso> of=/dev/sdX bs=1M status=progress;sync

/dev/sdX — устройство, соответствующее flash-диску.

#где <файл-образа.iso> — ISO-образ диска, аpv<файл-образа.iso> | dd oflag=direct of=/dev/sdX bs=1M;sync

/dev/sdX — устройство, соответствующее flash-диску.

lsblk или (если такой команды нет) blkid.

$ lsblk | grep disk

sda 8:0 0 931,5G 0 disk

sdb 8:16 0 931,5G 0 disk

sdc 8:32 1 7,4G 0 disk

USB-диск имеет имя устройства sdc.

# dd oflag=direct if=/iso/alt-virtualization-pve-11.0-x86_64.iso of=/dev/sdc bs=1M status=progress; sync

# pv /iso/alt-virtualization-pve-11.0-x86_64.iso | dd oflag=direct of=/dev/sdc bs=1M;sync

dd: warning: partial read (524288 bytes); suggest iflag=fullblock

3GiB 0:10:28 [4,61MiB/s] [===================================> ] 72% ETA 0:04:07

Предупреждение

sudo dd if=alt-virtualization-pve-11.0-x86_64.isoof=/dev/rdiskX bs=10Msync

alt-virtualization-pve-11.0-x86_64.iso — ISO-образ диска, а /dev/rdiskX — flash-диск.

diskutil list

Предупреждение

$ du -b alt-virtualization-pve-11.0-x86_64.iso | cut -f1

2275885056

$ md5sum alt-virtualization-pve-11.0-x86_64.iso

8fab2c87bb59ba310de90d5cfeb171a6 alt-virtualization-pve-11.0-x86_64.iso

# head -c 2275885056 /dev/sdd | md5sum

8fab2c87bb59ba310de90d5cfeb171a6

где размер после -c — вывод в п.1, а /dev/sdd — устройство DVD или USB Flash, на которое производилась запись.

Предупреждение

Примечание

vncviewer --listen):

Log in as root localhost login:

Примечание

Примечание

Примечание

Примечание

позволяет показать/скрыть панель со списком шагов установки:

позволяет показать/скрыть панель со списком шагов установки:

Примечание

Примечание

/boot);

Примечание

Примечание

Предупреждение

Примечание

# lsblk

NAME MAJ:MIN RM SIZE RO TYPE MOUNTPOINTS

sda 8:0 0 100G 0 disk

├─sda1 8:1 0 600M 0 part /boot/efi

└─sda2 8:2 0 99,4G 0 part

├─pve-swap 253:0 0 2G 0 lvm [SWAP]

├─pve-root 253:1 0 12G 0 lvm /

├─pve-data_tmeta 253:2 0 84M 0 lvm

│ └─pve-data 253:4 0 83,8G 0 lvm

└─pve-data_tdata 253:3 0 83,8G 0 lvm

└─pve-data 253:4 0 83,8G 0 lvm

sr0 11:0 1 1024M 0 rom

Примечание

/var/lib/pve/local-btrfs — он используется для хранения данных, необходимых для работы виртуализации.

Примечание

Примечание

Примечание

/var/lib/pve/local-btrfs. Для того чтобы использовать данный подтом инструментами PVE, в /etc/pve/storage.cfg будет создана следующая конфигурация:

dir: local

path /var/lib/vz

content iso,vztmpl,backup

disable # стандарное хранилище отключено

btrfs: local-btrfs

path /var/lib/pve/local-btrfs

content iso,vztmpl,backup,images,rootdir

Таким образом, хранилище local будет отключено в пользу local-btrfs, расположенного на дополнительном подтоме. Хранилище local-btrfs поддерживает все типы данных (образы, шаблоны, резервные копии и т.д).

# btrfs subvolume list /

ID 256 gen 160 top level 5 path var_lib_pve_local-btrfs

ID 257 gen 196 top level 5 path root

ID 258 gen 134 top level 257 path var/lib/machines

Предупреждение

/etc/fstab).

/root/.install-log, после чего из неё будут удалены все загрузочные записи, что приведёт к восстановлению полностью заполненной NVRAM и гарантирует загрузку вновь установленной ОС;

Примечание

Примечание

Примечание

Примечание

Примечание

Важно

#apt-get update#apt-get dist-upgrade#update-kernel#apt-get clean#reboot

Примечание

$ su -

или зарегистрировавшись в системе под именем root. Про режим суперпользователя можно почитать в главе Режим суперпользователя.

Примечание

Важно

Важно

nomodeset — не использовать modeset-драйверы для видеокарты;

vga=normal — отключить графический экран загрузки установщика;

xdriver=vesa — явно использовать видеодрайвер vesa. Данным параметром можно явно указать нужный вариант драйвера;

acpi=off noapic — отключение ACPI (управление питанием), если система не поддерживает ACPI полностью.

apm=off acpi=off mce=off barrier=off vga=normal). В безопасном режиме отключаются все параметры ядра, которые могут вызвать проблемы при загрузке. В этом режиме установка будет произведена без поддержки APIC. Возможно, у вас какое-то новое или нестандартное оборудование, но может оказаться, что оно отлично настраивается со старыми драйверами.

Log in as root localhost login:После ввода логина логина суперпользователя (root) появится приглашение командной строки:

[root@localhost /]#. Начиная с этого момента, система готова к вводу команд.

fixmbr без параметров. Программа попытается переустановить загрузчик в автоматическом режиме.

Содержание

Важно

Содержание

qmhttps://<имя-компьютера>:8006. Потребуется пройти аутентификацию (логин по умолчанию: root, пароль указывается в процессе установки ОС):

Примечание

Примечание

Важно

#control sshd-permit-root-login without_password#systemctl restart sshd

#А после того, как сервер будет добавлен, снова отключить.control sshd-permit-root-login enabled#systemctl restart sshd

Таблица 25.1. Используемые порты

|

Порт

|

Функция

|

|---|---|

|

TCP 8006

|

Веб-интерфейс PVE

|

|

TCP 5900-5999

|

Доступ к консоли VNC

|

|

TCP 3128

|

Доступ к консоли SPICE

|

|

TCP 22

|

SSH-доступ

|

|

UDP 5405-5412

|

Трафик кластера corosync

|

|

TCP 60000-60050

|

Живая миграция (память ВМ и данные локального диска)

|

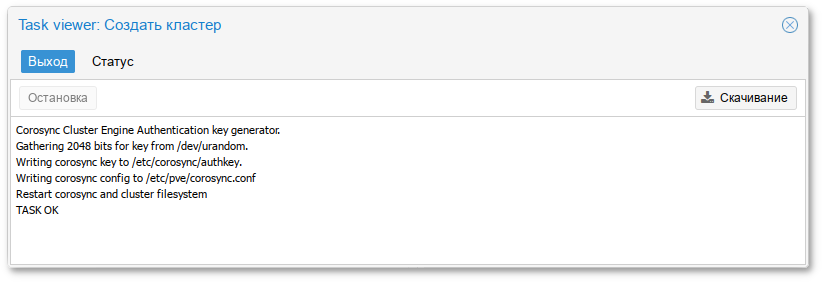

/etc/hosts:

#echo "192.168.0.186 pve01.test.alt pve01" >> /etc/hosts#echo "192.168.0.90 pve02.test.alt pve02" >> /etc/hosts#echo "192.168.0.70 pve03.test.alt pve03" >> /etc/hosts

Примечание

/etc/hosts можно в панели управления: выбрать узел, перейти в → , добавить все узлы, которые будут включены в состав кластера и нажать кнопку :

Примечание

/etc/hosts разрешающимся в 127.0.0.1.

Примечание

/etc/pve на присоединяемом узле будет полностью перезаписано конфигурацией кластера. В частности, присоединяющийся узел не должен содержать гостевые системы, так как это может привести к конфликтам идентификаторов ВМ. Если на узле уже есть ВМ, рекомендуется перед присоединением создать резервные копии всех ВМ (используя vzdump) и восстановить их с новыми идентификаторами после присоединения к кластеру.

Примечание

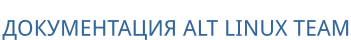

# pvecm create <cluster_name>

# pvecm create pve-cluster

# pvecm status

Cluster information

-------------------

Name: pve-cluster

Config Version: 1

Transport: knet

Secure auth: on

Quorum information

------------------

Date: Mon May 5 13:59:31 2025

Quorum provider: corosync_votequorum

Nodes: 1

Node ID: 0x00000001

Ring ID: 1.5

Quorate: Yes

Votequorum information

----------------------

Expected votes: 1

Highest expected: 1

Total votes: 1

Quorum: 1

Flags: Quorate

Membership information

----------------------

Nodeid Votes Name

0x00000001 1 192.168.0.186 (local)

/etc/pve/corosync.conf. По мере добавления узлов в кластер файл настройки будет автоматически пополняться информацией об узлах.

# pvecm add <existing_node_in_cluster>

где existing_node_in_cluster — адрес уже добавленного узла (рекомендуется указывать самый первый).

Примечание

link0 для установки адреса узла в этой сети:

# pvecm add <existing_node_in_cluster> --link0 <IP_link0>

# pvecm add pve01

где pve01 — имя или IP-адрес «головного» узла.

# pvecm add pve01

Please enter superuser (root) password for 'pve01': ***

Establishing API connection with host 'pve01'

Login succeeded.

Request addition of this node

Join request OK, finishing setup locally

stopping pve-cluster service

backup old database to '/var/lib/pve-cluster/backup/config-1625747072.sql.gz'

waiting for quorum...OK

(re)generate node files

generate new node certificate

merge authorized SSH keys and known hosts

generated new node certificate, restart pveproxy and pvedaemon services

successfully added node 'pve03' to cluster.

/etc/pve/corosync.conf должен содержать информацию об узлах кластера.

#systemctl start pve-cluster pveproxy pvedaemon pvestatd pve-firewall pvefw-logger pve-ha-crm pve-ha-lrm spiceproxy lxc lxcfs lxc-net lxc-monitord qmeventd pvescheduler pve-lxc-syscalld#systemctl enable pve-cluster pveproxy pvedaemon pvestatd pve-firewall corosync pvefw-logger pve-guests pve-ha-crm pve-ha-lrm spiceproxy lxc lxcfs lxc-net lxc-monitord qmeventd pvescheduler pve-lxc-syscalld

pvecm nodes, чтобы определить идентификатор узла, который следует удалить:

# pvecm nodes

Membership information

----------------------

Nodeid Votes Name

1 1 pve01 (local)

2 1 pve02

3 1 pve03

# pvecm delnode pve02

Примечание

Could not kill node (error = CS_ERR_NOT_EXIST)Данную ошибку можно игнорировать. Она возникает, если узел уже недоступен, и не влияет на корректность удаления.

Membership information команда отобразит список узлов кластера без удаленного узла):

# pvecm status

…

Membership information

----------------------

Nodeid Votes Name

0x00000001 1 192.168.0.186 (local)

0x00000003 1 192.168.0.70

Важно

/etc/pve/nodes/<имя_узла> не удаляется автоматически. Он может содержать конфигурации ВМ, хранилищ и другие данные, которые при необходимости можно сохранить или перенести.

Примечание

#Командаpvecm expected 1#pvecm delnode <недоступный_узел>

pvecm expected 1 применяется в ситуациях, когда:

pvecm expected 1 является аварийной мерой управления кластером, а не штатной операцией, и должно применяться только при осознанном принятии риска потери отказоустойчивости.

# pvecm status

…

Votequorum information

----------------------

Expected votes: 5

Highest expected: 5

Total votes: 5

Quorum: 3

Flags: Quorate

…

В выводе команды видно, что в кластере пять узлов (Expected votes), из них для кворума необходимо не менее трёх (Quorum), сейчас все пять узлов активны (Total votes), кворум соблюден (Flags: Quorate).

Примечание

Важно

#А после того, как QDevice будет добавлен, отключить:control sshd-permit-root-login enabled#systemctl restart sshd

#control sshd-permit-root-login without_password#systemctl restart sshd

# apt-get install corosync-qnetd

# corosync-qnetd-certutil -i

Примечание

/etc/sysconfig/corosync-qnetd изменить значение опции COROSYNC_QNETD_OPTIONS:

COROSYNC_QNETD_OPTIONS="-s off"

corosync-qnetd:

# systemctl enable --now corosync-qnetd

# apt-get install corosync-qdevice

# pvecm qdevice setup 192.168.0.88

где 192.168.0.88 — IP-адрес арбитра (внешнего сервера).

# pvecm status

…

Votequorum information

----------------------

Expected votes: 5

Highest expected: 5

Total votes: 5

Quorum: 3

Flags: Quorate Qdevice

Membership information

----------------------

Nodeid Votes Qdevice Name

0x00000001 1 A,V,NMW 192.168.0.186 (local)

0x00000002 1 A,V,NMW 192.168.0.90

0x00000003 1 A,V,NMW 192.168.0.70

0x00000004 1 A,V,NMW 192.168.0.91

0x00000000 1 Qdevice

# pvecm qdevice remove

/etc/pve/priv/ и /etc/pve/nodes/${NAME}/priv/ доступны только root.

/etc/pve/.

Таблица 26.1. Доступные типы хранилищ

|

Хранилище

|

PVE тип

|

Уровень

|

Общее (shared)

|

Снимки (snapshots)

|

|---|---|---|---|---|

|

ZFS (локальный)

|

zfspool

|

файл

|

нет

|

да

|

|

dir

|

файл

|

нет

|

нет (возможны в формате qcow2)

|

|

|

btrfs

|

файл

|

нет

|

да

|

|

|

nfs

|

файл

|

да

|

нет (возможны в формате qcow2)

|

|

|

cifs

|

файл

|

да

|

нет (возможны в формате qcow2)

|

|

|

glusterfs

|

файл

|

да

|

нет (возможны в формате qcow2)

|

|

|

cephfs

|

файл

|

да

|

да

|

|

|

lvm

|

блок

|

нет*

|

нет

|

|

|

lvmthin

|

блок

|

нет

|

да

|

|

|

iscsi

|

блок

|

да

|

нет

|

|

|

iscsidirect

|

блок

|

да

|

нет

|

|

|

rbd

|

блок

|

да

|

да

|

|

|

ZFS over iSCSI

|

zfs

|

блок

|

да

|

да

|

|

pbs

|

файл/блок

|

да

|

-

|

|

|

esxi

|

-

|

да

|

-

|

Примечание

/etc/pve/storage.cfg. Поскольку этот файл находится в /etc/pve/, он автоматически распространяется на все узлы кластера. Таким образом, все узлы имеют одинаковую конфигурацию хранилища.

<type>: <STORAGE_ID>

<property> <value>

<property> <value>

...

/etc/pve/storage.cfg:

# cat /etc/pve/storage.cfg

dir: local

path /var/lib/vz

content iso,vztmpl,snippets,backup,rootdir

shared 0

# хранилище образов по умолчанию при установке на LVM

lvmthin: local-lvm

thinpool data

vgname pve

content images,rootdir

nfs: nfs-storage

export /export/storage

path /mnt/nfs-vol

server 192.168.0.105

content images,iso,backup,vztmpl

options vers=3,nolock,tcp

/var/lib/vz, описание LVN-thin хранилища local-lvm, которое ссылается на группу томов pve, и описание NFS-хранилища nfs-storage.

Таблица 26.2. Параметры хранилищ

|

Свойство

|

Описание

|

|---|---|

|

nodes

|

Список узлов кластера, где хранилище можно использовать/доступно. Можно использовать это свойство, чтобы ограничить доступ к хранилищу.

|

|

content

|

Хранилище может поддерживать несколько типов содержимого. Это свойство указывает, для чего используется это хранилище.

Доступные опции:

|

|

shared

|

Указать, что это единое хранилище с одинаковым содержимым на всех узлах (или на всех перечисленных в опции

nodes). Данное свойство не делает содержимое локального хранилища автоматически доступным для других узлов, он просто помечает как таковое уже общее хранилище!

|

|

disable

|

Отключить хранилище

|

|

maxfiles

|

Устарело, следует использовать свойство prune-backups. Максимальное количество файлов резервных копий на ВМ

|

|

prune-backups

|

Параметры хранения резервных копий

|

|

format

|

Формат образа по умолчанию (raw|qcow2|vmdk)

|

|

preallocation

|

Режим предварительного выделения (off|metadata|falloc|full) для образов raw и qcow2 в файловых хранилищах. По умолчанию используется значение metadata (равносильно значению off для образов raw). При использовании сетевых хранилищ в сочетании с большими образами qcow2, использование значения off может помочь избежать таймаутов.

|

Примечание

local:iso/slinux-10.2-x86_64.iso local:101/vm-101-disk-0.qcow2 local:backup/vzdump-qemu-100-2024_08_22-21_12_33.vma.zst nfs-storage:vztmpl/alt-p10-rootfs-systemd-x86_64.tar.xz

# pvesm path <VOLUME_ID>

Например:

#pvesm path local:iso/slinux-10.2-x86_64.iso/var/lib/vz/template/iso/slinux-10.2-x86_64.iso #pvesm path nfs-storage:vztmpl/alt-p11-rootfs-systemd-x86_64.tar.xz/mnt/pve/nfs-storage/template/cache/alt-p11-rootfs-systemd-x86_64.tar.xz

pvesm (PVE Storage Manager), позволяет выполнять общие задачи управления хранилищами.

#pvesm add <TYPE> <STORAGE_ID> <OPTIONS>#pvesm add dir <STORAGE_ID> --path <PATH>#pvesm add nfs <STORAGE_ID> --path <PATH> --server <SERVER> --export <EXPORT>#pvesm add lvm <STORAGE_ID> --vgname <VGNAME>#pvesm add iscsi <STORAGE_ID> --portal <HOST[:PORT]> --target <TARGET>

# pvesm set <STORAGE_ID> --disable 1

# pvesm set <STORAGE_ID> --disable 0

#pvesm set <STORAGE_ID> <OPTIONS>#pvesm set <STORAGE_ID> --shared 1#pvesm set local --format qcow2#pvesm set <STORAGE_ID> --content iso

# pvesm remove <STORAGE_ID>

# pvesm alloc <STORAGE_ID> <VMID> <name> <size> [--format <raw|qcow2>]

# pvesm alloc local <VMID> '' 4G

# pvesm free <VOLUME_ID>

# pvesm status

# pvesm list <STORAGE_ID> [--vmid <VMID>]

# pvesm list <STORAGE_ID> --content iso

Примечание

Таблица 26.3. Структура каталогов

|

Тип данных

|

Подкаталог

|

|---|---|

|

Образы дисков ВМ

|

images/<VMID>/

|

|

ISO-образы

|

template/iso/

|

|

Шаблоны контейнеров

|

template/cache/

|

|

Резервные копии VZDump

|

dump/

|

|

Фрагменты (сниппеты)

|

snippets/

|

|

Импорт

|

import/

|

Примечание

/etc/fstab, а затем определить хранилище каталогов для этой точки монтирования. Таким образом, можно использовать любую файловую систему (ФС), поддерживаемую Linux.

Примечание

/mnt/iso:

path — указание каталога (это должен быть абсолютный путь к файловой системе);

content-dirs (опционально) — позволяет изменить макет по умолчанию. Состоит из списка идентификаторов, разделенных запятыми, в формате:

vtype=pathгде vtype — один из разрешенных типов контента для хранилища, а path — путь относительно точки монтирования хранилища.

/etc/pve/storage.cfg):

dir: backup

path /mnt/backup

content backup

prune-backups keep-last=7

shared 0

content-dirs backup=custom/backup

/mnt/backup/custom/backup.

Примечание

shared (Общий доступ) можно установить только для кластерных ФС (например, ocfs2).

VM-<VMID>-<NAME>.<FORMAT>где:

# ls /var/lib/vz/images/101

vm-101-disk-0.qcow2 vm-101-disk-1.qcow2

base-<VMID>-<NAME>.<FORMAT>

/etc/fstab).

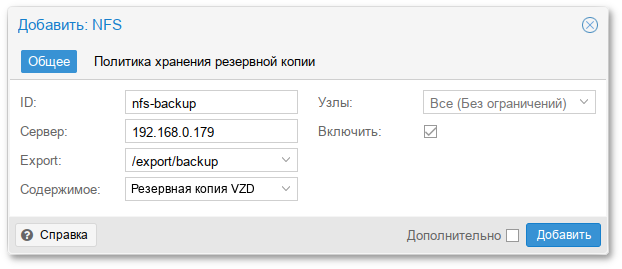

shared, который всегда установлен. Кроме того, для настройки NFS используются следующие свойства:

server — IP-адрес сервера или DNS-имя. Предпочтительнее использовать IP-адрес вместо DNS-имени (чтобы избежать задержек при поиске DNS);

export — совместный ресурс с сервера NFS (список можно просмотреть, выполнив команду pvesm scan nfs <server>);

path — локальная точка монтирования (по умолчанию /mnt/pve/<STORAGE_ID>/);

content-dirs (опционально) — позволяет изменить макет по умолчанию. Состоит из списка идентификаторов, разделенных запятыми, в формате:

vtype=pathгде vtype — один из разрешенных типов контента для хранилища, а path — путь относительно точки монтирования хранилища;

options — параметры монтирования NFS (см. man nfs).

/etc/pve/storage.cfg):

nfs: nfs-storage

export /export/storage

path /mnt/pve/nfs-storage

server 192.168.0.105

content images,backup,vztmpl,iso

options vers=3,nolock,tcp

Примечание

soft, в этом случае будет выполняться только три запроса.

Примечание

# systemctl enable --now nfs-client.target

/export/storage.

pvesm:

# pvesm add nfs nfs-storage --path /mnt/nfs-vol --server 192.168.0.105 --options vers=3,nolock,tcp --export /export/storage --content images,iso,vztmpl,backup

# pvesm nfsscan <server>

Примечание

Примечание

is_mountpoint.

/etc/pve/storage.cfg):

btrfs: btrfs-storage

path /mnt/data/btrfs-storage

content rootdir,images

is_mountpoint /mnt/data

nodes pve02

prune-backups keep-all=1

В данном примере файловая система BTRFS смонтирована в /mnt/data, а в качестве пула хранения данных добавляется её подкаталог btrfs-storage/.

/mnt/data:

pvesm:

# pvesm add btrfs btrfs-storage --path /mnt/data/btrfs-storage --is_mountpoint /mnt/data/ --content images,rootdir

# mkfs.btrfs -m single -d single -L My-Storage /dev/sdd

Параметры -m и -d используются для установки профиля для метаданных и данных соответственно. С помощью необязательного параметра -L можно установить метку.

# mkfs.btrfs -m raid1 -d raid1 -L My-Storage /dev/sdb1 /dev/sdc1

#mkdir /mnt/data#mount /dev/sdd /mnt/data

/etc/fstab. Рекомендуется использовать значение UUID (выведенное командой mkfs.btrfs), например:

UUID=5a556184-43b2-4212-bc21-eee3798c8322 /mnt/data btrfs defaults 0 0Выполнить проверку монтирования:

# mount -a

Результатом выполнения команды должен быть пустой вывод без ошибок.

Примечание

# blkid

/dev/sdd: LABEL="My-Storage" UUID="5a556184-43b2-4212-bc21-eee3798c8322" BLOCK_SIZE="4096" TYPE="btrfs"

# btrfs subvolume create /mnt/data/btrfs-storage

# btrfs subvolume snapshot -r /mnt/data/btrfs-storage /mnt/data/new

Будет создан доступный только для чтения «клон» подтома /mnt/data/btrfs-storage. Чтобы из снимка, доступного только для чтения, создать его версию, доступную для записи, следует просто создать его снимок без опции -r.

# btrfs subvolume list /mnt/data

ID 256 gen 17 top level 5 path btrfs-storage

ID 257 gen 14 top level 5 path new

# btrfs subvolume delete /mnt/data/btrfs-storage

# btrfs filesystem usage /mnt/data

или:

$ btrfs filesystem df /mnt/data

Примечание

shared, который всегда установлен. Кроме того, для настройки CIFS используются следующие свойства:

server — IP-адрес сервера или DNS-имя. Предпочтительнее использовать IP-адрес вместо DNS-имени (чтобы избежать задержек при поиске DNS);

share — совместный ресурс с сервера CIFS (список можно просмотреть, выполнив команду pvesm scan cifs <server>);

username — имя пользователя для хранилища CIFS (опционально, по умолчанию «guest»);

password — пароль пользователя (опционально). Пароль будет сохранен в файле, доступном только для чтения root-пользователю (/etc/pve/priv/storage/<STORAGE-ID>.pw);

domain — устанавливает домен пользователя (рабочую группу) для этого хранилища (опционально);

smbversion — версия протокола SMB (опционально, по умолчанию 3). Версия 1 не поддерживается;

path — локальная точка монтирования (по умолчанию /mnt/pve/<STORAGE_ID>/);

content-dirs (опционально) — позволяет изменить макет по умолчанию. Состоит из списка идентификаторов, разделенных запятыми, в формате:

vtype=pathгде vtype — один из разрешенных типов контента для хранилища, а path — путь относительно точки монтирования хранилища;

options — дополнительные параметры монтирования CIFS (см. man mount.cifs). Некоторые параметры устанавливаются автоматически, и их не следует задавать в этом параметре. PVE всегда устанавливает опцию soft;

subdir — подкаталог общего ресурса, который необходимо смонтировать (опционально, по умолчанию используется корневой каталог общего ресурса).

/etc/pve/storage.cfg):

cifs: newCIFS

path /mnt/pve/newCIFS

server 192.168.0.105

share smb_data

smbversion 2.1

# pvesm cifsscan <server> [--username <username>] [--password]

# pvesm add cifs <storagename> --server <server> --share <share> [--username <username>] [--password]

Примечание

# pvesm add cifs newCIFS --server 192.168.0.105 --share smb_data --smbversion 2.1

Примечание

server — IP-адрес или DNS-имя сервера GlusterFS;

server2 — IP-адрес или DNS-имя резервного сервера GlusterFS;

volume — том GlusterFS;

transport — транспорт GlusterFS: tcp, unix или rdma.

/etc/pve/storage.cfg):

glusterfs: gluster-01

server 192.168.0.105

server2 192.168.0.110

volume glustervol

content images,iso

Примечание

# modprobe zfs

#zfsв файле

/etc/modules-load.d/zfs.conf.

pool — пул/файловая система ZFS;

blocksize — размер блока;

sparse — использовать тонкое выделение ресурсов;

mountpoint — точка монтирования пула/файловой системы ZFS. Изменение этого параметра не влияет на свойство точки монтирования набора данных, видимого zfs. По умолчанию /<pool>.

/etc/pve/storage.cfg):

zfspool: vmdata

pool vmdata

content images,rootdir

mountpoint /vmdata

nodes pve03

Примечание

cannot destroy 'data/vm-101-disk-0': dataset is busyЧтобы избежать этой ситуации следует исключить ZFS-диски из области сканирования LVM, добавив в конфигурацию LVM (файл

/etc/lvm/lvm.conf) в секцию devices{} строки:

# Do not scan ZFS zvols (to avoid problems on ZFS zvols snapshots) filter = [ "r|^/dev/zd*|" ] global_filter = [ "r|^/dev/zd*|" ]

zfs и zpool.

# zpool create -f -o ashift=12 <pool> <device1> <device2>

# zpool create -f -o ashift=12 <pool> mirror <device1> <device2>

# zpool create -f -o ashift=12 <pool> mirror <device1> <device2> mirror <device3> <device4>

# zpool create -f -o ashift=12 <pool> raidz1 <device1> <device2> <device3>

# zpool create -f -o ashift=12 <pool> raidz2 <device1> <device2> <device3> <device4>

# zpool replace -f <pool> <old device> <new device>

# zfs set compression=on <pool>

# pvesm zfsscan

# zpool create -f vmdata mirror sdb sdc

# zpool list

NAME SIZE ALLOC FREE CKPOINT EXPANDSZ FRAG CAP DEDUP HEALTH ALTROOT

vmdata 17,5G 492K 17,5G - - 0% 0% 1.00x ONLINE -

Просмотреть статус пула:

# zpool status

pool: vmdata

state: ONLINE

config:

NAME STATE READ WRITE CKSUM

vmdata ONLINE 0 0 0

mirror-0 ONLINE 0 0 0

sdb ONLINE 0 0 0

sdc ONLINE 0 0 0

errors: No known data errors

vgname — имя группы томов LVM (должно указывать на существующую группу томов);

base — базовый том. Этот том автоматически активируется перед доступом к хранилищу. Это особенно полезно, когда группа томов LVM находится на удаленном сервере iSCSI;

saferemove — обнуление данных при удалении LV (гарантирует, что при удалении тома все данные будут удалены);

saferemove_throughput — очистка пропускной способности (значение параметра cstream -t).

/etc/pve/storage.cfg):

lvm: vg

vgname vg

content rootdir,images

nodes pve03

shared 0

Примечание

/dev/sdd:

# pvcreate /dev/sdd

Physical volume "/dev/sdd" successfully created.

# vgcreate vg /dev/sdd

Volume group "vg" successfully created

# pvs

PV VG Fmt Attr PSize PFree

/dev/sdd vg lvm2 a-- <18,00g <3,00g

# vgs

VG #PV #LV #SN Attr VSize VFree

vg 1 2 0 wz--n- <18,00g <3,00g

# pvesm lvmscan

vg

# pvesm add lvm myspace --vgname vg --nodes pve03

vgname — имя группы томов LVM (должно указывать на существующую группу томов);

thinpool — название тонкого пула LVM.

/etc/pve/storage.cfg):

lvmthin: vmstore

thinpool vmstore

vgname vmstore

content rootdir,images

nodes pve03

Примечание

# lvcreate -L 80G -T -n vmstore vg

# pvesm lvmthinscan vg

vmstore

# pvesm add lvmthin vmstore --thinpool vmstore --vgname vg --nodes pve03

portal — IP-адрес или DNS-имя сервера iSCSI;

target — цель iSCSI.

/etc/pve/storage.cfg):

iscsi: test1-iSCSI

portal 192.168.0.105

target iqn.2021-7.local.omv:test

content images

Примечание

content noneВ этом случае нельзя будет создавать ВМ с использованием iSCSI LUN напрямую.

Примечание

# systemctl enable --now iscsid

# pvesm scan iscsi <IP-адрес сервера[:порт]>

# pvesm add iscsi <ID> --portal <Сервер iSCSI> --target <Цель iSCSI> --content none

Примечание

/etc/pve/storage.cfg):

iscsidirect: test1-iSCSi

portal 192.168.0.191

target dc1.test.alt:server.target

monhost — список IP-адресов демона монитора (только если Ceph не работает на кластере PVE);

pool — название пула Ceph (rbd);

username — идентификатор пользователя Ceph (только если Ceph не работает на кластере PVE);

krbd (опционально) — обеспечивает доступ к блочным устройствам rados через модуль ядра krbd.

Примечание

krbd.

/etc/pve/storage.cfg):

rbd: new

content images

krbd 0

monhost 192.168.0.105

pool rbd

username admin

/root узла:

# scp <external cephserver>:/etc/ceph/ceph.client.admin.keyring /root/rbd.keyring

# pvesm add rbd <name> --monhost "10.1.1.20 10.1.1.21 10.1.1.22" --content images --keyring /root/rbd.keyring

/etc/pve/priv/ceph/<STORAGE_ID>.keyring.

Примечание

monhost — список IP-адресов демона монитора (только если Ceph не работает на кластере PVE);

path — локальная точка монтирования (по умолчанию используется /mnt/pve/<STORAGE_ID>/);

username — идентификатор пользователя (только если Ceph не работает на кластере PVE);

subdir — подкаталог CephFS для монтирования (по умолчанию /);

fuse — доступ к CephFS через FUSE (по умолчанию 0).

/etc/pve/storage.cfg):

cephfs: cephfs-external

content backup

monhost 192.168.0.105

path /mnt/pve/cephfs-external

username admin

Примечание

# ceph fs ls

/root узла:

# scp <external cephserver>:/etc/ceph/cephfs.secret /root/cephfs.secret

# pvesm add cephfs <name> --monhost "10.1.1.20 10.1.1.21 10.1.1.22" --content backup --keyring /root/cephfs.secret

/etc/pve/priv/ceph/<STORAGE_ID>.secret.

# ceph auth get-key client.userid > cephfs.secret

server — IP-адрес или DNS-имя сервера резервного копирования;

username — имя пользователя на сервере резервного копирования (например, root@pam, backup_u@pbs);

password — пароль пользователя. Значение будет сохранено в файле /etc/pve/priv/storage/<STORAGE-ID>.pw, доступном только суперпользователю;

datastore — идентификатор хранилища на сервере резервного копирования;

fingerprint — отпечаток TLS-сертификата API Proxmox Backup Server. Требуется, если сервер резервного копирования использует самоподписанный сертификат. Отпечаток можно получить в веб-интерфейсе сервера резервного копирования или с помощью команды proxmox-backup-manager cert info;

encryption-key — ключ для шифрования резервной копии. В настоящее время поддерживаются только те файлы, которые не защищены паролем (без функции получения ключа (kdf)). Ключ будет сохранен в файле /etc/pve/priv/storage/<STORAGE-ID>.enc, доступном только суперпользователю. Опционально;

master-pubkey — открытый ключ RSA, используемый для шифрования копии ключа шифрования (encryption-key) в рамках задачи резервного копирования. Зашифрованная копия будет добавлена к резервной копии и сохранена на сервере резервного копирования для целей восстановления. Опционально, требуется encryption-key.

/etc/pve/storage.cfg):

pbs: pbs_backup

datastore store2

server 192.168.0.123

content backup

fingerprint 42:5d:29:20:…:d1:be:bc:c0:c0:a9:9b:b1:a8:1b

prune-backups keep-all=1

username root@pam

# pvesm add pbs pbs_backup --server 192.168.0.123 --datastore store2 --username root@pam --fingerprint 42:5d:29:20:…:d1:be:bc:c0:c0:a9:9b:b1:a8:1b --password

encryption-key, либо через веб-интерфейс:

/etc/pve/priv/storage/<STORAGE-ID>.enc, который доступен только пользователю root.

Примечание

proxmox-backup-client key. Например, сгенерировать ключ:

# proxmox-backup-client key create --kdf none <path>

Сгенерировать мастер-ключ:

# proxmox-backup-client key create-master-key

Важно

Важно

Примечание

server — IP-адрес или DNS-имя сервера ESXi;

username — имя администратора на сервере ESXi;

password — пароль администратора. Значение будет сохранено в файле /etc/pve/priv/storage/<STORAGE-ID>.pw, доступном только суперпользователю;

skip-cert-verification — отключить проверку сертификата TLS (следует включать только в полностью доверенных сетях).

/etc/pve/storage.cfg):

esxi: myESXi

server 192.168.0.130

username root

skip-cert-verification 1

# pvesm add esxi myESXi --server 192.168.0.130 \

--username root --skip-cert-verification 1 --password

Примечание

Примечание

systool из пакета sysfsutils.

# apt-get install sysfsutils

# systool -c fc_host -A port_name

Class = "fc_host"

Class Device = "host1"

port_name = "0x10000090fa59a61a"

Device = "host1"

Class Device = "host16"

port_name = "0x10000090fa59a61b"

Device = "host16"

# lsblk

NAME MAJ:MIN RM SIZE RO TYPE MOUNTPOINTS

sda 8:0 0 59G 0 disk

sdb 8:16 0 931,3G 0 disk

└─mpatha 253:0 0 931,3G 0 mpath

sdc 8:32 0 931,3G 0 disk

└─mpatha 253:0 0 931,3G 0 mpath

sdd 8:48 0 931,3G 0 disk

└─mpatha 253:0 0 931,3G 0 mpath

sde 8:64 0 931,3G 0 disk

└─mpatha 253:0 0 931,3G 0 mpath

В данном примере один LUN на 1000GB виден по четырем путям.

node.startup значение automatic. Значение по умолчанию для параметра node.session.timeo.replacement_timeout составляет 120 секунд. Рекомендуется использовать значение — 15 секунд.

/etc/iscsi/iscsid.conf (по умолчанию). Если iSCSI target уже подключен, то необходимо изменить настройки по умолчанию для конкретной цели в файле /etc/iscsi/nodes/<TARGET>/<PORTAL>/default.

#apt-get install open-iscsi#systemctl enable --now iscsid

/etc/iscsi/iscsid.conf:

node.startup = automatic node.session.timeo.replacement_timeout = 15

#iscsiadm -m discovery -t sendtargets -p <iscsi-target-1-ip>#iscsiadm -m discovery -t sendtargets -p <iscsi-target-2-ip>#iscsiadm -m node --login

/etc/iscsi/iscsid.conf:

node.startup = automatic

/var/lib/iscsi/send_targets/<TargetServer>,<Port>/st_config:

discovery.sendtargets.use_discoveryd = Yes

# lsblk

NAME MAJ:MIN RM SIZE RO TYPE MOUNTPOINTS

sda 8:0 0 59G 0 disk

sdb 8:16 0 931,3G 0 disk

└─mpatha 253:0 0 931,3G 0 mpath

sdc 8:32 0 931,3G 0 disk

└─mpatha 253:0 0 931,3G 0 mpath

sdd 8:48 0 931,3G 0 disk

└─mpatha 253:0 0 931,3G 0 mpath

sde 8:64 0 931,3G 0 disk

└─mpatha 253:0 0 931,3G 0 mpath

В данном примере один LUN на 1000GB виден по четырем путям.

Примечание

iscsiadm:

# iscsiadm -m node --logout

# iscsiadm -m node --targetname "iscsi-target-1.test.alt:server.target1" --logout

# iscsiadm -m node -R

# iscsiadm -m session

# apt-get install multipath-tools

И запущена служба multipathd:

# systemctl enable --now multipathd && sleep 5; systemctl status multipathd

Примечание

multipath используется для обнаружения и объединения нескольких путей к устройствам.

multipath:

-l — отобразить текущую multipath-топологию, полученную из sysfs и устройства сопоставления устройств;

-ll — отобразить текущую multipath-топологию, собранную из sysfs, устройства сопоставления устройств и всех других доступных компонентов системы;

-f device — удалить указанное multipath-устройство;

-F — удалить все неиспользуемые multipath-устройства;

-w device — удалить WWID указанного устройства из файла wwids;

-W — сбросить файл wwids, чтобы включить только текущие многопутевые устройства;

-r — принудительная перезагрузка multipath-устройства.

# multipath -ll

mpatha (3600c0ff00014f56ee9f3cf6301000000) dm-0 HP,P2000 G3 FC

size=931G features='1 queue_if_no_path' hwhandler='1 alua' wp=rw

|-+- policy='service-time 0' prio=50 status=active

| |- 1:0:0:1 sdb 8:16 active ready running

| `- 16:0:1:1 sde 8:64 active ready running

`-+- policy='service-time 0' prio=10 status=enabled

|- 1:0:1:1 sdc 8:32 active ready running

`- 16:0:0:1 sdd 8:48 active ready running

# multipath -v3

/etc/multipath.conf:

defaults {

find_multipaths yes

user_friendly_names yes

}

user_friendly_names установлено значение no, то для имени multipath-устройства задается значение World Wide Identifier (WWID). Имя устройства будет /dev/mapper/WWID и /dev/dm-X:

#Если для параметраls /dev/mapper/3600c0ff00014f56ee9f3cf6301000000 #lsblkNAME MAJ:MIN RM SIZE RO TYPE MOUNTPOINTS sda 8:0 0 59G 0 disk sdb 8:16 0 931,3G 0 disk └─3600c0ff00014f56ee9f3cf6301000000 253:0 0 931,3G 0 mpath sdc 8:32 0 931,3G 0 disk └─3600c0ff00014f56ee9f3cf6301000000 253:0 0 931,3G 0 mpath sdd 8:48 0 931,3G 0 disk └─3600c0ff00014f56ee9f3cf6301000000 253:0 0 931,3G 0 mpath sde 8:64 0 931,3G 0 disk └─3600c0ff00014f56ee9f3cf6301000000 253:0 0 931,3G 0 mpath

user_friendly_names установлено значение yes, то для имени multipath-устройства задаётся алиас (псевдоним), в форме mpathХ. Имя устройства будет /dev/mapper/mpathХ и /dev/dm-X:

#Однако не гарантируется, что имя устройства будет одинаковым на всех узлах, использующих это multipath-устройство.ls /dev/mapper/mpatha #lsblkNAME MAJ:MIN RM SIZE RO TYPE MOUNTPOINTS sda 8:0 0 59G 0 disk sdb 8:16 0 931,3G 0 disk └─mpatha 253:0 0 931,3G 0 mpath sdc 8:32 0 931,3G 0 disk └─mpatha 253:0 0 931,3G 0 mpath sdd 8:48 0 931,3G 0 disk └─mpatha 253:0 0 931,3G 0 mpath sde 8:64 0 931,3G 0 disk └─mpatha 253:0 0 931,3G 0 mpath

/dev/mapper/mpatha). Для этого в файл /etc/multipath.conf добавить секции:

blacklist {

wwid .*

}

blacklist_exceptions {

wwid "3600c0ff00014f56ee9f3cf6301000000"

}

Данная настройка предписывает внести в черный список любые найденные устройства хранения данных, за исключением нужного.

multipaths {

multipath {

wwid "3600c0ff00014f56ee9f3cf6301000000"

alias mpatha

}

}

В этом случае устройство всегда будет доступно только по имени /dev/mapper/mpatha. Вместо mpatha можно вписать любое желаемое имя устройства.

Примечание

# /lib/udev/scsi_id -g -u -d /dev/sdb

3600c0ff00014f56ee9f3cf6301000000

Для устройств в одном multipath WWID будут совпадать.

/etc/multipath.conf может также потребоваться внести рекомендованные производителем СХД параметры.

/etc/multipath.conf необходимо перезапустить службу multipathd для активации настроек:

# systemctl restart multipathd.service

Примечание

/etc/multipath.conf на наличие ошибок можно, выполнив команду:

# multipath -t

Примечание

Примечание

/etc/lvm/lvm.conf, например:

filter = [ "a|/dev/mapper/|", "a|/dev/sda.*|", "r|.*|" ]В данном примере принимаются только multipath-устройства и

/dev/sda.*, все остальные устройства отклоняются:

/dev/mapper;

/dev/sda;

# fdisk -l /dev/mapper/mpatha

Disk /dev/mapper/mpatha: 931.32 GiB, 999999995904 bytes, 1953124992 sectors

Units: sectors of 1 * 512 = 512 bytes

Sector size (logical/physical): 512 bytes / 512 bytes

I/O size (minimum/optimal): 512 bytes / 1048576 bytes

Disklabel type: dos

Disk identifier: 0x2221951e

Device Boot Start End Sectors Size Id Type

/dev/mapper/mpatha-part1 2048 1953124991 1953122944 931.3G 83 Linux

# pvcreate /dev/mapper/mpatha-part1

Physical volume "/dev/mapper/mpatha-part1" successfully created.

# vgcreate VG1 /dev/mapper/mpatha-part1

Volume group "VG1" successfully created

# pvs

PV VG Fmt Attr PSize PFree

/dev/mapper/mpatha-part1 VG1 lvm2 a-- 931.32g 931.32g

# pvesm lvmscan

VG1

# pvesm add lvm mpath-lvm --vgname VG1 --content images,rootdir

# pvs

PV VG Fmt Attr PSize PFree

/dev/mapper/mpatha-part1 VG1 lvm2 a-- 931.32g 931.32g

# vgs

VG #PV #LV #SN Attr VSize VFree

VG1 1 0 0 wz--n- 931.32g 931.32g

# lvcreate -L 100G -T -n vmstore VG1

Logical volume "vmstore" created.

# pvesm lvmthinscan VG1

vmstore

# pvesm add lvmthin mpath-lvmthin --thinpool vmstore --vgname VG1 --nodes pve01

# multipath -l

mpatha (3600c0ff00014f56ee9f3cf6301000000) dm-0 HP,P2000 G3 FC

size=465G features='1 queue_if_no_path' hwhandler='1 alua' wp=rw

|-+- policy='service-time 0' prio=0 status=active

| |- 1:0:1:1 sdc 8:32 active undef running

| `- 16:0:1:1 sde 8:64 active undef running

`-+- policy='service-time 0' prio=0 status=enabled

|- 1:0:0:1 sdb 8:16 active undef running

`- 16:0:0:1 sdd 8:48 active undef running

# echo 1 > /sys/block/<path_device>/device/rescan

#echo 1 > /sys/block/sdb/device/rescan#echo 1 > /sys/block/sdc/device/rescan#echo 1 > /sys/block/sdd/device/rescan#echo 1 > /sys/block/sde/device/rescan

# dmesg -wHT

# multipathd -k"resize map 3600c0ff00014f56ee9f3cf6301000000"

где 3600c0ff00014f56ee9f3cf6301000000 — WWID multipath-устройства;

# pvresize /dev/mapper/mpatha

# resize2fs /dev/mapper/mpatha

Примечание

pveceph — инструмент для установки и управления службами Ceph на узлах PVE.

ls, find и т.д.), не создавая огромной нагрузки на кластер хранения Ceph.

Таблица 26.4. Системные требования к оборудованию для Ceph

|

Процесс

|

Критерий

|

Требования

|

|---|---|---|

|

Монитор Ceph

|

Процессор

|

2 ядра минимум, 4 рекомендуется

|

|

ОЗУ

|

5ГБ+ (большим/производственным кластерам нужно больше)

|

|

|

Жёсткий диск

|

100 ГБ на демон, рекомендуется SSD

|

|

|

Сеть

|

1 Гбит/с (рекомендуется 10+ Гбит/с)

|

|

|

Менеджер Ceph

|

Процессор

|

1 ядро

|

|

ОЗУ

|

1 ГБ

|

|

|

OSD Ceph

|

Процессор

|

|

|

ОЗУ

|

|

|

|

Жёсткий диск

|

1 SSD накопитель на демон

|

|

|

Сеть

|

1 Гбит/с (рекомендуется агрегированная сеть 10+ Гбит/с)

|

|

|

Сервер метаданных Ceph

|

Процессор

|

2 ядра

|

|

ОЗУ

|

2 ГБ+ (для производственных кластеров больше)

|

|

|

Жёсткий диск

|

1 ГБ на демон, рекомендуется SSD

|

|

|

Сеть

|

1 Гбит/с (рекомендуется 10+ Гбит/с)

|

|

Примечание

Примечание

# pveceph init --network 192.168.0.0/24

/etc/pve/ceph.conf с выделенной сетью для Ceph. Файл /etc/pve/ceph.conf автоматически распространяется на все узлы PVE с помощью pmxcfs. Будет также создана символическая ссылка /etc/ceph/ceph.conf, которая указывает на файл /etc/pve/ceph.conf. Таким образом, можно запускать команды Ceph без необходимости указывать файл конфигурации.

Примечание

# pveceph mon create

# pveceph mon destroy <mon_id>

Примечание

# pveceph mgr create

# pveceph mgr destroy <mgr_id>

# ceph-volume lvm zap /dev/[X] --destroy

Предупреждение

# pveceph osd create /dev/[X]

-db_dev и -wal_dev:

# pveceph osd create /dev/[X] -db_dev /dev/[Y] -wal_dev /dev/[Z]

Если диск для журналирования не указан, WAL размещается вместе с DB.

-db_size и -wal_size соответственно. Если эти параметры не указаны, будут использоваться следующие значения (по порядку):

Примечание

#Первая команда указывает Ceph не включать OSD в распределение данных. Вторая команда останавливает службу OSD. До этого момента данные не теряются.ceph osd out <ID>#systemctl stop ceph-osd@<ID>.service

-cleanup, чтобы дополнительно уничтожить таблицу разделов):

# pveceph osd destroy <ID>

Предупреждение

pveceph pool create):

-size) — количество реплик на объект. Ceph всегда пытается иметь указанное количество копий объекта (по умолчанию 3);

warn, выводится предупреждающее сообщение, если в пуле неоптимальное количество PG (по умолчанию warn);

-add_storages) — настроить хранилище с использованием нового пула. Доступно только при создании пула (по умолчанию true);

-min_size) — минимальное количество реплик для объекта. Ceph отклонит ввод-вывод в пуле, если в PG меньше указанного количества реплик (по умолчанию 2);

-crush_rule) — правило, используемое для сопоставления размещения объектов в кластере. Эти правила определяют, как данные размещаются в кластере;

-pg_num) — количество групп размещения, которые должен иметь пул в начале (по умолчанию 128);

-target_size_ratio) — соотношение ожидаемых данных в пуле. Автомасштабирование PG использует соотношение относительно других наборов соотношений. Данный параметр имеет приоритет над целевым размером, если установлены оба;

-target_size) — предполагаемый объем данных, ожидаемых в пуле. Автомасштабирование PG использует этот размер для оценки оптимального количества PG;

-pg_num_min) — минимальное количество групп размещения. Этот параметр используется для точной настройки нижней границы количества PG для этого пула. Автомасштабирование PG не будет объединять PG ниже этого порогового значения.

Примечание

min_size равным 1. Реплицированный пул с min_size равным 1 разрешает ввод-вывод для объекта, при наличии только одной реплики, что может привести к потере данных, неполным PG или ненайденным объектам.

# pveceph pool create <pool-name> -add_storages

size), тогда как в пуле EC данные разбиваются на k фрагментов данных с дополнительными m фрагментами кодирования (проверки). Эти фрагменты кодирования можно использовать для воссоздания данных, если фрагменты данных отсутствуют.

m определяет, сколько OSD может быть потеряно без потери данных. Общее количество хранимых объектов равно k + m.

pveceph. При планировании пула EC необходимо учитывать тот факт, что они работают иначе, чем реплицированные пулы.

min_size для пула EC зависит от параметра m. Если m = 1, значение min_size для пула EC будет равно k. Если m > 1, значение min_size будет равно k + 1. В документации Ceph рекомендуется использовать консервативное значение min_size, равное k + 2.

min_size OSD, любой ввод-вывод в пул будет заблокирован до тех пор, пока снова не будет достаточно доступных OSD.

Примечание

min_size, так как он определяет, сколько OSD должно быть доступно. В противном случае ввод-вывод будет заблокирован.

k = 2 и m = 1 будет иметь size = 3, min_size = 2 и останется работоспособным, если один OSD выйдет из строя. Если пул настроен с k = 2, m = 2, будет иметь size = 4 и min_size = 3 и останется работоспособным, если один OSD будет потерян.

# pveceph pool create <pool-name> --erasure-coding k=<integer> ,m=<integer> \

[,device-class=<class>] [,failure-domain=<domain>] [,profile=<profile>]

--add_storages 0. При настройке конфигурации хранилища вручную необходимо будет задать параметр data-pool, только тогда пул EC будет использоваться для хранения объектов данных.

Примечание

--size, --min_size и --crush_rule будут использоваться для реплицированного пула метаданных, но не для пула данных EC. Если нужно изменить min_size в пуле данных, это можно будет сделать позже. Параметры size и crush_rule нельзя изменить в пулах EC.

profile. Например:

# pveceph pool create <pool-name> --erasure-coding profile=<profile-name>

Существующий пул EC можно добавить в качестве хранилища в PVE:

# pvesm add rbd <storage-name> --pool <replicated-pool> --data-pool <ec-pool>

Примечание

keyring и monhost.

# pveceph pool destroy <name>

-cleanup, чтобы дополнительно уничтожить таблицу разделов):

# pveceph osd destroy <ID>

Чтобы также удалить связанное хранилище следует указать опцию -remove_storages.

Примечание

Примечание

# ceph mgr module enable pg_autoscaler

Список запущенных модулей можно посмотреть, выполнив команду:

# ceph mgr module ls

warn — предупреждение о работоспособности выдается, если предлагаемое значение pg_num слишком сильно отличается от текущего значения;

on — pg_num настраивается автоматически без необходимости ручного вмешательства;

off — автоматические корректировки pg_num не производятся, и предупреждение не выдается, если количество PG не является оптимальным.

target_size, target_size_ratio и pg_num_min.

# ceph osd crush tree --show-shadow

ID CLASS WEIGHT TYPE NAME

-6 nvme 0.09760 root default~nvme

-5 nvme 0 host pve01~nvme

-9 nvme 0.04880 host pve02~nvme

1 nvme 0.04880 osd.1

-12 nvme 0.04880 host pve03~nvme

2 nvme 0.04880 osd.2

-2 ssd 0.04880 root default~ssd

-4 ssd 0.04880 host pve01~ssd

0 ssd 0.04880 osd.0

-8 ssd 0 host pve02~ssd

-11 ssd 0 host pve03~ssd

-1 0.14639 root default

-3 0.04880 host pve01

0 ssd 0.04880 osd.0

-7 0.04880 host pve02

1 nvme 0.04880 osd.1

-10 0.04880 host pve03

2 nvme 0.04880 osd.2

# ceph osd crush rule create-replicated <rule-name> <root> <failure-domain> <class>

Где:

rule-name — имя политики;

root — корень отказа (значение default — корень Ceph);

failure-domain — домен отказа, на котором должны распределяться объекты (обычно host);

class — какой тип хранилища резервных копий OSD использовать (например, nvme, ssd).

# ceph osd crush rule create-replicated my_rule default host nvme

# ceph osd crush rule dump

# ceph osd pool set <pool-name> crush_rule <rule-name>

Примечание

Примечание

hotstandby при создании сервера, или, после его создания, установив в соответствующем разделе MDS в /etc/pve/ceph.conf параметр:

mds standby replay = trueЕсли этот параметр включен, указанный MDS будет находиться в состоянии warm, опрашивая активный, чтобы в случае возникновения каких-либо проблем быстрее взять на себя управление.

Примечание

# pveceph mds create

pveceph, например:

# pveceph fs create --pg_num 128 --add-storage

--add-storage (опция Добавить как хранилище) добавит CephFS в конфигурацию хранилища PVE.

Предупреждение

# umount /mnt/pve/<STORAGE-NAME>

где <STORAGE-NAME> — имя хранилища CephFS в PVE.

# pveceph stop --service mds.NAME

чтобы остановить их, или команду:

# pveceph mds destroy NAME

чтобы уничтожить их.

# pveceph fs destroy NAME --remove-storages --remove-pools

Это автоматически уничтожит базовые пулы Ceph, а также удалит хранилища из конфигурации PVE.

Примечание

size + 1. Причина этого в том, что балансировщик объектов Ceph CRUSH по умолчанию использует полный узел в качестве «домена отказа».

# ceph osd out osd.<id>

# ceph osd safe-to-destroy osd.<id>

#systemctl stop ceph-osd@<id>.service#pveceph osd destroy <id>

fstrim (discard) на ВМ и контейнерах. Это освобождает блоки данных, которые файловая система больше не использует. В результате снижается нагрузка на ресурсы. Большинство современных ОС регулярно отправляют такие команды discard своим дискам. Нужно только убедиться, что ВМ включают опцию disk discard.

#Эти команды также предоставляют обзор действий, которые необходимо предпринять если кластер находится в неработоспособном состоянии.ceph -s# однократный вывод #ceph -w# непрерывный вывод изменений статуса

/var/log/ceph/.

pvesr.

Примечание

pvesr.

# pvesr create-local-job 214-0 pve03 --schedule "*/10" --rate 10

# pvesr disable 214-0

# pvesr list

JobID Target Schedule Rate Enabled

213-0 local/pve02 */1:00 - yes

214-0 local/pve03 */10 10 no

# pvesr status

JobID Enabled Target LastSync NextSync Duration FailCount State

213-0 Yes local/pve02 2025-02-26_10:10:48 2025-02-26_11:00:00 2.455654 0 OK

# pvesr enable 214-0

# pvesr update 214-0 --schedule '*/1:00'

Примечание

# pvecm status

# pvecm expected 1

Примечание

#mv /etc/pve/nodes/pve02/qemu-server/100.conf /etc/pve/nodes/pve03/qemu-server/100.conf#mv /etc/pve/nodes/pve02/lxc/200.conf /etc/pve/nodes/pve03/lxc/200.conf

#qm start 100#pct start 200

Примечание

#apt-get install ifupdown2#systemctl disable network#systemctl mask network#systemctl enable networking.service#reboot

/etc/network/interfaces, который содержит всю конфигурацию сети.

Примечание

/etc/network/interfaces см. man interfaces(5)

Примечание

/etc/network/interfaces. Изменения сначала записываются во временный файл (/etc/network/interfaces.new), что позволяет сделать несколько связанных изменений одновременно. Это также позволяет убедиться, что изменения сделаны верно, так как неправильная конфигурация сети может сделать узел недоступным.

interfaces.new будут перенесены в файл /etc/network/interfaces и применены в реальном времени.

/etc/network/interfaces, применить их можно, выполнив команду:

# ifreload -a

systemd pvenetcommit активирует файл interfaces.new до того, как сетевая служба применит эту конфигурацию.

en для сетевых устройств Ethernet. Следующие символы зависят от драйвера устройства и того факта, какая схема подходит первой:

ovs_ports;

/etc/network/interfaces может выглядеть следующим образом:

auto lo

iface lo inet loopback

iface eno1 inet manual

iface enp0s20f0u1 inet manual

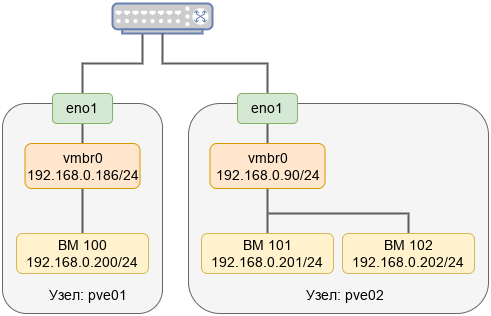

auto vmbr0

iface vmbr0 inet static

address 192.168.0.186/24

gateway 192.168.0.1

bridge-ports eno1

bridge-stp off

bridge-fd 0

bridge-vlan-aware yes

bridge-vids 2-4094

dns-nameservers 8.8.8.8

Примечание

Таблица 28.1. Режимы агрегации Linux Bond

|

Режим

|

Название

|

Описание

|

Отказоустойчивость

|

Балансировка нагрузки

|

|---|---|---|---|---|

|

balance-rr или mode=0

|

Round-robin

|

Режим циклического выбора активного интерфейса для трафика. Пакеты последовательно передаются и принимаются через каждый интерфейс один за другим. Данный режим не требует применения специальных коммутаторов.

|

Да

|

Да

|

|

active-backup или mode=1

|

Active Backup

|

В этом режиме активен только один интерфейс, остальные находятся в режиме горячей замены. Если активный интерфейс выходит из строя, его заменяет резервный. MAC-адрес интерфейса виден извне только на одном сетевом адаптере, что предотвращает путаницу в сетевом коммутаторе. Это самый простой режим, работает с любым оборудованием, не требует применения специальных коммутаторов.

|

Да

|

Нет

|

|

balance-xor или mode=2

|

XOR

|

Один и тот же интерфейс работает с определённым получателем. Передача пакетов распределяется между интерфейсами на основе формулы ((MAC-адрес источника) XOR (MAC-адрес получателя)) % число интерфейсов. Режим не требует применения специальных коммутаторов. Этот режим обеспечивает балансировку нагрузки и отказоустойчивость.

|

Да

|

Да

|

|

broadcast или mode=3

|

Широковещательный

|

Трафик идёт через все интерфейсы одновременно.

|

Да

|

Нет

|

|

LACP (802.3ad) или mode=4

|

Агрегирование каналов по стандарту IEEE 802.3ad

|

В группу объединяются одинаковые по скорости и режиму интерфейсы. Все физические интерфейсы используются одновременно в соответствии со спецификацией IEEE 802.3ad. Для реализации этого режима необходима поддержка на уровне драйверов сетевых карт и коммутатор, поддерживающий стандарт IEEE 802.3ad (коммутатор требует отдельной настройки).

|

Да

|

Да

|

|

balance-tlb или mode=5

|

Адаптивная балансировка нагрузки при передаче

|

Исходящий трафик распределяется в соответствии с текущей нагрузкой (с учетом скорости) на интерфейсах (для данного режима необходима его поддержка в драйверах сетевых карт). Входящие пакеты принимаются только активным сетевым интерфейсом.

|

Да

|

Да (исходящий трафик)

|

|

balance-alb или mode=6

|

Адаптивная балансировка нагрузки

|

Включает в себя балансировку исходящего трафика, плюс балансировку на приём (rlb) для IPv4 трафика и не требует применения специальных коммутаторов (балансировка на приём достигается на уровне протокола ARP, перехватом ARP ответов локальной системы и перезаписью физического адреса на адрес одного из сетевых интерфейсов, в зависимости от загрузки).

|

Да

|

Да

|

xmit_hash_policy).

Таблица 28.2. Режимы выбора каналов при организации балансировки нагрузки

|

Режим

|

Описание

|

|---|---|

|

layer2

|

Канал для отправки пакета однозначно определяется комбинацией MAC-адреса источника и MAC-адреса назначения. Весь трафик между определённой парой узлов всегда идёт по определённому каналу. Алгоритм совместим с IEEE 802.3ad. Этот режим используется по умолчанию.

|

|

layer2+3

|

Канал для отправки пакета определяется по совокупности MAC- и IP-адресов источника и назначения. Трафик между определённой парой IP-хостов всегда идёт по определённому каналу (обеспечивается более равномерная балансировка трафика, особенно в случае, когда большая его часть передаётся через промежуточные маршрутизаторы). Для протоколов 3 уровня, отличных от IP, данный алгоритм равносилен layer2. Алгоритм совместим с IEEE 802.3ad.

|

|

layer3+4

|

Канал для отправки пакета определяется по совокупности IP-адресов и номеров портов источника и назначения (трафик определённого узла может распределяться между несколькими каналами, но пакеты одного и того же TCP/UDP-соединения всегда передаются по одному и тому же каналу). Для фрагментированных пакетов TCP и UDP, а также для всех прочих протоколов 4 уровня, учитываются только IP-адреса. Для протоколов 3 уровня, отличных от IP, данный алгоритм равносилен layer2. Алгоритм не полностью совместим с IEEE 802.3ad.

|

Таблица 28.3. Параметры OVS Bond

|

Параметр

|

Описание

|

|---|---|

|

bond_mode=active-backup

|

В этом режиме активен только один интерфейс, остальные находятся в режиме горячей замены. Если активный интерфейс выходит из строя, его заменяет резервный. MAC-адрес интерфейса виден извне только на одном сетевом адаптере, что предотвращает путаницу в сетевом коммутаторе. Это самый простой режим, работает с любым оборудованием, не требует применения специальных коммутаторов.

|

|

bond_mode=balance-slb

|

Режим простой балансировки на основе MAC и VLAN. В этом режиме нагрузка трафика на интерфейсы постоянно измеряется, и если один из интерфейсов сильно загружен, часть трафика перемещается на менее загруженные интерфейсы. Параметр

bond-rebalance-interval определяет, как часто OVS должен выполнять измерение нагрузки трафика (по умолчанию 10 секунд). Этот режим не требует какой-либо специальной настройки на коммутаторах.

|

|

bond_mode=balance-tcp

|

Этот режим выполняет балансировку нагрузки, принимая во внимание данные уровней 2-4 (например, MAC-адрес, IP -адрес и порт TCP). На коммутаторе должен быть настроен LACP. Этот режим похож на режим mode=4 Linux Bond. Всегда, когда это возможно, рекомендуется использовать этот режим

|

|

lacp=[active|passive|off]

|

Управляет поведением протокола управления агрегацией каналов (LACP). На коммутаторе должен быть настроен протокол LACP. Если коммутатор не поддерживает LACP, необходимо использовать

bond_mode=balance-slb или bond_mode=active-backup.

|

|

other-config:lacp-fallback-ab=true

|

Устанавливает поведение LACP для переключения на

bond_mode=active-backup в качестве запасного варианта

|

|

other_config:lacp-time=[fast|slow]

|

Определяет, с каким интервалом управляющие пакеты LACPDU отправляются по каналу LACP: каждую секунду (fast) или каждые 30 секунд (slow). По умолчанию slow

|

|

other_config:bond-detect-mode=[miimon|carrier]

|

Режим определения состояния канала. По умолчанию carrier

|

|

other_config:bond-miimon-interval=100

|

Устанавливает периодичность MII мониторинга в миллисекундах

|

|

other_config:bond_updelay=1000

|

Задает время задержки в миллисекундах, перед тем как поднять линк при обнаружении восстановления канала

|

|

other_config:bond-rebalance-interval=10000

|

Устанавливает периодичность выполнения измерения нагрузки трафика в миллисекундах (по умолчанию 10 секунд).

|

Примечание

/etc/network/interfaces:

auto lo

iface lo inet loopback

iface enp0s3 inet manual

auto enp0s9

iface enp0s9 inet manual

auto enp0s8

iface enp0s8 inet manual

auto bond0

iface bond0 inet static

address 192.168.200.20/24

bond-slaves enp0s8 enp0s9

bond-miimon 100

bond-mode balance-rr

auto vmbr0

iface vmbr0 inet static

address 192.168.0.90/24

gateway 192.168.0.1

bridge-ports enp0s3

bridge-stp off

bridge-fd 0

dns-nameservers 8.8.8.8

Примечание

bond0 и нажать кнопку :

/etc/network/interfaces:

auto lo

iface lo inet loopback

auto enp0s3

iface enp0s3 inet manual

auto enp0s9

iface enp0s9 inet manual

auto enp0s8

iface enp0s8 inet manual

auto bond0

iface bond0 inet manual

bond-slaves enp0s3 enp0s8

bond-miimon 100

bond-mode 802.3ad

bond-xmit-hash-policy layer2+3

auto vmbr0

iface vmbr0 inet static

address 192.168.0.90/24

gateway 192.168.0.1

bridge-ports bond0

bridge-stp off

bridge-fd 0

dns-nameservers 8.8.8.8

/etc/network/interfaces:

auto lo

iface lo inet loopback

auto enp0s3

iface enp0s3 inet manual

auto enp0s9

iface enp0s9 inet manual

auto enp0s8

iface enp0s8 inet manual

auto bond0

iface bond0 inet manual

ovs_bonds enp0s3 enp0s8

ovs_type OVSBond

ovs_bridge vmbr0

ovs_options bond_mode=balance-slb

auto vmbr0

iface vmbr0 inet static

address 192.168.0.90/24

gateway 192.168.0.1

ovs_type OVSBridge

ovs_ports bond0

# ovs-vsctl show

20dc0ada-cbb5-4518-a437-0bd6909d088a

Bridge vmbr0

Port vmbr0

Interface vmbr0

type: internal

Port bond0

Interface enp0s3

Interface enp0s8

ovs_version: "3.3.2"

Примечание

Trunk выставляется на это новом интерфейсе.

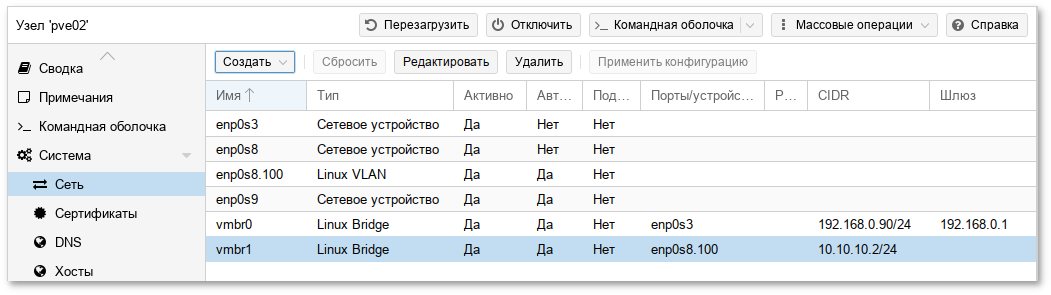

/etc/network/interfaces:

auto lo

iface lo inet loopback

iface enp0s3 inet manual

auto enp0s9

iface enp0s9 inet manual

iface enp0s8 inet manual

auto enp0s8.100

iface enp0s8.100 inet manual

auto vmbr0

iface vmbr0 inet static

address 192.168.0.90/24

gateway 192.168.0.1

bridge-ports enp0s3

bridge-stp off

bridge-fd 0

dns-nameservers 8.8.8.8

auto vmbr1

iface vmbr1 inet static

address 10.10.10.2/24

bridge-ports enp0s8.100

bridge-stp off

bridge-fd 0

Примечание

# pveam update

# pveam update

update successful

# pveam available

mail proxmox-mail-gateway-8.2-standard_8.2-1_amd64.tar.zst

mail proxmox-mailgateway-7.3-standard_7.3-1_amd64.tar.zst

system almalinux-9-default_20240911_amd64.tar.xz

system alpine-3.19-default_20240207_amd64.tar.xz

system alpine-3.20-default_20240908_amd64.tar.x

…

Примечание

pveam available, указав нужный раздел, например, базовые образы системы:

# pveam available --section system

system almalinux-9-default_20240911_amd64.tar.xz

system alpine-3.19-default_20240207_amd64.tar.xz

system alpine-3.20-default_20240908_amd64.tar.xz

system alpine-3.21-default_20241217_amd64.tar.xz

system archlinux-base_20240911-1_amd64.tar.zst

…

# pveam download local almalinux-9-default_20240911_amd64.tar.xz

# pveam list local

NAME SIZE

local:vztmpl/almalinux-9-default_20240911_amd64.tar.xz 99.60MB

Таблица 29.1. Каталоги локального хранилища

|

Каталог

|

Тип шаблона

|

|---|---|

/var/lib/vz/template/iso/

|

ISO-образы

|

/var/lib/vz/template/cache/

|

Шаблоны контейнеров LXC

|

Таблица 29.2. Каталоги общих хранилищ

|

Каталог

|

Тип шаблона

|

|---|---|

/mnt/pve/<storage_name>/template/iso/

|

ISO-образы

|

/mnt/pve/<storage_name>/template/cache/

|

Шаблоны контейнеров LXC

|

qm

Примечание

Примечание

Примечание

# qm set <vmid> -onboot 1

Примечание

Порядок запуска и отключения всегда будут запускаться после тех, для которых этот параметр установлен . Кроме того, этот параметр может применяться только для ВМ, работающих на одном хосте, а не в масштабе кластера.

qmqm — это инструмент для управления ВМ Qemu/KVM в PVE. Утилиту qm можно использовать для создания/удаления ВМ, для управления работой ВМ (запуск/остановка/приостановка/возобновление), для установки параметров в соответствующем конфигурационном файле, а также для создания виртуальных дисков.

qm <КОМАНДА> [АРГУМЕНТЫ] [ОПЦИИ]Чтобы просмотреть доступные для управления ВМ команды можно выполнить следующую команду:

# qm help

qm.

Таблица 30.1. Команды qm

|

Команда

|

Описание

|

|---|---|

qm agent

|

Псевдоним для

qm guest cmd

|

qm block <vmid>

|

Заблокировать ВМ.

|

qm cleanup <vmid> <clean-shutdown> <guest-requested>

|

Очищает ресурсы, такие как сенсорные устройства, vgpu и т.д. Вызывается после выключения, сбоя ВМ и т. д.

|

qm clone <vmid> <newid> [ОПЦИИ]

|

Создать копию ВМ/шаблона.

|

qm cloudinit dump <vmid> <type>

|

Получить автоматически сгенерированную конфигурацию cloud-init.

|

qm cloudinit pending <vmid>

|

Получить конфигурацию cloud-init с текущими и ожидающими значениями.

|

qm cloudinit update <vmid>

|

Восстановить и изменить диск конфигурации cloud-init.

|

qm config <vmid> <ОПЦИИ>

|

Вывести конфигурацию ВМ с применёнными ожидающими изменениями конфигурации. Для вывода текущей конфигурации следует указать параметр

current.

|

qm create <vmid> <ОПЦИИ>

|

Создать или восстановить ВМ.

Некоторые опции:

|

qm delsnapshot <vmid> <snapname> <ОПЦИИ>

|

Удалить снимок ВМ.

|

qm destroy <vmid> [ОПЦИИ]

|

Уничтожить ВМ и все её тома (будут удалены все разрешения, специфичные для ВМ).

|

qm disk import <vmid> <source> <storage> [ОПЦИИ]

|

Импортировать образ внешнего диска в неиспользуемый диск ВМ. Формат образа должен поддерживаться qemu-img.

|

qm disk move <vmid> <disk> <storage> [ОПЦИИ]

|

Переместить том в другое хранилище или в другую ВМ.

|

qm disk rescan [ОПЦИИ]

|

Пересканировать все хранилища и обновить размеры дисков и неиспользуемые образы дисков.

|

qm disk resize <vmid> <disk> <size> [ОПЦИИ]

|

Увеличить размер диска.

|

qm disk unlink <vmid> --idlist <строка> [ОПЦИИ]

|

Отсоединить/удалить образы дисков.

|

qm guest cmd <vmid> <команда>

|

Выполнить команды гостевого агента QEMU.

|

qm guest exec <vmid> [<extra-args>] [ОПЦИИ]

|

Выполнить данную команду через гостевой агент.

|

qm guest exec-status <vmid> <pid>

|

Получить статус данного pid, запущенного гостевым агентом.

|

qm guest passwd <vmid> <username> [ОПЦИИ]

|

Установить пароль для данного пользователя.

|

qm help [extra-args] [ОПЦИИ]

|

Показать справку по указанной команде.

|

qm importdisk

|

Псевдоним для

qm disk import.

|

qm importovf <vmid> <manifest> <storage> [ОПЦИИ]

|

Создать новую ВМ, используя параметры, считанные из манифеста OVF.

|

qm list [ОПЦИИ]

|

Вывести список ВМ узла.

|

qm listsnapshot <vmid>

|

Вывести список снимков ВМ.

|

qm migrate <vmid> <target> [ОПЦИИ]

|

Перенос ВМ. Создаёт новую задачу миграции.

|

qm monitor <vmid>

|

Войти в интерфейс монитора QEMU.

|

qm move-disk

|

Псевдоним для

qm disk move.

|

qm move_disk

|

Псевдоним для

qm disk move.

|

qm nbdstop <vmid>

|

Остановить встроенный сервер NBD.

|

qm pending <vmid>

|

Получить конфигурацию ВМ с текущими и ожидающими значениями.

|

qm reboot <vmid> [ОПЦИИ]

|

Перезагрузить ВМ. Применяет ожидающие изменения.

|

qm remote-migrate <vmid> [<target-vmid>] <target-endpoint> --target-bridge <строка> --target-storage <строка> [ОПЦИИ]

|

Перенос ВМ в удалённый кластер. Создаёт новую задачу миграции. ЭКСПЕРИМЕНТАЛЬНАЯ функция!

|

qm rescan

|

Псевдоним для

qm disk rescan.

|

qm reset <vmid> [ОПЦИИ]

|

Сбросить ВМ.

|

qm resize

|

Псевдоним для

qm disk resize.

|

qm resume <vmid> [ОПЦИИ]

|

Возобновить работу ВМ.

|

qm rollback <vmid> <snapname> [ОПЦИИ]

|

Откат состояния ВМ до указанного снимка.

|

qm sendkey <vmid> <ключ> [ОПЦИИ]

|

Послать нажатия клавиш на ВМ.

|

qm set <vmid> [ОПЦИИ]

|

Установить параметры ВМ.

Некоторые опции:

|

qm showcmd <vmid> [ОПЦИИ]

|

Показать командную строку, которая используется для запуска ВМ (информация для отладки).

|

qm shutdown <vmid> [ОПЦИИ]

|

Выключение ВМ (эмуляция нажатия кнопки питания). Гостевой ОС будет отправлено событие ACPI.

|

qm snapshot <vmid> <snapname> [ОПЦИИ]

|

Сделать снимок ВМ.

|

qm start <vmid> [ОПЦИИ]

|

Запустить ВМ.

|

qm status <vmid> [ОПЦИИ]

|

Показать статус ВМ.

|

qm stop <vmid> [ОПЦИИ]

|

Остановка ВМ (аналогично отключению питания работающего компьютера). Процесс qemu немедленно завершается.

|

qm suspend <vmid> [ОПЦИИ]

|

Приостановить ВМ.

|

qm template <vmid> [ОПЦИИ]

|

Создать шаблон.

|

qm terminal <vmid> [ОПЦИИ]

|

Открыть терминал с помощью последовательного устройства (на ВМ должно быть настроено последовательное устройство, например, Serial0: Socket).

|

qm unlink

|

Псевдоним для

qm disk unlink.

|

qm unlock <vmid>

|

Разблокировать ВМ.

|

qm vncproxy <vmid>

|

Проксировать VNC-трафик ВМ на стандартный ввод/вывод.

|

qm wait <vmid> [ОПЦИИ]

|

Подождать, пока ВМ не будет остановлена.

|

qm:

# qm create 109 -ide0 local-lvm:21 -net0 e1000 -cdrom nfs-storage:iso/alt-server-11.0-x86_64.iso

# qm start 109

# qm shutdown 109 && qm wait 109

# qm sendkey 109 ctrl-shift

#qm monitor 109qm>help

Примечание

quit или последовательно нажать CTRL+O и CTRL+C.

/var/lib/vz/snippets) и добавить его к ВМ или контейнеру.

Примечание

hookscript:

#где <script_file> — исполняемый файл скрипта.qm set <vmid> --hookscript <storage>:snippets/<script_file>#pct set <vmid> --hookscript <storage>:snippets/<script_file>

# qm set 103 --hookscript snippet:snippets/guest-hookscript.pl

update VM 103: -hookscript snippet:snippets/guest-hookscript.pl

Примечание

guest-hookscript.pl):

#!/usr/bin/perl

# Example hookscript for PVE guests

use strict;

use warnings;

print "GUEST HOOK: " . join(' ', @ARGV). "\n";

# First argument is the vmid

my $vmid = shift;

# Second argument is the phase

my $phase = shift;

if ($phase eq 'pre-start') {

# Первый этап 'pre-start' будет выполнен до запуска ВМ

# Выход с code != 0 отменит старт ВМ

print "$vmid is starting, doing preparations.\n";

# print "preparations failed, aborting."

# exit(1);

} elsif ($phase eq 'post-start') {

# Второй этап 'post-start' будет выполнен после успешного

# запуска ВМ

system("/root/date.sh $vmid");

print "$vmid started successfully.\n";

} elsif ($phase eq 'pre-stop') {

# Третий этап 'pre-stop' будет выполнен до остановки ВМ через API

# Этап не будет выполнен, если ВМ остановлена изнутри,

# например, с помощью 'poweroff'

print "$vmid will be stopped.\n";

} elsif ($phase eq 'post-stop') {

# Последний этап 'post-stop' будет выполнен после остановки ВМ

# Этап должен быть выполнен даже в случае сбоя или неожиданной остановки ВМ

print "$vmid stopped. Doing cleanup.\n";

} else {

die "got unknown phase '$phase'\n";

}

exit(0);

#!/bin/bash if [ $2 == "pre-start" ] then echo "Запуск ВМ $1" >> /root/test.txt date >> /root/test.txt fi

args: -vnc 0.0.0.0:55Или, чтобы включить защиту паролем:

args: -vnc 0.0.0.0:55,password=on

set_password vnc newvnc -d vnc2

В данном примере, при подключении будет запрашиваться пароль: newvnc. Максимальная длина пароля VNC: 8 символов. После перезапуска ВМ указанную выше команду необходимо повторить, чтобы снова установить пароль.

Примечание

Примечание

qemu-img — утилита для манипулирования образами дисков машин QEMU. qemu-img позволяет выполнять операции по созданию образов различных форматов, конвертировать файлы-образы между этими форматами, получать информацию об образах и объединять снимки ВМ для тех форматов, которые это поддерживают.

qemu-img:

# qemu-img convert -f vmdk test.vmdk -O qcow2 test.qcow2

# qemu-img create -f raw test.raw 40G

# qemu-img resize -f raw test.raw 80G

# qemu-img info test.raw

# qm resize <vm_id> <virtual_disk> [+]<size>

Примечание

# qm resize 100 scsi1 80G

# qm move-disk <vm_id> <virtual_disk> <storage>

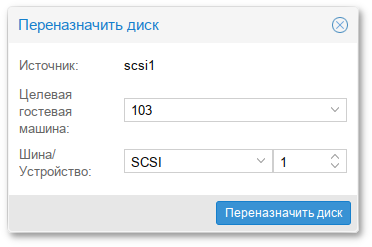

# qm move-disk <vm_id> <virtual_disk> --target-vmid <vm_id> --target-disk <virtual_disk>

# qm move-disk 107 scsi0 --target-vmid 10007 --target-disk scsi1

Примечание

Примечание

remote-viewer из пакета virt-viewer).

# qm set VMID -spice_enhancements foldersharing=1,videostreaming=all

Примечание

http://localhost:9843.

Примечание

Примечание

dav://localhost:9843/).

lsusb).

lsusb -t).

# qm set 100 --usb3 spice

update VM 100: -usb3 spice

# qm set 100 --usb4 host=346d:5678

update VM 100: -usb4 host=346d:5678

Примечание

Примечание

info usb и info usbhost:

Предупреждение

# qm set <vm_id> -efidisk0 <storage>:1,format=<format>,efitype=4m,pre-enrolled-keys=1

где:

efitype — указывает, какую версию микропрограммы OVMF следует использовать. Для новых ВМ необходимо указывать 4m (это значение по умолчанию в графическом интерфейсе);

pre-enroll-keys — указывает, должен ли efidisk поставляться с предварительно загруженными ключами безопасной загрузки для конкретного дистрибутива и Microsoft Standard Secure Boot. Включает безопасную загрузку по умолчанию.

# qm set <vm_id> -tpmstate0 <storage>:1,version=<version>

где:

Примечание

intel_iommu=on (для процессоров AMD он должен быть включен автоматически).

/etc/modules):

vfio vfio_iommu_type1 vfio_pci vfio_virqfd

# dmesg | grep -e DMAR -e IOMMU -e AMD-Vi

/etc/modprobe.d/vfio.conf строку:

options vfio-pci ids=1234:5678,4321:8765где 1234:5678 и 4321:8765 — идентификаторы поставщика и устройства.

# lspci -nn

/etc/modprobe.d/blacklist.conf:

blacklist DRIVERNAME

# qm set VMID -hostpci0 00:02.0

# qm set VMID -hostpci0 02:00,device-id=0x10f6,sub-vendor-id=0x0000

, расположенную в строке с созданным сопоставлением, и в открывшемся окне добавить сопоставление устройству на другом узле:

, расположенную в строке с созданным сопоставлением, и в открывшемся окне добавить сопоставление устройству на другом узле:

# pvesh create /cluster/mapping/<тип> <опции>

где <тип> — это тип оборудования (pci или usb), а <опции> — сопоставления устройств и другие параметры конфигурации.

# pvesh create /cluster/mapping/pci --id device \

--map node=pve01,path=0000:01:00.0,id=0002:0001 \

--map node=pve02,path=0000:02:00.0,id=0002:0001

Параметр map должен быть указан для каждого узла, для которого это устройство должно быть сопоставлено.

Примечание