Редакция март, 2023

Аннотация

apt-get и её графическая оболочка synaptic позволяют пользователям легко обновлять свои системы и быть в курсе актуальных новостей мира свободных программ.

Содержание

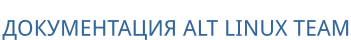

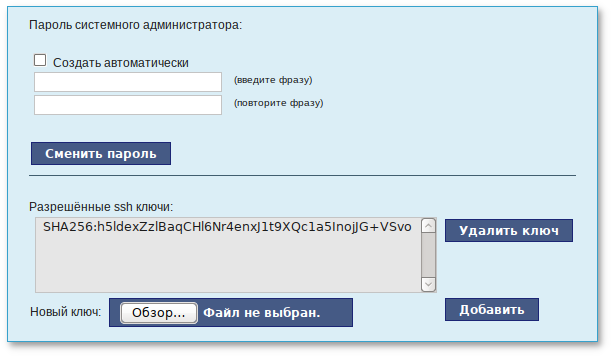

ssh-keygen. По умолчанию будет создан ключ RSA.

ssh-keygen с дополнительными параметрами:

-t — указывает тип ключа;

-b — указывает размер ключа.

$ ssh-keygen -t ed25519

$ ssh-keygen -t rsa -b 4096

Generating public/private <тип_ключа> key pair. Enter file in which to save the key (/home/<пользователь>/.ssh/id_<тип_ключа>):По умолчанию ключ будет сохранён в файл

~/.ssh/id_<тип_ключа>. Можно нажать ENTER, чтобы согласиться с этим или указать другой файл.

Enter passphrase (empty for no passphrase): Enter same passphrase again:Парольная фраза еще больше повышает безопасность. Если установить парольную фразу, она будет запрашиваться каждый раз, когда используется ключ. Если нажать ENTER без ввода парольной фразы, SSH-ключ будет сгенерирован без пароля.

ssh-keygen будут созданы два ключа:

author_keys).

cat:

$ cat ~/.ssh/id_ed25519.pub

ssh-ed25519 AAAAC3NzaC1lZDI1NTE5AAAAIMnCtC+IJ0Bbw480ql79hijTPNFN9QFM+sLM19n+BBMu user@host-15

Выделите текст и скопируйте его в буфер обмена. Этот ключ необходимо указать при создании ВМ в поле SSH-ключ.

Примечание

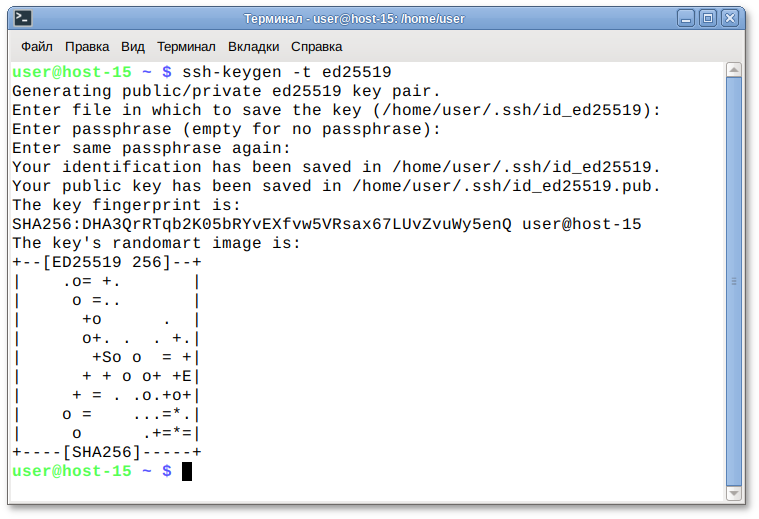

$ ssh-keygen -p

Обратите внимание, что вы должны знать свою текущую парольную фразу. Если вы забыли парольную фразу, то больше не сможете использовать свой SSH-ключ.

Примечание

$ ssh <логин>@<IP-адрес>

Например:

$ ssh user@158.160.0.157

The authenticity of host '158.160.0.157 (158.160.0.157)' can't be established.

ED25519 key fingerprint is SHA256:4+OX7yelFgZ0NfcLCXAv0hUVTs8GBIqfjmNHP5L65tyr.

This key is not known by any other names

Are you sure you want to continue connecting (yes/no/[fingerprint])? yes

Warning: Permanently added '158.160.0.157' (ED25519) to the list of known hosts.

Примечание

~/.ssh/known_hosts и автоматически распознан при следующих подключениях.

Enter passphrase for key '/home/user/.ssh/id_ed25519':Обратите внимание, что вводимый пароль не отображается в интерфейсе командной строки.

Примечание

$ ssh -i <файл_ключа> <логин>@<IP-адрес>

Например:

$ ssh -i .ssh/id_ed25519 user@158.160.0.157

$ ssh <уникальное-имя>

вместо:

$ ssh -i <ключ> <логин>@<IP-адрес>

~/.ssh/config) новые записи добавляются в следующем формате:

Host <уникальное-имя>

HostName <IP-адрес>

User <логин>

IdentityFile <ключ>

Например:

Host altserver;

HostName 158.160.0.157

User user

IdentityFile ~/.ssh/id_ed25519

$ ssh altserver

sudo. За подробностями следует обратиться к документации облачной платформы.

sudo.

$ sudo su -

$ sudo reboot

Содержание

apt-get. Она автоматически определяет зависимости между пакетами и строго следит за её соблюдением при выполнении любой из следующих операций: установка, удаление или обновление пакетов.

Важно

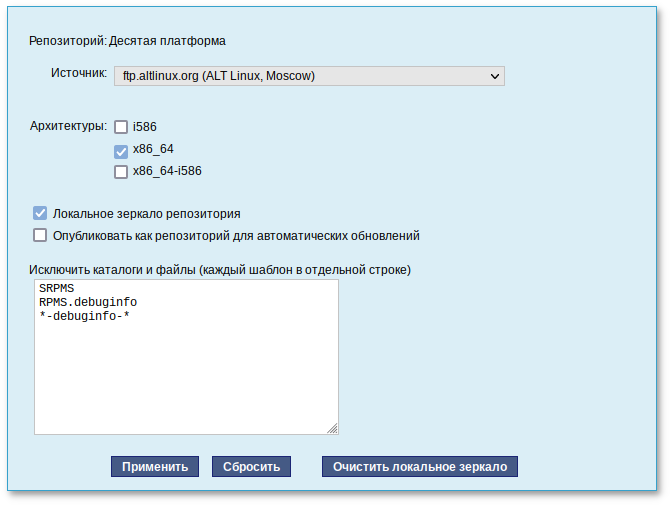

/etc/apt/sources.list, либо в любой файл .list (например, mysources.list) в каталоге /etc/apt/sources.list.d/. Описания репозиториев заносятся в эти файлы в следующем виде:

rpm [подпись] метод:путь база название rpm-src [подпись] метод:путь база названиеЗдесь:

/etc/apt/vendor.list;

/etc/apt/sources.list.d/*.list обычно указывается интернет-репозиторий, совместимый с установленным дистрибутивом.

sources.list, необходимо обновить локальную базу данных APT о доступных пакетах. Это делается командой apt-get update.

sources.list присутствует репозиторий, содержимое которого может изменяться (например, постоянно разрабатываемый репозиторий или репозиторий обновлений по безопасности), то прежде чем работать с APT, необходимо синхронизировать локальную базу данных с удалённым сервером командой apt-get update. Локальная база данных создаётся заново при каждом изменении в репозитории: добавлении, удалении или переименовании пакета.

/etc/apt/sources.list, относящиеся к ресурсам в сети Интернет.

apt-repo:

apt-repo

apt-repo add репозиторий

apt-repo rm репозиторий

apt-repo update

apt-repo:

man apt-repo

или

apt-repo --help

Примечание

#Или то же самое одной командой:apt-repo#rm allapt-repoadd p10

# apt-repo set p10

/etc/apt/sources.list.d/.

Примечание

alt.list может содержаться такая информация:

# ftp.altlinux.org (ALT Linux, Moscow) # ALT Linux Platform 10 #rpm [p10] ftp://ftp.altlinux.org/pub/distributions/ALTLinux/p10/branch x86_64 classic #rpm [p10] ftp://ftp.altlinux.org/pub/distributions/ALTLinux/p10/branch x86_64-i586 classic #rpm [p10] ftp://ftp.altlinux.org/pub/distributions/ALTLinux/p10/branch noarch classic rpm [p10] http://ftp.altlinux.org/pub/distributions/ALTLinux/p10/branch x86_64 classic rpm [p10] http://ftp.altlinux.org/pub/distributions/ALTLinux/p10/branch x86_64-i586 classic rpm [p10] http://ftp.altlinux.org/pub/distributions/ALTLinux/p10/branch noarch classic

apt-get update или apt-repo update).

apt-cache. Данная утилита позволяет искать пакет не только по имени, но и по его описанию.

apt-cache search подстрока позволяет найти все пакеты, в именах или описании которых присутствует указанная подстрока. Например:

$ apt-cache search dictionary

stardict-wn - GCIDE - The Collaborative International Dictionary of English

firefox-ru - Russian (RU) Language Pack for Firefox

gnome-dictionary-applet - GNOME panel applet for gnome-dictionary

gnome-utils - Utilities for the GNOME 2.0 desktop

libgdict - GNOME Dictionary Library.

stardict-mueller7 - V.K. Mueller English-Russian Dictionary, 7 Edition: stardict format

stardict-slovnyk_be-en - Dictionary: Slovnyk Belarusian-English

stardict-slovnyk_be-ru - Dictionary: Slovnyk Belarusian-Russian

stardict-slovnyk_be-uk - Dictionary: Slovnyk Belarusian-Ukrainian

stardict-slovnyk_cs-ru - Dictionary: Slovnyk Czech-Russian

stardict-slovnyk_en-be - Dictionary: Slovnyk English-Belarusian

stardict-slovnyk_en-ru - Dictionary: Slovnyk English-Russian

stardict-slovnyk_en-uk - Dictionary: Slovnyk English-Ukrainian

stardict-slovnyk_es-ru - Dictionary: Slovnyk Spanish-Russian

stardict-slovnyk_ru-be - Dictionary: Slovnyk Russian-Belarusian

stardict-slovnyk_ru-cs - Dictionary: Slovnyk Russian-Czech

stardict-slovnyk_ru-en - Dictionary: Slovnyk Russian-English

stardict-slovnyk_ru-es - Dictionary: Slovnyk Russian-Spanish

stardict-slovnyk_ru-uk - Dictionary: Slovnyk Russian-Ukrainian

stardict-slovnyk_uk-be - Dictionary: Slovnyk Ukrainian-Belarusian

stardict-slovnyk_uk-en - Dictionary: Slovnyk Ukrainian-English

stardict-slovnyk_uk-ru - Dictionary: Slovnyk Ukrainian-Russian

words - A dictionary of English words for the /usr/share/dict directory

apt-cache show:

$ apt-cache show stardict-mueller7

Package: stardict-mueller7

Section: Text tools

Installed Size: 3094848

Maintainer: Anton V. Boyarshinov <boyarsh@altlinux.ru>

Version: 1.0-alt8@1338342590

Pre-Depends: rpmlib(PayloadIsLzma)

Depends: stardict (>= 2.4.2)

Provides: stardict-mueller7 (= 1.0-alt8)

Architecture: noarch

Size: 3134862

MD5Sum: 54f9e085c1fc67084253b3ba72a0c482

Filename: stardict-mueller7-1.0-alt8.noarch.rpm

Description: V.K. Mueller English-Russian Dictionary, 7th Edition, for stardict

Electronic version of V.K. Mueller English-Russian Dictionary,

7th Edition, in stardict format, for use with a stardict client.

apt-cache можно использовать русскую подстроку. В этом случае будут найдены пакеты, имеющие описание на русском языке. К сожалению, описание на русском языке в настоящее время есть не у всех пакетов, но наиболее актуальные описания переведены.

Важно

apt-get install имя_пакета.

Важно

# apt-get update

apt-get позволяет устанавливать в систему пакеты, требующие для работы наличие других, пока ещё не установленных пакетов. В этом случае он определяет, какие пакеты необходимо установить. apt-get устанавливает их, пользуясь всеми доступными репозиториями.

apt-get install stardict-mueller7 приведёт к следующему диалогу с APT (если пакет еще не установлен):

# apt-get install stardict-mueller7

Чтение списков пакетов... Завершено

Построение дерева зависимостей... Завершено

Следующие дополнительные пакеты будут установлены:

icon-theme-hicolor libgtk+2 libgtk+2-locales libsigc++2 stardict

Следующие НОВЫЕ пакеты будут установлены:

icon-theme-hicolor libgtk+2 libgtk+2-locales libsigc++2 stardict stardict-mueller7

0 будет обновлено, 6 новых установлено, 0 пакетов будет удалено и 24 не будет обновлено.

Необходимо получить 9629kB архивов.

После распаковки потребуется дополнительно 36,2MB дискового пространства.

Продолжить? [Y/n] y

Совершаем изменения...

Подготовка... ####################### [100%]

Обновление / установка...

1: libsigc++2-2.10.7-alt1 ####################### [ 17%]

2: libgtk+2-locales-2.24.33-alt1 ####################### [ 33%]

3: icon-theme-hicolor-0.17-alt2 ####################### [ 50%]

4: libgtk+2-2.24.33-alt1 ####################### [ 67%]

5: stardict-3.0.6-alt1 ####################### [ 83%]

6: stardict-mueller7-1.0-alt8 ####################### [100%]

Завершено.

apt-get install имя_пакета apt-get дополнительно проверяет, есть ли обновлённая, в сравнении с установленной в системе, версия пакета в репозитории.

apt-get install stardict-mueller7 будет таким:

# apt-get install stardict-mueller7

Чтение списков пакетов... Завершено

Построение дерева зависимостей... Завершено

Последняя версия stardict-mueller7 уже установлена.

0 будет обновлено, 0 новых установлено, 0 пакетов будет удалено и 1 не будет обновлено.

# apt-get install /путь/к/файлу.rpm

При этом APT проведёт стандартную процедуру проверки зависимостей и конфликтов с уже установленными пакетами.

apt-get отказывается выполнять операции установки, удаления или обновления. В этом случае необходимо повторить операцию, задав опцию -f, заставляющую apt-get исправить нарушенные зависимости, удалить или заменить конфликтующие пакеты. В этом случае необходимо внимательно следить за сообщениями, выводимыми apt-get. Любые действия в этом режиме обязательно требуют подтверждения со стороны пользователя.

apt-get remove имя_пакета. Для того чтобы не нарушать целостность системы, будут удалены и все пакеты, зависящие от удаляемого. В случае удаления пакета, который относится к базовым компонентам системы, apt-get потребует дополнительное подтверждение с целью предотвращения возможной случайной ошибки.

Важно

apt-get удалить базовый компонент системы, вы увидите следующий запрос на подтверждение операции:

# apt-get remove filesystem

Чтение списков пакетов... Завершено

Построение дерева зависимостей... Завершено

Следующие пакеты будут УДАЛЕНЫ:

...

ВНИМАНИЕ: Будут удалены важные для работы системы пакеты

Обычно этого делать не следует. Вы должны точно понимать возможные последствия!

...

0 будет обновлено, 0 новых установлено, 2648 пакетов будет удалено и 0 не будет обновлено.

Необходимо получить 0B архивов.

После распаковки будет освобождено 8994MB дискового пространства.

Вы делаете нечто потенциально опасное!

Введите фразу 'Yes, do as I say!' чтобы продолжить.

Предупреждение

#apt-get#updateapt-getdist-upgrade

apt-get update) обновит индексы пакетов. Вторая команда (apt-get dist-upgrade) позволяет обновить только те установленные пакеты, для которых в репозиториях, перечисленных в /etc/apt/sources.list, имеются новые версии.

Примечание

apt-get upgrade существует, использовать её следует осторожно, либо не использовать вовсе.

/etc/apt/sources.list, имеются новые версии.

apt-get upgrade, в результате чего происходит нарушение целостности системы: появляются неудовлетворённые зависимости. Для разрешения этой проблемы существует режим обновления в масштабе дистрибутива — apt-get dist-upgrade.

apt-get, которым APT предварит само обновление.

Примечание

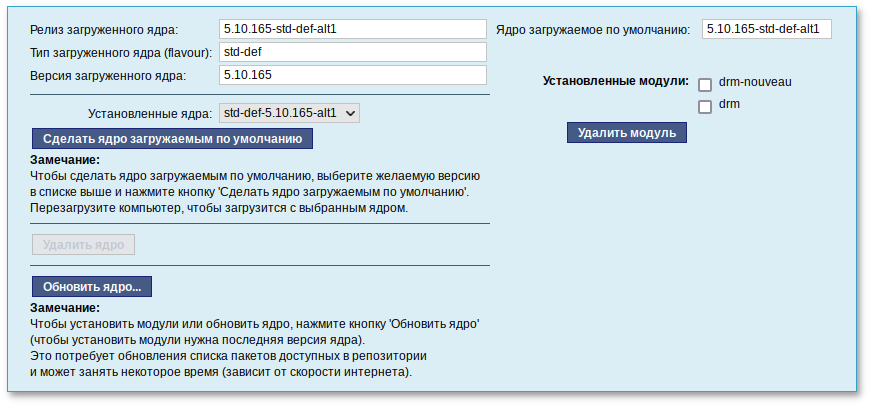

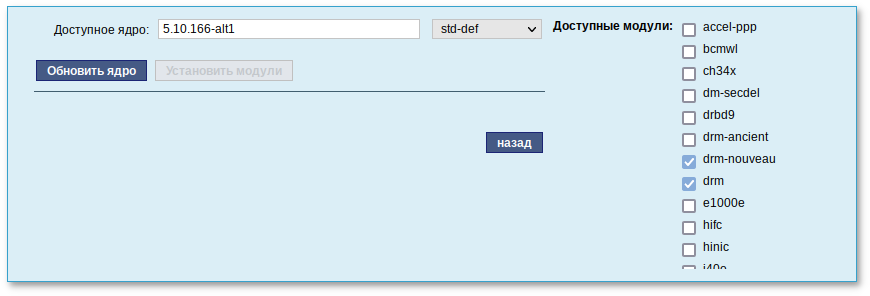

apt-get dist-upgrade обновит систему, но ядро ОС не будет обновлено.

# update-kernel

Примечание

update-kernel необходимо выполнить команду apt-get update.

# update-kernel -t <новый тип ядра>

где <новый тип ядра> — std-def, un-def и т.п.

Примечание

-t и тип ядра (std-def, un-def и т.п.) следует указывать только если необходимо обновить ядро другого типа, так как по умолчанию обновляется текущий тип ядра. Узнать версию загруженного ядра можно, выполнив команду:

$ uname –r

update-kernel обновляет и модули ядра, если в репозитории обновилось что-то из модулей без обновления ядра.

# apt-get install kernel-modules-<модуль>-<тип ядра>

# remove-old-kernels

epm упрощает процедуру управления пакетами, может использоваться в скриптах и установщиках, сервисных программах, в повседневном администрировании различных систем. В epm добавлены типовые операции, которые в случае использования apt, потребовали бы ввода более одной команды.

Примечание

epm, если она еще не установлена, выполняется командой:

# apt-get install eepm

epm и её опциях можно получить, выполнив команду:

$ epm --help

Ниже описаны лишь некоторые возможности утилиты epm.

# epm install <имя_пакета>

Важно

epm install не будут выполнены установочные скрипты из пакета. Это предохраняет систему от повреждения, но может привести к тому, что пакет не заработает. Вернуть стандартное поведение можно добавлением --scripts:

# epm install --scripts <имя_пакета>

# epm play <имя_программы>

Список программ, которые можно установить данной командой, можно просмотреть, выполнив команду:

$ epm play

Run with a name of a play script to run:

anydesk - Install AnyDesk from the official site

assistant - Install Assistant (Ассистент) from the official site

…

yandex-browser - Install Yandex browser from the official site

yandex-disk - Install Yandex Disk from the official site

zoom - Install Zoom client from the official site

Команда epm play требует наличия доступа в сеть Интернет.

Примечание

# epm install --repack <имя_пакета>

Для deb-пакетов ключ --repack применяется автоматически.

# epm remove <имя_пакета>

# epm search <текст>

$ epm list

# epm autoremove

# epm full-upgrade

Примечание

yum (должен быть установлен пакет eepm-yum), позволяет имитировать работу менеджера пакетов yum, например:

# yum search docs-alt-kworkstation

# apt-cache search -- docs-alt-kworkstation | grep -E -i --color -- "(docs-alt-kworkstation)"

docs-alt-kworkstation - ALT KWorkstation documentation

Содержание

Предупреждение

Предупреждение

# apt-get install task-samba-dc

# for service in smb nmb krb5kdc slapd bind; do systemctl disable $service; systemctl stop $service; done

#rm -f /etc/samba/smb.conf#rm -rf /var/lib/samba#rm -rf /var/cache/samba#mkdir -p /var/lib/samba/sysvol

Предупреждение

/etc/samba/smb.conf перед созданием домена: rm -f /etc/samba/smb.conf

/etc/sysconfig/network

# hostnamectl set-hostname dc.test.alt

# domainname test.alt

Примечание

Предупреждение

# samba-tool domain provision --realm=test.alt --domain=test --adminpass='Pa$$word' --dns-backend=SAMBA_INTERNAL --option="dns forwarder=8.8.8.8" --server-role=dc

где

Примечание

--use-rfc2307 позволяет поддерживать расширенные атрибуты типа UID и GID в схеме LDAP и ACL на файловой системе Linux.

Примечание

# samba-tool domain provision

Realm [TEST.ALT]:

Domain [TEST]:

Server Role (dc, member, standalone) [dc]:

DNS backend (SAMBA_INTERNAL, BIND9_FLATFILE, BIND9_DLZ, NONE) [SAMBA_INTERNAL]:

DNS forwarder IP address (write 'none' to disable forwarding) [127.0.0.1]: 8.8.8.8

Administrator password:

Retype password:

Looking up IPv4 addresses

More than one IPv4 address found. Using 192.168.0.122

Looking up IPv6 addresses

No IPv6 address will be assigned

Setting up share.ldb

Setting up secrets.ldb

Setting up the registry

Setting up the privileges database

Setting up idmap db

Setting up SAM db

Setting up sam.ldb partitions and settings

Setting up sam.ldb rootDSE

Pre-loading the Samba 4 and AD schema

Adding DomainDN: DC=test,DC=alt

Adding configuration container

Setting up sam.ldb schema

Setting up sam.ldb configuration data

Setting up display specifiers

Modifying display specifiers

Adding users container

Modifying users container

Adding computers container

Modifying computers container

Setting up sam.ldb data

Setting up well known security principals

Setting up sam.ldb users and groups

Setting up self join

Adding DNS accounts

Creating CN=MicrosoftDNS,CN=System,DC=test,DC=alt

Creating DomainDnsZones and ForestDnsZones partitions

Populating DomainDnsZones and ForestDnsZones partitions

Setting up sam.ldb rootDSE marking as synchronized

Fixing provision GUIDs

A Kerberos configuration suitable for Samba 4 has been generated at /var/lib/samba/private/krb5.conf

Once the above files are installed, your Samba4 server will be ready to use

Server Role: active directory domain controller

Hostname: dc

NetBIOS Domain: TEST

DNS Domain: test.alt

DOMAIN SID: S-1-5-21-80639820-2350372464-3293631772

Примечание

/etc/resolvconf.conf добавить строку:

name_servers=127.0.0.1Обновить DNS адреса:

# resolvconf -u

# systemctl enable --now samba

/etc/krb5.conf. Следует раскомментировать строку default_realm и содержимое разделов realms и domain_realm и указать название домена (обратите внимание на регистр символов), в строке dns_lookup_realm должно быть установлено значение false:

includedir /etc/krb5.conf.d/

[logging]

# default = FILE:/var/log/krb5libs.log

# kdc = FILE:/var/log/krb5kdc.log

# admin_server = FILE:/var/log/kadmind.log

[libdefaults]

dns_lookup_kdc = true

dns_lookup_realm = false

ticket_lifetime = 24h

renew_lifetime = 7d

forwardable = true

rdns = false

default_realm = TEST.ALT

# default_ccache_name = KEYRING:persistent:%{uid}

[realms]

TEST.ALT = {

default_domain = test.alt

}

[domain_realm]

dc = TEST.ALT

Примечание

krb5.conf для домена в каталоге /var/lib/samba/private/. Можно просто заменить этим файлом файл, находящийся в каталоге /etc/:

# cp /var/lib/samba/private/krb5.conf /etc/krb5.conf

# samba-tool domain info 127.0.0.1

Forest : test.alt

Domain : test.alt

Netbios domain : TEST

DC name : dc.test.alt

DC netbios name : DC

Server site : Default-First-Site-Name

Client site : Default-First-Site-Name

# smbclient -L localhost -Uadministrator

Password for [TEST\administrator]:

Sharename Type Comment

--------- ---- -------

sysvol Disk

netlogon Disk

IPC$ IPC IPC Service (Samba 4.15.9)

SMB1 disabled -- no workgroup available

Общие ресурсы netlogon и sysvol создаваемые по умолчанию нужны для функционирования сервера AD и создаются в smb.conf в процессе развертывания/модернизации.

/etc/resolv.conf:

#cat /etc/resolv.conf# Generated by resolvconf # Do not edit manually, use # /etc/net/ifaces/<interface>/resolv.conf instead. search test.alt nameserver 127.0.0.1 #host test.alttest.alt has address 192.168.0.122

#Если имена не находятся, проверьте выключение службы named.host -t SRV _kerberos._udp.test.alt._kerberos._udp.test.alt has SRV record 0 100 88 dc.test.alt. #host -t SRV _ldap._tcp.test.alt._ldap._tcp.test.alt has SRV record 0 100 389 dc.test.alt. #host -t A dc.test.alt.dc.test.alt has address 192.168.0.122

# kinit administrator@TEST.ALT

Password for administrator@TEST.ALT:

Просмотр полученного билета:

# klist

Ticket cache: FILE:/tmp/krb5cc_0

Default principal: administrator@TEST.ALT

Valid starting Expires Service principal

14.09.2022 14:32:35 15.09.2022 00:32:35 krbtgt/TEST.ALT@TEST.ALT

renew until 21.09.2022 14:32:32

samba-tool user create имя пользователяsamba-tool user setexpiry имя пользователя

samba-tool user delete имя пользователяsamba-tool user disable имя пользователяsamba-tool user enable имя пользователяsamba-tool user setpassword имя пользователя# samba-tool user list

#samba-tool user create ivanov --given-name='Иван Иванов' --mail-address='ivanov@test.alt'#samba-tool user setexpiry ivanov --noexpiry

Предупреждение

pdbedit -x -m имя

# apt-get install task-samba-dc

# for service in smb nmb krb5kdc slapd bind; do systemctl disable $service; systemctl stop $service; done

#rm -f /etc/samba/smb.conf#rm -rf /var/lib/samba#rm -rf /var/cache/samba#mkdir -p /var/lib/samba/sysvol

# systemctl status bind

И, если она была включена, выключить службу bind и перезапустить службу samba:

#systemctl stop bind#systemctl restart samba

Предупреждение

# samba-tool dns add 192.168.0.122 test.alt DC2 A 192.168.0.106 -Uadministrator

Password for [TEST\administrator]:

Record added successfully

/etc/krb5.conf):

[libdefaults] default_realm = TEST.ALT dns_lookup_realm = false dns_lookup_kdc = true

Примечание

/etc/resolv.conf обязательно должен быть добавлен PDC как nameserver:

#echo "name_servers=192.168.0.122" >> /etc/resolvconf.conf#echo "search_domains=test.alt" >> /etc/resolvconf.conf#resolvconf -u#cat /etc/resolv.confsearch test.alt nameserver 192.168.0.122 nameserver 8.8.8.8

# kinit administrator@TEST.ALT

Password for administrator@TEST.ALT:

Предупреждение

# klist

Ticket cache: KEYRING:persistent:0:0

Default principal: administrator@TEST.ALT

Valid starting Expires Service principal

14.09.2022 15:50:40 15.09.2022 01:50:40 krbtgt/TEST.ALT@TEST.ALT

renew until 21.09.2022 15:50:34

# samba-tool domain join test.alt DC -Uadministrator --realm=test.alt --option="dns forwarder=8.8.8.8"

Если всё нормально, в конце будет выведена информация о присоединении к домену:

Joined domain TEST (SID S-1-5-21-80639820-2350372464-3293631772) as a DCДля получения дополнительной информации можно воспользоваться командой:

# samba-tool domain join --help

# systemctl enable --now samba

Предупреждение

Предупреждение

# samba-tool drs replicate dc2.test.alt dc.test.alt dc=test,dc=alt -Uadministrator

Сначала указывается приемник, затем источник, после этого реплицируемая ветка в LDAP.

# samba-tool drs replicate dc.test.alt dc2.test.alt dc=test,dc=alt -Uadministrator

Сначала указывается приемник, затем источник, после этого реплицируемая ветка в LDAP.

Примечание

# samba-tool drs showrepl

Примечание

# apt-get install task-auth-ad-sssd

# hostnamectl set-hostname host-15.test.alt

/etc/net/ifaces/enp0s3/resolv.conf со следующим содержимым:

nameserver 192.168.0.122где 192.168.0.122 — IP-адрес DNS-сервера домена.

/etc/resolvconf.conf добавить/отредактировать следующие параметры:

interface_order='lo lo[0-9]* lo.* enp0s3' search_domains=test.altгде enp0s3 — интерфейс на котором доступен контроллер домена, test.alt — домен.

# resolvconf -u

Примечание

/etc/resolv.conf должны появиться строки:

search test.alt nameserver 192.168.0.122

# system-auth write ad test.alt host-15 test 'administrator' 'Pa$$word'

Joined 'HOST-15' to dns domain 'test.alt'

smb.confПримечание

/etc/samba/smb.conf, следует запустить команду testparm для проверки файла на синтаксические ошибки:

# testparm /etc/samba/smb.conf

И, в случае отсутствия ошибок, перезапустить службы smb и nmb, чтобы изменения вступили в силу:

#systemctl restart smb#systemctl restart nmb

Примечание

# smbpasswd -a <имя_пользователя>

Примечание

# smbpasswd -a user

New SMB password:

Retype new SMB password:

Added user user.

Примечание

Примечание

browseable для домашних каталогов будет унаследован от глобального флага browseable, а не флага browseable раздела [homes]. Таким образом, установка browseable = no в разделе [homes] скроет общий ресурс [homes], но сделает видимыми все автоматические домашние каталоги.

browseable — определяет, отображается ли этот общий ресурс в списке доступных общих ресурсов в сетевом окружении и в списке просмотра (по умолчанию: browseable = yes);

path — указывает каталог, к которому должен быть предоставлен доступ;

read only — если для этого параметра задано значение «yes», то пользователи службы не могут создавать или изменять файлы в каталоге (по умолчанию: read only = yes);

writable — инвертированный синоним для read only (по умолчанию: writeable = no);

write list — список пользователей, которым будет предоставлен доступ для чтения и записи. Если пользователь находится в этом списке, ему будет предоставлен доступ для записи, независимо от того, какой параметр установлен для параметра read only. Список может включать имена групп с использованием синтаксиса @group;

read list — список пользователей, которым будет предоставлен доступ только для чтения. Если пользователь находится в этом списке, ему не будет предоставлен доступ для записи, независимо от того, какой параметр установлен для параметра read only. Список может включать имена групп;

guest ok — если этот параметр имеет значение «yes», то для подключения к ресурсу не требуется пароль (по умолчанию: guest ok = no);

guest only — разрешить только гостевые соединения к общему ресурсу (по умолчанию: guest only = no);

printable — если этот параметр имеет значение «yes», то клиенты могут открывать, писать и ставить задания в очередь печати (по умолчанию: printable = no);

map to guest — определяет что делать с запросами, которые не удалось аутентифицировать («Never» — запросы с неправильными паролями будут отклонены; «Bad user» — запросы с неправильными паролями будут отклонены, если такое имя пользователя существует;) (по умолчанию: map to guest = Never).

/etc/samba/smb.conf для работы Samba в режиме файлового сервера с двумя открытыми для общего доступа ресурсами, домашними каталогами пользователей и принтером (закомментированные параметры действуют по умолчанию):

[global]

workgroup = WORKGROUP

server string = Samba Server Version %v

security = user

log file = /var/log/samba/log.%m

max log size = 50

guest ok = yes

cups options = raw

map to guest = Bad User

; idmap config * : backend = tdb

[homes]

comment = Home Directory for '%u'

browseable = no

writable = yes

guest ok = no

[share]

comment = Commonplace

path = /srv/share

read only = No

[printers]

comment = All Printers

path = /var/spool/samba

browseable = no

; guest ok = no

; writable = no

printable = yes

# Каталог доступный только для чтения, за исключением пользователей

# входящих в группу "staff"

[public]

comment = Public Stuff

path = /home/samba

public = yes

writable = yes

write list = +staff

; browseable = yes

[Free]

path = /mnt/win/Free

read only = no

; browseable = yes

guest ok = yes

# smbclient -L 192.168.0.157 -Uuser

Password for [WORKGROUP\user]:

Sharename Type Comment

--------- ---- -------

share Disk Commonplace

public Disk Public Stuff

Free Disk

IPC$ IPC IPC Service (Samba Server Version 4.15.9)

user Disk Home Directory for 'user'

Примечание

man smb.conf.

/etc/fstab /etc/samba/sambacreds (например, командой mcedit /etc/samba/sambacreds), с содержимым:

username=имя_пользователя password=пароль

/etc/fstab необходимо прописать:

//server/public /mnt/server_public cifs users,credentials=/etc/samba/sambacreds 0 0

/etc/samba/sambacreds, надо установить так, чтобы файл был доступен только владельцу:

# chmod 600 /etc/samba/sambacreds

и принадлежать root:

# chown root: /etc/samba/sambacreds

#systemctl stop ahttpd#a2dissite 000-default_https#a2disport https#systemctl condreload httpd2

# apt-get install freeipa-server freeipa-server-dns

# hostnamectl set-hostname ipa.example.test

Примечание

# ipa-server-install -U --hostname=$(hostname) -r EXAMPLE.TEST -n example.test -p 12345678 -a 12345678 --setup-dns --forwarder 8.8.8.8 --auto-reverse

Для пакетной установки необходимо указать следующие параметры:

-r REALM_NAME — имя области Kerberos для сервера FreeIPA;

-n DOMAIN_NAME — доменное имя;

-p DM_PASSWORD — пароль, который будет использоваться сервером каталогов для менеджера каталогов (DM);

-a ADMIN_PASSWORD — пароль пользователя admin, администратора FreeIPA;

-U — позволить процессу установки выбрать параметры по умолчанию, не запрашивая у пользователя информацию;

--hostname=HOST_NAME — полное DNS-имя этого сервера.

--setup-dns — создать зону DNS, если она еще не существует, и настроить DNS-сервер;

--forwarder или --no-forwarders — в зависимости от того, нужно ли настроить серверы пересылки DNS или нет;

--auto-reverse или --no-reverse — в зависимости от того, нужно ли настроить автоматическое обнаружение обратных зон DNS, которые должны быть созданы в FreeIPA DNS, или отключить автоматическое определение обратных зон.

Предупреждение

--mkhomedir):

# ipa-server-install -U --hostname=$(hostname) -r EXAMPLE.TEST -n example.test -p 12345678 -a 12345678 --setup-dns --forwarder 8.8.8.8 --auto-reverse --mkhomedir

# ipa-server-install

Do you want to configure integrated DNS (BIND)? [no]: yesОстальные вопросы необходимо выбрать по умолчанию (можно просто нажать Enter). Так же при установке необходимо ввести пароль администратора системы и пароль администратора каталогов (пароли должны быть не менее 8 символов).

# kinit admin

# ipa dnsrecord-add example.test _ntp._udp --srv-priority=0 --srv-weight=100 --srv-port=123 --srv-target=ipa.example.test

# ntpdate -q localhost

server 127.0.0.1, stratum 3, offset 0.000018, delay 0.02568

27 Nov 10:27:00 ntpdate[29854]: adjust time server 127.0.0.1 offset 0.000018 sec

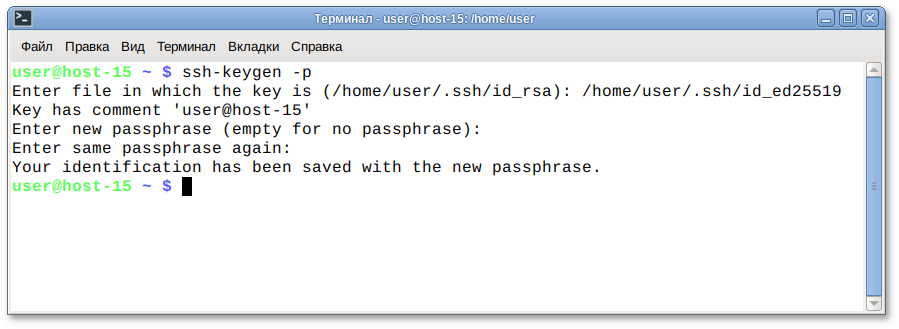

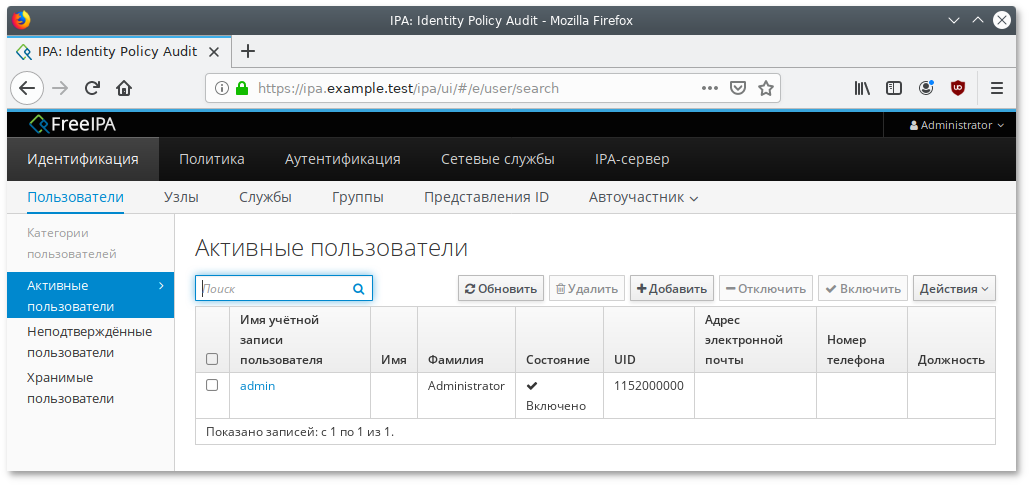

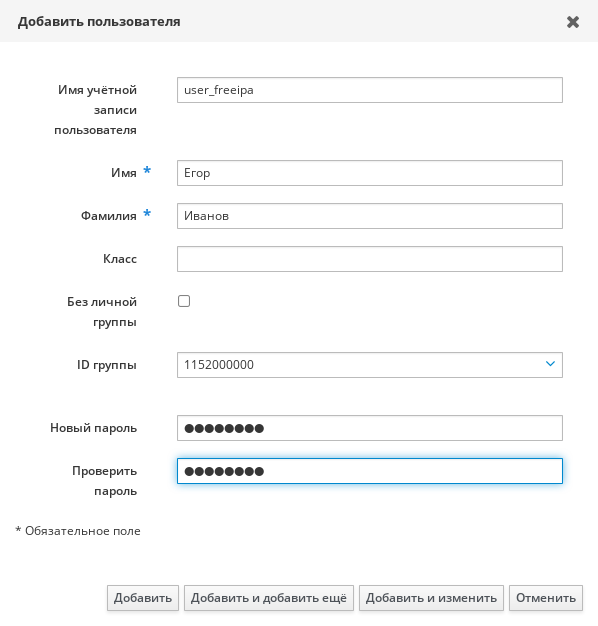

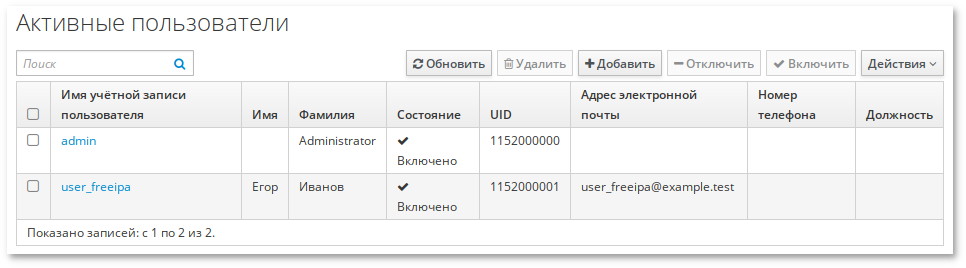

https://ipa.example.test/ipa/ui/.

Примечание

# ipa-server-install --uninstall

https://ipa.example.test/ipa/ui/ и ввести данные администратора для входа в систему.

# apt-get install freeipa-client libsss_sudo krb5-kinit bind-utils libbind zip task-auth-freeipa

# hostnamectl set-hostname comp01.example.test

/etc/net/ifaces/eth0/resolv.conf со следующим содержимым:

nameserver 192.168.0.113где 192.168.0.113 — IP-адрес FreeIPA сервера.

/etc/resolvconf.conf добавить/отредактировать следующие параметры:

interface_order='lo lo[0-9]* lo.* eth0' search_domains=example.testгде eth0 — интерфейс на котором доступен FreeIPA сервер, example.test — домен.

# resolvconf -u

Примечание

/etc/resolv.conf должны появиться строки:

search example.test nameserver 192.168.0.113

# ipa-client-install -U -p admin -w 12345678

или интерактивно:

# ipa-client-install

'''Discovery was successful!''' Client hostname: comp01.example.test Realm: EXAMPLE.TEST DNS Domain: example.test IPA Server: ipa.example.test BaseDN: dc=example,dc=test Continue to configure the system with these values? [no]:Необходимо ответить

yes, ввести имя пользователя, имеющего право вводить машины в домен, и его пароль.

Предупреждение

Hostname (comp01.example.test) does not have A/AAAA record. Failed to update DNS records.Необходимо проверить IP-адрес доменного DNS сервера в файле

/etc/resolv.conf.

# ipa-client-install -U --uninstall

# control sudo public

# ipa-client-install --uninstall

…

Client uninstall complete.

The original nsswitch.conf configuration has been restored.

You may need to restart services or reboot the machine.

Do you want to reboot the machine? [no]: yes

The ipa-client-install command was successful

/etc/krb5.keytab):

# ipa-rmkeytab -k /path/to/keytab -r EXAMPLE.TEST

# ipa dnsrecord-del

Имя записи: comp01

Имя зоны: example.test

Возможность удаления определённой записи не предусмотрена.

Удалить все? Yes/No (default No): yes

-----------------------

Удалена запись "comp01"

-----------------------

# ipa host-del comp01.example.test

---------------------------------

Удалён узел "comp01.example.test"

---------------------------------

Примечание

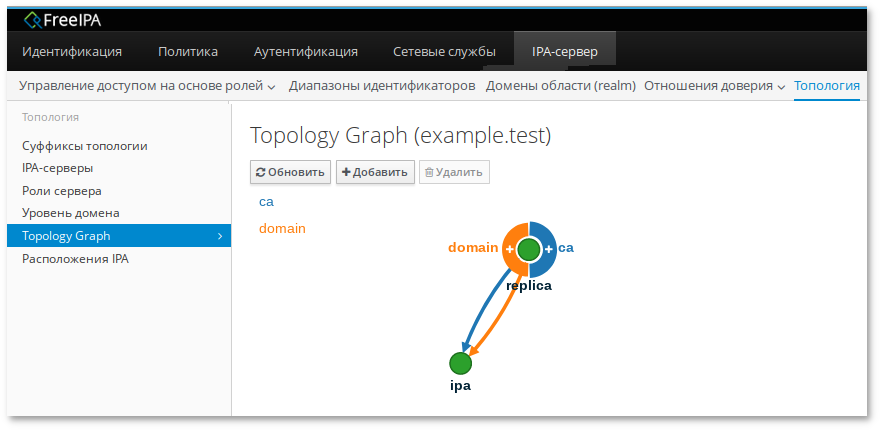

ipa-replica-install сначала регистрирует систему в качестве клиента, а затем устанавливает компоненты реплики. В примере, описанном ниже, для авторизации регистрации используется случайный пароль, действительный только для одной регистрации этого клиента.

$ kinit admin

$ ipa host-add replica.example.test --random --ip-address=192.168.0.145

----------------------------------

Добавлен узел "replica.example.test"

----------------------------------

Имя узла: replica.example.test

Случайный пароль: 2AaT0Ix8itDsYugdDGoRtBt

Пароль: True

Таблица ключей: False

Managed by: replica.example.test

$ ipa hostgroup-add-member ipaservers --hosts replica.example.test

Группа узлов: ipaservers

Описание: IPA server hosts

Узлы-участники: ipa.example.test, replica.example.test

-----------------------------------

Количество добавленных участников 1

-----------------------------------

# apt-get install freeipa-server freeipa-server-dns

ipa-replica-install, указав сгенерированный пароль в параметре --password (т.к. пароль часто содержит специальные символы, следует заключить его в одинарные кавычки):

# ipa-replica-install --password='2AaT0Ix8itDsYugdDGoRtBt' --setup-ca --setup-dns --forwarder 192.168.0.113 --forwarder 8.8.8.8

Configuring client side components

This program will set up IPA client.

Version 4.9.10

Discovery was successful!

Client hostname: replica.example.test

Realm: EXAMPLE.TEST

DNS Domain: example.test

IPA Server: ipa.example.test

BaseDN: dc=example,dc=test

…

The ipa-client-install command was successful

…

The ipa-replica-install command was successful

$ ipa user-add test_user

$ ipa user-show test_user

Примечание

# apt-get install nginx

# systemctl enable --now nginx

# mkdir -p /var/www/test.alt

/etc/nginx/sites-available.d/test.alt.conf на основе /etc/nginx/sites-available.d/default.conf:

# cp /etc/nginx/sites-available.d/default.conf /etc/nginx/sites-available.d/test.alt.conf

/etc/nginx/sites-available.d/test.alt.conf:

server {

listen *:80;

server_name test.alt www.test.alt;

location / {

root /var/www/test.alt;

}

access_log /var/log/nginx/test.alt-access.log;

}

# ln -s /etc/nginx/sites-available.d/test.alt.conf /etc/nginx/sites-enabled.d/

# systemctl reload nginx

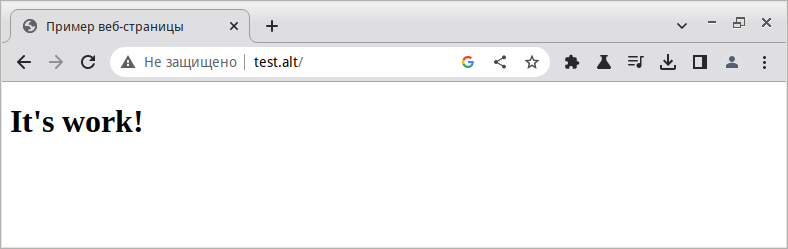

/var/www/test.alt/index.html со следующим содержимым:

<html> <head> <title>Пример веб-страницы</title> </head> <body> <h1>It's work!</h1> </body> </html>

/etc/nginx/nginx.conf — главный файл конфигурации Nginx;

/etc/nginx/sites-available — каталог с конфигурациями виртуальных хостов (каждый файл, находящийся в этом каталоге, содержит информацию о конкретном сайте);

/etc/nginx/sites-enabled — в этом каталоге содержаться конфигурации активных сайтов, обслуживаемых Nginx.

# apt-get install mariadb

# systemctl enable --now mariadb.service

# mysql_secure_installation

$mysql -u root -pEnter password: Welcome to the MariaDB monitor. Commands end with ; or \g. Your MariaDB connection id is 24 Server version: 10.6.9-MariaDB-alt1 (ALT p10) Copyright (c) 2000, 2018, Oracle, MariaDB Corporation Ab and others. Type 'help;' or '\h' for help. Type '\c' to clear the current input statement. MariaDB [(none)]>exit$

Примечание

mysql_secure_installation. Это связано с тем, что метод аутентификации по умолчанию для пользователя root в MySQL — unix_socket. Пользователями, которым разрешено входить в систему в качестве пользователя root MySQL, являются системные пользователи с привилегиями sudo, подключающиеся из консоли или через приложение, работающее с одинаковыми привилегиями.

#mysqlMariaDB [(none)]>exit#

Примечание

# apt-get install php8.2-fpm-fcgi php8.2-mysqlnd php8.2-mysqlnd-mysqli

# systemctl enable --now php8.2-fpm

Примечание

$ php -v

/etc/nginx/sites-available.d/test.alt.conf:

server {

listen *:80;

# can't use wildcards in first server_name

server_name test.alt www.test.alt;

index index.php;

root /var/www/test.alt;

location / {

try_files $uri =404;

}

location ~ \.php$ {

try_files $uri =404;

include /etc/nginx/fastcgi_params;

fastcgi_pass unix:/var/run/php8.2-fpm/php8.2-fpm.sock;

fastcgi_param SCRIPT_FILENAME /var/www/test.alt/$fastcgi_script_name;

}

access_log /var/log/nginx/test.alt-access.log;

}

listen — задаёт адрес и порт, на которых сервер будет принимать запросы. Можно указать адрес и порт, либо только адрес или только порт;

root — определяет корневой каталог, в котором хранятся файлы, обслуживаемые данным веб-сайтом;

index — определяет файлы, которые будут использоваться в качестве индекса. В имени файла можно использовать переменные. Наличие файлов проверяется в порядке их перечисления;

server_name — определяет имя виртуального сервера (в этой директиве необходимо указать доменное имя сервера или общедоступный IP-адрес);

location / — первый блок location включает директиву try_files, которая проверяет наличие файлов или каталогов, соответствующих запросу URI. Если Nginx не может найти подходящий ресурс, он вернет ошибку 404;

location ~ \.php$ — этот блок location включает фактическую обработку PHP, указывая Nginx на файл конфигурации fastcgi-php.conf и файл php8.2-fpm.sock, который объявляет, какой сокет связан с php-fpm;

location ~ /\.ht — этот блок location имеет дело с файлами .htaccess, которые Nginx не обрабатывает. При добавлении директивы deny all, если какие-либо файлы .htaccess попадут в корень документа, они не будут показываться посетителям.

# nginx -t

nginx: the configuration file /etc/nginx/nginx.conf syntax is ok

nginx: configuration file /etc/nginx/nginx.conf test is successful

# systemctl reload nginx.service

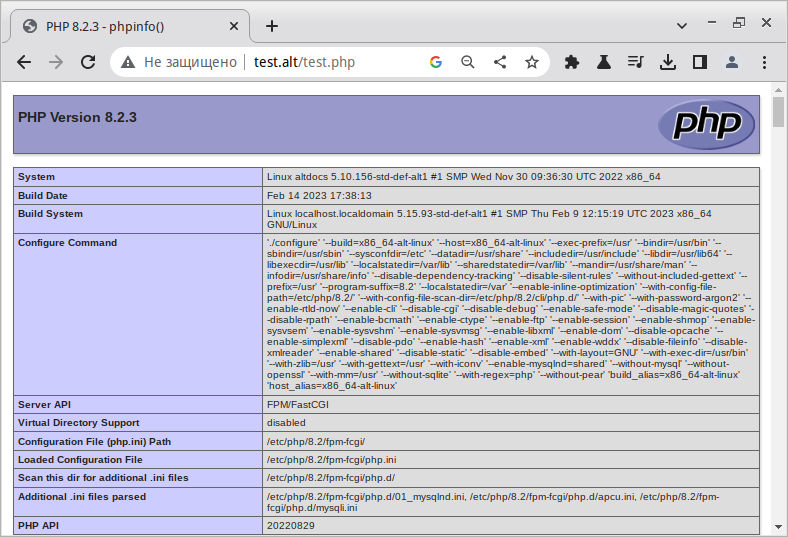

/var/www/test.alt/test.php со следующим содержимым:

<?php phpinfo(); ?>

http://test.alt/test.php будет доступна информация о PHP:

# rm /var/www/test.alt/test.php

# mysql

Создать новую БД:

MariaDB [(none)]> CREATE DATABASE example_db;

Query OK, 1 row affected (0,000 sec)

Создать нового пользователя и предоставить ему полные права доступа к базе данных example_database:

MariaDB [(none)]> CREATE USER 'example_user'@'%' IDENTIFIED BY 'password';

Query OK, 0 rows affected (0,002 sec)

Предоставить пользователю example_user все права на базу example_db:

MariaDB [(none)]>Выйти из оболочки MySQL:GRANT ALL PRIVILEGES ON example_db.* TO 'example_user'@'%';Query OK, 0 rows affected (0,002 sec) MariaDB [(none)]>FLUSH PRIVILEGES;Query OK, 0 rows affected (0,000 sec)

MariaDB [(none)]> exit;

$ mysql -u example_user -p

Enter password:

MariaDB [(none)]>

MariaDB [(none)]> SHOW DATABASES;

+--------------------+

| Database |

+--------------------+

| example_db |

| information_schema |

+--------------------+

2 rows in set (0,000 sec)

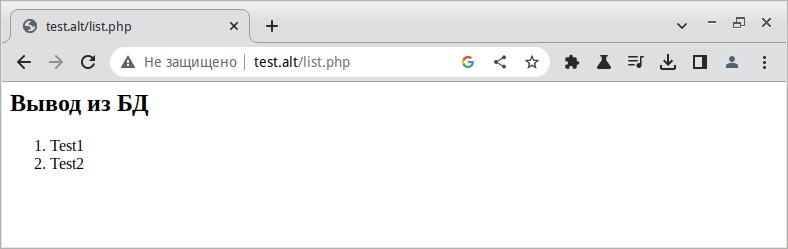

MariaDB [(none)]>USE example_db;MariaDB [(none)]>CREATE TABLE test (item_id INT AUTO_INCREMENT, content VARCHAR(255), PRIMARY KEY(item_id));MariaDB [(none)]>INSERT INTO test (content) VALUES ("Test1");MariaDB [(none)]>INSERT INTO test (content) VALUES ("Test2");MariaDB [(none)]>EXIT

/var/www/test.alt/list.php), который будет подключаться к MySQL и запрашивать контент, со следующим содержимым:

<?php

$user = "example_user";

$password = "password";

$database = "example_db";

$table = "test";

$conn = mysqli_connect("localhost", $user, $password, $database);

if (!$conn) {

die("Connection failed: " . mysqli_connect_error());

}

echo "<h2>Вывод из БД</h2><ol>";

foreach($conn->query("SELECT content FROM $table") as $row) {

echo "<li>" . $row['content'] . "</li>";

}

echo "</ol>";

mysqli_close($conn);

?>

http://test.alt/list.php:

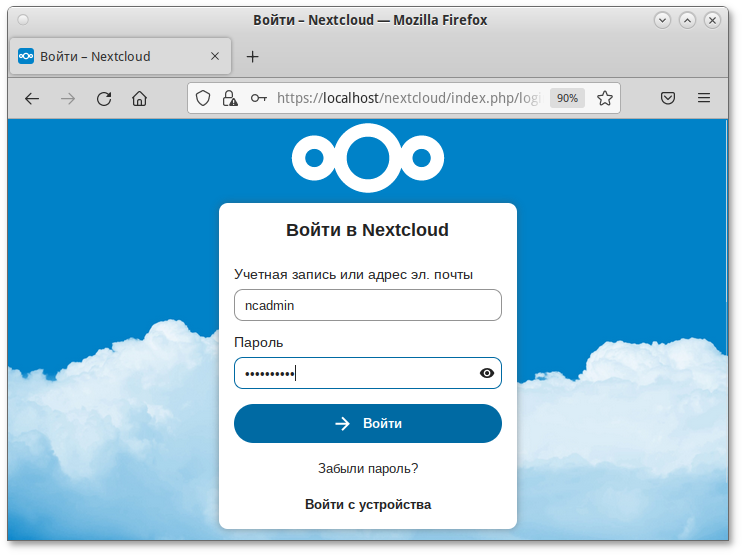

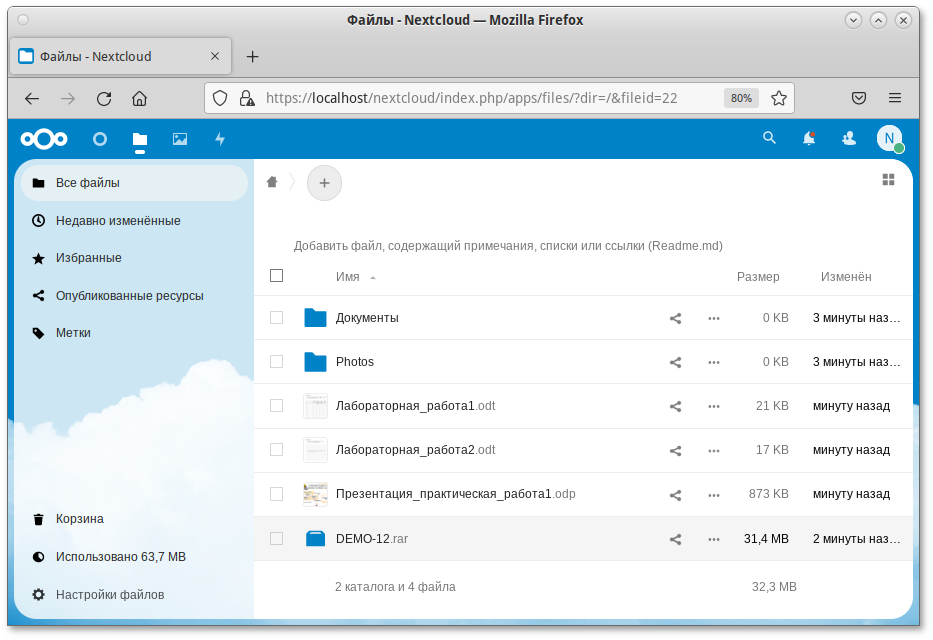

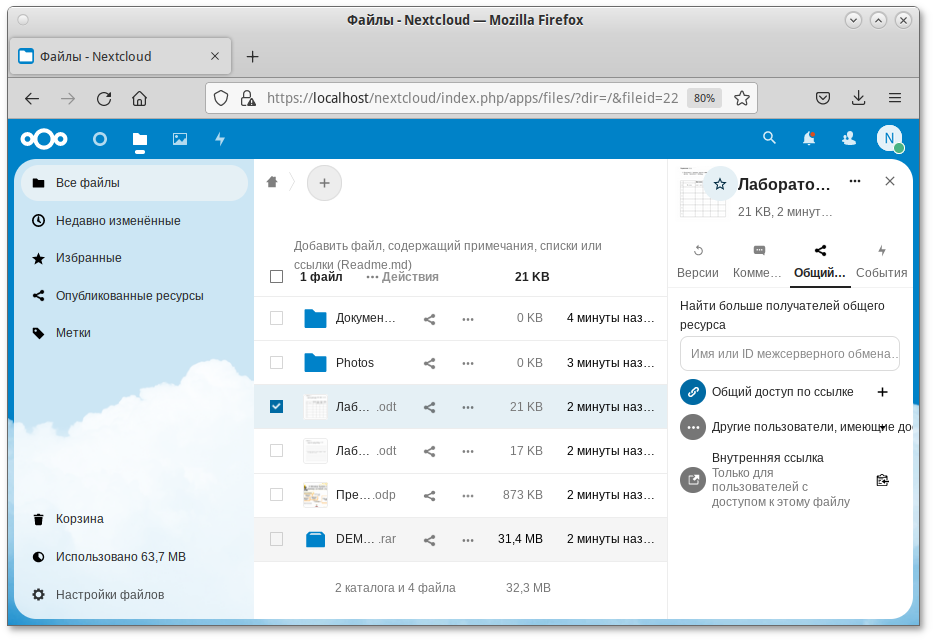

#apt-get install deploy#deploy nextcloud

# deploy nextcloud password=5Z4SAq2U28rWyVz

/var/www/webapps/nextcloud/config/config.php — файл конфигурации Nextcloud.

Важно

'memcache.local' => '\OC\Memcache\Memcached',

'memcache.distributed' => '\OC\Memcache\Memcached',

'memcached_servers' => array(

array('localhost', 11211),

),

Примечание

# apt-get install memcached php8.0-memcached

Служба memcached должна быть добавлена в автозагрузку:

# systemctl enable --now memcached

'trusted_domains' => array ( 0 => 'localhost', 1 => 'IP-адрес', 2 => 'nextcloud.test.ru', ),

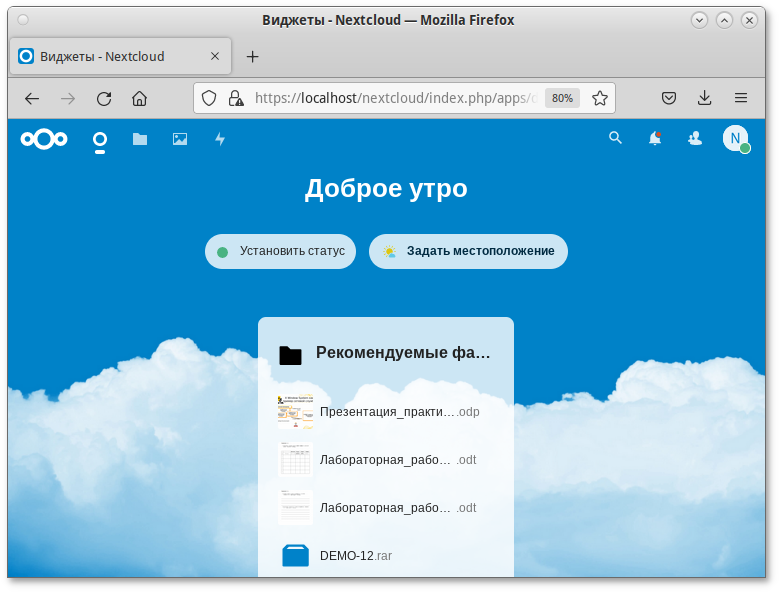

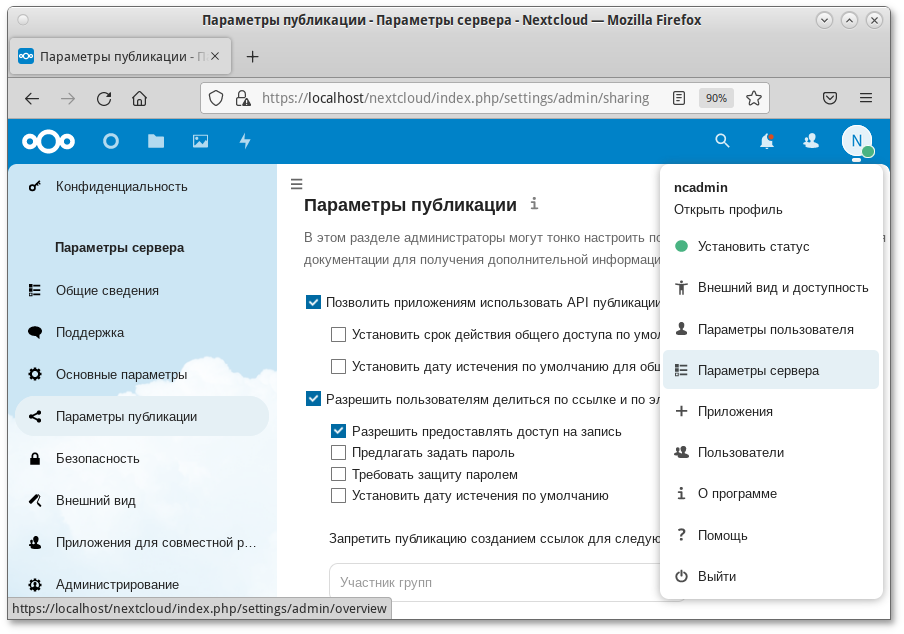

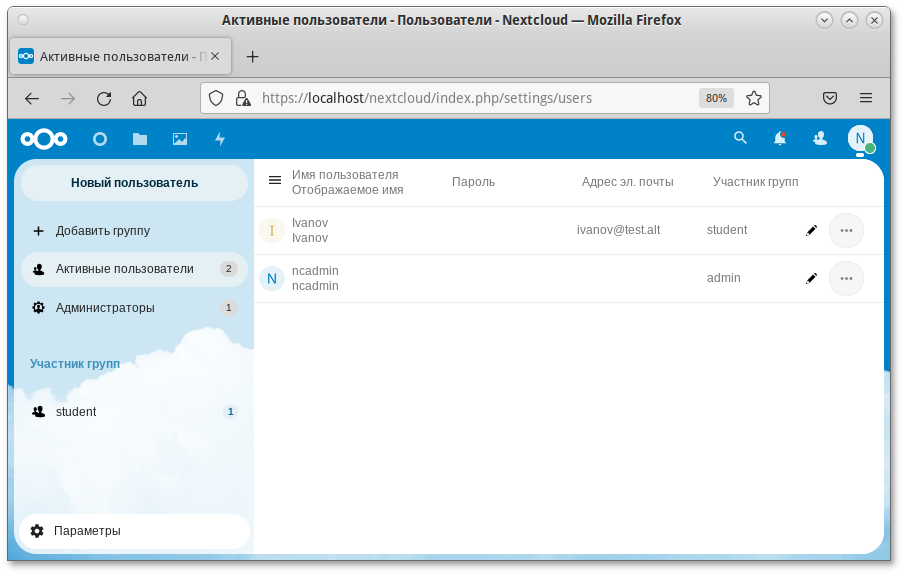

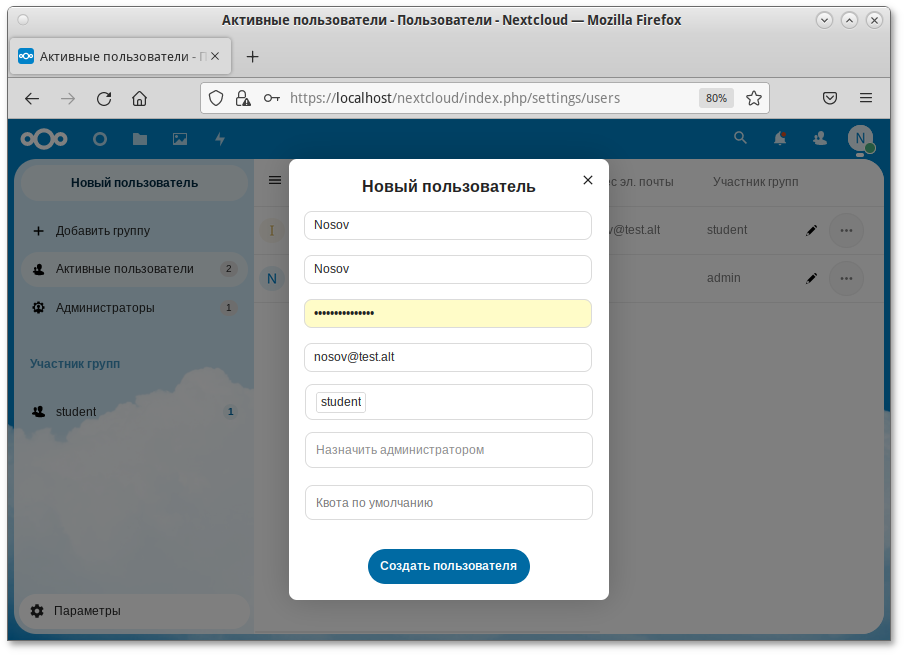

https://IP-адрес/nextcloud/. Администратор: ncadmin.

Примечание

Таблица 17.1. Системные требования

|

Компонент

|

ОЗУ

|

ЦП

|

Диск

|

|---|---|---|---|

|

OpenUDS Server

|

2 ГБ

|

2 vCPUs

|

8 ГБ

|

|

SQL Server

|

1 ГБ

|

2 vCPUs

|

10 ГБ

|

|

OpenUDS Tunnel

|

2 ГБ

|

2 vCPUs

|

13 ГБ

|

Примечание

# apt-get install mariadb

Запустить сервер mariadb и добавить его в автозагрузку:

# systemctl enable --now mariadb.service

Задать пароль root для mysql и настройки безопасности:

# mysql_secure_installation

$mysql -u root -pEnter password: MariaDB>CREATE DATABASE dbuds CHARACTER SET utf8 COLLATE utf8_general_ci;MariaDB>CREATE USER 'dbuds'@'%' IDENTIFIED BY 'password';MariaDB>GRANT ALL PRIVILEGES ON dbuds.* TO 'dbuds'@'%';MariaDB>FLUSH PRIVILEGES;MariaDB>exit;

# apt-get install openuds-server-nginx

/etc/openuds/settings.py, указав корректные данные для подключения к SQL серверу:

DATABASES = {

'default': {

'ENGINE': 'django.db.backends.mysql',

'OPTIONS': {

'isolation_level': 'read committed',

},

'NAME': 'dbuds',

'USER': 'dbuds',

'PASSWORD': 'password',

'HOST': 'localhost',

'PORT': '3306',

}

}

#su -s /bin/bash - openuds$cd /usr/share/openuds$python3 manage.py migrate$exit

# systemctl enable --now openuds-web.service

#ln -s ../sites-available.d/openuds.conf /etc/nginx/sites-enabled.d/openuds.conf#systemctl enable --now nginx.service

# systemctl enable --now openuds-taskmanager.service

Примечание

Примечание

Примечание

# apt-get install openuds-tunnel

Примечание

/etc/openuds-tunnel/ssl генерируются сертификаты. Их можно заменить на свои, выпущенные внутри организации или Удостоверяющим Центром.

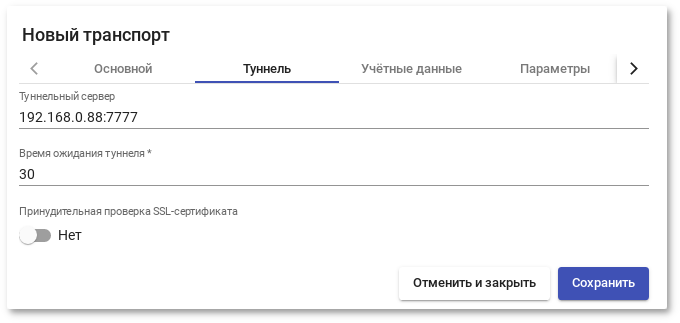

/etc/openuds-tunnel/udstunnel.conf :

uds_server = http://192.168.0.53/uds/rest/tunnel/ticket uds_token = 5ba9d52bb381196c2a22e495ff1c9ba4bdc03440b726aa8bгде 192.168.0.53 — адрес OpenUDS сервера (брокера);

# systemctl enable --now openuds-tunnel.service

# openuds_tunnel_register.py -H 192.168.0.88 -n Tunnel -t 5ba9d52bb381196c2a22e495ff1c9ba4bdc03440b726aa8b

Tunnel token register success. (With token: 5ba9d52bb381196c2a22e495ff1c9ba4bdc03440b726aa8b)

где:

-H — задаёт IP-адрес туннельного сервера;

-n — задаёт название туннеля;

-t — позволяет указать токен туннельного сервера (из файла udstunnel.conf).

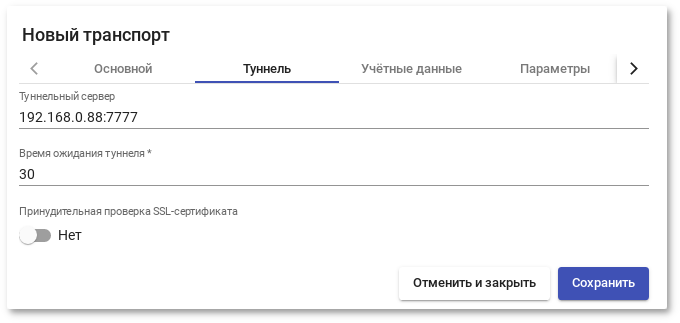

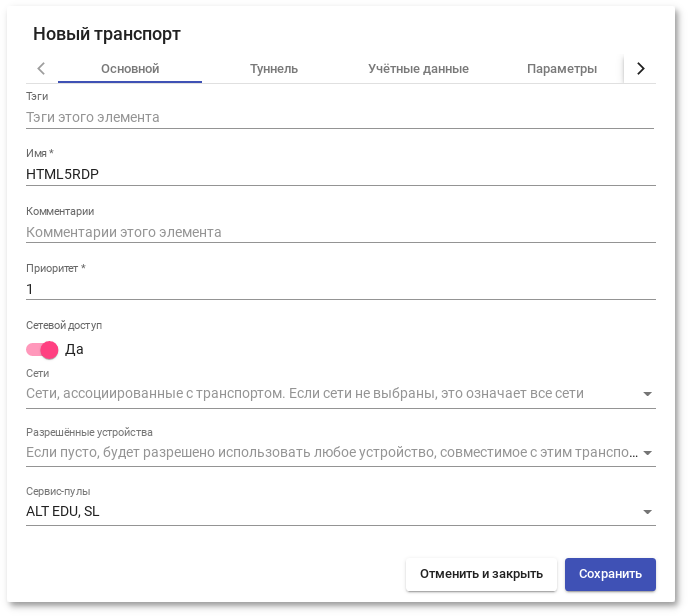

192.168.0.88:7777

/etc/guacamole/guacamole.properties привести значение параметра uds-base-url к виду:

http://<IP openuds сервера>/uds/guacamole/auth/<Токен из файла udstunnel.conf>/Например:

uds-base-url=http://192.168.0.53/uds/guacamole/auth/5ba9d52bb381196c2a22e495ff1c9ba4bdc03440b726aa8b

/etc/tomcat/server.xml добавить новый Connector, в котором указать порт (в примере 10443), сертификат (файл .crt, .pem и т.д.), закрытый ключ (.key, .pem и т.д.):

<Connector port="10443" protocol="org.apache.coyote.http11.Http11AprProtocol" SSLEnabled="true"

ciphers="A-CHACHA20-POLY1305,ECDHE-RSA-CHACHA20-POLY1305,

ECDHE-ECDSA-AES128-GCM-SHA256,ECDHE-RSA-AES128-GCM-SHA256,

ECDHE-ECDSA-AES256-GCM-SHA384,ECDHE-RSA-AES256-GCM-SHA384,

DHE-RSA-AES128-GCM-SHA256,DHE-RSA-AES256-GCM-SHA384,

ECDHE-ECDSA-AES128-SHA256,ECDHE-RSA-AES128-SHA256,

ECDHE-ECDSA-AES128-SHA,ECDHE-RSA-AES256-SHA384,

ECDHE-RSA-AES128-SHA,ECDHE-ECDSA-AES256-SHA384,

ECDHE-ECDSA-AES256-SHA,ECDHE-RSA-AES256-SHA,

DHE-RSA-AES128-SHA256,DHE-RSA-AES128-SHA,

DHE-RSA-AES256-SHA256,DHE-RSA-AES256-SHA,

ECDHE-ECDSA-DES-CBC3-SHA,ECDHE-RSA-DES-CBC3-SHA,

EDH-RSA-DES-CBC3-SHA,AES128-GCM-SHA256,AES256-GCM-SHA384,

AES128-SHA256,AES256-SHA256,AES128-SHA,AES256-SHA,DES-CBC3-SHA"

maxThreads="500" scheme="https" secure="true"

SSLCertificateFile="/etc/openuds-tunnel/ssl/certs/openuds-tunnel.pem"

SSLCertificateKeyFile="/etc/openuds-tunnel/ssl/private/openuds-tunnel.key"

maxKeepAliveRequests="1000"

clientAuth="false" sslProtocol="TLSv1+TLSv1.1+TLSv1.2" />

# systemctl enable --now guacd tomcat

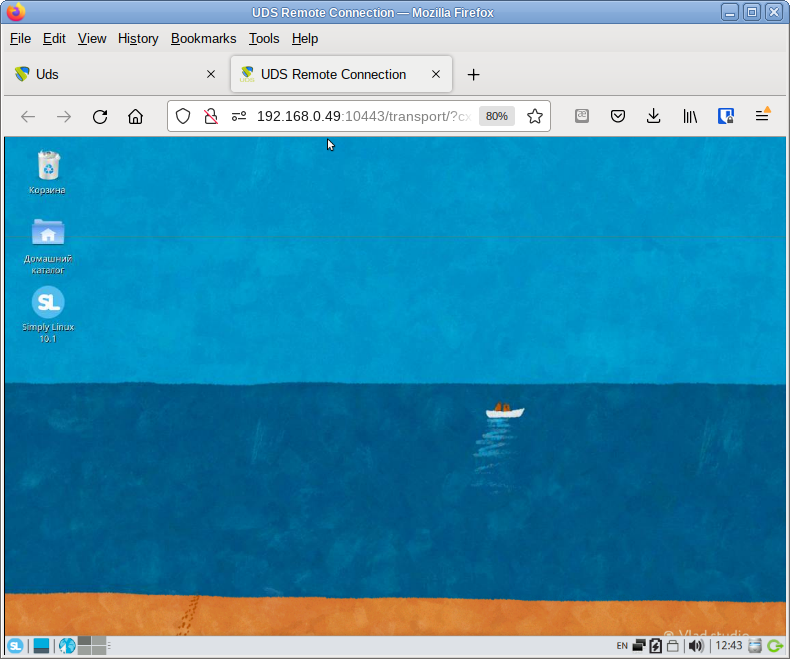

http://192.168.0.88:8080 — для подключения по http;

https://192.168.0.88:10443 — для подключения по https.

/etc/openuds/settings.py.rpmnew в файл /etc/openuds/settings.py. Проверить, что изменилось можно, выполнив команду:

# diff -u --color /etc/openuds/settings.py /etc/openuds/settings.py.rpmnew

# su -s /bin/bash - openuds -c "cd /usr/share/openuds; python3 manage.py migrate"

/run/openuds/socket.

Примечание

Примечание

Примечание

Примечание

Примечание

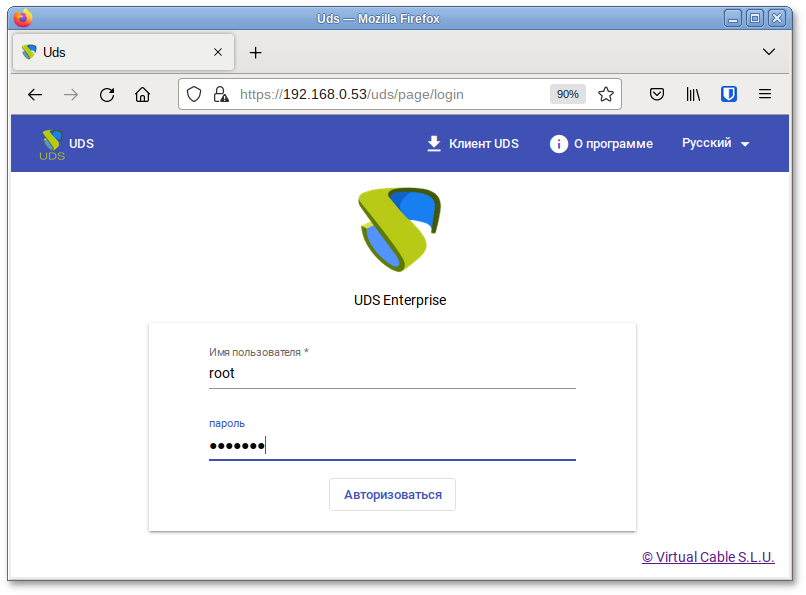

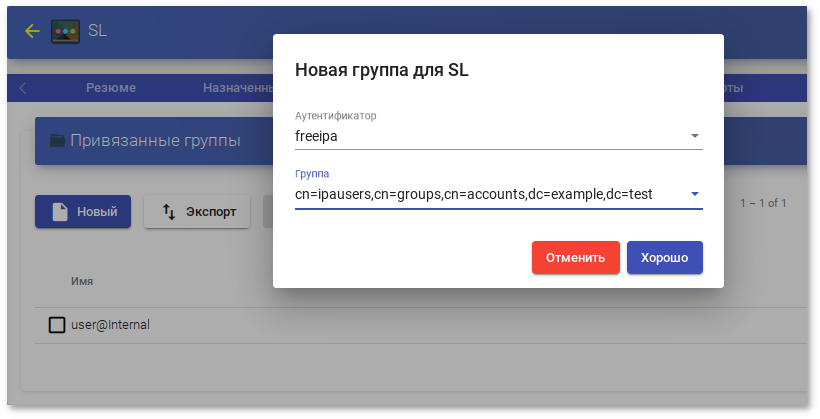

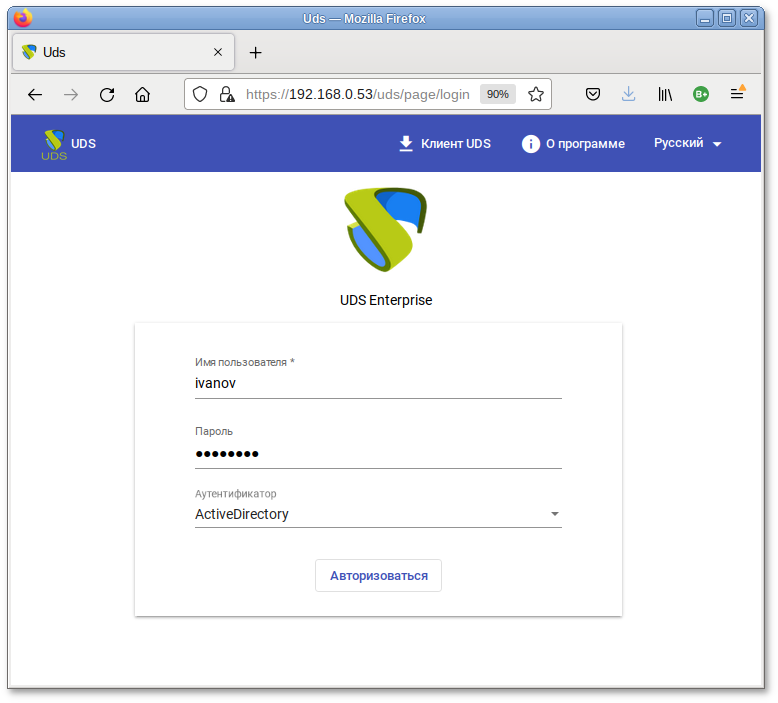

https://192.168.0.53/uds/page/login/AD).

Важно

Примечание

Примечание

Примечание

OU = name_OU_last_level, … OU = name_OU_first_level, DC = name_domain, DC = extension_domain. Во избежание ошибок, рекомендуется сверяться с полем distinguishedName в свойствах атрибута OU;

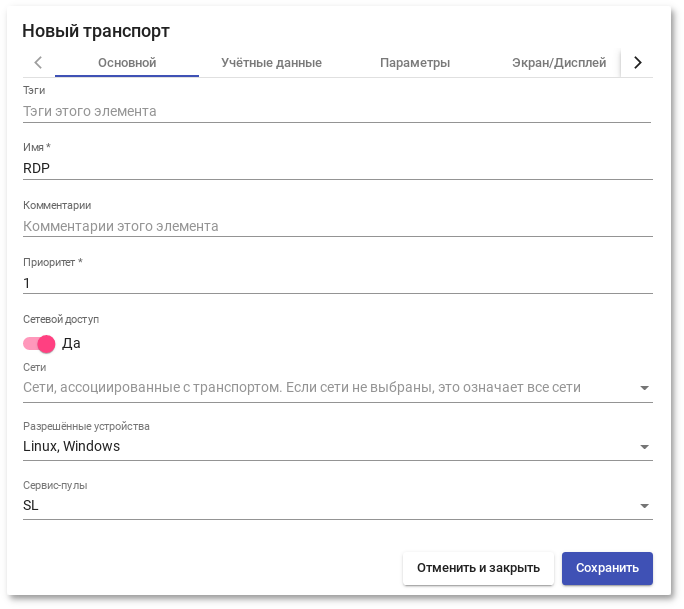

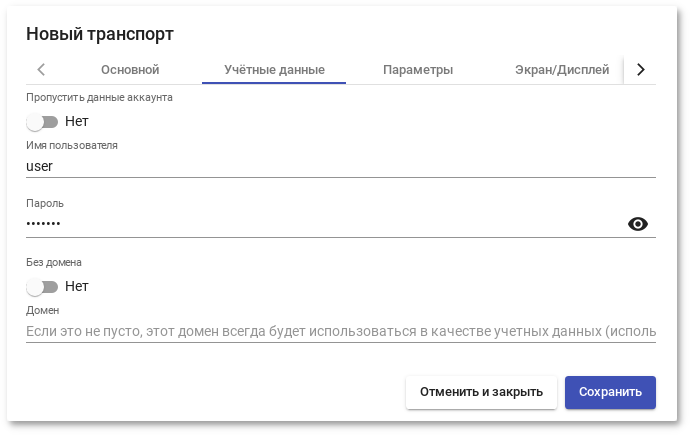

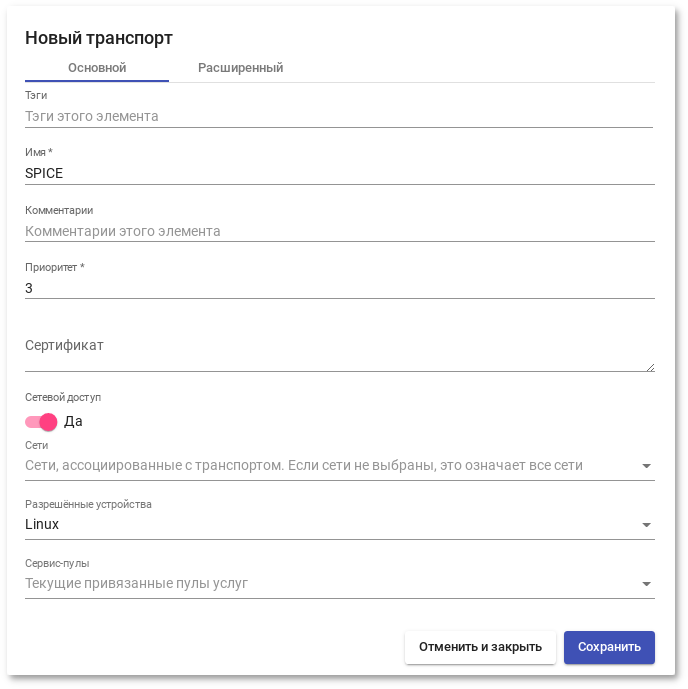

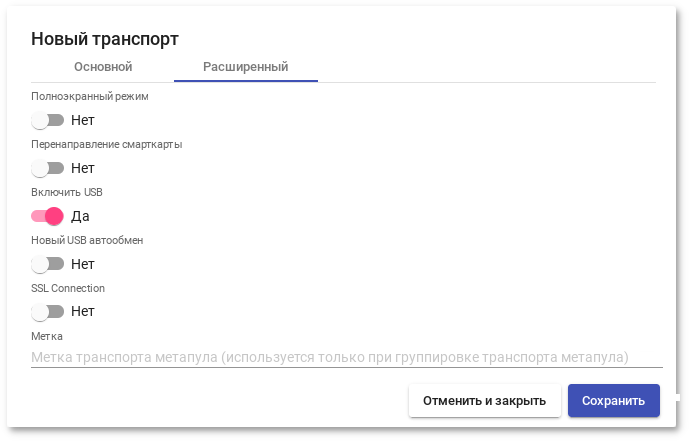

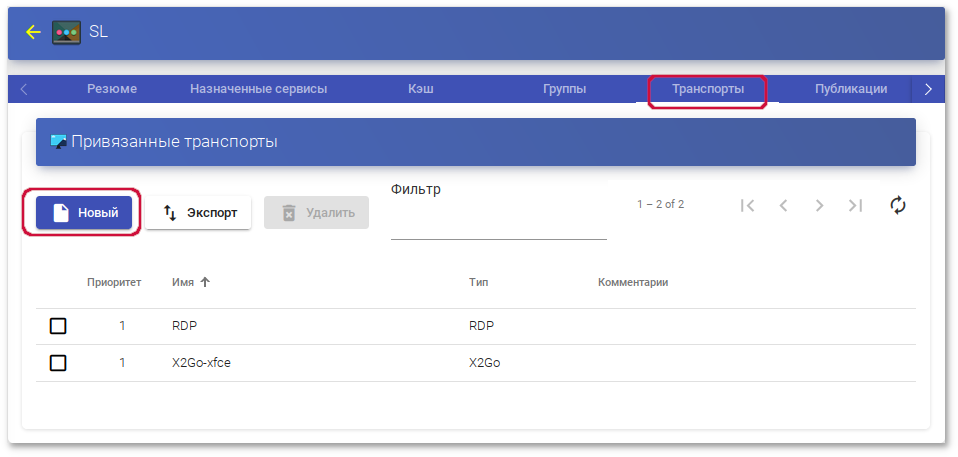

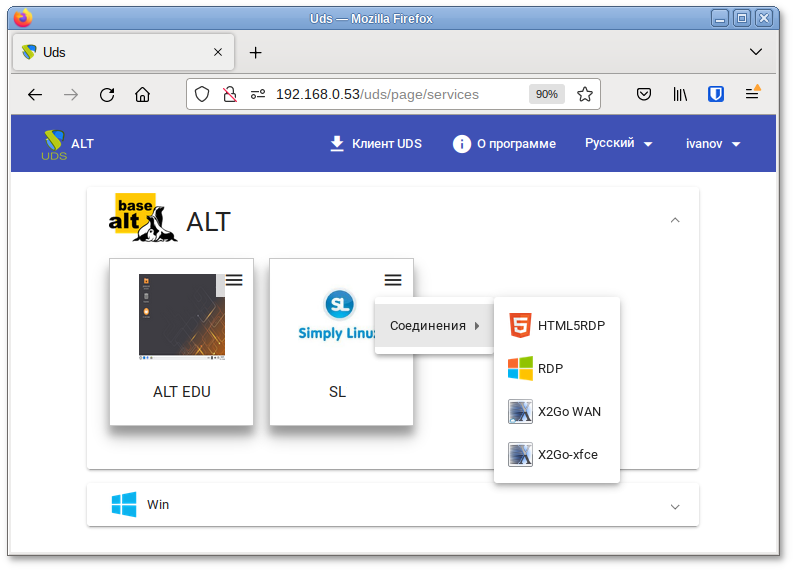

lpstat -a);

/media);

Примечание

Важно

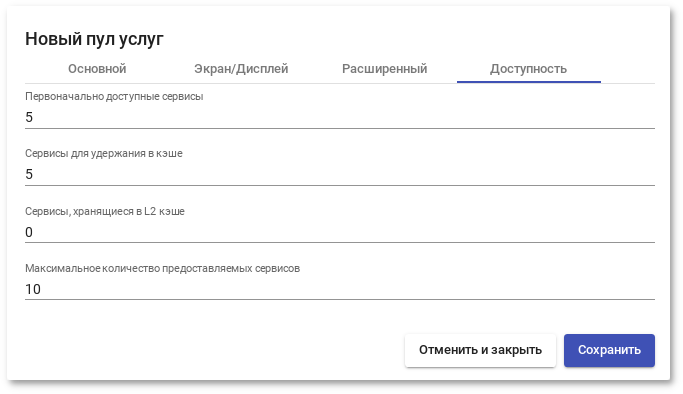

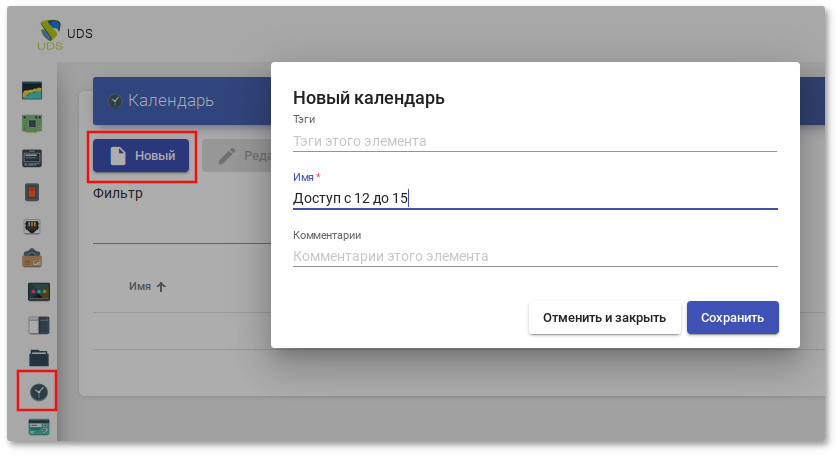

{use} — указывает процент использования пула (рассчитывается на основе поля Максимальное количество предоставляемых сервисов и назначенных услуг);

{total} — общее количество машин (данные извлечены из поля Максимальное количество предоставляемых сервисов);

{usec} — количество машин, используемых пользователями в пуле;

{left} — количество машин, доступных в пуле для подключения пользователей;

Примечание

Примечание

Примечание

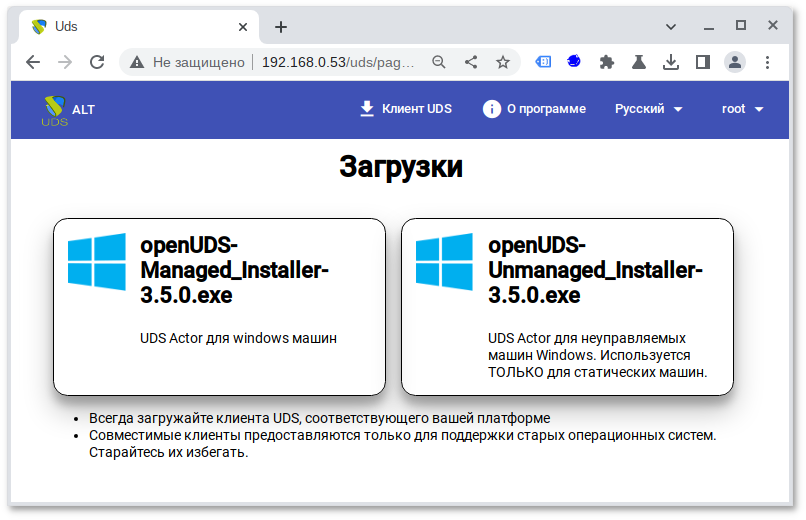

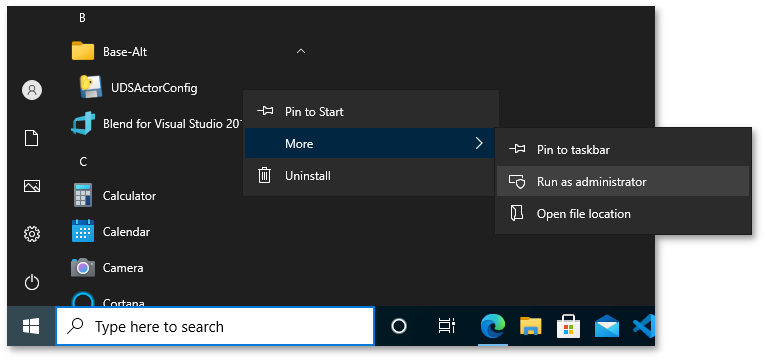

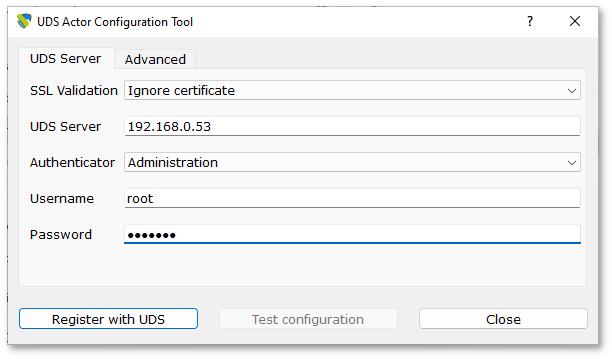

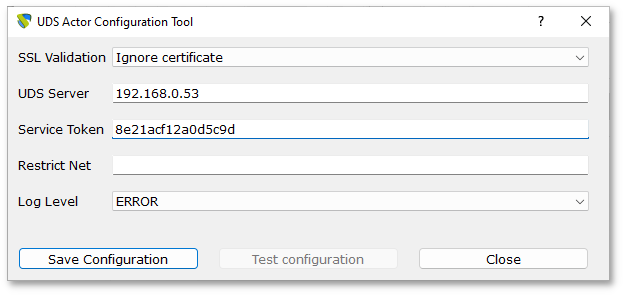

# apt-get install openuds-actor

# systemctl enable udsactor.service

$ /usr/sbin/UDSActorConfig-pkexec

# apt-get install xrdp

#systemctl enable --now xrdp#systemctl enable --now xrdp-sesman

# gpasswd -a user tsusers

# apt-get install x2goserver

# systemctl enable --now x2goserver

Примечание

Примечание

Примечание

Важно

Примечание

Примечание

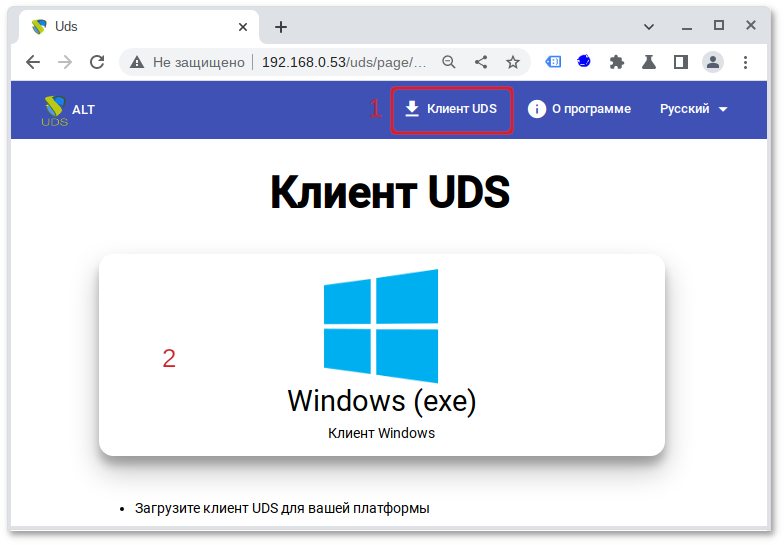

# apt-get install openuds-client

Примечание

Примечание

Примечание

Примечание

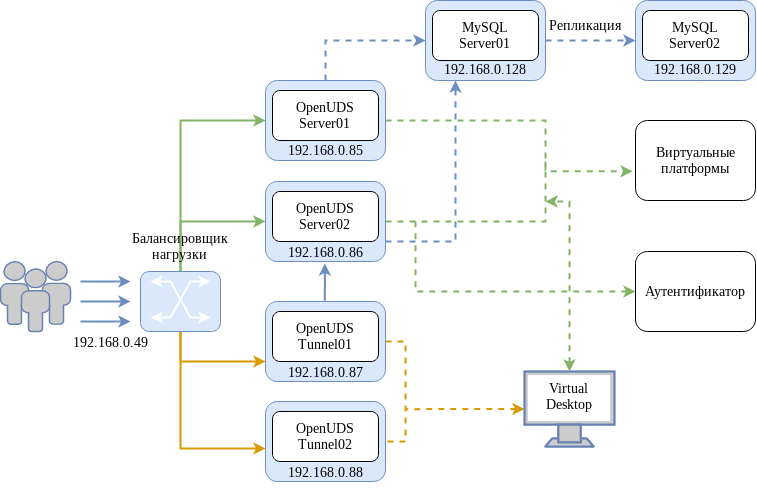

Таблица 17.2. Системные требования

|

Компонент

|

Количество

|

ОЗУ

|

ЦП

|

Диск

|

|---|---|---|---|---|

|

SQL Server

|

2

|

1 ГБ

|

2 vCPUs

|

10 ГБ

|

|

HAProxy

|

2

|

1 ГБ

|

2 vCPUs

|

10 ГБ

|

|

OpenUDS Server

|

2

|

2 ГБ

|

2 vCPUs

|

8 ГБ

|

|

OpenUDS Tunnel

|

2

|

2 ГБ

|

2 vCPUs

|

13 ГБ

|

Примечание

# apt-get install mariadb

Запустить сервер MySQL и добавить его в автозагрузку:

# systemctl enable --now mariadb.service

Задать пароль root и настройки безопасности для MySQL:

# mysql_secure_installation

/etc/my.cnf.d/server.cnf:

skip-networking;

server-id и log-bin;

server-id установлено значение 1;

bind-address и указать IP-адрес сервера (главного):

bind-address 192.168.0.128

# systemctl restart mariadb

$ mysql -p

MariaDB [(none)]> CREATE USER 'replica'@'%' IDENTIFIED BY 'uds';

Query OK, 0 rows affected (0.009 sec)

replication slave пользователю:

MariaDB [(none)]> GRANT REPLICATION SLAVE ON *.* TO 'replica'@'%' IDENTIFIED BY 'uds';

Query OK, 0 rows affected (0.002 sec)

MariaDB [(none)]> SHOW MASTER STATUS\G

*************************** 1. row ***************************

File: mysql-bin.000002

Position: 328

Binlog_Do_DB:

Binlog_Ignore_DB:

1 row in set (0.001 sec)

/etc/my.cnf.d/server.cnf:

skip-networking;

server-id и log-bin;

server-id установить значение 2;

bind-address и указать IP-адрес сервера (вторичного):

bind-address 192.168.0.129

# systemctl restart mariadb

$ mysql -p

MariaDB [(none)]> STOP SLAVE;

Query OK, 0 rows affected, 1 warning (0.001 sec)

MariaDB [(none)]> CHANGE MASTER TO MASTER_HOST='192.168.0.128', MASTER_USER='replica', MASTER_PASSWORD='uds', MASTER_LOG_FILE='mysql-bin.000002', MASTER_LOG_POS=328;

Query OK, 0 rows affected (0.020 sec)

MariaDB [(none)]> START SLAVE;

Query OK, 0 rows affected (0.001 sec)

MariaDB [(none)]> SHOW SLAVE STATUS\G

*************************** 1. row ***************************

Slave_IO_State: Waiting for master to send event

Master_Host: 192.168.0.128

Master_User: replica

Master_Port: 3306

Connect_Retry: 60

Master_Log_File: mysql-bin.000004

Read_Master_Log_Pos: 328

Relay_Log_File: mysqld-relay-bin.000006

Relay_Log_Pos: 555

Relay_Master_Log_File: mysql-bin.000004

Slave_IO_Running: Yes

Slave_SQL_Running: Yes

…

Slave_IO_Running и Slave_SQL_Running должны быть установлены в значение «Yes».

MariaDB [(none)]> CREATE DATABASE replicatest;

Query OK, 1 row affected (0.001 sec)

MariaDB [(none)]> SHOW DATABASES;

+--------------------+

| Database |

+--------------------+

| information_schema |

| mysql |

| performance_schema |

| replicatest |

+--------------------+

4 rows in set (0.001 sec)

MariaDB [(none)]> SHOW DATABASES;

+--------------------+

| Database |

+--------------------+

| information_schema |

| mysql |

| performance_schema |

| replicatest |

+--------------------+

4 rows in set (0.002 sec)

MariaDB [(none)]> DROP DATABASE replicatest;

$mysql -pEnter password: MariaDB [(none)]>CREATE DATABASE dbuds CHARACTER SET utf8 COLLATE utf8_general_ci;MariaDB [(none)]>CREATE USER 'dbuds'@'%' IDENTIFIED BY 'password';MariaDB [(none)]>GRANT ALL PRIVILEGES ON dbuds.* TO 'dbuds'@'%';MariaDB [(none)]>FLUSH PRIVILEGES;MariaDB [(none)]>exit;

/var/server/server/settings.py указать параметры новой БД (это необходимо сделать на всех серверах OpenUDS-Server).

Примечание

# mysqldump -u dbuds -ppassword --databases dbuds > dbuds_dump.sql

# openssl req -x509 -nodes -days 3650 -newkey rsa:2048 -keyout /root/ssl.key -out /root/ssl.crt

/etc/openssl/private):

# cat /root/ssl.crt /root/ssl.key > /etc/openssl/private/haproxy.pem

Примечание

/etc/openssl/private на вторичном сервере. Если используется собственный сертификат, его необходимо скопировать на оба сервера (основной и дополнительный).

Важно

# apt-get install haproxy keepalived

/etc/haproxy/haproxy.cfg следующим:

global

log /dev/log local0

log /dev/log local1 notice

chroot /var/lib/haproxy

stats socket /var/lib/haproxy/admin.sock mode 660 level admin

stats timeout 30s

maxconn 2048

user _haproxy

group _haproxy

daemon

# Default SSL material locations

# ca-base /etc/openssl/certs

# crt-base /etc/openssl/private

# Default ciphers to use on SSL-enabled listening sockets.

# For more information, see ciphers(1SSL). This list is from:

# https://hynek.me/articles/hardening-your-web-servers-ssl-ciphers/

ssl-default-bind-options ssl-min-ver TLSv1.2 prefer-client-ciphers

# ssl-default-bind-ciphersuites TLS_AES_128_GCM_SHA267:TLS_AES_267_GCM_SHA384:TLS_CHACHA20_POLY1305_SHA267

ssl-default-bind-ciphers ECDH+AESGCM:ECDH+CHACHA20:ECDH+AES267:ECDH+AES128:!aNULL:!SHA1:!AESCCM

# ssl-default-server-options ssl-min-ver TLSv1.2

# ssl-default-server-ciphersuites TLS_AES_128_GCM_SHA267:TLS_AES_267_GCM_SHA384:TLS_CHACHA20_POLY1305_SHA267

# ssl-default-server-ciphers ECDH+AESGCM:ECDH+CHACHA20:ECDH+AES267:ECDH+AES128:!aNULL:!SHA1:!AESCCM

tune.ssl.default-dh-param 2048

defaults

log global

mode http

option httplog

option dontlognull

option forwardfor

retries 3

option redispatch

stats enable

stats uri /haproxystats

stats realm Strictly\ Private

stats auth stats:haproxystats

timeout connect 5000

timeout client 50000

timeout server 50000

frontend http-in

bind *:80

mode http

http-request set-header X-Forwarded-Proto http

default_backend openuds-backend

frontend https-in

bind *:443 ssl crt /etc/openssl/private/haproxy.pem

mode http

http-request set-header X-Forwarded-Proto https

default_backend openuds-backend

frontend tunnel-in

bind *:1443

mode tcp

option tcplog

default_backend tunnel-backend-ssl

frontend tunnel-in-guacamole # HTML5

bind *:10443

mode tcp

option tcplog

default_backend tunnel-backend-guacamole

backend openuds-backend

option http-keep-alive

balance roundrobin

server udss1 192.168.0.85:80 check inter 2000 rise 2 fall 5

server udss2 192.168.0.86:80 check inter 2000 rise 2 fall 5

backend tunnel-backend-ssl

mode tcp

option tcplog

balance roundrobin

server udst1 192.168.0.87:7777 check inter 2000 rise 2 fall 5

server udst2 192.168.0.88:7777 check inter 2000 rise 2 fall 5

backend tunnel-backend-guacamole

mode tcp

option tcplog

balance source

server udstg1 192.168.0.87:10443 check inter 2000 rise 2 fall 5

server udstg2 192.168.0.88:10443 check inter 2000 rise 2 fall 5

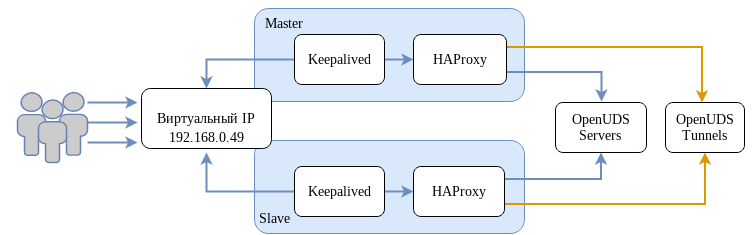

#echo "net.ipv4.ip_nonlocal_bind = 1" >> /etc/sysctl.conf#sysctl -p

/etc/keepalived/keepalived.conf. Содержимое файла зависит от узла, который настраивается:

global_defs {

# Keepalived process identifier

lvs_id haproxy_DH

}

# Script used to check if HAProxy is running

vrrp_script check_haproxy {

script "killall -0 haproxy"

interval 2

weight 2

}

# Виртуальный интерфейс

# The priority specifies the order in which the assigned interface to take over in a failover

vrrp_instance VI_01 {

state MASTER

interface enp0s3

virtual_router_id 51

priority 101

# Виртуальный IP-адрес

virtual_ipaddress {

192.168.0.49

}

track_script {

check_haproxy

}

}

где enp0s3 — интерфейс, для виртуального IP (узнать имя сетевого интерфейса можно, выполнив команду ip a).

global_defs {

# Keepalived process identifier

lvs_id haproxy_DH_passive

}

# Script used to check if HAProxy is running

vrrp_script check_haproxy {

script "killall -0 haproxy"

interval 2

weight 2

}

# Виртуальный интерфейс

# The priority specifies the order in which the assigned interface to take over in a failover

vrrp_instance VI_01 {

state SLAVE

interface eth0

virtual_router_id 51

priority 100

# Виртуальный IP-адрес

virtual_ipaddress {

192.168.0.49

}

track_script {

check_haproxy

}

}

где eth0 — интерфейс, для виртуального IP (узнать имя сетевого интерфейса можно, выполнив команду ip a).

#systemctl enable --now haproxy#systemctl enable --now keepalived

$ ip a |grep enp0s3

2: enp0s3: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc fq_codel state UP group default qlen 1000

inet 192.168.0.52/24 brd 192.168.0.255 scope global noprefixroute enp0s3

inet 192.168.0.49/32 scope global enp0s3

# apt-get install openuds-server-nginx

/etc/openuds/settings.py, указав корректные данные для подключения к главному MySQL-серверу:

DATABASES = {

'default': {

'ENGINE': 'django.db.backends.mysql',

'OPTIONS': {

'isolation_level': 'read committed',

},

'NAME': 'dbuds', # Or path to database file if using sqlite3.

'USER': 'dbuds', # Not used with sqlite3.

'PASSWORD': 'password', # Not used with sqlite3.

'HOST': '192.168.0.128', # Set to empty string for localhost. Not used with sqlite3.

'PORT': '3306', # Set to empty string for default. Not used with sqlite3.

}

}

#su -s /bin/bash - openuds$cd /usr/share/openuds$python3 manage.py migrate$exit

# systemctl enable --now openuds-web.service

#ln -s ../sites-available.d/openuds.conf /etc/nginx/sites-enabled.d/openuds.conf#systemctl enable --now nginx.service

# systemctl enable --now openuds-taskmanager.service

# apt-get install openuds-tunnel

/etc/openuds-tunnel/udstunnel.conf :

uds_server = http://192.168.0.49/uds/rest/tunnel/ticket uds_token = 5ba9d52bb381196c2a22e495ff1c9ba4bdc03440b726aa8b

# systemctl enable --now openuds-tunnel.service

/etc/guacamole/guacamole.properties привести значение параметра uds-base-url к виду:

uds-base-url=http://192.168.0.49/uds/guacamole/auth/5ba9d52bb381196c2a22e495ff1c9ba4bdc03440b726aa8bгде 192.168.0.49 — виртуальный IP-адрес;

/etc/tomcat/server.xml добавить новый Connector, в котором указать порт (в примере 10443), сертификат (файл .crt, .pem и т.д.), закрытый ключ (.key, .pem и т.д.):

<Connector port="10443" protocol="org.apache.coyote.http11.Http11AprProtocol" SSLEnabled="true"

ciphers="A-CHACHA20-POLY1305,ECDHE-RSA-CHACHA20-POLY1305,

ECDHE-ECDSA-AES128-GCM-SHA256,ECDHE-RSA-AES128-GCM-SHA256,

DHE-RSA-AES128-GCM-SHA256,DHE-RSA-AES256-GCM-SHA384,

ECDHE-ECDSA-AES128-SHA256,ECDHE-RSA-AES128-SHA256,

ECDHE-ECDSA-AES128-SHA,ECDHE-RSA-AES256-SHA384,

ECDHE-RSA-AES128-SHA,ECDHE-ECDSA-AES256-SHA384,

ECDHE-ECDSA-AES256-SHA,ECDHE-RSA-AES256-SHA,

DHE-RSA-AES128-SHA256,DHE-RSA-AES128-SHA,

DHE-RSA-AES256-SHA256,DHE-RSA-AES256-SHA,

ECDHE-ECDSA-DES-CBC3-SHA,ECDHE-RSA-DES-CBC3-SHA,

EDH-RSA-DES-CBC3-SHA,AES128-GCM-SHA256,AES256-GCM-SHA384,

AES128-SHA256,AES256-SHA256,AES128-SHA,AES256-SHA,DES-CBC3-SHA"

maxThreads="500" scheme="https" secure="true"

SSLCertificateFile="/etc/openuds-tunnel/ssl/certs/openuds-tunnel.pem"

SSLCertificateKeyFile="/etc/openuds-tunnel/ssl/private/openuds-tunnel.key"

maxKeepAliveRequests="1000"

clientAuth="false" sslProtocol="TLSv1+TLSv1.1+TLSv1.2" />

# systemctl enable --now guacd tomcat

INSERT INTO `uds_tunneltoken` VALUES (ID,'автор добавления','IP-адрес туннеля','IP-адрес туннеля' 'название туннеля','Токен из файла udstunnel.conf','дата добавления');Например:

#mysql -u root -pMariaDB>USE dbuds;MariaDB>INSERT INTO `uds_tunneltoken` VALUES (ID,'admin','192.168.0.87','192.168.0.87','Tunnel','5ba9d52bb381196c2a22e495ff1c9ba4bdc03440b726aa8b','2022-11-15');MariaDB>INSERT INTO `uds_tunneltoken` VALUES (ID,'admin','192.168.0.88','192.168.0.88','Tunnel','9ba4bdc03440b726aa8b5ba9d52bb381196c2a22e495ff1c','2022-11-15');MariaDB>exit;

Примечание

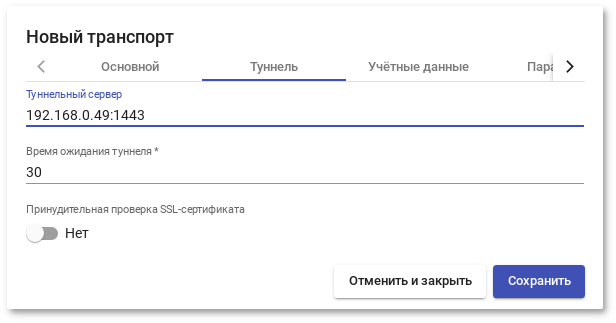

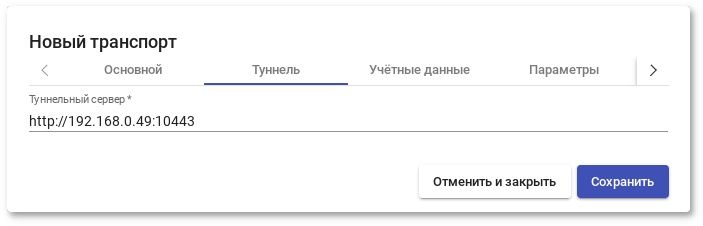

frontend tunnel-in файла /etc/haproxy/haproxy.cfg (в данном примере: 1443):

frontend tunnel-in-guacamole файла /etc/haproxy/haproxy.cfg (в данном примере: 10443):

fping:

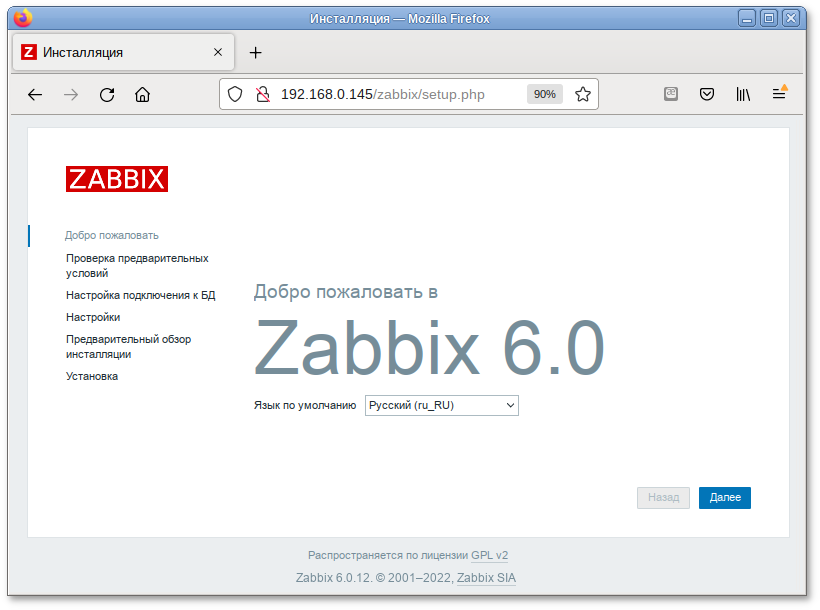

# apt-get install postgresql14-server zabbix-server-pgsql fping

# /etc/init.d/postgresql initdb

# systemctl enable --now postgresql

#su - postgres -s /bin/sh -c 'createuser --no-superuser --no-createdb --no-createrole --encrypted --pwprompt zabbix'#su - postgres -s /bin/sh -c 'createdb -O zabbix zabbix'#systemctl restart postgresql

# su - postgres -s /bin/sh -c 'psql -U zabbix -f /usr/share/doc/zabbix-common-database-pgsql-*/schema.sql zabbix'

Если создаётся база данных для Zabbix прокси, следующие команды выполнять не нужно.

#su - postgres -s /bin/sh -c 'psql -U zabbix -f /usr/share/doc/zabbix-common-database-pgsql-*/images.sql zabbix'#su - postgres -s /bin/sh -c 'psql -U zabbix -f /usr/share/doc/zabbix-common-database-pgsql-*/data.sql zabbix'

# apt-get install apache2 apache2-mod_php8.0

# systemctl enable --now httpd2

Примечание

php<мажорная>.<минорная версии>-<имя модуля>

# apt-get install php8.0 php8.0-mbstring php8.0-sockets php8.0-gd php8.0-xmlreader php8.0-pgsql php8.0-ldap php8.0-openssl

/etc/php/8.0/apache2-mod_php/php.ini:

memory_limit = 256M post_max_size = 32M max_execution_time = 600 max_input_time = 600 date.timezone = Europe/Moscow always_populate_raw_post_data = -1

# systemctl restart httpd2

/etc/zabbix/zabbix_server.conf:

DBHost=localhost DBName=zabbix DBUser=zabbix DBPassword=Пароль от базы

# systemctl enable --now zabbix_pgsql

# apt-get install zabbix-phpfrontend-apache2

# ln -s /etc/httpd2/conf/addon.d/A.zabbix.conf /etc/httpd2/conf/extra-enabled/

# systemctl restart httpd2

# chown apache2:apache2 /var/www/webapps/zabbix/ui/conf

http://<ip-сервера>/zabbix

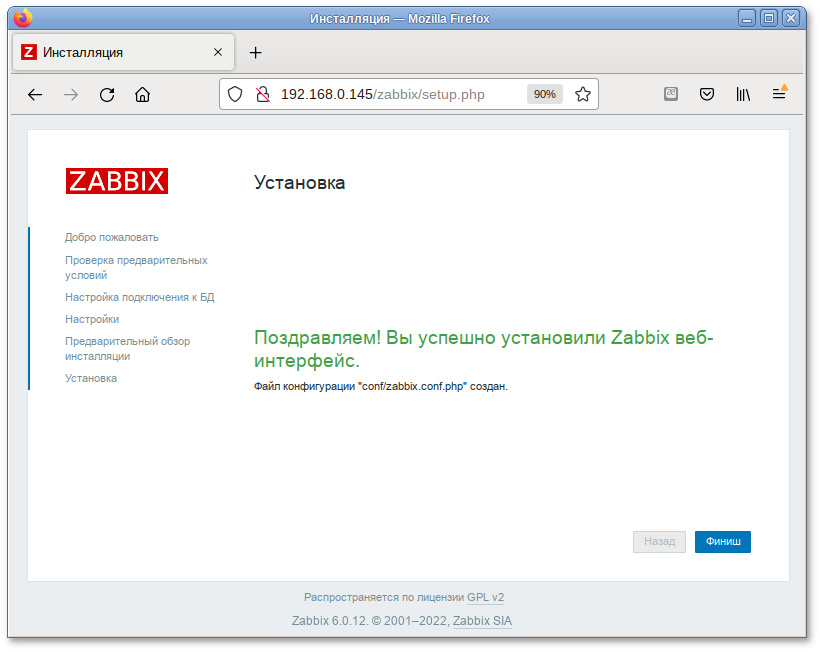

Примечание

/etc/httpd2/conf/sites-available/default.conf в секцию <Directory> добавить запись:

Require all grantedи перезапустить apache2:

# systemctl restart httpd2

Примечание

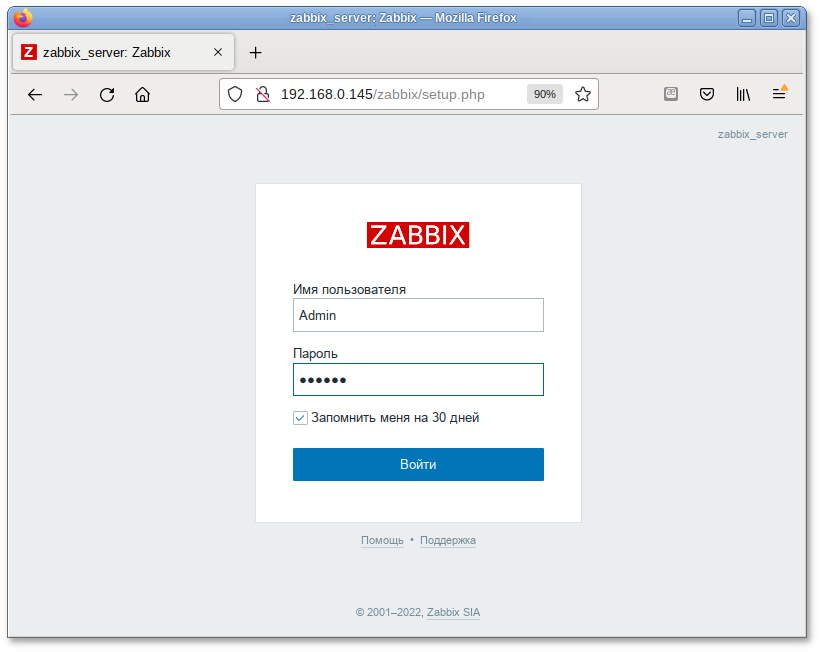

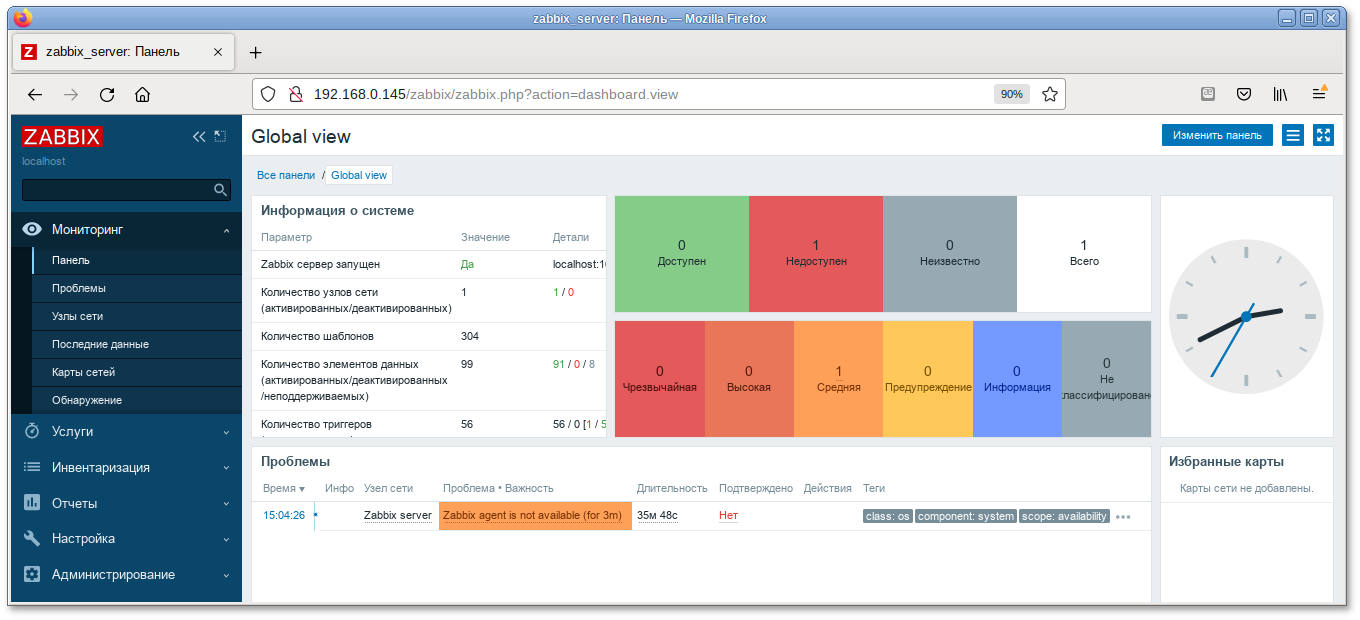

Логин: Admin Пароль: zabbix

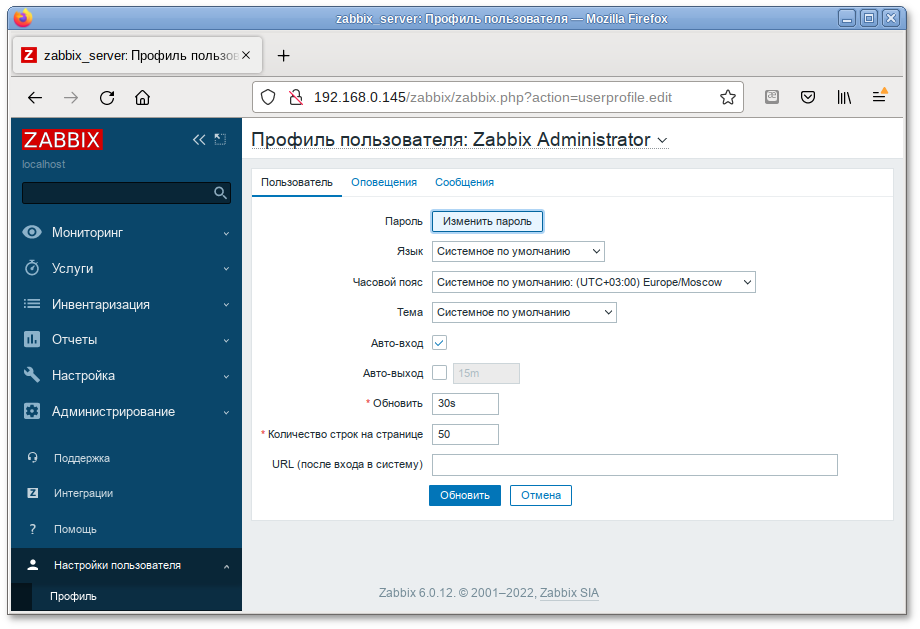

Примечание

# apt-get install zabbix-agent

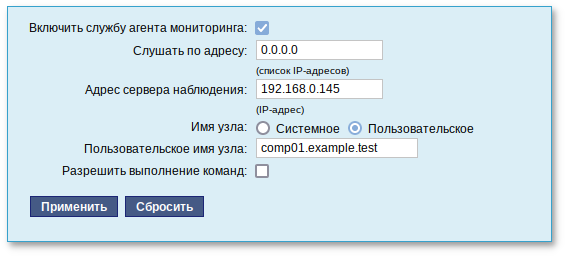

/etc/zabbix/zabbix_agentd.conf нужно задать следующие параметры:

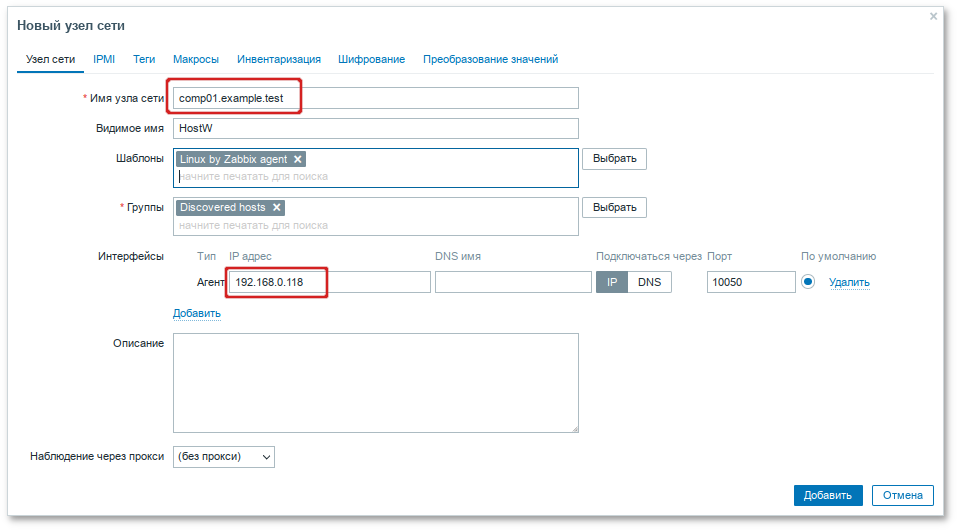

Server=<ip-сервера> ServerActive=<ip-сервера> Hostname=comp01.example.testcomp01.example.test — имя узла мониторинга, которое будет указано на сервере Zabbix.

Примечание

# systemctl enable --now zabbix_agentd.service

Примечание

Примечание

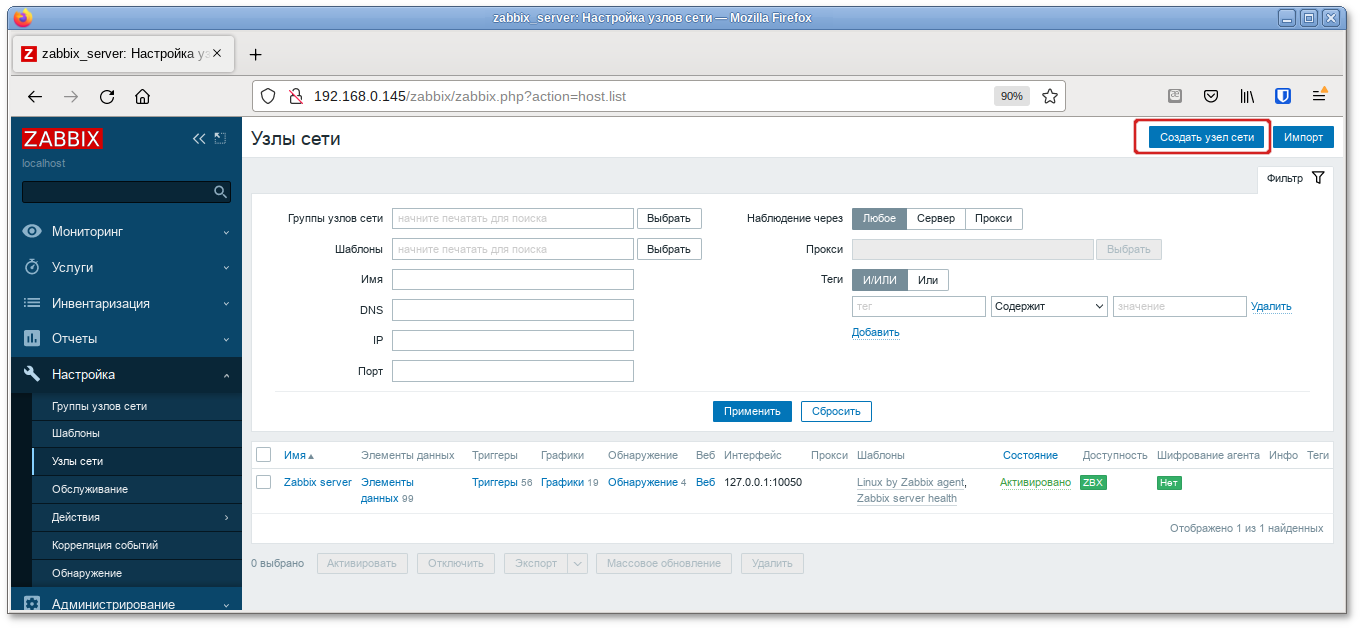

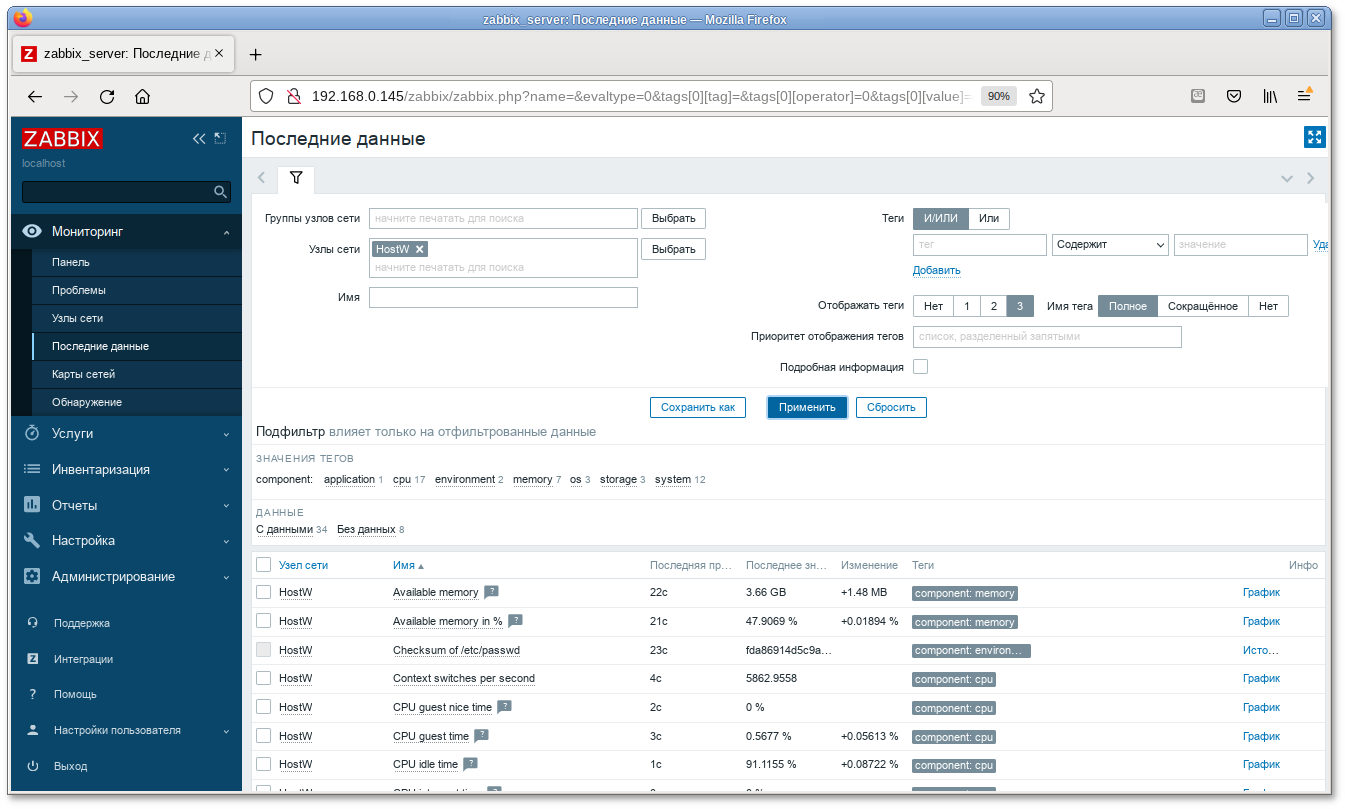

/etc/zabbix/zabbix_agentd.conf) в поле Hostname.

Примечание

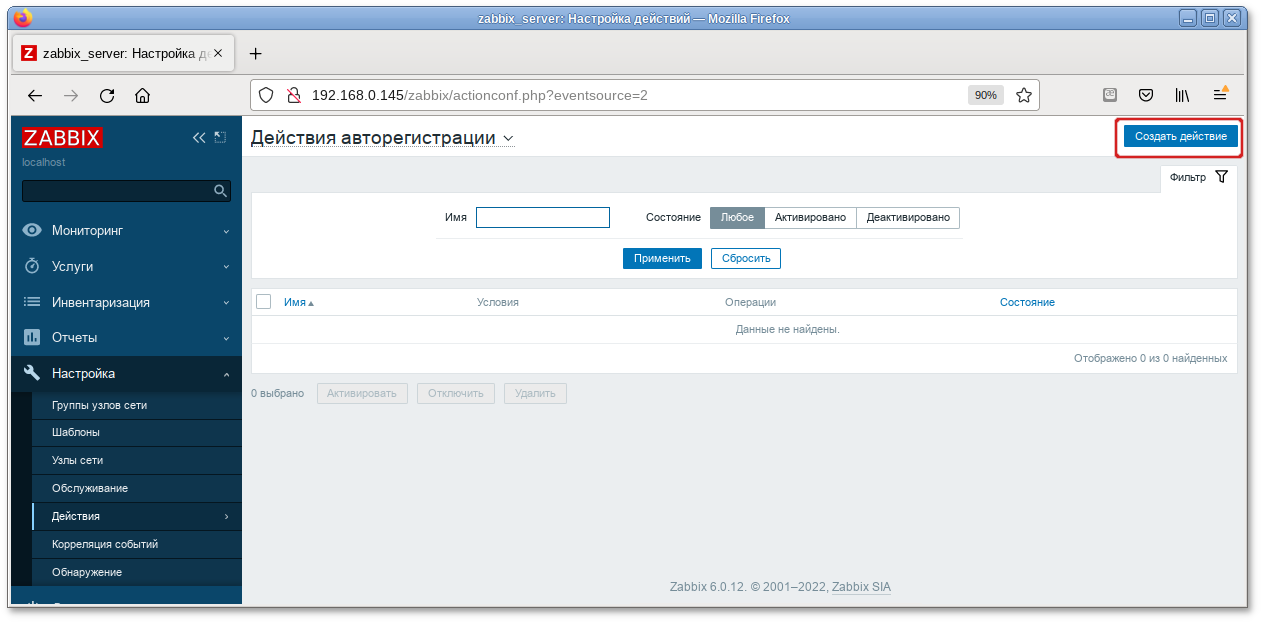

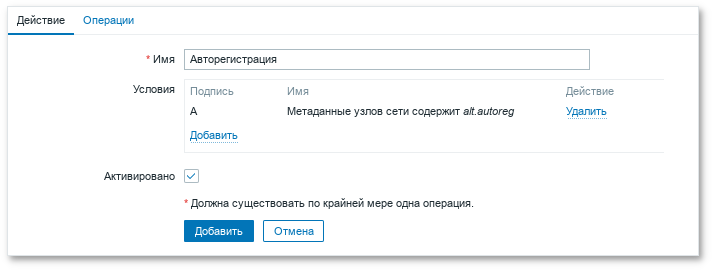

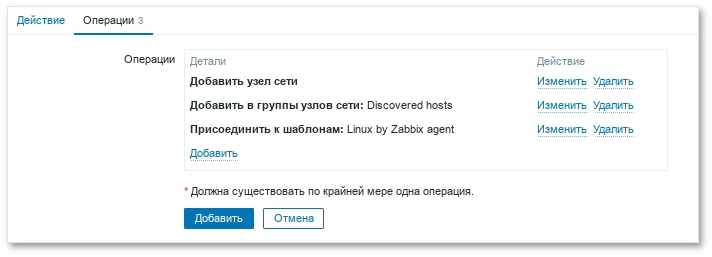

Hostname — уникальное имя;

ServerActive — IP-адрес сервера;

HostMetadata — значение, которое было указано в настройках сервера (HostMetadata=alt.autoreg).

Примечание

# apt-get install prosody jitsi-meet-prosody jitsi-meet-web jitsi-meet-web-config jicofo jitsi-videobridge

Примечание

# hostnamectl set-hostname jitsi2

/etc/hosts строку:

127.0.0.1 jitsi2.test.alt jitsi2

Примечание

#hostnamejitsi2 #hostname -fjitsi2.test.alt $ping "$(hostname)"PING jitsi2.test.alt (127.0.0.1) 56(84) bytes of data. 64 bytes from localhost (127.0.0.1): icmp_seq=1 ttl=64 time=0.053 ms [...]

/etc/prosody/conf.d для хранения пользовательских конфигураций:

# mkdir -p /etc/prosody/conf.d

/etc/prosody/prosody.cfg.lua дописать строку:

Include "conf.d/*.cfg.lua"

/etc/prosody/conf.d/jitsi2.test.alt.cfg.lua) со следующим содержимым:

plugin_paths = { "/usr/share/jitsi-meet/prosody-plugins/" }

-- domain mapper options, must at least have domain base set to use the mapper

muc_mapper_domain_base = "jitsi2.test.alt";

cross_domain_bosh = false;

consider_bosh_secure = true;

----------- Virtual hosts -----------

VirtualHost "jitsi2.test.alt"

authentication = "anonymous"

ssl = {

key = "/var/lib/prosody/jitsi2.test.alt.key";

certificate = "/var/lib/prosody/jitsi2.test.alt.crt";

}

speakerstats_component = "speakerstats.jitsi2.test.alt"

conference_duration_component = "conferenceduration.jitsi2.test.alt"

-- we need bosh

modules_enabled = {

"bosh";

"pubsub";

"ping"; -- Enable mod_ping

"speakerstats";

"turncredentials";

"conference_duration";

}

c2s_require_encryption = false

Component "conference.jitsi2.test.alt" "muc"

storage = "memory"

modules_enabled = {

"muc_meeting_id";

"muc_domain_mapper";

-- "token_verification";

}

admins = { "focus@auth.jitsi2.test.alt" }

muc_room_locking = false

muc_room_default_public_jids = true

VirtualHost "auth.jitsi2.test.alt"

ssl = {

key = "/var/lib/prosody/auth.jitsi2.test.alt.key";

certificate = "/var/lib/prosody/auth.jitsi2.test.alt.crt";

}

authentication = "internal_plain"

-- internal muc component, meant to enable pools of jibri and jigasi clients

Component "internal.auth.jitsi2.test.alt" "muc"

storage = "memory"

modules_enabled = {

"ping";

}

admins = { "focus@auth.jitsi2.test.alt", "jvb@auth.jitsi2.test.alt" }

muc_room_locking = false

muc_room_default_public_jids = true

Component "focus.jitsi2.test.alt"

component_secret = "secret1" -- достаточно длинный пароль, он же JICOFO_SECRET

Component "speakerstats.jitsi2.test.alt" "speakerstats_component"

muc_component = "conference.jitsi2.test.alt"

Component "conferenceduration.jitsi2.test.alt" "conference_duration_component"

muc_component = "conference.jitsi2.test.alt"

#prosodyctl cert generate jitsi2.test.alt#prosodyctl cert generate auth.jitsi2.test.alt

#ln -s /var/lib/prosody/jitsi2.test.alt.crt /etc/pki/ca-trust/source/anchors/#ln -s /var/lib/prosody/auth.jitsi2.test.alt.crt /etc/pki/ca-trust/source/anchors/#update-ca-trust

# prosodyctl register focus auth.jitsi2.test.alt secret2

где secret2 — достаточно длинный пароль.

# prosodyctl start

/etc/jitsi/jicofo/config следует указать:

# Jitsi Conference Focus settings

# sets the host name of the XMPP server

JICOFO_HOST=localhost

# sets the XMPP domain (default: none)

JICOFO_HOSTNAME=jitsi2.test.alt

# sets the secret used to authenticate as an XMPP component

JICOFO_SECRET=secret1

# overrides the prefix for the XMPP component domain. Default: "focus"

#JICOFO_FOCUS_SUBDOMAIN=focus

# sets the port to use for the XMPP component connection

JICOFO_PORT=5347

# sets the XMPP domain name to use for XMPP user logins

JICOFO_AUTH_DOMAIN=auth.jitsi2.test.alt

# sets the username to use for XMPP user logins

JICOFO_AUTH_USER=focus

# sets the password to use for XMPP user logins

JICOFO_AUTH_PASSWORD=secret2

# extra options to pass to the jicofo daemon

JICOFO_OPTS="${JICOFO_FOCUS_SUBDOMAIN:+ --subdomain=$JICOFO_FOCUS_SUBDOMAIN}"

# adds java system props that are passed to jicofo (default are for home and logging config file)

JAVA_SYS_PROPS="-Dnet.java.sip.communicator.SC_HOME_DIR_LOCATION=/etc/jitsi

-Dnet.java.sip.communicator.SC_HOME_DIR_NAME=jicofo

-Dnet.java.sip.communicator.SC_LOG_DIR_LOCATION=/var/log/jitsi

-Djava.util.logging.config.file=/etc/jitsi/jicofo/logging.properties"

Важно

JICOFO_SECRET=secret1должен быть указан пароль, установленный в файле

/etc/prosody/conf.d/jitsi2.test.alt.cfg.lua.

JICOFO_AUTH_PASSWORD=secret2должен быть указан пароль пользователя focus.

/etc/jitsi/jicofo/sip-communicator.properties следует указать:

org.jitsi.jicofo.health.ENABLE_HEALTH_CHECKS=true org.jitsi.jicofo.BRIDGE_MUC=JvbBrewery@internal.auth.jitsi2.test.alt

# systemctl start jicofo

# curl -i localhost:8888/about/health

HTTP/1.1 500 Internal Server Error

Date: Wed, 04 May 2022 10:02:05 GMT

Content-Type: application/json

Content-Length: 56

Server: Jetty(9.4.15.v20190215)

No operational bridges available (total bridge count: 0)

Так как пока ни одного Jitsi Videobridge к серверу не подключено, jicofo ответит кодом ответа 500 и сообщением No operational bridges available. Если в ответе сообщение об ошибке иного рода — следует проверить настройки и связь между prosody и jicofo.

# prosodyctl register jvb auth.jitsi2.test.alt secret3

/etc/jitsi/videobridge/config на следующее:

# Jitsi Videobridge settings # extra options to pass to the JVB daemon JVB_OPTS="--apis=," # adds java system props that are passed to jvb (default are for home and logging config file) JAVA_SYS_PROPS="-Dnet.java.sip.communicator.SC_HOME_DIR_LOCATION=/etc/jitsi -Dnet.java.sip.communicator.SC_HOME_DIR_NAME=videobridge -Dnet.java.sip.communicator.SC_LOG_DIR_LOCATION=/var/log/jitsi -Djava.util.logging.config.file=/etc/jitsi/videobridge/logging.properties -Dconfig.file=/etc/jitsi/videobridge/application.conf"

/etc/jitsi/videobridge/application.conf и /etc/jitsi/videobridge/sip-communicator.properties.

/etc/jitsi/videobridge/application.conf необходимо указать:

videobridge {

stats {

enabled = true

transports = [

{ type = "muc" }

]

}

apis {

xmpp-client {

configs {

shard {

hostname = "localhost"

domain = "auth.jitsi2.test.alt"

username = "jvb"

password = "secret3"

muc_jids = "JvbBrewery@internal.auth.jitsi2.test.alt"

# The muc_nickname must be unique across all instances

muc_nickname = "jvb-mid-123"

}

}

}

}

}

Важно

password = "secret3"должен быть указан пароль пользователя jvb.

/etc/jitsi/videobridge/sip-communicator.properties:

org.ice4j.ice.harvest.DISABLE_AWS_HARVESTER=true org.ice4j.ice.harvest.STUN_MAPPING_HARVESTER_ADDRESSES=meet-jit-si-turnrelay.jitsi.net:443 org.jitsi.videobridge.ENABLE_STATISTICS=true org.jitsi.videobridge.STATISTICS_TRANSPORT=muc org.jitsi.videobridge.xmpp.user.shard.HOSTNAME=localhost org.jitsi.videobridge.xmpp.user.shard.DOMAIN=auth.jitsi2.test.alt org.jitsi.videobridge.xmpp.user.shard.USERNAME=jvb org.jitsi.videobridge.xmpp.user.shard.PASSWORD=secret3 org.jitsi.videobridge.xmpp.user.shard.MUC_JIDS=JvbBrewery@internal.auth.jitsi2.test.alt org.jitsi.videobridge.xmpp.user.shard.MUC_NICKNAME=6d8b40cb-fe32-49f5-a5f6-13d2c3f95bba

Примечание

# systemctl start jitsi-videobridge

# curl -i localhost:8888/about/health

HTTP/1.1 200 OK

Date: Wed, 04 May 2022 10:06:04 GMT

Content-Length: 0

Server: Jetty(9.4.15.v20190215)

Если всё сделано правильно, jicofo на healthcheck-запрос будет отдавать HTTP-код 200.

Примечание

# openssl genrsa -out rootCA.key 2048

# openssl req -x509 -new -key rootCA.key -days 10000 -out rootCA.crt -subj "/C=RU/ST=Russia/L=Moscow/CN=SuperPlat CA Root"

# openssl genrsa -out jitsi2.test.alt.key 2048

# openssl req -new -key jitsi2.test.alt.key -out jitsi2.test.alt.csr -subj "/C=RU/L=Moscow/CN=jitsi2.test.alt"

# openssl x509 -req -in jitsi2.test.alt.csr -CA rootCA.crt -CAkey rootCA.key -CAcreateserial -out jitsi2.test.alt.crt -days 5000

Signature ok

subject=C = RU, CN = jitsi2.test.alt

Getting CA Private Key

/etc/jitsi/meet/:

#cp jitsi2.test.alt.crt /etc/jitsi/meet/#cp jitsi2.test.alt.key /etc/jitsi/meet/

/etc/jitsi/meet/jitsi2.test.alt-config.js на основе /usr/share/jitsi-meet-web-config/config.js:

# cp /usr/share/jitsi-meet-web-config/config.js /etc/jitsi/meet/jitsi2.test.alt-config.js

Внести изменения в файл /etc/jitsi/meet/jitsi2.test.alt-config.js в соответствии с настройками серверной части:

var config = {

// Connection

//

hosts: {

// XMPP domain.

domain: 'jitsi2.test.alt',

muc: 'conference.jitsi2.test.alt'

},

// BOSH URL. FIXME: use XEP-0156 to discover it.

bosh: '//jitsi2.test.alt/http-bind',

// Websocket URL

// websocket: 'wss://jitsi-meet.example.com/xmpp-websocket',

// The name of client node advertised in XEP-0115 'c' stanza

clientNode: 'http://jitsi.org/jitsimeet',

[...]

}

/usr/share/doc/jitsi-meet-web-config-4109/jitsi-meet/jitsi-meet.example-apache

/etc/httpd2/conf/sites-available/jitsi2.test.alt.conf на основе /usr/share/doc/jitsi-meet-web-config-4109/jitsi-meet/jitsi-meet.example-apache:

# cp /usr/share/doc/jitsi-meet-web-config-4109/jitsi-meet/jitsi-meet.example-apache /etc/httpd2/conf/sites-available/jitsi2.test.alt.conf

/etc/httpd2/conf/sites-available/jitsi2.test.alt.conf (изменить имя, указать сертификат):

<VirtualHost *:80>

ServerName jitsi2.test.alt

Redirect permanent / https://jitsi2.test.alt/

RewriteEngine On

RewriteCond %{HTTPS} off

RewriteRule ^ https://%{HTTP_HOST}%{REQUEST_URI} [R=301,L]

</VirtualHost>

<VirtualHost *:443>

ServerName jitsi2.test.alt

SSLProtocol TLSv1 TLSv1.1 TLSv1.2

SSLEngine on

SSLProxyEngine on

SSLCertificateFile /etc/jitsi/meet/jitsi2.test.alt.crt

SSLCertificateKeyFile /etc/jitsi/meet/jitsi2.test.alt.key

SSLCipherSuite "EECDH+ECDSA+AESGCM:EECDH+aRSA+AESGCM:EECDH+ECDSA+SHA256:EECDH+aRSA+SHA256:EECDH+ECDSA+SHA384:EECDH+ECDSA+SHA256:EECDH+aRSA+SHA384:EDH+aRSA+AESGCM:EDH+aRSA+SHA256:EDH+aRSA:EECDH:!aNULL:!eNULL:!MEDIUM:!LOW:!3DES:!MD5:!EXP:!PSK:!SRP:!DSS:!RC4:!SEED"

SSLHonorCipherOrder on

Header set Strict-Transport-Security "max-age=31536000"

DocumentRoot "/usr/share/jitsi-meet"

<Directory "/usr/share/jitsi-meet">

Options Indexes MultiViews Includes FollowSymLinks

AddOutputFilter Includes html

AllowOverride All

Order allow,deny

Allow from all

</Directory>

ErrorDocument 404 /static/404.html

Alias "/config.js" "/etc/jitsi/meet/jitsi2.test.alt-config.js"

<Location /config.js>

Require all granted

</Location>

Alias "/external_api.js" "/usr/share/jitsi-meet/libs/external_api.min.js"

<Location /external_api.js>

Require all granted

</Location>

ProxyPreserveHost on

ProxyPass /http-bind http://localhost:5280/http-bind/

ProxyPassReverse /http-bind http://localhost:5280/http-bind/

RewriteEngine on

RewriteRule ^/([a-zA-Z0-9]+)$ /index.html

</VirtualHost>

# apt-get install apache2-mod_ssl

#a2enmod rewrite#a2enmod ssl#a2enmod headers#a2enmod proxy#a2enmod proxy_http#a2enport https#a2dissite 000-default

# a2ensite jitsi2.test.alt

# systemctl enable --now httpd2

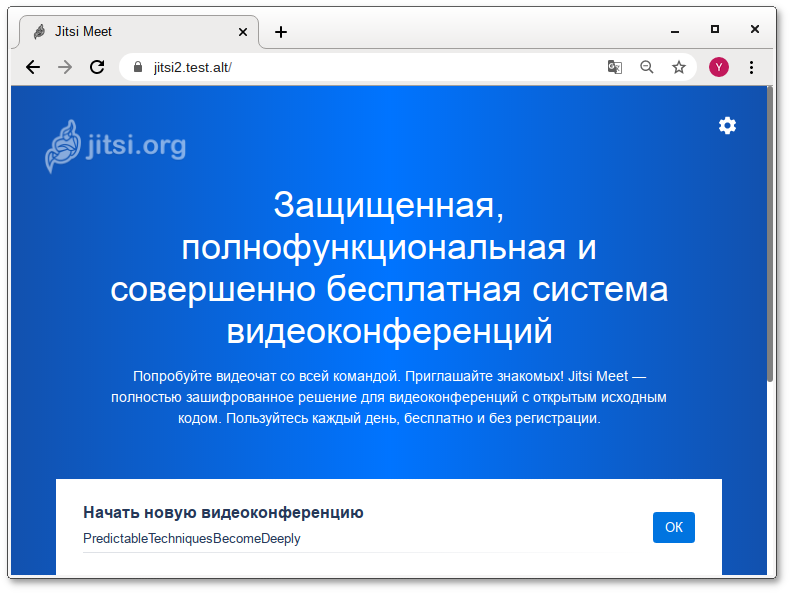

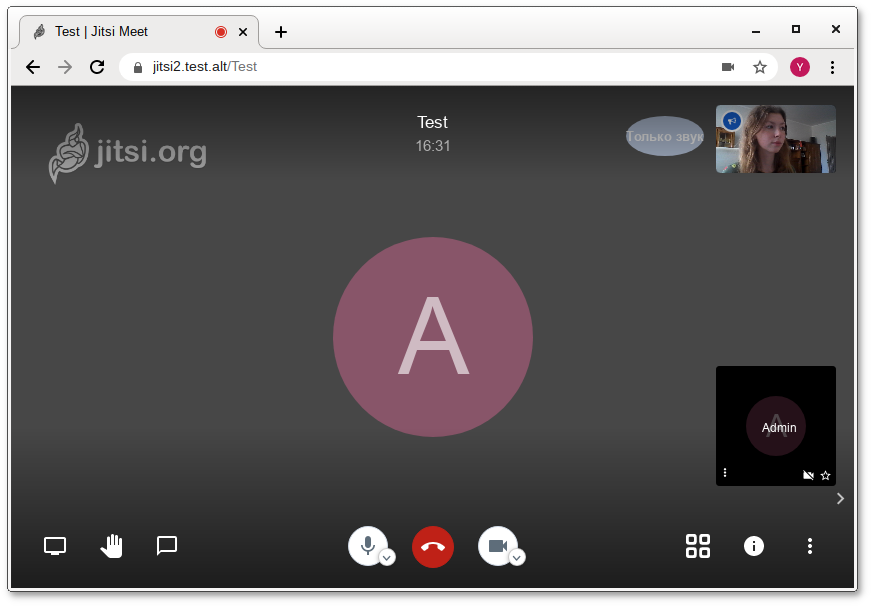

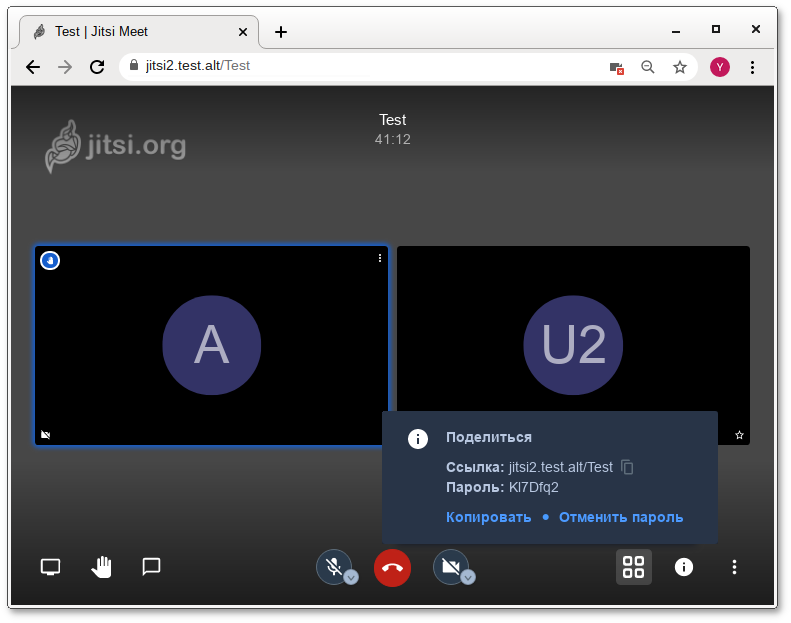

https://jitsi2.test.alt:

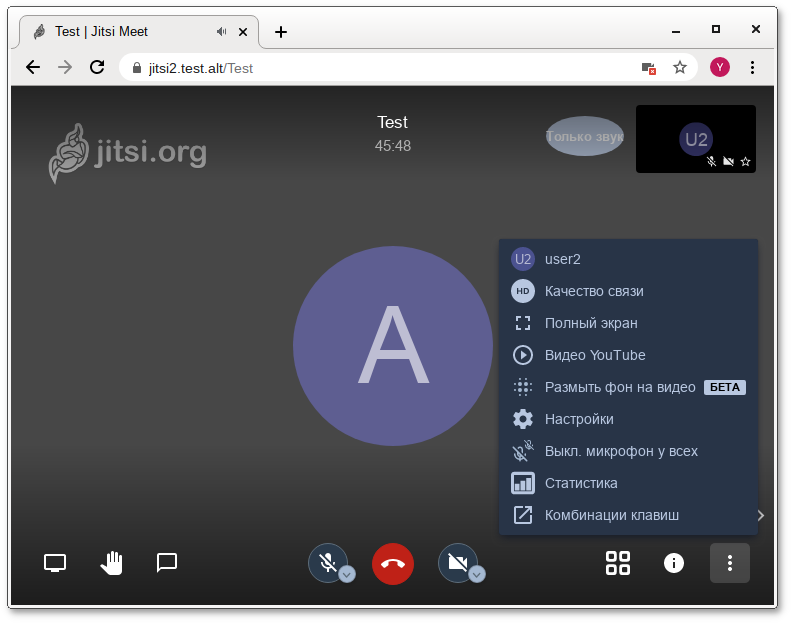

Примечание

Примечание

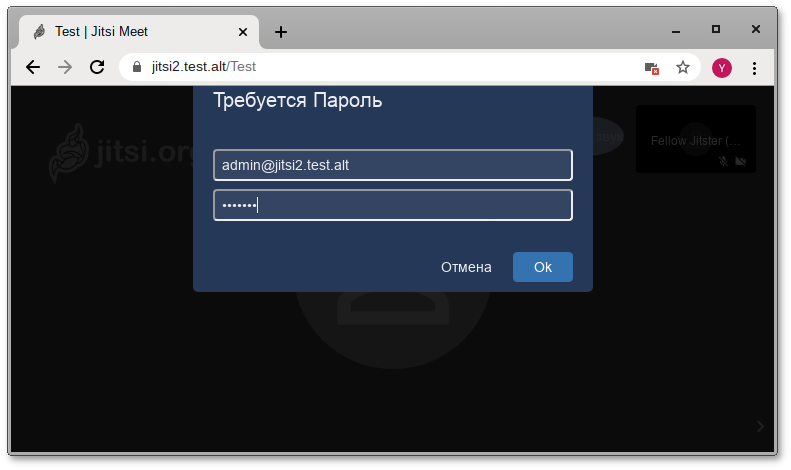

/etc/prosody/conf.d/jitsi2.test.alt.cfg.lua, изменив в нем запись:

VirtualHost "jitsi2.test.alt" authentication = "anonymous"на:

VirtualHost "jitsi2.test.alt" authentication = "internal_hashed"

/etc/prosody/conf.d/jitsi2.test.alt.cfg.lua строки:

VirtualHost "guest.jitsi2.test.alt" authentication = "anonymous" c2s_require_encryption = falseЭти настройки позволят анонимным пользователям присоединяться к конференциям, созданным пользователем, прошедшим аутентификацию. При этом у гостя должен иметься уникальный адрес и пароль конференции (если этот пароль задан);

/etc/jitsi/meet/jitsi2.test.alt-config.js указать параметры анонимного домена:

domain: 'jitsi2.test.alt', anonymousdomain: 'guest.jitsi2.test.alt',

/etc/jitsi/jicofo/sip-communicator.properties добавить строку:

org.jitsi.jicofo.auth.URL=XMPP:jitsi2.test.alt

#prosodyctl restart#systemctl restart jicofo#systemctl restart jitsi-videobridge

prosodyctl register <ПОЛЬЗОВАТЕЛЬ> jitsi2.test.alt <ПАРОЛЬ>

Изменить пароль пользователя:

prosodyctl passwd <ПОЛЬЗОВАТЕЛЬ>

Удалить пользователя:

prosodyctl deluser <ПОЛЬЗОВАТЕЛЬ>

# prosodyctl register admin jitsi2.test.alt secret4

Предупреждение

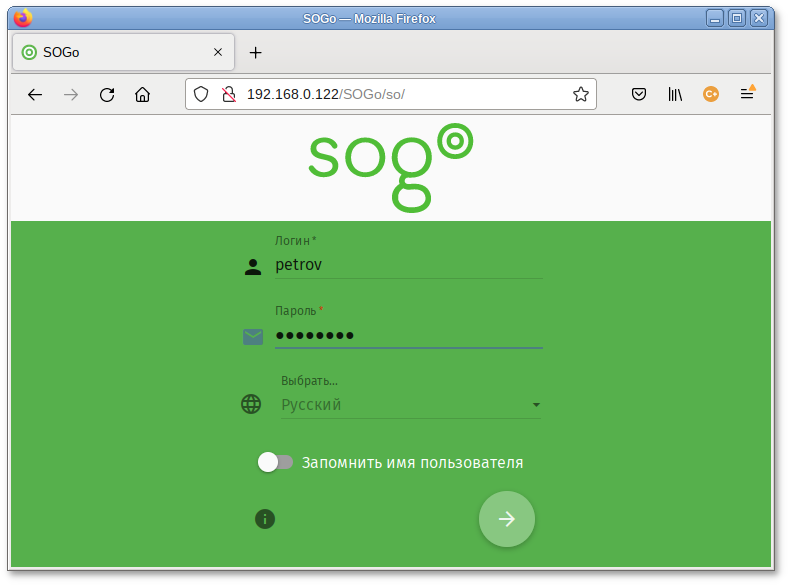

# apt-get install task-sogo

# /etc/init.d/postgresql initdb

# systemctl start postgresql

#su - postgres -s /bin/sh -c 'createuser --no-superuser --no-createdb --no-createrole sogo'#su - postgres -s /bin/sh -c 'createdb -O sogo sogo'#systemctl restart postgresql

#samba-tool user create sogo#samba-tool user setexpiry --noexpiry sogo

/etc/sogo/sogo.conf:

{

SOGoProfileURL = "postgresql://sogo@/sogo/sogo_user_profile";

OCSFolderInfoURL = "postgresql://sogo@/sogo/sogo_folder_info";

OCSSessionsFolderURL = "postgresql://sogo@/sogo/sogo_sessions_folder";

OCSEMailAlarmsFolderURL = "postgresql://sogo@/sogo/sogo_alarms_folder";

SOGoEnableEMailAlarms = YES;

SOGoDraftsFolderName = Drafts;

SOGoSentFolderName = Sent;

SOGoTrashFolderName = Trash;

SOGoIMAPServer = "imaps://localhost:993/?tlsVerifyMode=allowInsecureLocalhost";

SOGoMailingMechanism = sendmail;

SOGoForceExternalLoginWithEmail = NO;

NGImap4ConnectionStringSeparator = "/";

SOGoUserSources = (

{

id = sambaLogin;

displayName = "SambaLogin";

canAuthenticate = YES;

type = ldap;

CNFieldName = cn;

IDFieldName = cn;

UIDFieldName = sAMAccountName;

hostname = "ldaps://127.0.0.1";

baseDN = "CN=Users,DC=test,DC=alt";

bindDN = "CN=sogo,CN=Users,DC=test,DC=alt";

bindPassword = "Pa$$word";

bindFields = (sAMAccountName);

},

{

id = sambaShared;

displayName = "Shared Addressbook";

canAuthenticate = NO;

isAddressBook = YES;

type = ldap;

CNFieldName = cn;

IDFieldName = mail;

UIDFieldName = mail;

hostname = "ldaps://127.0.0.1";